一.Batch归一化

Batch归一化使参数搜索问题变得容易,使神经网络对超参数的选择更加稳定,超参数的范围会更庞大,工作效果也很好,更加容易训练深层网络。

1.原理

Batch归一化,不只适用输入层,对于任意一个隐藏层都使用,归一化隐藏层的输入特征,使其分布更加均匀,从而可以加速训练速度

2.使用方法

对于隐藏层的输入特征,先用归一化,再使用激活函数。

3.公式

和

的作用在于使隐藏单元值的均值和方差标准化,有固定的均值和方差,通过限制了隐藏单元值随机化的程度,使其更加具有代表性,从而从而可以加速训练速度。

4.特点

(1)Batch归一化使得隐藏单元值的均值和方差标准化,有固定的均值和方差,加速训练速度。

(2)限制了在前面层的参数更新会影响数值分布的程度,减少了输入值改变的问题,使其变得更稳定,增加每层网络独立学习能力,使得神经网络后面的层就会有更坚实的基础,从而更好应对输入数据的改变。

(3)有轻微正则化的作用,在mini-batch上计算均值和方差时,会有一些噪音,因为只是在mini-batch上计算的,而不是整个数据集。由于给隐藏单元添加了噪音,因此有轻微正则化的作用,使得后层单元不过分依赖任何一个隐藏单元,类似dropout的作用。

(4)由于Batch归一化的正则化效果很微弱,因此可以将batch归一化和dropout一起使用。但是如果用了更大的mini-batch,会减少Batch归一化的噪声,也会减少正则化效果。

(5)不要仅依靠Batch归一化会添加噪声这一特点,当做一种正规化方法使用,而是把它当做归一化隐藏单元值的一种方法使用,从而加速训练深层神经网络的速度。

二、SoftMax回归

1.SoftMax层

SoftMax层的纬度和输出值的种类有关,如上图C=4,故SoftMax的纬度为(4,1)即(c,1).

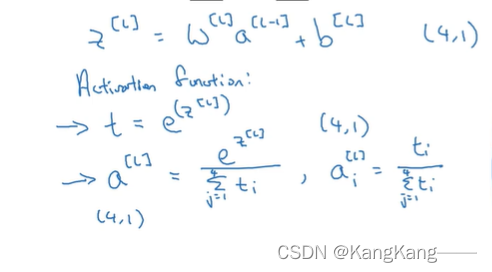

2.SoftMax激活函数

3.样例

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?