实战文本分类,深度学习是最优算法吗

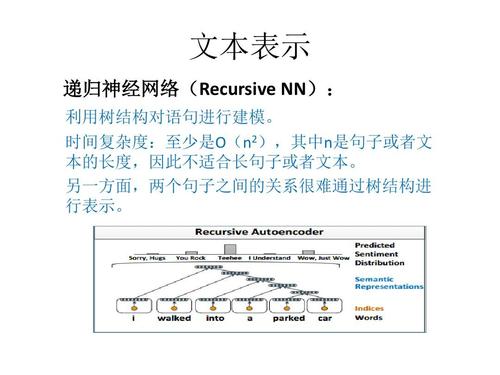

深度学习是个笼统概念,深度学习中的卷积神经网络、循环神经网络、递归神经网络等不同网络结构以及不同网络组合都会在文本分类任务中产生不同相同效果。

深度学习网络算法千千万,无所谓哪一种是最优算法,不同种算法的组合也许会取得意外的效果。总而言之,实践是检验真理的唯一标准。

谷歌人工智能写作项目:小发猫

什么是BP神经网络?

rfid。

BP算法的基本思想是:学习过程由信号正向传播与误差的反向回传两个部分组成;正向传播时,输入样本从输入层传入,经各隐层依次逐层处理,传向输出层,若输出层输出与期望不符,则将误差作为调整信号逐层反向回传,对神经元之间的连接权矩阵做出处理,使误差减小。

经反复学习,最终使误差减小到可接受的范围。具体步骤如下:1、从训练集中取出某一样本,把信息输入网络中。2、通过各节点间的连接情况正向逐层处理后,得到神经网络的实际输出。

3、计算网络实际输出与期望输出的误差。4、将误差逐层反向回传至之前各层,并按一定原则将误差信号加载到连接权值上,使整个神经网络的连接权值向误差减小的方向转化。

5、対训练集中每一个输入—输出样本对重复以上步骤,直到整个训练样本集的误差减小到符合要求为止。

文本分类的方法

文本分类问题与其它分类问题没有本质上的区别,其方法可以归结为根据待分类数据的某些特征来进行匹配,当然完全的匹配是不太可能的,因此必须(根据某种评价标准)选择最优的匹配结果,从而完成分类。

后来人们意识到,究竟依据什么特征来判断文本应当隶属的类别这个问题,就连人类自己都不太回答得清楚,有太多所谓“只可意会,不能言传

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2601

2601

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?