通过Ollama来进行安装

下面是Ollama官网

OllamaGet up and running with large language models.https://ollama.com/https://ollama.com/![]() https://ollama.com/进入下载:点击Download

https://ollama.com/进入下载:点击Download

双击OllamaSetup.exe安装

点击Install安装

安装完成之后,托盘出现Ollama图标,可进入命令窗口输入ollama --version查看是否安装成功。

修改Ollama的环境变量

windows下进入控制面板->在控制面版搜索【环境变量】->编辑账户的环境变量->新建

修改变量名为:OLLAMA_MODELS 变量值:自定义的路径,然后点击确定,应用。

DeepSeek-R1 模型下载

部署模型之前需要事先根据自己电脑的GPU内存选择合适的模型,我的是8G选择的是7B Qwen DeepSeek R1

安装命令

1.5B Qwen DeepSeek R1

ollama run deepseek-r1:1.5b7B Qwen DeepSeek R1

ollama run deepseek-r1:7b8B Llama DeepSeek R1

ollama run deepseek-r1:8b14B Qwen DeepSeek R1

ollama run deepseek-r1:14b32B Qwen DeepSeek R1

ollama run deepseek-r1:32b70B Llama DeepSeek R1

ollama run deepseek-r1:70bDeepSeek-R1 Models

| Model | #Total Params | #Activated Params | Context Length | Download |

| DeepSeek-R1-Zero | 671B | 37B | 128K | 🤗 HuggingFace |

| DeepSeek-R1 | 671B | 37B | 128K | 🤗 HuggingFace |

DeepSeek-R1-Zero 和 DeepSeek-R1 基于 DeepSeek-V3-Base 进行训练。有关模型架构的更多详细信息,请参阅DeepSeek-V3存储库。

| Model | Base Model | Download |

|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | 🤗 HuggingFace |

Web UI 安装

为了方便对话,安装UI客户端,使用浏览器插件完成,web UI安装地址:https://chromewebstore.google.com/detail/page-assist-%E6%9C%AC%E5%9C%B0-ai-%E6%A8%A1%E5%9E%8B%E7%9A%84-web/jfgfiigpkhlkbnfnbobbkinehhfdhndo

安装到Chrome.

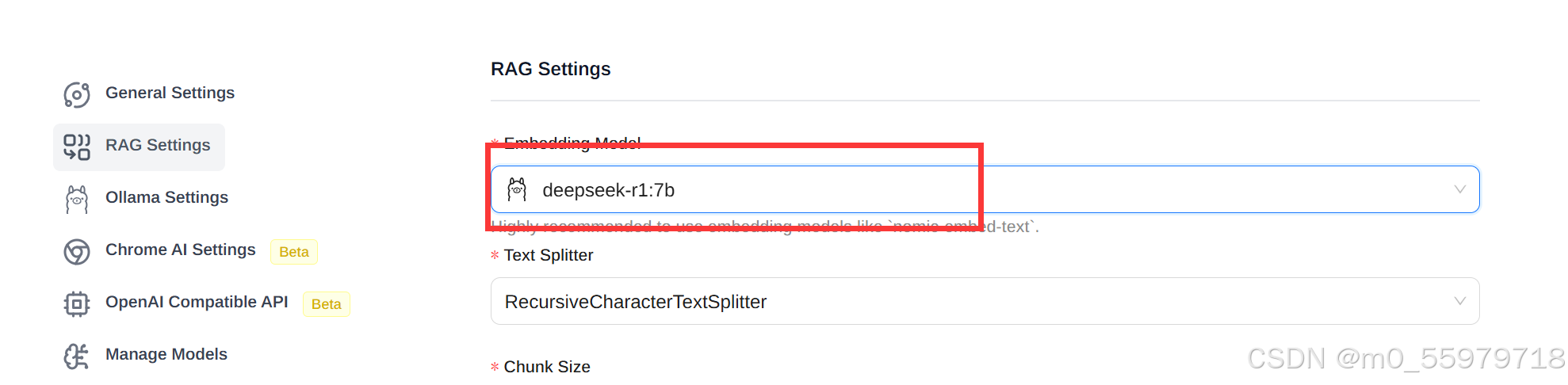

然后进入插件的设置setting,对RAG Settings进行设置,选择模型,然后保存。

当我们进行对话时,出现Ollama call failed with status code 403的错误。这是因为某些客户端在发送请求时会包含Origin头,Ollama可能会因为未正确配置而拒绝这些请求

我们需要设置OLLAMA_ORIGINS环境变量来允许特定的Origin。我们使用的是Chrome扩展,可以设置为:

OLLAMA_ORIGINS=chrome-extension://* ollama serve具体在控制面版设置环境变量参考上面的Ollama的环境变量修改过程。

修改变量名为:OLLAMA_ORIGINS 变量值:chrome-extension://*,然后点击确定,应用。

配置完成后就可以丝滑使用Deep seek进行对话了

370

370

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?