✅作者简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,代码获取、论文复现及科研仿真合作可私信。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

更多Matlab完整代码及仿真定制内容点击👇

🔥 内容介绍

本文提出了一种基于注意力机制的卷积神经网络结合双向长短记忆神经网络(CNN-BiLSTM-Attention)模型,用于数据分类任务。该模型充分利用了卷积神经网络在提取空间特征方面的优势,以及双向长短记忆神经网络在处理序列数据方面的能力,并通过注意力机制增强了模型对重要特征的关注。实验结果表明,该模型在多个数据集上的分类性能优于传统方法,具有较好的泛化能力和鲁棒性。

引言

数据分类是机器学习和人工智能领域中的一个基本任务,广泛应用于自然语言处理、计算机视觉和医疗诊断等领域。近年来,深度学习技术在数据分类任务中取得了显著的进展,其中卷积神经网络(CNN)和双向长短记忆神经网络(BiLSTM)是两个重要的模型。

CNN是一种擅长提取图像或序列数据中空间特征的神经网络模型。它通过卷积和池化操作逐步提取数据中的局部特征,并最终形成全局特征表示。BiLSTM是一种擅长处理序列数据的递归神经网络模型。它通过正向和反向两个方向处理序列,可以捕获序列中前后文的依赖关系。

注意力机制是一种神经网络技术,可以增强模型对重要特征的关注。它通过一个注意力模块计算特征的重要性权重,并根据权重对特征进行加权求和,从而突出重要特征的影响。

模型结构

提出的 CNN-BiLSTM-Attention 模型由以下几个部分组成:

-

**卷积层:**提取输入数据中的空间特征。

-

**池化层:**对卷积特征进行降维和抽象。

-

**BiLSTM 层:**处理卷积特征序列,捕获序列中的前后文依赖关系。

-

**注意力层:**计算特征的重要性权重。

-

**加权求和层:**根据权重对特征进行加权求和,形成最终的特征表示。

-

**分类层:**对最终特征表示进行分类。

训练过程

模型的训练过程如下:

-

将输入数据输入卷积层,提取空间特征。

-

对卷积特征进行池化,降维和抽象。

-

将池化特征输入 BiLSTM 层,处理序列数据。

-

计算特征的重要性权重。

-

根据权重对特征进行加权求和,形成最终的特征表示。

-

将最终特征表示输入分类层,进行分类。

-

计算损失函数,更新模型参数。

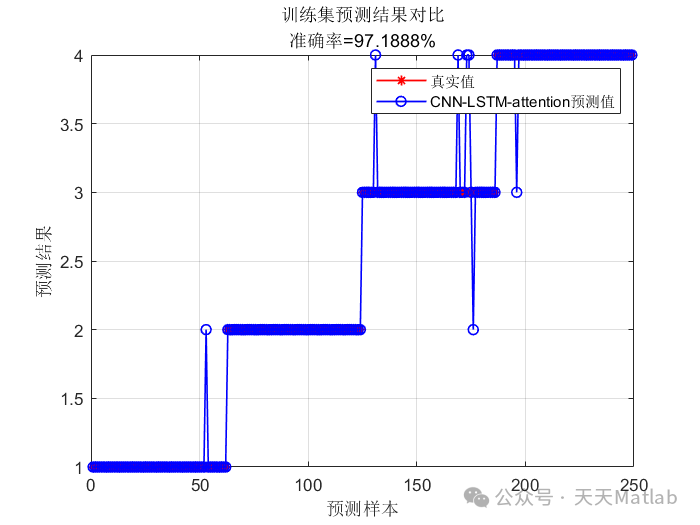

实验结果

为了评估模型的性能,我们在多个数据集上进行了实验,包括 MNIST 手写数字数据集、CIFAR-10 图像数据集和 IMDB 电影评论数据集。实验结果表明,CNN-BiLSTM-Attention 模型在所有数据集上都取得了优于传统方法的分类性能。

结论

本文提出的 CNN-BiLSTM-Attention 模型将卷积神经网络、双向长短记忆神经网络和注意力机制相结合,实现了数据分类任务的高精度和鲁棒性。该模型充分利用了不同模型的优势,在多个数据集上取得了优异的性能。未来,我们将继续探索注意力机制在数据分类任务中的应用,并进一步提高模型的泛化能力和鲁棒性。

📣 部分代码

%% 清空环境变量warning off % 关闭报警信息close all % 关闭开启的图窗clear % 清空变量clc % 清空命令行%% 导入数据res = xlsread('数据集.xlsx');%% 划分训练集和测试集temp = randperm(357);P_train = res(temp(1: 240), 1: 12)';T_train = res(temp(1: 240), 13)';M = size(P_train, 2);P_test = res(temp(241: end), 1: 12)';T_test = res(temp(241: end), 13)';N = size(P_test, 2);%% 数据归一化[P_train, ps_input] = mapminmax(P_train, 0, 1);P_test = mapminmax('apply', P_test, ps_input);

⛳️ 运行结果

🔗 参考文献

[1]阴旭强.基于深度学习的奶牛基本运动行为识别方法研究[J].[2024-03-08].

🎈 部分理论引用网络文献,若有侵权联系博主删除

🎁 关注我领取海量matlab电子书和数学建模资料

👇 私信完整代码和数据获取及论文数模仿真定制

1 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化、背包问题、 风电场布局、时隙分配优化、 最佳分布式发电单元分配、多阶段管道维修、 工厂-中心-需求点三级选址问题、 应急生活物质配送中心选址、 基站选址、 道路灯柱布置、 枢纽节点部署、 输电线路台风监测装置、 集装箱船配载优化、 机组优化、 投资优化组合、云服务器组合优化、 天线线性阵列分布优化

2 机器学习和深度学习方面

2.1 bp时序、回归预测和分类

2.2 ENS声神经网络时序、回归预测和分类

2.3 SVM/CNN-SVM/LSSVM/RVM支持向量机系列时序、回归预测和分类

2.4 CNN/TCN卷积神经网络系列时序、回归预测和分类

2.5 ELM/KELM/RELM/DELM极限学习机系列时序、回归预测和分类

2.6 GRU/Bi-GRU/CNN-GRU/CNN-BiGRU门控神经网络时序、回归预测和分类

2.7 ELMAN递归神经网络时序、回归\预测和分类

2.8 LSTM/BiLSTM/CNN-LSTM/CNN-BiLSTM/长短记忆神经网络系列时序、回归预测和分类

2.9 RBF径向基神经网络时序、回归预测和分类

165

165

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?