多模态背后的backbone会长成什么样?

各种模态到梯度下降到最后会不会都差不多?

Sora 是不是已经被追上了?

我们真的把视频数据都用好了吗?

知识库完整文档:

Manifesto

多模态,3D和视频生成是三个相关又各自独立的领域,他们在技术和应用领域上有所交叉。

1,多模态(Multimodality)

多模态技术指的是结合多种感官输入或输出的方式,例如视觉,听觉,触觉等。在人工智能领域,多模态通常指的是结合不同类型数据的分析和处理,如文本,图像和声音。

多模态学习是人工智能的一个重要分支,它涉及理解和生成能够同时处理多种数据类型的模型。

2,3D(三维)生成

3D技术涉及到创建和操作三维空间中的物体和场景,这包括3D建模,打印,动画和渲染等,在计算机图形学中,3D技术是创建逼真视觉效果的基础,广泛应用于电影,游戏和虚拟现实等领域。

3,视频生成:

视频生成指的是用计算机算法来创建视频生成的过程,可以是简单的动画,也可以是复杂的场景和角色模拟。

视频生成技术可以是结合3D模拟来创建三维动画,也可以使用机器模拟来生成逼真的内容

随着技术的发展,这三个领域正不断融合:

多模态与3D:在3D的创建过程中,多模态可以增强用户体验,通过结合视觉和听觉,可以增加3D的体验。

多模态与视频生成:多模态能帮助视频生成,从视觉和听觉的角度更好的理解和模拟真实世界。

一,多模态研究综述:

跨模态生成:

跨模态生成主要分为图像生成和视频生成两个部分

图像生成:

在图像生成领域,早期较为流行的架构为GAN(Generative Adversarial Network),模型通过generator 和 discriminator两个模块互相竞争来进行图像生成,Generator 大量生成多样性图像,Discriminator通过识别以及大量分类来识破generator 的生成。

在GAN 系列工作中,较为知名的style GAN,Circle GAN, 其中style GAN可以后期生成高分辨的人形图像,是GAN后期的最为流行的应用架构。

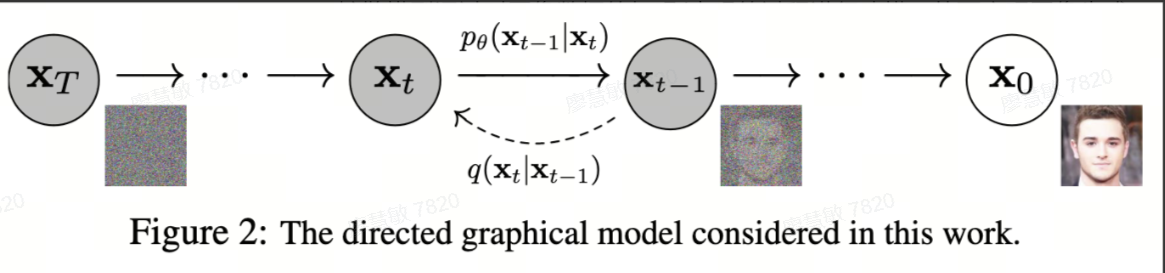

近年来,图像生成领域占据主导地位的是扩散模型- diffusion models,扩散模型通过对图像数据的加噪/去噪的过程进行建模,从而实现图像的生成。

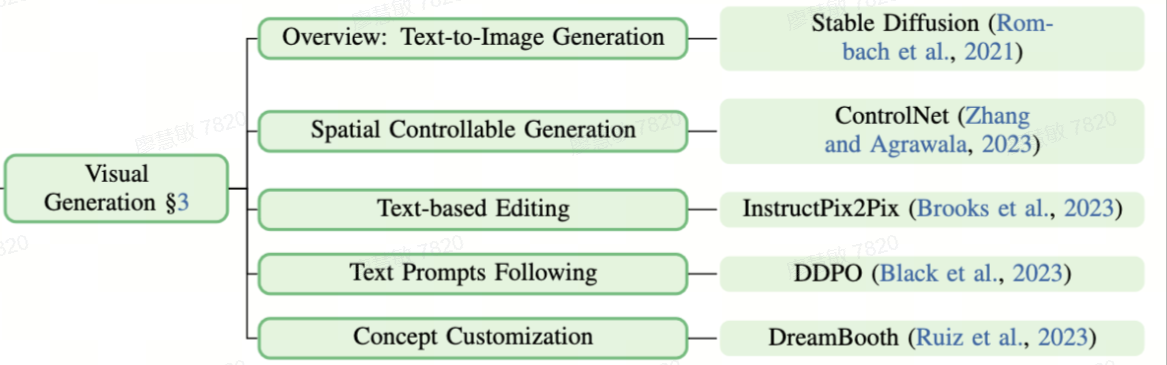

无论是GAN模型还是Diffusion Model,早期的工作都是从conditional generation开始,尽管模型可以生成高质量的图像,但用户无法对生成结果进行控制,因此后期的一个研究方向是condition/controllable generation开始,其中最流行的是text to image generation,除此之外还包括spatial layout condition ,image condition (in- context) 等。

视频生成

与图像生成类似,早期的视频生成模型也是以GAN为主,不再赘述,近年来,扩散模型已在视频生成领域占据了主导地位,从早期图像迁移到视频领域,实现了text to video。

跨模态理解:

1,从训练数据,模型结构,评估方式等对大模型进行了分类。

2,很全面的列举了各种多模态多模型理解模型,以及他们在模型结构上的共性。

多模态幻觉:

多模态幻觉是模型在生成输出时生成了和图像不符的信息。一般是由大模型对图片的理解不够准确,或生成时过度依赖文本情境而忽略图片情境而导致的。

提升训练数据标注质量,改进训练方式,改进解码方式,对生成结果进行后处理。

这篇综述对多模态幻觉原因,评测benchmark以及在不同阶段的缓解方法进行了总结,对多模态幻觉的研究可以消除幻觉,提升模型的可靠度和用户信任外,更有利于揭示多模态模型的内在机制和潜在缺陷,推动模型架构和训练方法的改进。

片段定位:

如果多模态大模型能理解表示图片/视频中的部分内容的文本输入输出,那么这个大模型就能完成更低颗粒度的任务,如grounding,dense captioning.

在图片-文本多模态大模型中拥有grounding能力的模型包括Qwen-VL,InternLM-XComposer等,在视频,文本等大模型中,拥有grounding能力的大模型包括VTimeLM,TimeChat,HawkEye。

具身智能:

具身智能旨在识别和理解环境中的物体,来实现类似人类对环境的感知和与周围环境的交互,目前学术研究中具身智能方面最热门的问题包括具身规划,具身控制和具身问答。一些研究使用多模态大模型来统一解决各种具身智能问题。

视频理解中高效帧采样的单帧偏置问题

虽然理论上视频是新增了时间维度的帧的序列,但实践中对视频中的帧进行等距采样作为多模态大模型的输入一般是并不是最优解;有时很长的一段视频中只有一小段和问题相关,甚至只需要一帧中的静态画面就能回答很多问题。因此对于视频-文本多模态大模型,如何对视频进行更高效的帧采样对算法和性能都有重要影响,是一个关键研究问题。

3D生成

单场景3D重建:

神经网络辐射场与3D高斯颇溅是单场景3D重建近几年最常用的AI网络。二者区别于NeRF是利用神经网络隐式存储3D空间信息,3D Gaussian Splatting 是通过显式存储3D高斯隧球来保存3D信息。

多模态3D重建:

Toy data multi-model 3D diffusion

最经典的是zero1-to-3.该方法在image diffusion的基础上引入了camera matrix当作控制变量,对大模型微调得到了3D diffusion模型,这样我们获得了根据输入文字的图片/描述生成对应3D场景的多模态能力。

但重建出的物体质量极低,meta提出了3D Gen,3D Gen是通过集成Meta 3D AssetGen 和 Meta 3D TextureGen 模型的能力合理重建toy data 相对高质量的纹理,也保持了较好的几何合理性与连续性。

目录:

多模态研究综述:浩瀚学术中的拼图

跨模态生成

图像生成

视频生成

跨模态理解

简介

重要学术问题

3D生成

单场景3D重建

多场景3D重建

工程化观察:给开发者的工具箱

跨模态生成

图像生成

视频生成

3D生成

多模态生成

开源工具

闭源工具

图片理解工具

视频理解工具

训练和部署工作

Benchmark动态

技术与发展的探讨

多模态与视觉生成

Diffusion vs AR

理解 vs 生成

内容生成 vs 视觉模型

数据质量 vs scaling law

多模态与3D生成

NeRF vs 3DGS vs 几何表征

数据集构建与scaling

精度。成本与应用范围

商业化赛道观察

万物灵犀 (3D扫描)

C端商业模式

B端商业模式

创源引擎(3D世界生成)

极佳科技(世界模型与多模态数据)

圆桌校友思考

补充内容:

年初,Sora的横空出世并引起广泛关注就是一个明显信号。多模态模型的运行可以大致分成两个过程:一是对多模态模型世界的理解,第二就是生成。以Sora视频生成类模型为例,它的运行不仅需要更大的内存带宽,对算力的需求也非常大。运行时,模型首先需要专门的图像处理引擎对视频或图片进行理解。这个过程中几乎每秒都要处理上千个Token才能实现实时理解。对于视频来说,一秒钟至少要生成30帧,同时还要考虑上下文的联系,连续30秒需要的算力非常之高。在理解的基础上,模型还要做生成。这对处理器的带宽又会提出新的要求。

也就是说,多模态模型的运行对芯片的算力和带宽以及成本、功耗都将有着更高的要求。Sora推出以来,其推广速度并不如人们想象得那么快,这与它对AI芯片的高需求有着莫大关系。当前的AI芯片很难支撑如此庞大的算力、带宽需求,而对算力带宽提出高需求的同时又会急剧推高成本。据测算,多模态模型的芯片成本将远高于目前的大语言模型。

蔡一茂指出,相对传统架构而言,存内计算或是突破多模态大模型发展中算力瓶颈的一个重要方向。如前所述,存内计算相对传统计算架构无论在算力还是带宽方面都有明显提升。存内计算相对传统计算另外一个重要优势是可以大幅降低成本。随着Flash、DRAM等存储容量的大幅度提高,芯片的单位成本也将不断降低。同时存内计算可以大幅减少数据搬运,这对降低芯片的运行功耗非常有利。

存内计算是一种将计算单元嵌入到内存中的计算范式,旨在解决传统冯·诺依曼架构中的“内存墙”和“功耗墙”问题。北京大学集成电路学院院长蔡一茂在接受记者采访时就表示,在越来越接近物理极限的情况下,单纯依靠传统工艺集成的方式推进摩尔定律,难度和成本都在急剧上升。另一方面,随着AI时代的到来,对传统芯片架构也将带来新的挑战,用户更加看重AI芯片在算力、存储、缓存带宽等方面的整体表现,因此寻求芯片架构上的创新对延续摩尔定律非常重要。这个架构创新就包括存内计算技术。

针对多模态的商业化应用方向观察,在图像视频与3D生成领域快速发展,本地化部署的大模型参数将达到千亿,然而目前基于SRAM/DRAM缓存的GPU或者NPU方案,都面临存储容量受限或者成本过高的巨大挑战。而存内计算不但可以有效减小计算过程中的缓存需求,还可以探索基于低成本大容量的Flash介质比如VNAND研制更加低成本的存内计算芯片,这将是一个重要的市场发展机遇。

关于存内计算2024 ISSCC最新论文解析访问链接 https://github.com/witmem/Witmem-CIM-Papers-Collection

以上。

635

635

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?