这篇论文的标题是《融合文本、语音和表情的多模态情绪识别》,作者是谢星宇、丁彩琴、王宪伦和潘东杰,发表在《青岛大学学报(工程技术版)》2024年第39卷第3期。论文主要研究了一种基于Transformer网络的多模态情绪识别模型,旨在解决情绪识别中信息不全面和易受噪声干扰的问题。以下是论文的详细介绍:

研究背景与动机

情绪识别是人机交互和家庭护理等领域中的关键技术。传统的单模态情绪识别方法(如仅基于文本、语音或表情)往往存在信息不全面的问题,容易受到噪声的干扰,导致识别准确率不高。多模态情绪识别通过融合多种模态的信息,可以提供更准确和细致的情绪识别结果。近年来,研究者尝试使用多种模态信息进行情感分析,但仍然存在特征信息提取不全面、模态融合中部分特征信息易丢失等问题。

多模态情绪识别网络框架

论文提出了一种基于Transformer网络的多模态情绪识别模型(BRC TN),该模型融合了文本、视觉和听觉等信息,并引入人物特征信息辅助情绪识别。模型框架主要由特征提取、模态融合和基于Transformer的多模态情绪特征识别三个部分组成。

特征提取

文本特征:使用GloVe进行无监督训练,提取文本特征,并通过BERT提取上下文信息。模型引入人物嵌入,按时序综合成人物向量,改进后的模型能够更好地捕捉不同语境下的语义信息。

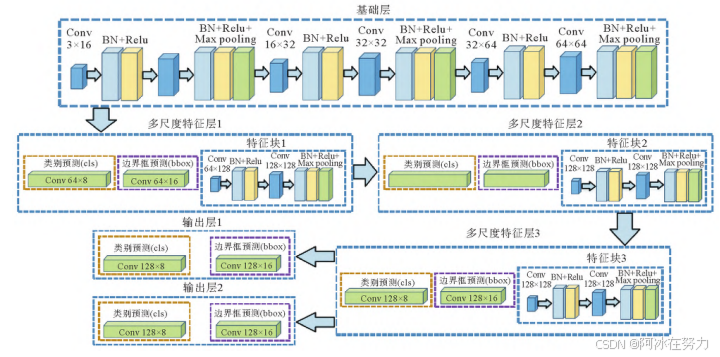

视觉特征:通过设备获取的人脸原始图像进行预处理,提取人脸区域,并使用残差网络进行多层次的特征提取。模型采用单发多框检测算法,能够准确检测人脸并提取特征。

听觉特征:对原始音频信号进行预处理,提取时域、谱域、倒谱域特征等音频特征数据。使用Transformer+CTC混合模型实现长距离音频特征的建模,解决输入序列长度不一、难以对齐的问题。

人物特征:采用基于局部二值模式的人脸识别算法(LBPH)对人脸图像进行关键点识别,识别到的人脸关键点编码后组成的矩阵存储到数据库中,能够在向量结合时嵌入其中,提高模型区分识别对象的能力。

模态融合

特征嵌入:将文本、表情和语音特征提取网络的输出部分融合为包含情绪识别结果的多模态特征向量矩阵。

模态嵌入:融合向量进一步与位置、人物特征向量融合,最后输入Transformer网络进行识别。通过模态编码的方式,让输入的特征序列具有不同模态之间的区分度。

多模态情绪识别

基于Transformer编码器的结构,由自注意力模块和前馈神经网络模块组成,计算多模态特征表示。模型通过自注意力机制,能够有效地处理多维输入向量,提取深层次的情绪特征。

实验设置与结果分析

实验环境及数据来源:实验使用Windows 10操作系统,AMD 5600X处理器,NVIDIA GeForce RTX 3060 Ti显卡,加速库为CUDA 12.0,编程语言为Python 3.6,深度学习框架为PyTorch 1.9。实验数据来源于公开数据集IEMOCAP,将4000个数据样本按照6:2:2的比例划分为训练集、验证集和测试集。

文本识别方法验证:对比了嵌入人物标签的BERT模型与原始BERT模型,结果表明嵌入人物标签的BERT模型在情绪识别准确率上优于原始BERT模型。

多模态情绪识别方法验证:

不同数量模态融合效果对比:双模态融合的识别准确率优于单模态,其中音频-文本模态的识别效果最好。三模态融合后,模型能够挖掘更多数据间的潜在联系,识别准确率比双模态模型有明显提高,多轮训练后,准确率稳定在80%以上。

与其他方法对比:在IEMOCAP数据集上,BRC TN模型的准确率达到87%,优于其他先进方法。

消融实验:通过混淆矩阵展示了6种情绪识别结果,证明了BRC TN模型在情绪识别中的优越性能。

结论

论文搭建了一种基于Transformer的多模态情绪识别网络模型(BRC TN),通过引入LBPH的人脸关键点识别模块,提高了模型提取关键特征的能力,解决了识别过程中信号输入不连续导致识别准确度低的问题。模型使用全新的多模态向量结构,将三个模态和人物特征映射到高维度全局向量空间,进一步学习不同模态特征之间的潜在联系。在IEMOCAP数据集上的验证结果表明,BRC TN模型的准确率有明显提高,具有更好的识别效果。

1105

1105

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?