机器学习的可解释性

来源:《计算机研究与发展》,作者陈珂锐等

摘 要 近年来,机器学习发展迅速,尤其是深度学习在图像、声音、自然语言处理等领域取得卓越成效.机器学习算法的表示能力大幅度提高,但是伴随着模型复杂度的增加,机器学习算法的可解释性越差,至今,机器学习的可解释性依旧是个难题.通过算法训练出的模型被看作成黑盒子,严重阻碍了机器学习在某些特定领域的使用,譬如医学、金融等领域.目前针对机器学习的可解释性综述性的工作极少,因此,将现有的可解释方法进行归类描述和分析比较,一方面对可解释性的定义、度量进行阐述,另一方面针对可解释对象的不同,从模型的解释、预测结果的解释和模仿者模型的解释3个方面,总结和分析各种机器学习可解释技术,并讨论了机器学习可解释方法面临的挑战和机遇以及未来的可能发展方向.

关键词 机器学习;可解释性;神经网络;黑盒子;模仿者模型

纵观机器学习的历史发展进程,其最初的目标是从一系列数据中寻找出可以解释的知识,因而在追求算法性能的同时,也很注重算法的可解释性.典型的代表譬如线性感知机、决策树、k近邻算法等.进入20世纪80年代之后,伴随神经网络的复苏,机器学习算法在设计时开始放弃可解释性这一要求,强调提高算法泛化的性能.神经网络的激活函数的选择不再局限于线性函数,而采用非线性的譬如Sigmoid,tanh,Softmax,Relu等函数,一方面其表示能力大幅度提高,另一方面,随着其模型复杂度的增加,算法的可解释性就更差.

然而,机器学习解释技术具有巨大的潜在应用空间.譬如科学家在知识发现的过程中,可解释的机器学习系统可以帮助他们更好地理解输出的知识,并寻找各种因素之间的相关性;对于一些复杂任务的端到端系统,几乎无法完全测试,也无法创建系统可能失败的完整场景列表,人类无法枚举出所有可能出现的计算上或者逻辑上的不可行输出,系统的可解释性对于系统的理解则至关重要;需要防范可能产生某些歧视的场景,即使我们有意识将某些特定的受保护类编码到系统中,也仍然存在考虑欠缺的先验偏见,譬如种族歧视[1-3]、性别歧视等.

对机器学习的可解释性需求不仅仅来源于上述的需求,同时还来源于法律法规.欧盟于2018年5月生效的GDPR(General Data Protection Regulation)中有条例明确规定,当机器针对某个个体作出决定时,该决定必须符合一定要求的可解释性.

NIPS2017的工作组曾针对“可解释性在机器学习中是否必要”这一问题展开激烈的讨论[4].并非所有的机器学习系统都需要可解释性,譬如邮政编码分类、航空器防撞系统等都是在没有人类干预的情况下运行,不需要解释.但是在医疗保健、金融等行业而言,模型的可解释性不仅重要而且非常必要.譬如在医疗保健方面,护理人员、医生和临床专家都依赖于新的医疗技术来帮助他们监控和决策患者护理,一个良好的可解释性模型被证明可以提高临床工作人员的解决问题的能力,从而提高患者护理质量[5-7].通常对于系统出现不可接受的结果且无法造成重大后果的情况下,或者在实际应用中,人们已经充分地研究和验证出现的问题,即使系统表现不太完美,人们也愿意相信系统的决定.在类似的场景下,对可解释性是没有需求的.

近几年来针对机器学习的可解释性综述性的工作陆续出现,每个学者从不同的研究角度和侧重点进行概述说明.

Miller[8]从哲学、心理学和认知科学的角度对解释的定义、生成、选择、评估和呈现给予说明,展现人们在研究机器学习可解释过程中的某种认知偏见和社会期望.Zhou等人[9]认为机器学习缺乏解释既是实际问题也是道德问题,根据解释的概念和黑盒子系统的类型不同,对目前的解释技术进行了分类总结.

Gilpin等人[10]重点描述了可解释技术在人机交互领域(human computer interaction, HCI)、黑盒模型和其他领域的应用说明.Carvalho等人[11]阐述可解释性问题的重要性,并粗粒度地给出3种体系的分类归纳:Pre-Model VS In-Model VS Post-Model、内在(intrinsic)VS Hoc以及特异性模型(model-specific)VS不可知模型(model-agnostic).Brian等人[12]提出可解释地预测与可解释模型之间的区别,前者侧重于解释模型预测的结果,通常以个体特征的贡献角度来诠释,而后者从模型本身出发进行解释.还有部分的研究者关注特定研究领域的可解释性.譬如:Zhang等人[13]聚焦卷积神经网络(convolutional neural networks, CNNs)的可解释研究工作.Tjoa等人[14]则关注医疗领域的可解释性工作.纪守领等人[15]侧重可解释技术的应用和安全领域的研究工作.

本文立足于机器学习的可解释技术,借鉴和扩展Brian[12]提出的分类框架,对可解释技术的最新研究进展进行综述.一方面对可解释性的定义、度量进行阐述,另一方面针对可解释对象的不同,从模型的解释、预测结果的解释和模仿者模型3个方面,总结和分析各种机器学习可解释技术.

1 基础知识

1.1 可解释定义

目前,关于机器学习的可解释性没有明确的定义,Liu等人[16]给出定义为:“解释是指解释给人听的过程”.Doshi-Velez等人[17]也提出类似的定义.解释意味着提供可理解的术语来说明一些概念.这些定义隐含地假设,解释是由一些可理解的术语表达概念来构成,这些概念是自包含的,不需要进一步解释.

目前文献中用于描述可解释性的英文单词有解释(interpretation)、解释(explanation)和理解(under-standing).Montavon等人[18]给出了区别定义:Interpretation表示将抽象概念(例如预测类)映射到人类可以理解的领域中;Explanation是一个可解释域的特征集合,用于解释给定实例的决策(譬如分类、回归等)处理过程;Understanding指对模型的功能性解释.

1.2 形式化描述

令D={x1,x2,…,xm}表示包含m个示例的数据集,(xi,yi)表示第i个样例,yi∈y是示例xi的标记,y表示输出空间.给定一个数据集D={(x1,y1),(x2,y2),…,(xm,ym)}和一个预测器p.

1) 模型解释

模型解释的任务是从数据集D和预测器p中建立映射f:(xm→y)×(xn×m×yn)→(xm→y),解释函数fE:(xm→y)→ε,ε表示人类能理解的逻辑值.

2) 预测结果解释

预测结果解释的任务是从数据集D和预测器

p中建立映射f:(xm→y)×(xn×m×yn)→(xm→y),解释函数fE:(xm→y)×xm→ε,解释过程中使用数据记录xm的特征值.

3) 模仿者模型解释

模仿者模型解释的任务是从数据集D和预测器p中建立映射f:xm→y,解释模型函数fE:(xm→y)→ε,且ε≈y.

2 主要研究方向和可解释研究框架

2.1 主要研究方向

解释技术最早出现在基于上下文规则的专家系统中,早在20世纪70年代,Shortliffe等人[19]就讨论了解释专家系统决策过程的必要性.

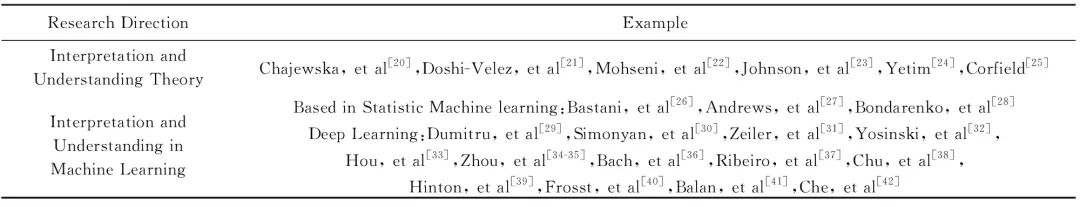

目前,可解释技术的研究方向主要由表1所示,包括解释理论和机器学习的可解释.解释理论的研究最早可以追溯到20世纪90年代,Chajewska等人[20]在通用的概率系统中提出解释的正式定义.最近则是2017年,Doshi-Velez等人[21]提出的分别以应用为基础、以人类为基础、以功能为基础的3种方法的分类,从而评估机器学习的人类可解释性.其理论的发展伴随应用场景的变化而发生改变.

Table 1 The Main Research Directions of Interpretation and Understanding Technology

表1 解释技术的主要研究方向

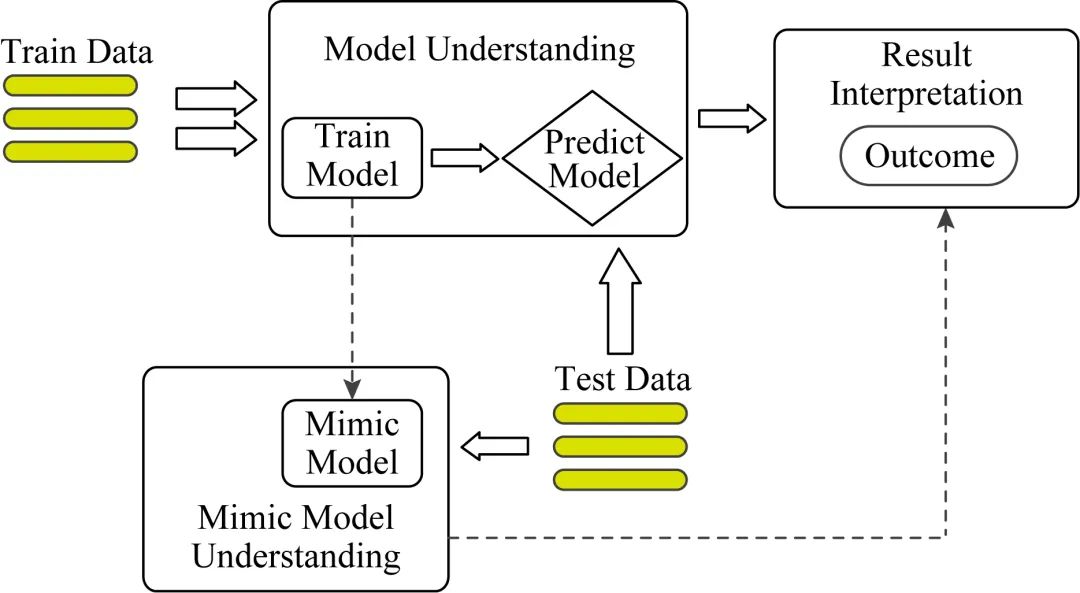

Fig. 1 The framework of interpretation and understanding in machine leaning

图1 机器学习的可解释研究框架

对于机器学习的可解释技术发展而言,早期主要关注传统统计机器学习的方法,譬如基于规则的浅层模型的解释、决策树等.现阶段大部分的研究聚焦于深度学习的可解释性,无论是学界还是业界,越来越多的学者注意到深度模型可解释的重要性和急迫性,未来在此方向将出现更多的研究思路和解决方案.

2.2 机器学习的可解释研究框架

人类认知科学中,人类会根据详细的逻辑推理来做决定,于是可以通过一步一步地展示推理过程来清楚地解释决策是如何做出.在这种情况下,决策模型是透明的.另外,人类也会先做出直觉决策,然后寻求对决策的解释,这属于事后解释法.依据这2种建模哲学构建机器学习的可解释技术研究框架如图1所示:机器学习处理流程通常将数据集划分为训练集和测试集,训练数据集经过训练模型得到预测模型,测试数据流入到预测模型,最终给出预测结果.围绕机器学习的处理流程,可解释工作主要围绕在模型和结果解释(result interpretation)两个环节上,对于模型的解释又分为模型解释(model understanding)和模仿者模型解释(mimic model understanding)两种方式,因此,本文将现存在的可解释技术按照上述的框架进行研究和总结分析.

3 机器学习模型的解释技术

3.1 基于规则的解释

基于规则的解释通常使用容易被人类理解的规则模型,譬如决策树和决策列表.Bastani等人[26]提出一种学习决策树的模型提取算法,该算法对新输入的数据主动采样,并利用复杂模型对其进行标记,生成新的训练数据集,最后使用决策树作为全局解释.该学习决策树是非参数的,又高度的结构化,因此是可解释的.Andrews等人[27]概括总结各种基于解释规则的方式,提供对复杂模型的理解.

除了树模型的规则解释之外,还有针对神经网络的规则提取.Bondarenko等人[28]总结基于神经网络规则提取的分解法(decompositional rule extraction method)&

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?