引言:

在正文开始之前,首先给大家介绍一个不错的人工智能学习教程:https://www.captainbed.cn/bbs。其中包含了机器学习、深度学习、强化学习等系列教程,感兴趣的读者可以自行查阅。

1. 算法介绍

决策树是一种常用的机器学习算法,用于分类和回归任务。它通过构建一个树状结构来进行决策,每个内部节点代表一个特征或属性,每个叶节点代表一个类别或预测值。决策树的优点是直观易懂,可解释性强,适用于处理各种类型的数据。

2. 算法原理

决策树的构建过程主要基于以下几个步骤:

- 特征选择:选择最佳的特征作为当前节点的分裂标准。

- 生成子节点:根据选定的特征将数据集分割为子集。

- 递归构建:对每个子节点重复步骤1和2,直到满足停止条件。

特征选择通常使用信息增益或基尼不纯度等指标。以信息增益为例,其计算公式如下:

Information Gain = H ( S ) − ∑ i = 1 n ∣ S i ∣ ∣ S ∣ H ( S i ) \text{Information Gain} = H(S) - \sum_{i=1}^n \frac{|S_i|}{|S|} H(S_i) Information Gain=H(S)−i=1∑n∣S∣∣Si∣H(Si)

其中:

- H ( S ) H(S) H(S) 是数据集 S S S 的熵

- S i S_i Si 是按特征分割后的子集

- H ( S i ) H(S_i) H(Si) 是子集 S i S_i Si 的熵

熵的计算公式为:

H ( S ) = − ∑ i = 1 c p i log 2 ( p i ) H(S) = -\sum_{i=1}^c p_i \log_2(p_i) H(S)=−i=1∑cpilog2(pi)

其中 c c c 是类别数量, p i p_i pi 是第 i i i 个类别的概率。

3. 案例分析

我们使用著名的鸢尾花(Iris)数据集来演示决策树分类算法。我们首先加载数据,然后将其分为训练集和测试集。接着,我们创建并训练决策树模型,并使用测试集进行预测。最后,我们评估模型性能并可视化决策树结构。

import pandas as pd

import numpy as np

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import accuracy_score, classification_report

import matplotlib.pyplot as plt

from sklearn.tree import plot_tree

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建并训练决策树模型

clf = DecisionTreeClassifier(random_state=42)

clf.fit(X_train, y_train)

# 预测

y_pred = clf.predict(X_test)

# 评估模型

accuracy = accuracy_score(y_test, y_pred)

print(f"准确率: {accuracy:.2f}")

print("\n分类报告:")

print(classification_report(y_test, y_pred, target_names=iris.target_names))

# 可视化决策树

plt.figure(figsize=(20,10))

plot_tree(clf, feature_names=iris.feature_names, class_names=iris.target_names, filled=True)

plt.show()

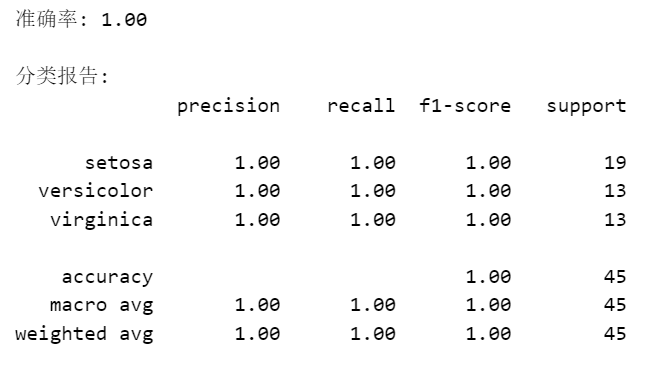

分类结果:

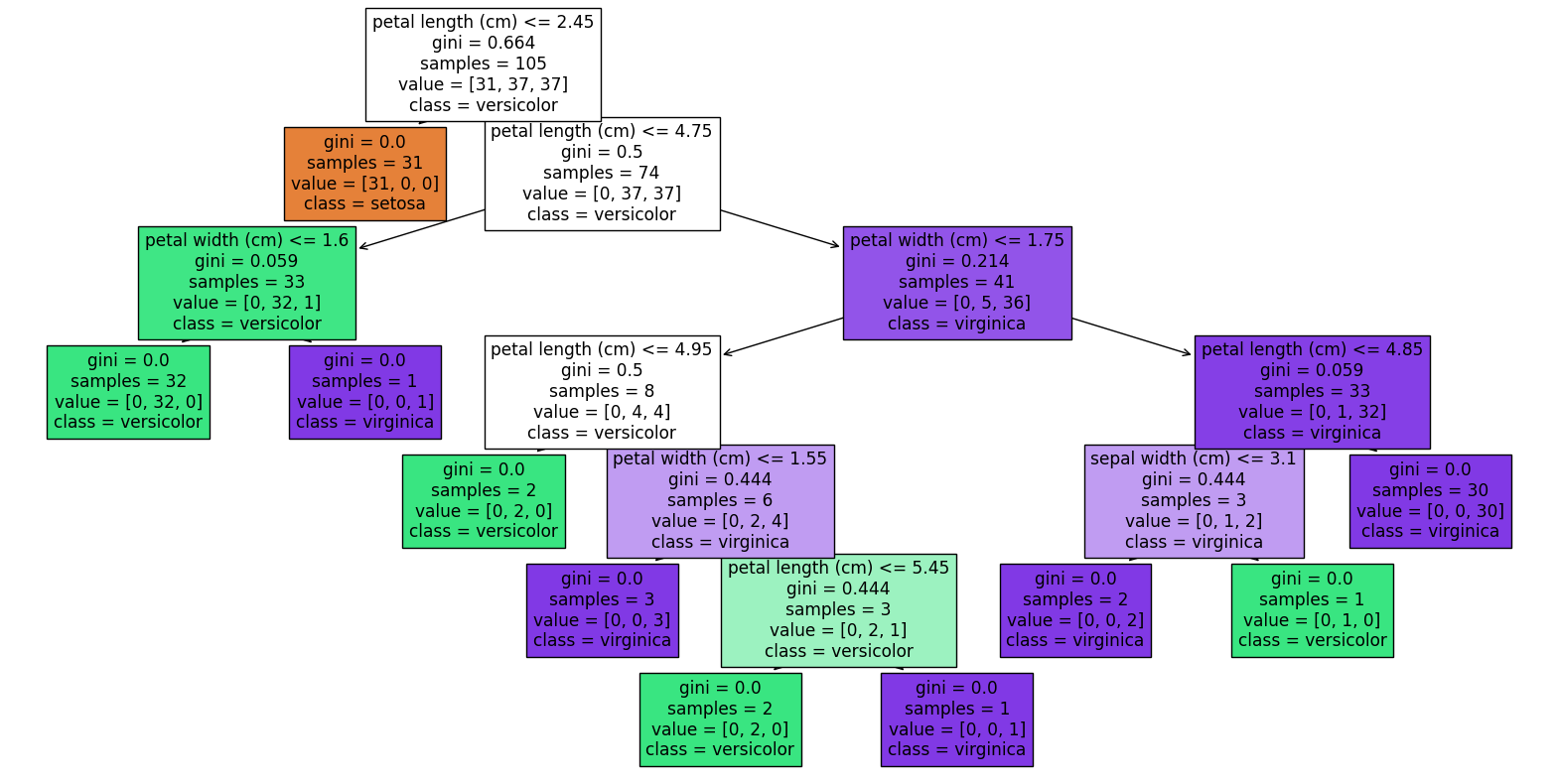

决策树可视化:

4. 总结

决策树是一种强大而直观的机器学习算法,适用于多种分类任务。在实际应用中,可能还需要考虑决策树的剪枝、随机森林等进阶技术,以进一步提高模型的性能和泛化能力。

811

811

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?