基础作业:

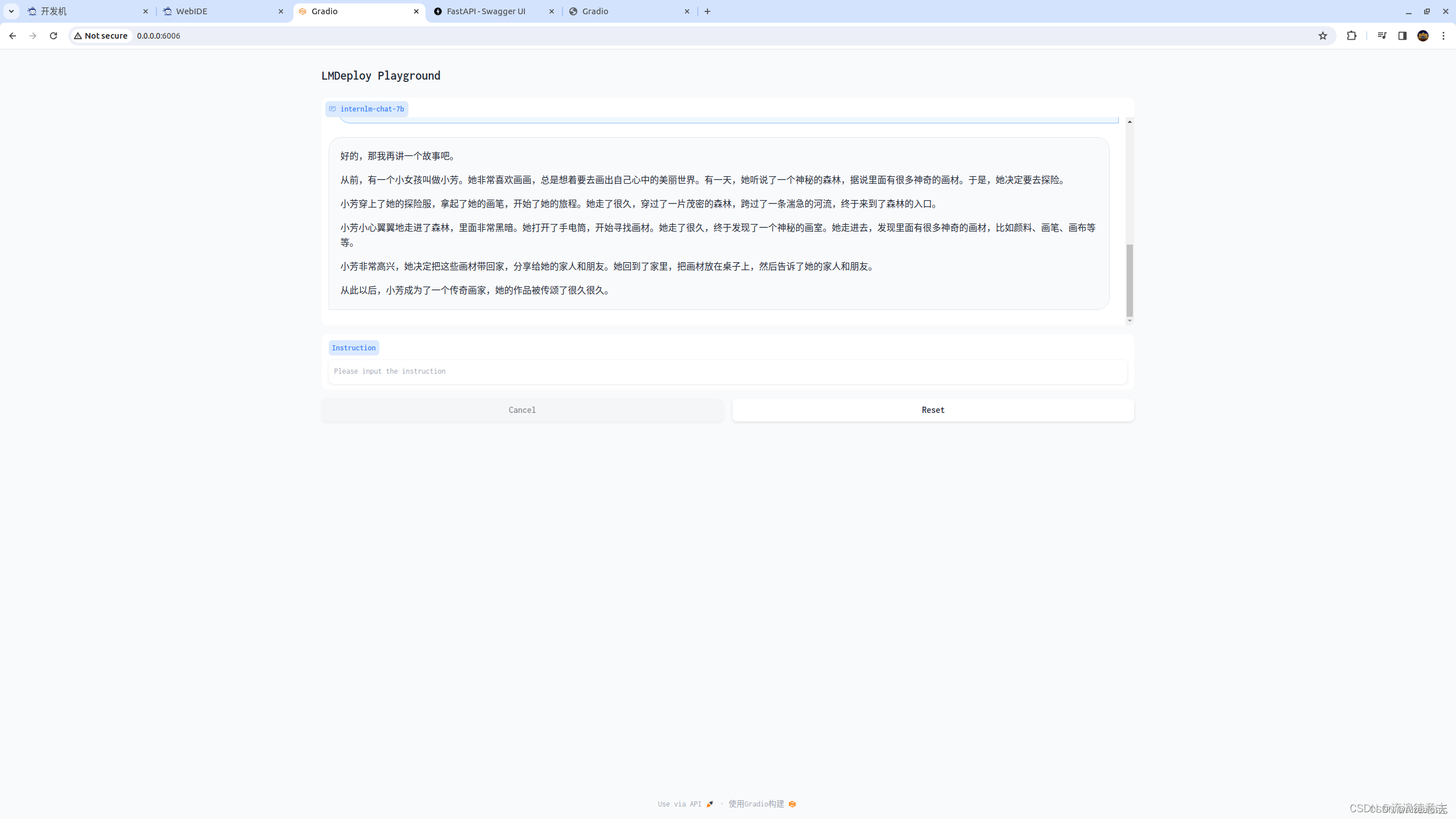

使用 LMDeploy 以本地对话、网页Gradio、API服务中的一种方式部署 InternLM-Chat-7B 模型,生成 300 字的小故事(需截图)

TurboMind 推理+命令行本地对话

lmdeploy chat turbomind /share/temp/model_repos/internlm-chat-7b/ --model-name internlm-chat-7b

TurboMind推理+API服务

一个终端

lmdeploy serve api_server ./workspace \

> --server_name 0.0.0.0 \

> --server_port 23333 \

> --instance_num 64 \

> --tp 1

另一个终端

lmdeploy serve gradio http://0.0.0.0:23333 \

> --server_name 0.0.0.0 \

> --server_port 6006 \

> --restful_api True

网页 Demo 演示:

本文介绍了如何使用LMDeploy将InternLM-Chat-7B模型部署到本地对话、网页Gradio以及API服务中,包括TurboMind推理的命令行步骤和网页Demo的演示,要求提供模型运行的截图作为示例。

本文介绍了如何使用LMDeploy将InternLM-Chat-7B模型部署到本地对话、网页Gradio以及API服务中,包括TurboMind推理的命令行步骤和网页Demo的演示,要求提供模型运行的截图作为示例。

2354

2354

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?