lecture 17:XGBoost(eXtreme Gradient Boosting )

目录

1XGBoost是什么

全称:eXtreme Gradient Boosting

作者:陈天奇(华盛顿大学博士)

基础:GBDT

所属:boosting迭代型、树类算法。

适用范围:分类、回归

优点:速度快、效果好、能处理大规模数据、支持多种语言、支 持自定义损失函数等等。

缺点:发布时间短(2014),工业领域应用较少,待检验

参考博客:http://blog.csdn.net/a819825294/article/details/51206410

2xgboost vs gbdt

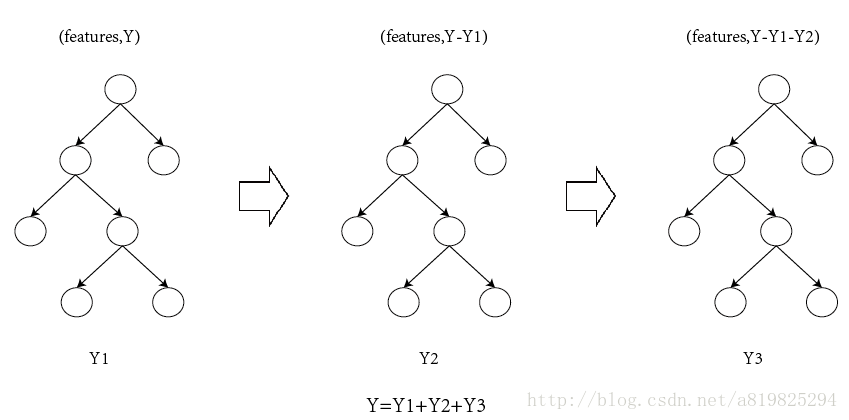

xgboost是在GBDT的基础上对boosting算法进行的改进,内部决策树使用的是回归树,简单回顾GBDT如下:

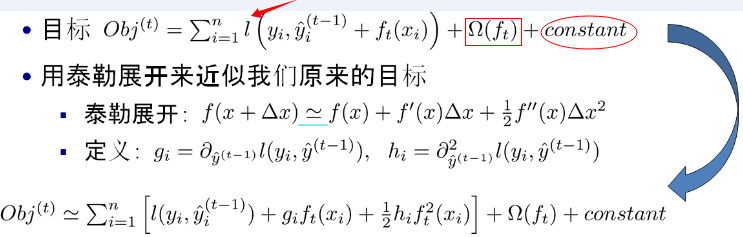

如果不考虑工程实现、解决问题上的一些差异,xgboost与gbdt比较大的不同就是目标函数的定义。

注意:

- 红色箭头指向的l即为损失函数;红色方框为正则项,包括L1、L2;红色圆圈为常数项。

- xgboost利用泰勒展开三项,做一个近似,我们可以很清晰地看到,最终的目标函数只依赖于每个数据点的在误差函数上的一阶导数和二阶导数。

3XGBoost原理

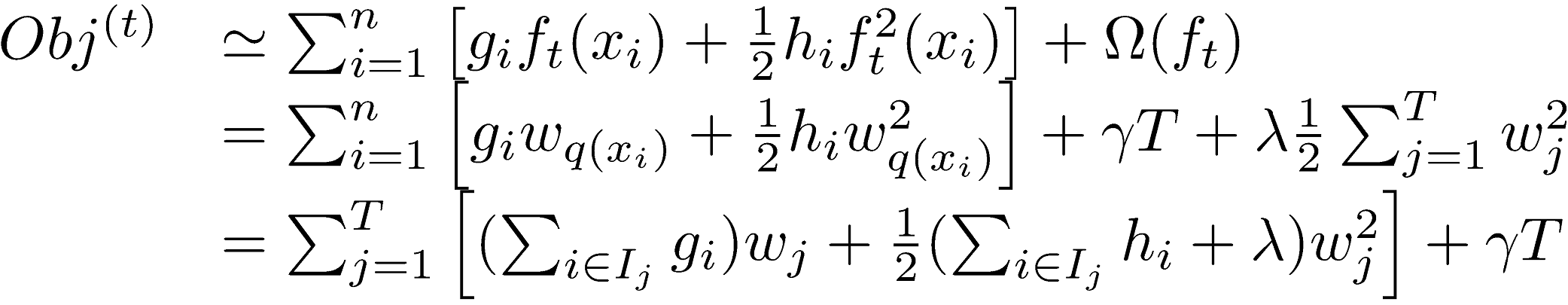

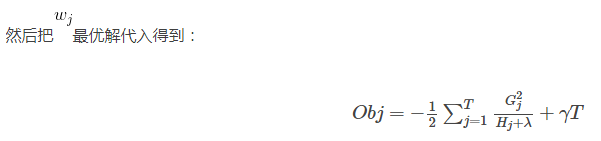

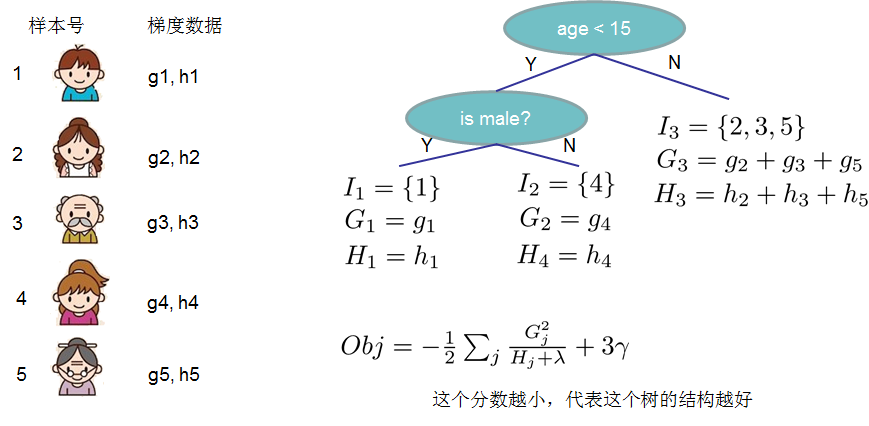

对于上面给出的目标函数,我们可以进一步化简

3.1定义树的复杂度

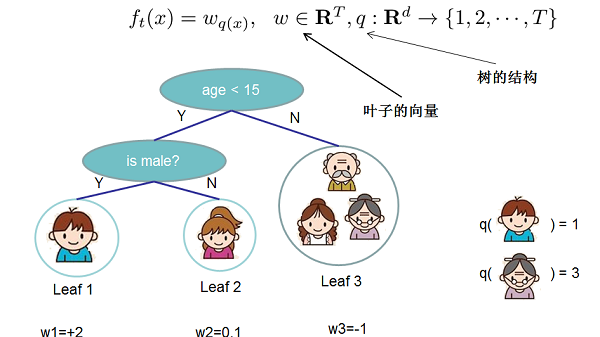

对于f的定义做一下细化,把树拆分成结构部分q和叶子权重部分w。下图是一个具体的例子。结构函数q把输入映射到叶子的索引号上面去,而w给定了每个索引号对应的叶子分数是什么。

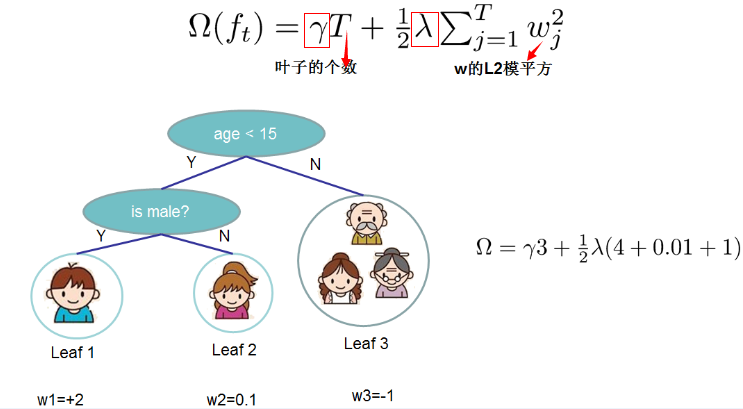

定义这个复杂度包含了一棵树里面节点的个数,以及每个树叶子节点上面输出分数的L2模平方。

当然这不是唯一的一种定义方式,不过这一定义方式学习出的树效果一般都比较不错。下图还给出了复杂度计算的一个例子

注:方框部分在最终的模型公式中控制这部分的比重,对应模型参数中的

λ,γ

λ

,

γ

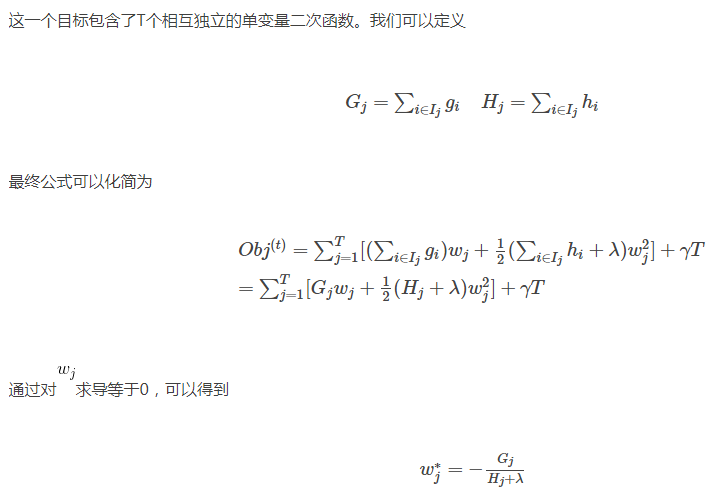

在这种新的定义下,我们可以把目标函数进行如下改写,其中I被定义为每个叶子上面样本集合

g是一阶导数,h是二阶导数

3.2打分函数计算示例

3.3分裂节点

论文中给出了两种分裂节点的方法

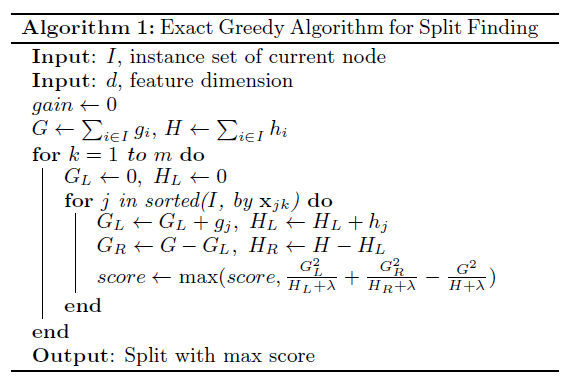

(1)贪心法:

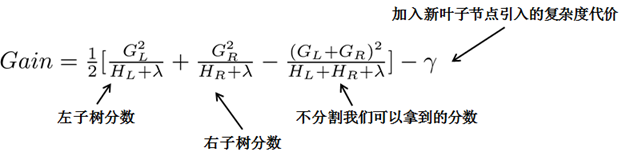

每一次尝试去对已有的叶子加入一个分割

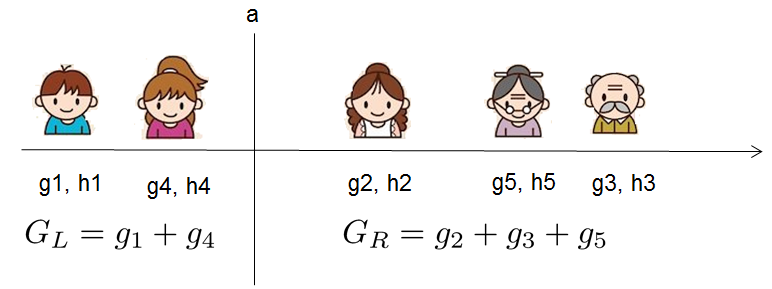

对于每次扩展,我们还是要枚举所有可能的分割方案,如何高效地枚举所有的分割呢?我假设我们要枚举所有x < a 这样的条件,对于某个特定的分割a我们要计算a左边和右边的导数和。

我们可以发现对于所有的a,我们只要做一遍从左到右的扫描就可以枚举出所有分割的梯度和GL和GR。然后用上面的公式计算每个分割方案的分数就可以了。

观察这个目标函数,大家会发现第二个值得注意的事情就是引入分割不一定会使得情况变好,因为我们有一个引入新叶子的惩罚项。优化这个目标对应了树的剪枝, 当引入的分割带来的增益小于一个阀值的时候,我们可以剪掉这个分割。大家可以发现,当我们正式地推导目标的时候,像计算分数和剪枝这样的策略都会自然地出现,而不再是一种因为heuristic(启发式)而进行的操作了。

下面是论文中的算法

(2)近似算法:

主要针对数据太大,不能直接进行计算

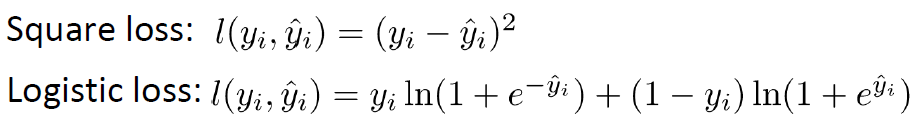

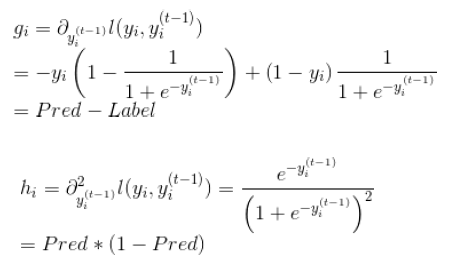

4自定义损失函数(指定grad、hess)

(1)损失函数

(2)grad、hess推导

(3)官方代码

#!/usr/bin/python

import numpy as np

import xgboost as xgb

###

# advanced: customized loss function

#

print ('start running example to used customized objective function')

dtrain = xgb.DMatrix('../data/agaricus.txt.train')

dtest = xgb.DMatrix('../data/agaricus.txt.test')

# note: for customized objective function, we leave objective as default

# note: what we are getting is margin value in prediction

# you must know what you are doing

param = {'max_depth': 2, 'eta': 1, 'silent': 1}

watchlist = [(dtest, 'eval'), (dtrain, 'train')]

num_round = 2

# user define objective function, given prediction, return gradient and second order gradient

# this is log likelihood loss

def logregobj(preds, dtrain):

labels = dtrain.get_label()

preds = 1.0 / (1.0 + np.exp(-preds))

grad = preds - labels

hess = preds * (1.0-preds)

return grad, hess

# user defined evaluation function, return a pair metric_name, result

# NOTE: when you do customized loss function, the default prediction value is margin

# this may make builtin evaluation metric not function properly

# for example, we are doing logistic loss, the prediction is score before logistic transformation

# the builtin evaluation error assumes input is after logistic transformation

# Take this in mind when you use the customization, and maybe you need write customized evaluation function

def evalerror(preds, dtrain):

labels = dtrain.get_label()

# return a pair metric_name, result

# since preds are margin(before logistic transformation, cutoff at 0)

return 'error', float(sum(labels != (preds > 0.0))) / len(labels)

# training with customized objective, we can also do step by step training

# simply look at xgboost.py's implementation of train

bst = xgb.train(param, dtrain, num_round, watchlist, logregobj, evalerror)5Xgboost调参

由于xgboost的参数过多,这里介绍两种思路

(1)GridSearch

(2)Hyperopt

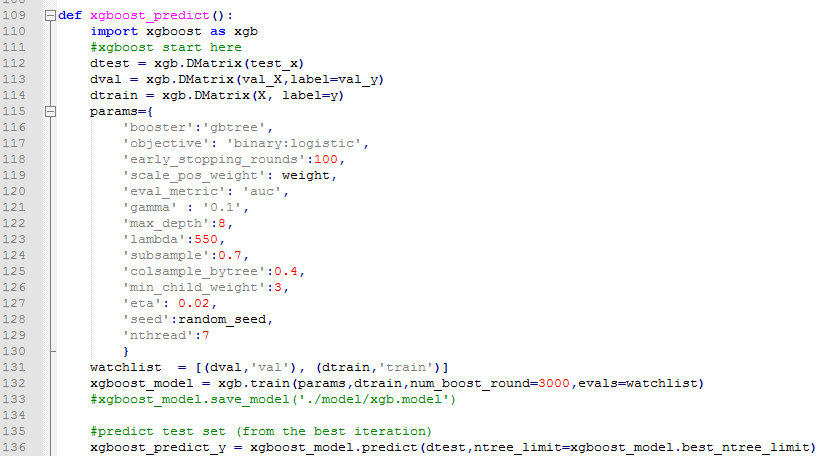

6python对于xgboost的简单使用

任务:二分类,存在样本不均衡问题(scale_pos_weight可以一定程度上解读此问题)

有一些比较重要的参数

7DART

核心思想就是将dropout引入XGBoost

import xgboost as xgb

# read in data

dtrain = xgb.DMatrix('demo/data/agaricus.txt.train')

dtest = xgb.DMatrix('demo/data/agaricus.txt.test')

# specify parameters via map

param = {'booster': 'dart',

'max_depth': 5, 'learning_rate': 0.1,

'objective': 'binary:logistic', 'silent': True,

'sample_type': 'uniform',

'normalize_type': 'tree',

'rate_drop': 0.1,

'skip_drop': 0.5}

num_round = 50

bst = xgb.train(param, dtrain, num_round)

# make prediction

# ntree_limit must not be 0

preds = bst.predict(dtest, ntree_limit=num_round)8XGBoost在sklearn的例子

from sklearn.model_selection import train_test_split

from sklearn import metrics

from sklearn.datasets import make_hastie_10_2

import xgboost as xgb

#记录程序运行时间

import time

start_time = time.time()

X, y = make_hastie_10_2(random_state=0)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.5, random_state=0)##test_size测试集合所占比例

#xgb矩阵赋值

xgb_train = xgb.DMatrix(X_train, label=y_train)

xgb_test = xgb.DMatrix(X_test,label=y_test)

##参数

params={

'booster':'gbtree',

'silent':1 ,#设置成1则没有运行信息输出,最好是设置为0.

#'nthread':7,# cpu 线程数 默认最大

'eta': 0.007, # 如同学习率

'min_child_weight':3,

# 这个参数默认是 1,是每个叶子里面 h 的和至少是多少,对正负样本不均衡时的 0-1 分类而言

#,假设 h 在 0.01 附近,min_child_weight 为 1 意味着叶子节点中最少需要包含 100 个样本。

#这个参数非常影响结果,控制叶子节点中二阶导的和的最小值,该参数值越小,越容易 overfitting。

'max_depth':6, # 构建树的深度,越大越容易过拟合

'gamma':0.1, # 树的叶子节点上作进一步分区所需的最小损失减少,越大越保守,一般0.1、0.2这样子。

'subsample':0.7, # 随机采样训练样本

'colsample_bytree':0.7, # 生成树时进行的列采样

'lambda':2, # 控制模型复杂度的权重值的L2正则化项参数,参数越大,模型越不容易过拟合。

#'alpha':0, # L1 正则项参数

#'scale_pos_weight':1, #如果取值大于0的话,在类别样本不平衡的情况下有助于快速收敛。

#'objective': 'multi:softmax', #多分类的问题

#'num_class':10, # 类别数,多分类与 multisoftmax 并用

'seed':1000, #随机种子

#'eval_metric': 'auc'

}

plst = list(params.items())

num_rounds = 100 # 迭代次数

watchlist = [(xgb_train, 'train'),(xgb_test, 'val')]

#训练模型并保存

# early_stopping_rounds 当设置的迭代次数较大时,early_stopping_rounds 可在一定的迭代次数内准确率没有提升就停止训练

model = xgb.train(plst, xgb_train, num_rounds, watchlist,early_stopping_rounds=100)

#model.save_model('./model/xgb.model') # 用于存储训练出的模型

print("best best_ntree_limit",model.best_ntree_limit)

y_pred = model.predict(xgb_test,ntree_limit=model.best_ntree_limit)

print('error=%f' % ( sum(1 for i in range(len(y_pred)) if int(y_pred[i]>0.5)!=y_test[i]) /float(len(y_pred))))

#输出运行时长

cost_time = time.time()-start_time

print("xgboost success!",'\n',"cost time:",cost_time,"(s)......")

149

149

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?