1.研究背景与意义

项目参考AAAI Association for the Advancement of Artificial Intelligence

研究背景与意义

随着计算机视觉技术的快速发展,图像识别已经成为了人工智能领域的一个重要研究方向。图像识别技术在各个领域都有广泛的应用,其中之一就是花卉图像识别。花卉图像识别可以帮助人们快速准确地识别花卉的种类和特征,对于植物学研究、园艺种植、生态环境保护等方面都具有重要的意义。

传统的花卉图像识别方法主要依赖于手工设计的特征提取算法和分类器,这些方法在一定程度上可以实现花卉图像的识别,但是存在着一些问题。首先,手工设计的特征提取算法往往需要人工经验和专业知识,对于不同的花卉种类和特征可能需要不同的特征提取算法,这给算法的设计和实现带来了一定的困难。其次,传统的分类器在处理大规模的花卉图像数据时,往往需要大量的计算资源和时间,无法满足实时性的要求。此外,传统的方法对于花卉图像中的遮挡、光照变化等问题也比较敏感,识别准确率有限。

基于深度学习的图像识别方法在解决上述问题上具有很大的优势。深度学习模型可以自动学习图像的特征表示,不需要手工设计特征提取算法,大大减轻了算法设计的难度。同时,深度学习模型可以通过大规模的训练数据进行训练,可以充分利用计算资源,提高识别的准确率和效率。此外,深度学习模型对于图像中的遮挡、光照变化等问题也具有一定的鲁棒性。

HRNet-YOLO是一种基于深度学习的目标检测算法,它结合了高分辨率网络(HRNet)和You Only Look Once(YOLO)的思想,可以实现对花卉图像中花卉目标的准确检测和识别。HRNet-YOLO具有多尺度特征融合和全局上下文信息的建模能力,可以有效地解决花卉图像中的遮挡、光照变化等问题,提高识别的准确率和鲁棒性。

因此,基于深度学习的HRNet-YOLO的花卉图像识别系统具有重要的研究意义和应用价值。通过研究该系统,可以实现对花卉图像的自动化识别和分类,为植物学研究、园艺种植、生态环境保护等领域提供有力的支持。此外,该系统还可以应用于花卉市场、花卉展览等场景,提供快速准确的花卉识别服务,提升用户体验和商业价值。因此,研究基于深度学习的HRNet-YOLO的花卉图像识别系统具有重要的理论和实践意义。

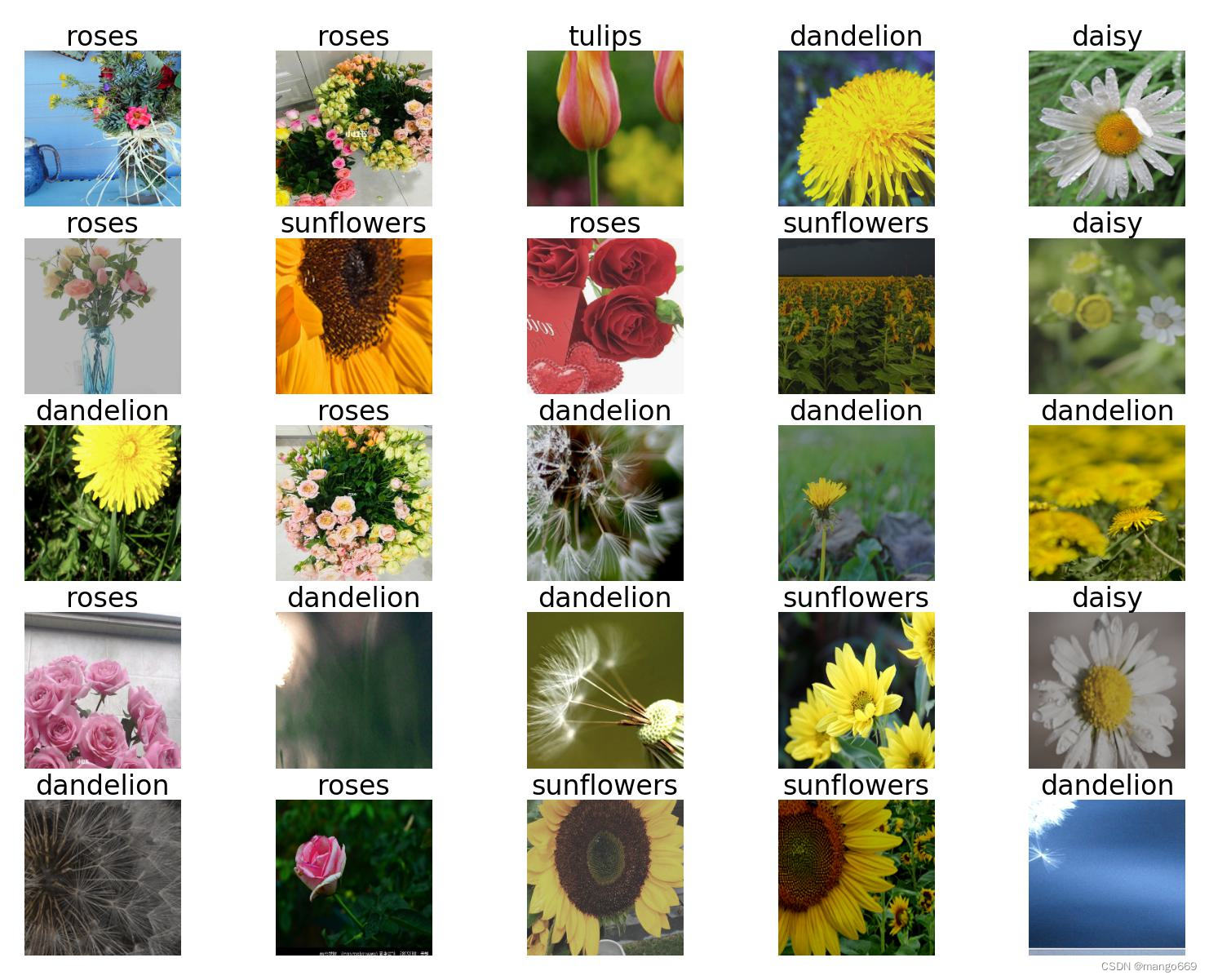

2.图片演示

3.视频演示

基于深度学习的HRNet-YOLO的花卉图像识别系统_哔哩哔哩_bilibili

4.数据集的采集&标注和整理

图片的收集

首先,我们需要收集所需的图片。这可以通过不同的方式来实现,例如使用现有的公开数据集FlowerDatasets。

下面是一个简单的方法是使用Python脚本,该脚本读取分类图片文件,然后将其转换为所需的格式。

import os

import shutil

import random

# 指定输入和输出文件夹的路径

input_dir = 'train'

output_dir = 'output'

# 确保输出文件夹存在

if not os.path.exists(output_dir):

os.makedirs(output_dir)

# 遍历输入文件夹中的所有子文件夹

for subdir in os.listdir(input_dir):

input_subdir_path = os.path.join(input_dir, subdir)

# 确保它是一个子文件夹

if os.path.isdir(input_subdir_path):

output_subdir_path = os.path.join(output_dir, subdir)

# 在输出文件夹中创建同名的子文件夹

if not os.path.exists(output_subdir_path):

os.makedirs(output_subdir_path)

# 获取所有文件的列表

files = [f for f in os.listdir(input_subdir_path) if os.path.isfile(os.path.join(input_subdir_path, f))]

# 随机选择四分之一的文件

files_to_move = random.sample(files, len(files) // 4)

# 移动文件

for file_to_move in files_to_move:

src_path = os.path.join(input_subdir_path, file_to_move)

dest_path = os.path.join(output_subdir_path, file_to_move)

shutil.move(src_path, dest_path)

print("任务完成!")

整理数据文件夹结构

我们需要将数据集整理为以下结构:

-----dataset

-----dataset

|-----train

| |-----class1

| |-----class2

| |-----.......

|

|-----valid

| |-----class1

| |-----class2

| |-----.......

|

|-----test

| |-----class1

| |-----class2

| |-----.......

模型训练

Epoch gpu_mem box obj cls labels img_size

1/200 20.8G 0.01576 0.01955 0.007536 22 1280: 100%|██████████| 849/849 [14:42<00:00, 1.04s/it]

Class Images Labels P R mAP@.5 mAP@.5:.95: 100%|██████████| 213/213 [01:14<00:00, 2.87it/s]

all 3395 17314 0.994 0.957 0.0957 0.0843

Epoch gpu_mem box obj cls labels img_size

2/200 20.8G 0.01578 0.01923 0.007006 22 1280: 100%|██████████| 849/849 [14:44<00:00, 1.04s/it]

Class Images Labels P R mAP@.5 mAP@.5:.95: 100%|██████████| 213/213 [01:12<00:00, 2.95it/s]

all 3395 17314 0.996 0.956 0.0957 0.0845

Epoch gpu_mem box obj cls labels img_size

3/200 20.8G 0.01561 0.0191 0.006895 27 1280: 100%|██████████| 849/849 [10:56<00:00, 1.29it/s]

Class Images Labels P R mAP@.5 mAP@.5:.95: 100%|███████ | 187/213 [00:52<00:00, 4.04it/s]

all 3395 17314 0.996 0.957 0.0957 0.0845

5.核心代码讲解

5.1 cls_hrnet.py

def conv3x3(in_planes, out_planes, stride=1):

"""3x3 convolution with padding"""

return nn.Conv2d(in_planes, out_planes, kernel_size=3, stride=stride,

padding=1, bias=False)

class BasicBlock(nn.Module):

expansion = 1

def __init__(self, inplanes, planes, stride=1, downsample=None):

super(BasicBlock, self).__init__()

self.conv1 = conv3x3(inplanes, planes, stride)

self.bn1 = nn.BatchNorm2d(planes, momentum=BN_MOMENTUM)

self.relu = nn.ReLU(inplace=True)

self.conv2 = conv3x3(planes, planes)

self.bn2 = nn.BatchNorm2d(planes, momentum=BN_MOMENTUM)

self.downsample = downsample

self.stride = stride

def forward(self, x):

residual = x

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

if self.downsample is not None:

residual = self.downsample(x)

out += residual

out = self.relu(out)

return out

class Bottleneck(nn.Module):

expansion = 4

def __init__(self, inplanes, planes, stride=1, downsample=None):

super(Bottleneck, self).__init__()

self.conv1 = nn.Conv2d(inplanes, planes, kernel_size=1, bias=False)

self.bn1 = nn.BatchNorm2d(planes, momentum=BN_MOMENTUM)

self.conv2 = nn.Conv2d(planes, planes, kernel_size=3, stride=stride,

padding=1, bias=False)

self.bn2 = nn.BatchNorm2d(planes, momentum=BN_MOMENTUM)

self.conv3 = nn.Conv2d(planes, planes * self.expansion, kernel_size=1,

bias=False)

self.bn3 = nn.BatchNorm2d(planes * self.expansion,

momentum=BN_MOMENTUM)

self.relu = nn.ReLU(inplace=True)

self.downsample = downsample

self.stride = stride

def forward(self, x):

residual = x

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

out = self.relu(out)

out = self.conv3(out)

out = self.bn3(out)

if self.downsample is not None:

residual = self.downsample(x)

out += residual

out = self.relu(out)

return out

class HighResolutionModule(nn.Module):

def __init__(self, num_branches, blocks, num_blocks, num_inchannels,

num_channels, fuse_method, multi_scale_output=True):

super(HighResolutionModule, self).__init__()

self._check_branches(

num_branches, blocks, num_blocks, num_inchannels, num_channels)

self.num_inchannels = num_inchannels

self.fuse_method = fuse_method

self.num_branches = num_branches

self.multi_scale_output = multi_scale_output

self.branches = self._make_branches(

num_branches, blocks, num_blocks, num_channels)

self.fuse_layers = self._make_fuse_layers()

self.relu = nn.ReLU(False)

def _check_branches(self, num_branches, blocks, num_blocks,

num_inchannels, num_channels):

if num_branches != len(num_blocks):

error_msg = 'NUM_BRANCHES({}) <> NUM_BLOCKS({})'.format(

num_branches, len(num_blocks))

logger.error(error_msg)

raise ValueError(error_msg)

if num_branches != len(num_channels):

error_msg = 'NUM_BRANCHES({}) <> NUM_CHANNELS({})'.format(

num_branches, len(num_channels))

logger.error(error_msg)

raise ValueError(error_msg)

if num_branches != len(num_inchannels):

error_msg = 'NUM_BRANCHES({}) <> NUM_INCHANNELS({})'.format(

num_branches, len(num_inchannels))

logger.error(error_msg)

raise ValueError(error_msg)

def _make_one_branch(self, branch_index, block, num_blocks, num_channels,

stride=1):

downsample = None

if stride != 1 or \

self.num_inchannels[branch_index] != num_channels[branch_index] * block.expansion:

downsample = nn.Sequential(

nn.Conv2d(self.num_inchannels[branch_index],

num_channels[branch_index] * block.expansion,

kernel_size=1, stride=stride, bias=False),

nn.BatchNorm2d(num_channels[branch_index] * block.expansion,

momentum=BN_MOMENTUM),

)

layers = []

layers.append(block(self.num_inchannels[branch_index],

num_channels[branch_index], stride, downsample))

self.num_inchannels[branch_index] = \

num_channels[branch_index] * block.expansion

for i in range(1, num_blocks[branch_index]):

layers.append(block(self.num_inchannels[branch_index],

num_channels[branch_index]))

return nn.Sequential(*layers)

def _make_branches(self, num_branches, block, num_blocks, num_channels):

branches = []

for i in range(num_branches):

branches.append(

self._make_one_branch(i, block, num_blocks, num_channels))

return nn.ModuleList(branches)

def _make_fuse_layers(self):

if self.num_branches == 1:

return None

num_branches = self.num_branches

num_inchannels = self.num_inchannels

fuse_layers = []

for i in range(num_branches if self.multi_scale_output else 1):

fuse_layer = []

for j in range(num_branches):

if j > i:

fuse_layer.append(nn.Sequential(

nn.Conv2d(num_inchannels[j],

num_inchannels[i],

1,

1,

0,

bias=False),

nn.BatchNorm2d(num_inchannels[i],

momentum=BN_MOMENTUM),

nn.Upsample(scale_factor=2**(j-i), mode='nearest')))

elif j == i:

fuse_layer.append(None)

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2691

2691

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?