摘要: 分享对论文的理解. 原文见 Xie, M.-K., & Huang, S.-J. (2022). Partial multi-label learning with noisy label identification. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 1–12.

1. 论文贡献

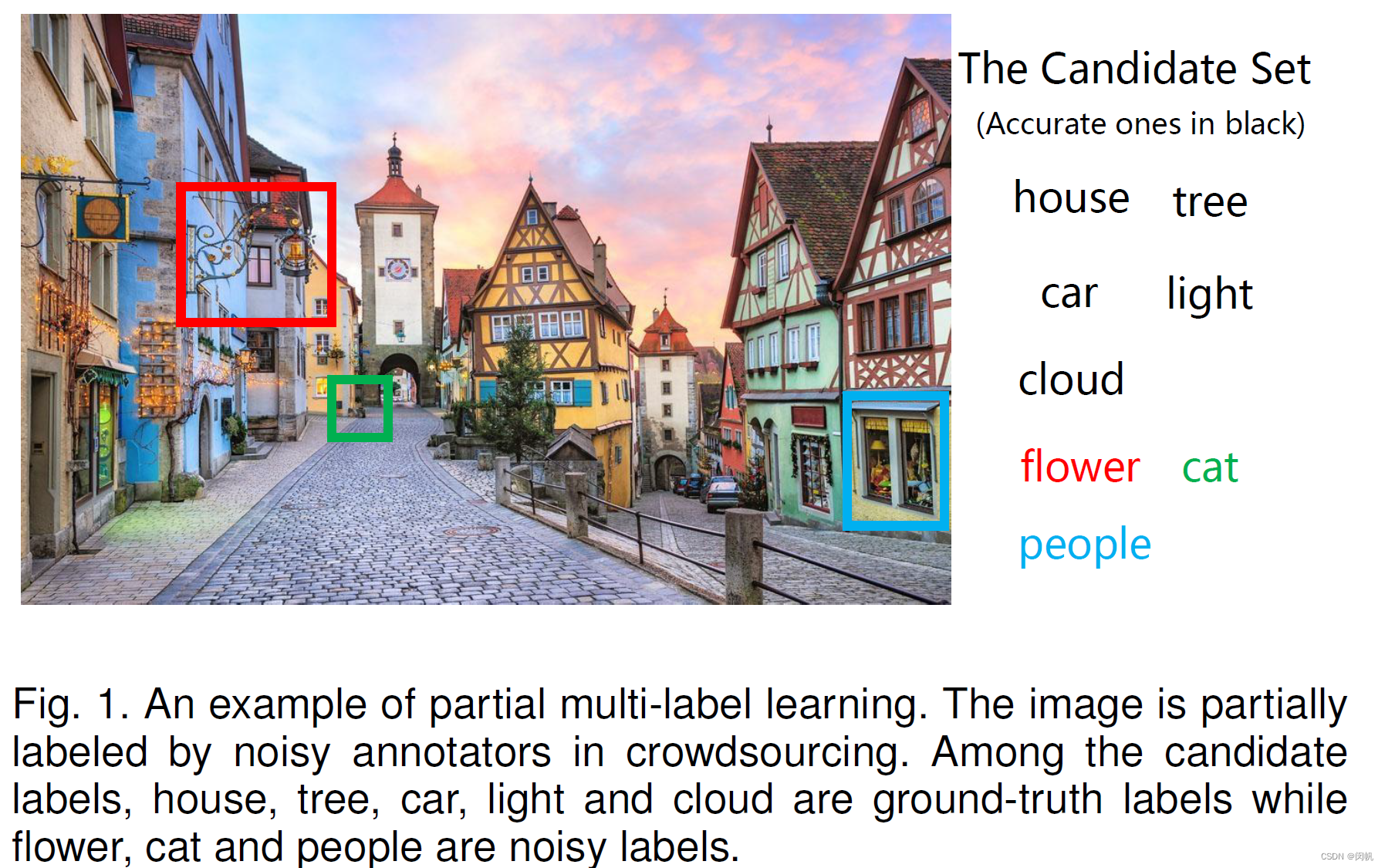

Under the supervision of the observed noise-corrupted label matrix, the multi-label classifier and noisy label identifier are jointly optimized by incorporating the label correlation exploitation and feature-induced noise model.

(采用谷歌翻译)在观察到的噪声破坏标签矩阵的监督下,通过结合标签相关性开发和特征诱导噪声模型,对多标签分类器和噪声标签识别器进行联合优化。

2. 主要思想

These methods typically assume that noisy labels are generated randomly, which may be not consistent with many real-world scenarios. In practice, we observe that noisy labels are usually caused by some ambiguous contents of the example and there thus exist some relationships between the noisy labels and feature representations.

这些方法通常假设噪声标签是随机生成的,这可能与许多现实世界的场景不一致。 在实践中,我们观察到噪声标签通常是由示例的一些模糊内容引起的,因此噪声标签和特征表示之间存在一些关系。

顺便学一波构图.

3. 符号系统

| 符号 | 含义 | 说明 |

|---|---|---|

| x ∈ R d \mathbf{x} \in \mathbb{R}^d x∈Rd | 对象 | |

| y ∈ { 0 , 1 } q \mathbf{y} \in \{0, 1\}^q y∈{0,1}q | 标签矩阵 | 使用 0 0 0 表示没有该标签 |

| X = [ x 1 , … , x n ] ∈ R d × n \mathbf{X} = [\mathbf{x}_1, \dots, \mathbf{x}_n] \in \mathbb{R}^{d \times n} X=[x1,…,xn]∈Rd×n | 属性矩阵 | 每一列对应于一个样本 |

| Y = [ y 1 , … , y n ] ∈ { 0 , 1 } q × n \mathbf{Y} = [\mathbf{y}_1, \dots, \mathbf{y}_n] \in \{0, 1\}^{q \times n} Y=[y1,…,yn]∈{0,1}q×n | 带噪声的标签矩阵 | |

| Y g \mathbf{Y}_g Yg | 真实标签矩阵 | 可能永远不知道 |

| Y n \mathbf{Y}_n Yn | 噪声标签矩阵 | Y = Y g + Y n \mathbf{Y} = \mathbf{Y}_g + \mathbf{Y}_n Y=Yg+Yn |

| W = [ w 1 , … , w q ] T ∈ R q × d \mathbf{W} = [\mathbf{w}_1, \dots, \mathbf{w}_q]^{\mathrm{T}} \in \mathbb{R}^{q \times d} W=[w1,…,wq]T∈Rq×d | 权值矩阵 | r a n k ( W ) ≤ ϵ rank(\mathbf{W}) \leq \epsilon rank(W)≤ϵ |

| S = [ s 1 , … , s q ] T ∈ R q × d \mathbf{S} = [\mathbf{s}_1, \dots, \mathbf{s}_q]^{\mathrm{T}} \in \mathbb{R}^{q \times d} S=[s1,…,sq]T∈Rq×d | 权值矩阵 | c a r d ( S ) ≤ σ card(\mathbf{S}) \leq \sigma card(S)≤σ |

| H = W + S \mathbf{H} = \mathbf{W} + \mathbf{S} H=W+S | 权值矩阵 | c a r d ( S ) ≤ σ card(\mathbf{S}) \leq \sigma card(S)≤σ |

4. 算法

Y

g

≈

W

X

(1)

\mathbf{Y}_g \approx \mathbf{W} \mathbf{X} \tag{1}

Yg≈WX(1)

要求

r

a

n

k

(

W

)

≤

ϵ

rank(\mathbf{W}) \leq \epsilon

rank(W)≤ϵ 比较奇怪, 一般来说不这么干, 线性模型相当于第

i

i

i 个标签用

w

i

\mathbf{w}_i

wi 单独预测.

Y

n

≈

S

X

(2)

\mathbf{Y}_n \approx \mathbf{S} \mathbf{X} \tag{2}

Yn≈SX(2)

要求

c

a

r

d

(

S

)

≤

σ

card(\mathbf{S}) \leq \sigma

card(S)≤σ 即非零元素个数不超过阈值, 注意向量有 0 范数, 矩阵没有. 其实这里表达的是同一个意思.

一般性的目标函数表示为:

min

H

,

W

,

S

L

(

H

,

X

,

Y

)

+

λ

R

(

H

)

,

s.t.

H

=

W

+

S

;

r

a

n

k

(

W

)

≤

ϵ

;

c

a

r

d

(

S

)

≤

σ

.

(3)

\min_{\mathbf{H}, \mathbf{W}, \mathbf{S}} L(\mathbf{H}, \mathbf{X}, \mathbf{Y}) + \lambda R(\mathbf{H}), \\\textrm{s.t. } \mathbf{H} = \mathbf{W} + \mathbf{S};\\ rank(\mathbf{W}) \leq \epsilon;\\ card(\mathbf{S}) \leq \sigma. \tag{3}

H,W,SminL(H,X,Y)+λR(H),s.t. H=W+S;rank(W)≤ϵ;card(S)≤σ.(3)

从数学上来说, 要么你指定

W

\mathbf{W}

W 和

S

\mathbf{S}

S,

H

\mathbf{H}

H 就确定了; 要么你只需要学习一个综合的

H

\mathbf{H}

H.

如果使用 Frobenius 范数损失和 Frobenius 正则, 就具体写为

min

H

,

W

,

S

1

2

∥

Y

−

H

X

∥

F

2

+

1

2

λ

∥

H

∥

F

2

,

s.t.

H

=

W

+

S

;

r

a

n

k

(

W

)

≤

ϵ

;

c

a

r

d

(

S

)

≤

σ

.

(4)

\min_{\mathbf{H}, \mathbf{W}, \mathbf{S}} \frac{1}{2}\|\mathbf{Y} - \mathbf{HX}\|_{\mathrm{F}}^2 + \frac{1}{2} \lambda \|\mathbf{H}\|_{\mathrm{F}}^2, \\\textrm{s.t. } \mathbf{H} = \mathbf{W} + \mathbf{S};\\ rank(\mathbf{W}) \leq \epsilon;\\ card(\mathbf{S}) \leq \sigma. \tag{4}

H,W,Smin21∥Y−HX∥F2+21λ∥H∥F2,s.t. H=W+S;rank(W)≤ϵ;card(S)≤σ.(4)

将其做成 Lagrange 无约束形式:

min

H

,

W

,

S

1

2

∥

Y

−

H

X

∥

F

2

+

1

2

λ

∥

H

∥

F

2

+

β

r

a

n

k

(

W

)

+

γ

c

a

r

d

(

S

)

,

s.t.

H

=

W

+

S

.

(5)

\min_{\mathbf{H}, \mathbf{W}, \mathbf{S}} \frac{1}{2}\|\mathbf{Y} - \mathbf{HX}\|_{\mathrm{F}}^2 + \frac{1}{2} \lambda \|\mathbf{H}\|_{\mathrm{F}}^2 + \beta rank(\mathbf{W}) + \gamma card(\mathbf{S}), \\\textrm{s.t. } \mathbf{H} = \mathbf{W} + \mathbf{S}. \tag{5}

H,W,Smin21∥Y−HX∥F2+21λ∥H∥F2+βrank(W)+γcard(S),s.t. H=W+S.(5)

搞了半天还是没法优化, 退而求其次,

min

H

,

W

,

S

1

2

∥

Y

−

H

X

∥

F

2

+

1

2

λ

∥

H

∥

F

2

+

β

∥

W

∥

t

r

+

γ

∥

S

∥

1

,

s.t.

H

=

W

+

S

,

(6)

\min_{\mathbf{H}, \mathbf{W}, \mathbf{S}} \frac{1}{2}\|\mathbf{Y} - \mathbf{HX}\|_{\mathrm{F}}^2 + \frac{1}{2} \lambda \|\mathbf{H}\|_{\mathrm{F}}^2 + \beta \|\mathbf{W}\|_{\mathrm{tr}} + \gamma \|\mathbf{S}\|_1, \\\textrm{s.t. } \mathbf{H} = \mathbf{W} + \mathbf{S}, \tag{6}

H,W,Smin21∥Y−HX∥F2+21λ∥H∥F2+β∥W∥tr+γ∥S∥1,s.t. H=W+S,(6)

其中

∥

W

∥

\|\mathbf{W}\|

∥W∥ 的轶换成迹,

∥

S

∥

\|\mathbf{S}\|

∥S∥ 的 0 范数换成 1 范数. 对的, 机器学习就是这样高高举起, 轻轻落下, 没有什么是不可以改的.

具体的优化找罗皓吧.

5. 小结

- 把想法用数学式子表达出来, 能使用优化算法就直接做, 不能就进行一定的替换.

- 线性模型可以进行一系列的理论分析, 但线性模型毕竟太基础. 还没想好如何把这篇论文的思想引入非线性模型.

- 一作是硕士研究生, 毫无疑问的卷王一枚.

2245

2245

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?