CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

Subjects: cs.CV

1.Locally Attentional SDF Diffusion for Controllable 3D Shape Generation

标题:用于可控 3D 形状生成的局部注意 SDF 扩散

作者:Xin-Yang Zheng, Hao Pan, Peng-Shuai Wang, Xin Tong, Yang Liu, Heung-Yeung Shum

文章链接:https://arxiv.org/abs/2305.04461

项目代码:https://zhengxinyang.github.io/projects/LAS-Diffusion.html

摘要:

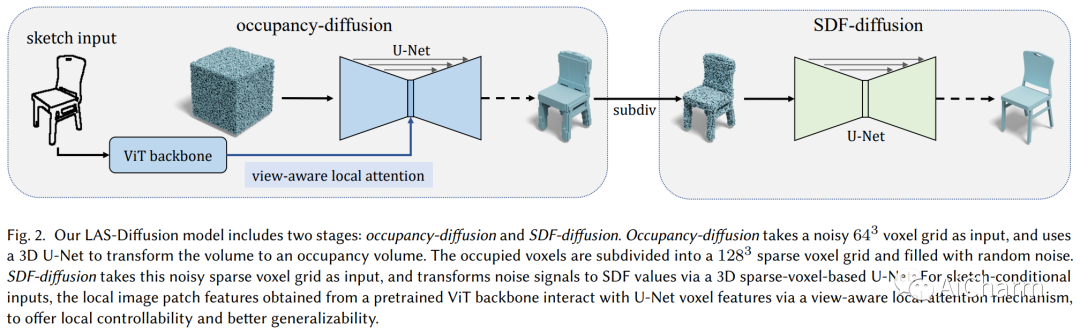

虽然最近 3D 生成神经网络的快速发展大大提高了 3D 形状的生成,但普通用户仍然不方便创建 3D 形状和控制生成形状的局部几何形状。为了应对这些挑战,我们提出了一个基于扩散的 3D 生成框架——局部注意力 SDF 扩散,通过 2D 草图图像输入来模拟合理的 3D 形状。我们的方法建立在两阶段扩散模型之上。第一阶段称为占用扩散,旨在生成一个低分辨率的占用场来近似形状壳。第二阶段,称为 SDF 扩散,在第一阶段确定的占用体素内合成高分辨率符号距离场,以提取精细几何形状。我们的模型由一种用于图像条件形状生成的新型视图感知局部注意机制提供支持,该机制利用 2D 图像块特征来指导 3D 体素特征学习,极大地提高了局部可控性和模型的通用性。通过在草图条件和类别条件 3D 形状生成任务中进行大量实验,我们验证并展示了我们的方法提供合理且多样化的 3D 形状的能力,以及其优于现有工作的可控性和普遍性。我们的代码和经过训练的模型可在此 https URL 上获得

2.EfficientViT: Memory Efficient Vision Transformer with Cascaded Group Attention

标题:EfficientViT:具有级联组注意力的高效内存视觉转换器

作者:Xinyu Liu, Houwen Peng, Ningxin Zheng, Yuqing Yang, Han Hu, Yixuan Yuan

文章链接:https://arxiv.org/abs/2305.07027

项目代码:https://github.com/microsoft/Cream/tree/main/EfficientViT

摘要:

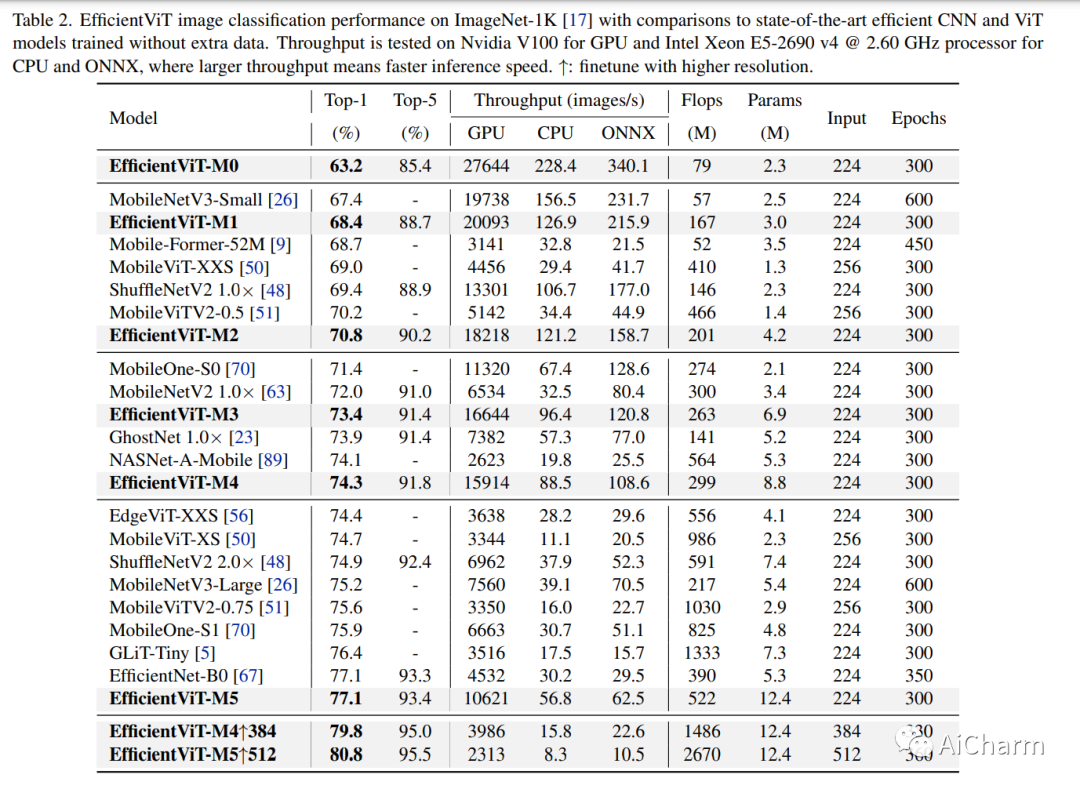

视觉转换器因其高模型能力而取得了巨大的成功。然而,它们卓越的性能伴随着沉重的计算成本,这使得它们不适合实时应用。在本文中,我们提出了一个名为 EfficientViT 的高速视觉转换器系列。我们发现现有 Transformer 模型的速度通常受内存低效操作的限制,尤其是 MHSA 中的张量重塑和逐元素函数。因此,我们设计了一种具有三明治布局的新构建块,即在高效 FFN 层之间使用单个内存绑定 MHSA,从而提高内存效率,同时增强通道通信。此外,我们发现注意力图在头部之间具有高度相似性,从而导致计算冗余。为了解决这个问题,我们提出了一个级联的组注意力模块,为注意力头提供不同的完整特征分割,这不仅节省了计算成本,而且提高了注意力的多样性。综合实验表明 EfficientViT 优于现有的高效模型,在速度和准确性之间取得了良好的平衡。例如,我们的 EfficientViT-M5 在精度上比 MobileNetV3-Large 高出 1.9%,同时在 Nvidia V100 GPU 和英特尔至强 CPU 上的吞吐量分别高出 40.4% 和 45.2%。与最近的高效模型 MobileViT-XXS 相比,EfficientViT-M2 的精度提高了 1.8%,同时在 GPU/CPU 上的运行速度提高了 5.8 倍/3.7 倍,转换为 ONNX 格式时速度提高了 7.4 倍。此 https URL 上提供了代码和模型。

3.The emergence of clusters in self-attention dynamics

标题:自注意力动力学中集群的出现

作者:Borjan Geshkovski, Cyril Letrouit, Yury Polyanskiy, Philippe Rigollet

文章链接:https://arxiv.org/abs/2304.05977

摘要:

将变形金刚视为相互作用的粒子系统,当权重不依赖于时间时,我们描述了学习表示的几何形状。我们表明,随着时间趋于无穷大,代表标记的粒子倾向于聚集到特定的限制对象。出现的限制对象的类型取决于值矩阵的范围。此外,在一维情况下,我们证明自注意力矩阵收敛到低秩布尔矩阵。这些结果的组合在数学上证实了 Vaswani 等人所做的经验观察。在 Transformers 处理时出现在一系列标记中。

更多Ai资讯:公主号AiCharm

2917

2917

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?