Guo, M.-H., Cai, J.-X., Liu, Z.-N., Mu, T.-J., Martin, R. R., & Hu, S.-M. (2021). PCT: Point cloud transformer. Computational Visual Media, 7(2), 187–199. https://doi.org/10.1007/s41095-021-0229-5

PCT:点云transformer

摘要

这篇论文介绍了一种名为“点云Transformer”(Point Cloud Transformer,PCT)的新型框架,用于点云学习。由于点云的不规则域和缺乏顺序,设计用于点云处理的深度神经网络具有挑战性。PCT基于变压器(Transformer)构建,该架构在自然语言处理中取得了巨大成功,并在图像处理中展现了巨大潜力。由于其固有的排列不变性,适用于处理点序列,使其非常适用于点云学习。为了更好地捕捉点云中的局部上下文,该方法采用了最远点采样和最近邻搜索的方法来增强输入嵌入。广泛的实验证明,PCT在形状分类、部分分割、语义分割和法线估计等任务上取得了业界领先的性能。

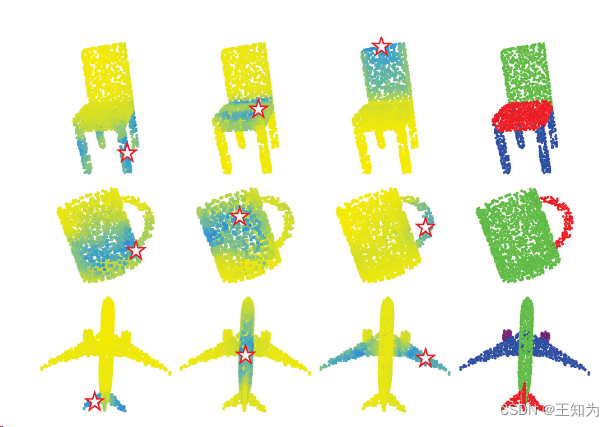

图1:PCT生成的注意力图和部分分割。前三列:不同查询点的逐点注意力图(由指示),黄色到蓝色表示逐渐增加的注意力权重。最后一列:部分分割结果。

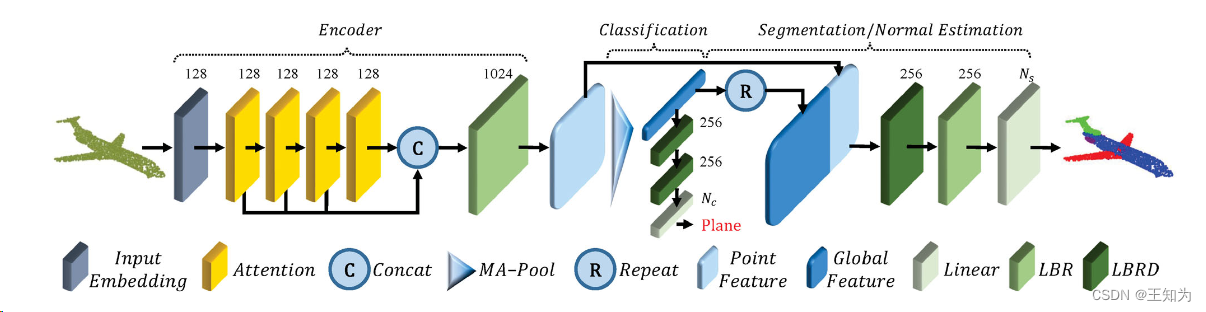

图2:PCT架构。编码器主要包括一个输入嵌入模块和四个堆叠的注意力模块。解码器主要包括多个线性层。每个模块上方的数字表示其输出通道数。MA-Pool将最大池化和平均池化连接在一起。LBR组合了线性、批归一化和ReLU层。LBRD表示LBR后跟一个Dropout层。

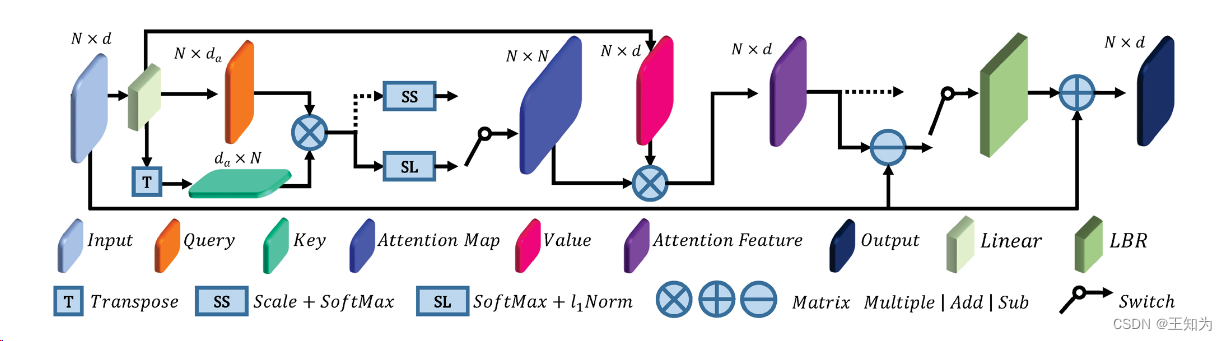

图3:Offset-Attention的架构。张量上方的数字是维度N和特征通道数D/Da,开关显示了Self-Attention或Offset-Attention的替代方案:虚线表示Self-Attention分支。

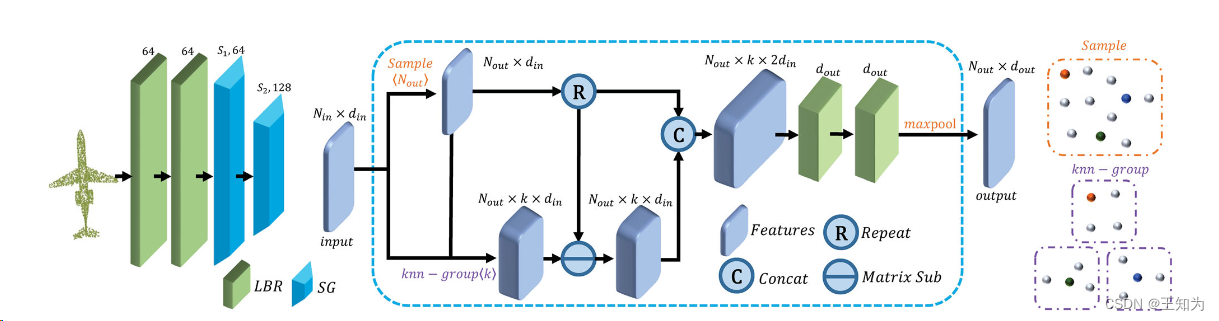

图4:左侧:邻居嵌入架构。中间:SG模块,其中Nin是输入点数,din是输入通道数,k是邻居数,Nout是输出采样点数,dout是输出通道数。右上方:采样示例(彩色球代表采样点)。右下方:带有k-NN邻居的分组示例。LBR上方的数字:输出通道数。SG上方的数字:采样点数及其输出通道数。

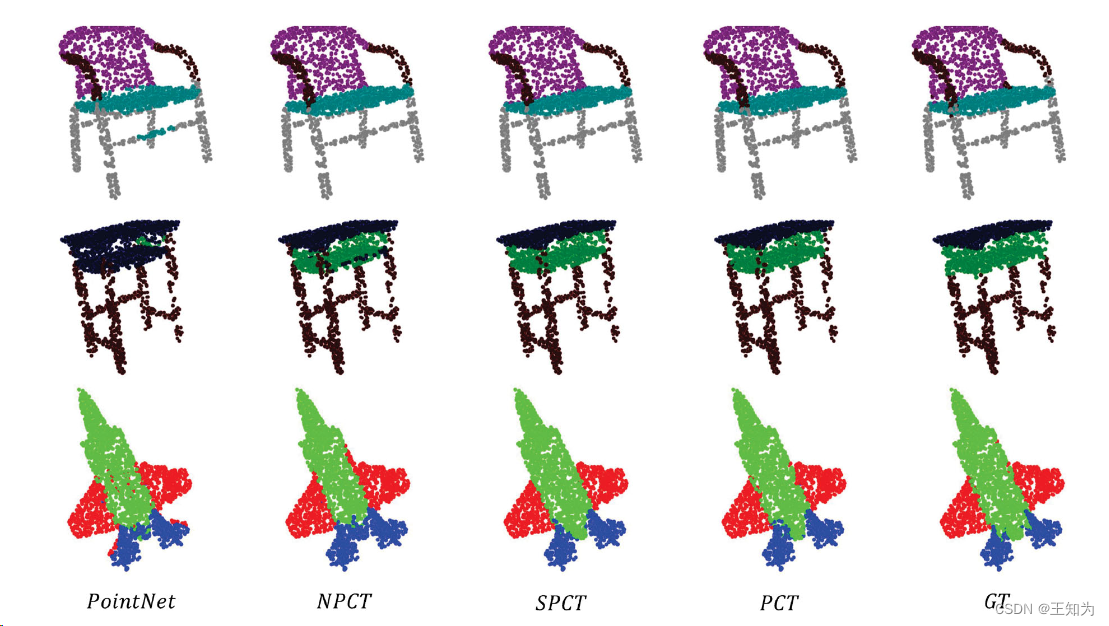

图5:PointNet、NPCT、SPCT、PCT和真实值(GT)的分割结果。

4633

4633

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?