一、卷积神经网络

卷积层、池化层、全链接层

卷积层:特征提取

池化层:压缩

卷积层=卷积+激活函数

激活函数:非线性激活函数

卷积神经网络:https://blog.csdn.net/Ace_Yom/article/details/47254023

https://blog.csdn.net/yunpiao123456/article/details/52437794

https://blog.csdn.net/zouxy09/article/details/8781543

二、卷积层

- 对应代码:

self.conv1=nn.Conv2d(in_dim,6,3,stride=1,padding=1)

nn.Conv1d与nn.Conv2d的区别:1维和2维,图解说明卷积神经的网络的大小变化。

nn.Conv2d(self, in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True))

参数:

in_channel: 输入数据的通道数,例RGB图片通道数为3;

out_channel: 输出数据的通道数,这个根据模型调整;

kennel_size: 卷积核大小,可以是int,或tuple;kennel_size=2,意味着卷积大小2, kennel_size=(2,3),意味着卷积在第一维度大小为2,在第二维度大小为3;

stride:步长,默认为1,与kennel_size类似,stride=2,意味在所有维度步长为2, stride=(2,3),意味着在第一维度步长为2,意味着在第二维度步长为3;

padding: 零填充

三、BatchNorm

- 对应代码:

self.batch_norm1=nn.BatchNorm2d(6)

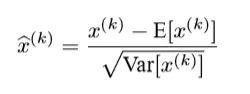

总的来说,bn的操作很简单,也很容易理解。就是在网络的每一层输入之前,做了一个归一化处理,就是作用于(wu+b),即bn(wu+b),然后再接激活函数(非线性映射)。

https://www.jianshu.com/p/86530a0a3935

四、池化

self.pool=nn.Maxpool2d(2,2)

class torch.nn.MaxUnpool2d(kernel_size, stride=None, padding=0)

五、全连接层

全连接层的作用是什么? - 蒋竺波的回答 - 知乎

https://www.zhihu.com/question/41037974/answer/320267531

参考文档:https://blog.csdn.net/qq_31417941/article/details/85056252

完整代码:https://github.com/viki6666/Pytorch_learn/blob/master/CNN_MNIST.ipynb

1155

1155

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?