1,模型转换atc模型转换

模型转换如图

参考链接如下:

https://toscode.mulanos.cn/ascend/samples/tree/master/inference/modelInference/sampleResnetQuickStart/cpp

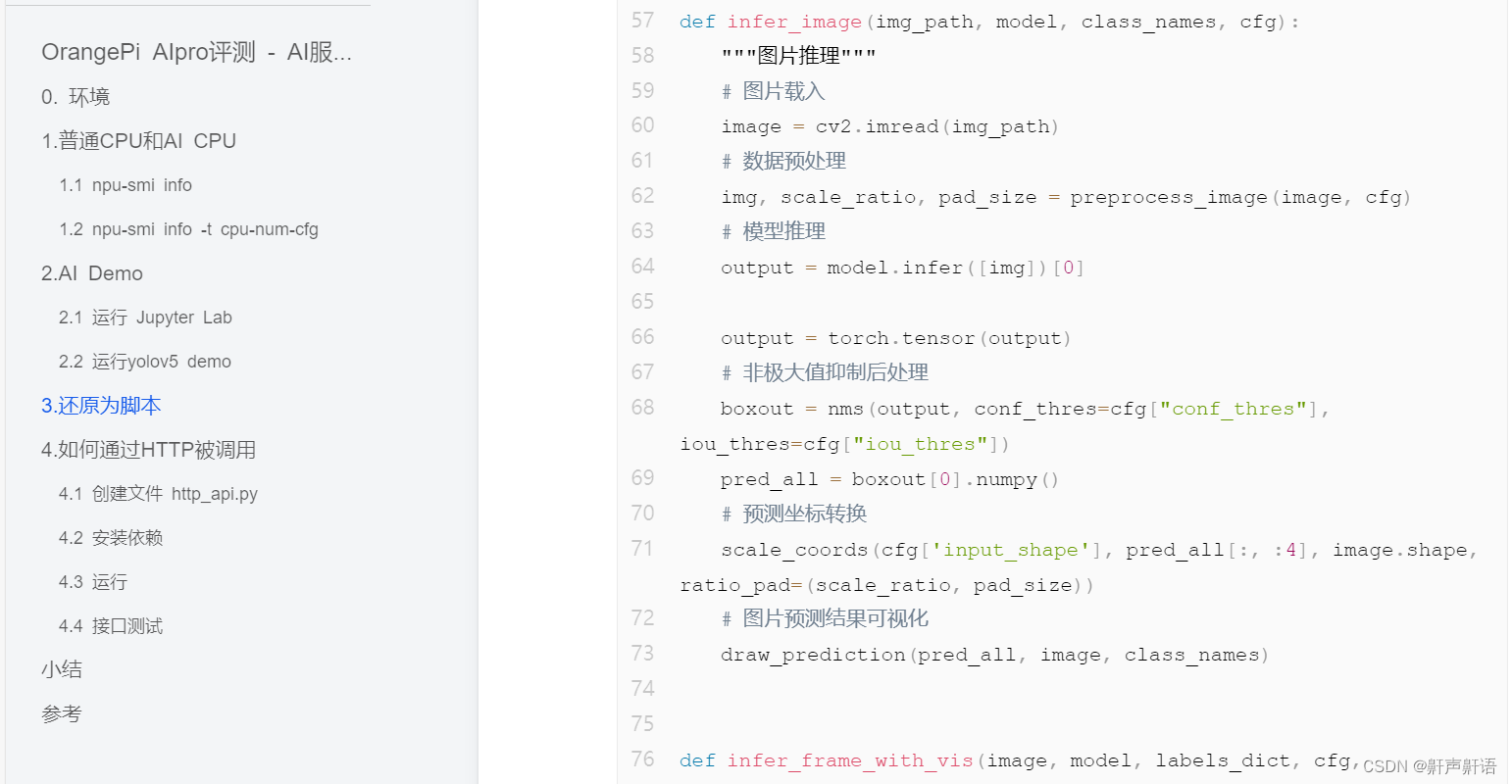

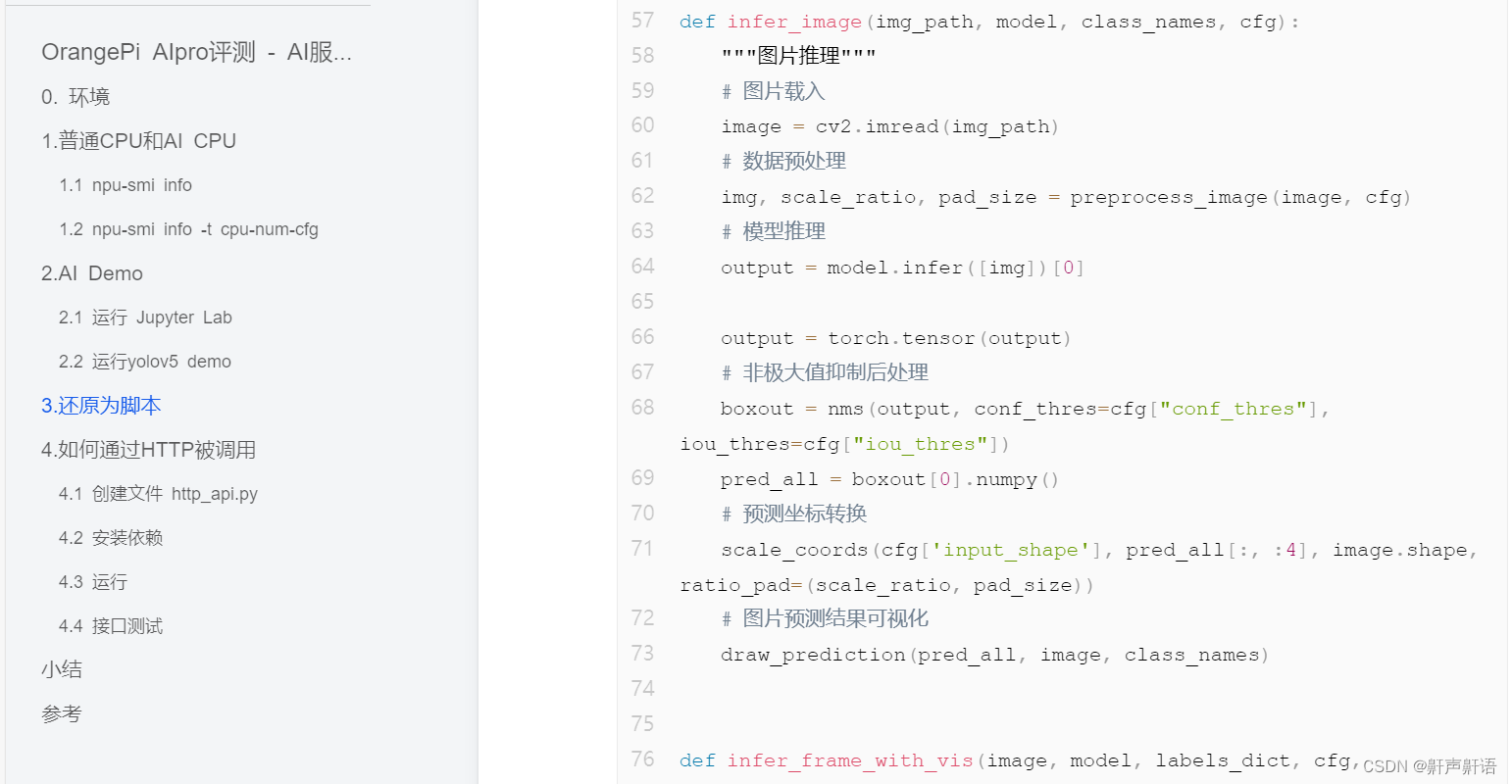

2,推理运行,这里需要注意用到了infer,有点类似的pytorch对模型的加载使用

model = InferSession(0, model_path)

参考链接1:

模型转换如图

参考链接如下:

https://toscode.mulanos.cn/ascend/samples/tree/master/inference/modelInference/sampleResnetQuickStart/cpp

model = InferSession(0, model_path)

参考链接1:

834

834

686

686

2170

2170

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?