01

「Example系列的前世今生」

我们希望成为 LLM 与普罗大众的阶梯,以自由、平等的开源精神,拥抱更恢弘而辽阔的 LLM 世界。

Self-llm 开源项目是一个围绕开源大模型、针对国内初学者、适合中国宝宝的专属大模型教程,针对各类开源大模型提供包括环境配置、本地部署、高效微调等技能在内的全流程指导,简化开源大模型的部署、使用和应用流程,让更多的普通学生、研究者更好地使用开源大模型,帮助开源、自由的大模型更快融入到普通学习者的生活中。

为了进一步深化学习者对大模型应用的理解,self-llm项目特别增加了大模型最佳实践应用集合。应用将不断更新,以反映最新的技术进展和应用趋势。筹备已久 self-llm examples 系列第一期现已更新,这标志着我们self-llm项目的进一步拓展。

Examples 系列的目标是帮助学习者在完成基础知识学习后,通过精选的实际案例,深入理解和掌握大模型应用开发的核心技术。这些案例将涵盖不同的实际应用类型,引导学习者探讨和实践如何有效利用大模型解决实际问题。我们期望,通过这些精心设计的大模型应用项目示范(Demo),学习者能够在完成我们的示例后,不仅全面掌握大模型应用开发的技术要点,还能具备独立进行大模型应用的二次开发或自主开发的能力。项目以教程及blog形式展示。

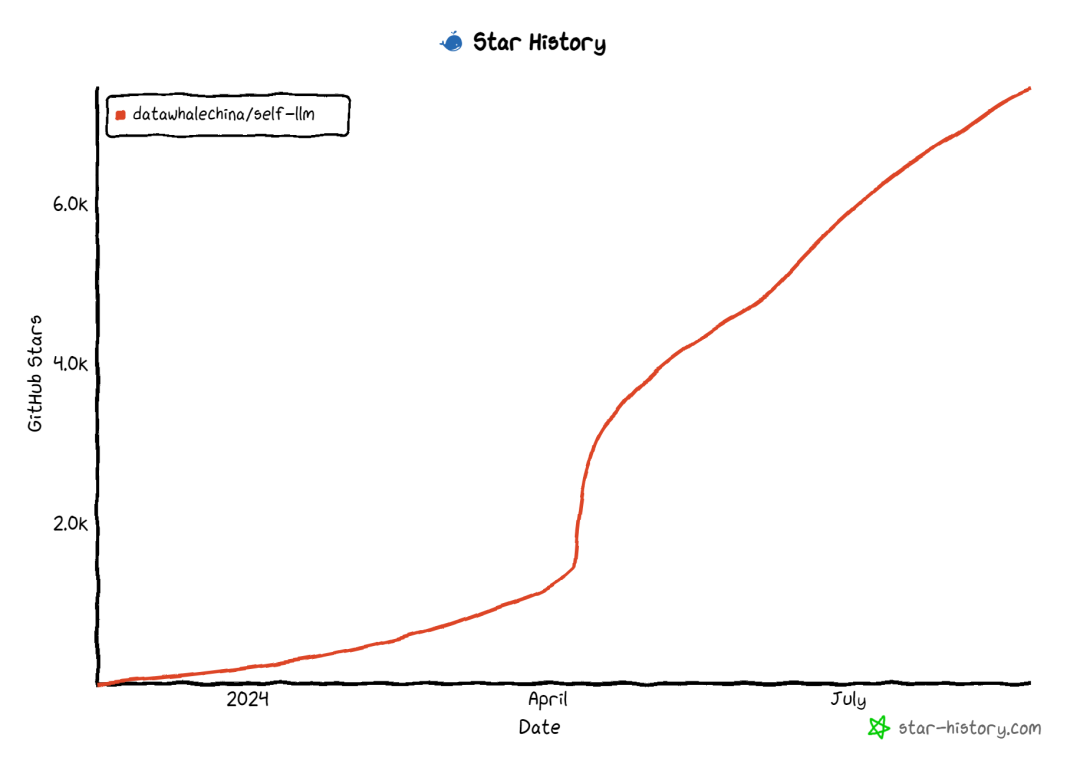

项目地址↓ 欢迎 Star ⭐️

https://github.com/datawhalechina/self-llm/tree/master/examples

02

Examples系列第一期

「Chat嬛嬛 是如何炼成的」

Chat-甄嬛是利用《甄嬛传》剧本中所有关于甄嬛的台词和语句,基于大模型进行LoRA微调得到的模仿甄嬛语气的聊天语言模型。

甄嬛,小说《后宫·甄嬛传》及同名电视剧女主角,原为汉人甄远道之女,后被雍正帝赐姓钮祜禄氏,成为满洲上三旗成员。因容貌酷似已故纯元皇后而入宫,历经宫斗,从青涩少女成长为宫斗高手。在皇帝发现年氏一族野心后,甄嬛协助皇帝剪除政敌,深得宠爱。经历被皇后陷害、出宫为尼、与果郡王相爱等波折后,设计回宫并生下双生子。最终在一系列阴谋中斗垮皇后,毒杀雍正,成为乾隆帝的圣母皇太后,权倾朝野。

Chat-甄嬛,实现了以《甄嬛传》为切入点,打造一套基于小说、剧本的个性化 AI 微调大模型完整流程,通过提供任一小说、剧本,指定人物角色,运行本项目完整流程,让每一位用户都基于心仪的小说、剧本打造一个属于自己的、契合角色人设、具备高度智能的个性化 AI。

Chat-嬛嬛模型累计下载量 15.6k

Modelscope 地址:

https://www.modelscope.cn/models/kmno4zx/huanhuan-chat-internlm2

Chat-嬛嬛累计获得 500 star

huahuan-chat 项目地址:

https://github.com/KMnO4-zx/huanhuan-chat.git

xlab-huanhuan-chat 项目地址:

https://github.com/KMnO4-zx/xlab-huanhuan.git

OK,那接下来我将会带领大家亲自动手,一步步实现 Chat-甄嬛 的训练过程,让我们一起来体验一下吧~

Step 1: 环境准备

本文基础环境如下:

\----------------

ubuntu 22.04

python 3.12

cuda 12.1

pytorch 2.3.0

\----------------

本文默认学习者已安装好以上 Pytorch(cuda) 环境,如未安装请自行安装。

首先 pip 换源加速下载并安装依赖包

# 升级pip

python -m pip install --upgrade pip

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

pip install modelscope==1.16.1

pip install transformers==4.43.1

pip install accelerate==0.32.1

pip install peft==0.11.1

pip install datasets==2.20.0

Step 2: 数据准备

首先,我们需要准备《甄嬛传》剧本数据,这里我们使用了《甄嬛传》剧本数据,我们可以查看一下原始数据的格式。

第2幕

(退朝,百官散去)

官员甲:咱们皇上可真是器重年将军和隆科多大人。

官员乙:隆科多大人,恭喜恭喜啊!您可是国家的大功臣啊!

官员丙:年大将军,皇上对你可是垂青有加呀!

官员丁:年大人,您可是皇上的股肱之臣哪!

苏培盛(追上年羹尧):年大将军请留步。大将军——

年羹尧:苏公公,有何指教?

苏培盛:不敢。皇上惦记大将军您的臂伤,特让奴才将这秘制的金创药膏交给大人,叫您使用。

年羹尧(遥向金銮殿拱手):臣年羹尧恭谢皇上圣恩!敢问苏公公,小妹今日在宫中可好啊?

苏培盛:华妃娘娘凤仪万千、宠冠六宫啊,大将军您放心好了。

年羹尧:那就有劳苏公公了。(转身离去)

苏培盛:应该的。

每一句都有人物及对应的台词,所以就可以很简单的将这些数据处理成对话的形式,如下:

\[

{"rloe":"官员甲", "content":"咱们皇上可真是器重年将军和隆科多大人。"},

{"rloe":"官员乙", "content":"隆科多大人,恭喜恭喜啊!您可是国家的大功臣啊!"},

{"rloe":"官员丙", "content":"年大将军,皇上对你可是垂青有加呀!"},

{"rloe":"官员丁", "content":"年大人,您可是皇上的股肱之臣哪!"},

{"rloe":"苏培盛", "content":"年大将军请留步。大将军——"},

...

\]

然后再将我们关注的角色的对话提取出来,形成 QA 问答对。对于这样的数据,我们可以使用正则表达式或者其他方法进行快速的提取,并抽取出我们关注的角色的对话。

然后很多情况下,我们并没有这样优秀的台词格式数据。所以我们可能就需要从一大段文本中抽取角色的对话数据,然后将其转换成我们需要的格式。

比如《西游记白话文》,我们可以看到他的文本是这样的。对于这样的文本,那我们就需要借助大模型的能力,从文本中提取出角色和角色对应的对话。然后再筛选出我们需要的橘角色对话。

可以借助一个小工具:extract-dialogue 从文本中提取对话。

......

原来孙悟空走了以后,有一个混世魔王独占了水帘洞,并且抢走了许多猴子猴孙。孙悟空听到这些以后,气得咬牙跺脚。他问清了混世魔王的住处,决定找混世魔王报仇,便驾着筋斗云,朝北方飞去。

不一会儿,孙悟空就来到混世魔王的水脏洞前,对门前的小妖喊到∶“你家那个狗屁魔王,多次欺负我们猴子。我今天来,要和那魔王比比高低!

”小妖跑进洞里,报告魔王。魔王急忙穿上铁甲,提着大刀,在小妖们的簇拥下走出洞门。

孙悟空赤手空拳,夺过了混世魔王的大刀,把他劈成了两半。然后,拔下一把毫毛咬碎喷了出去,毫毛变成许多小猴子,直杀进洞里,把所有的妖精全杀死,然后救出被抢走的小猴子,放了一把火烧了水脏洞。

......

chat-甄嬛 的原始数据:

https://github.com/KMnO4-zx/huanhuan-chat/tree/master/dataset/input/huanhuan

西游记白话文原始数据:

https://github.com/KMnO4-zx/huanhuan-chat/blob/master/dataset/input/wukong/%E8%A5%BF%E6%B8%B8%E8%AE%B0%E7%99%BD%E8%AF%9D%E6%96%87.txt

最后再将其整理成 json 格式的数据,如下:

\[

{

"instruction": "小姐,别的秀女都在求中选,唯有咱们小姐想被撂牌子,菩萨一定记得真真儿的——",

"input": "",

"output": "嘘——都说许愿说破是不灵的。"

},

{

"instruction": "这个温太医啊,也是古怪,谁不知太医不得皇命不能为皇族以外的人请脉诊病,他倒好,十天半月便往咱们府里跑。",

"input": "",

"output": "你们俩话太多了,我该和温太医要一剂药,好好治治你们。"

},

{

"instruction": "嬛妹妹,刚刚我去府上请脉,听甄伯母说你来这里进香了。",

"input": "",

"output": "出来走走,也是散心。"

}

\]

Chat-嬛嬛 的数据:

https://github.com/datawhalechina/self-llm/blob/master/dataset/huanhuan.json

所以,在这一步处理数据的大致思路就是:

1. 从原始数据中提取出角色和对话

2. 筛选出我们关注的角色的对话

3. 将对话转换成我们需要的格式

这一步也可以增加数据增强的环节,比如利用两到三条数据作为 example 丢给LLM,让其生成风格类似的数据。再或者也可以找一部分日常对话的数据集,使用 RAG 生成一些固定角色风格的对话数据。这里大家可以完全放开的大胆去尝试!

Step 3: 模型训练

那这一步,大家可能再熟悉不过了。在self-llm的每一个模型中,都会有一个 Lora 微调模块,我们只需要将数据处理成我们需要的格式,然后再调用我们的训练脚本即可。

此处选择我们选择 LLaMA3_1-8B-Instruct 模型进行微调,首先还是要下载模型,创建一个model_download.py文件,输入以下内容:

import torch

from modelscope import snapshot\_download, AutoModel, AutoTokenizer

import os

model\_dir = snapshot\_download('LLM-Research/Meta-Llama-3.1-8B-Instruct', cache\_dir='/root/autodl-tmp', revision='master')

注意:记得修改

cache_dir为你的模型下载路径哦~

其次,准备训练代码。对于熟悉 self-llm 的同学来说,这一步可能再简单不过了,在此处我会在当前目录下放置train.py,大家修改其中的数据集路径和模型路径即可。

当然也可以使用 self-llm 中的 lora 微调教程。

教程地址:

https://github.com/datawhalechina/self-llm/blob/master/models/LLaMA3/04-LLaMA3-8B-Instruct%20Lora%20%E5%BE%AE%E8%B0%83.md

在命令行运行以下指令:

python train.py

注意:记得修改 train.py 中的数据集路径和模型路径哦~

训练大概会需要 20 ~ 30 分钟的时间,训练完成之后会在output目录下生成lora模型。可以使用以下代码进行测试:

from transformers import AutoModelForCausalLM, AutoTokenizer

import torch

from peft import PeftModel

mode\_path = './LLM-Research/Meta-Llama-3\_\_\_1-8B-Instruct'

lora\_path = './output/llama3\_1\_instruct\_lora/checkpoint-699' # 这里改称你的 lora 输出对应 checkpoint 地址

# 加载tokenizer

tokenizer = AutoTokenizer.from\_pretrained(mode\_path, trust\_remote\_code=True)

# 加载模型

model = AutoModelForCausalLM.from\_pretrained(mode\_path, device\_map="auto",torch\_dtype=torch.bfloat16, trust\_remote\_code=True).eval()

# 加载lora权重

model = PeftModel.from\_pretrained(model, model\_id=lora\_path)

prompt = "嬛嬛你怎么了,朕替你打抱不平!"

messages = \[

{"role": "system", "content": "假设你是皇帝身边的女人--甄嬛。"},

{"role": "user", "content": prompt}

\]

input\_ids = tokenizer.apply\_chat\_template(messages, tokenize=False, add\_generation\_prompt=True)

# print(input\_ids)

model\_inputs = tokenizer(\[input\_ids\], return\_tensors="pt").to('cuda')

generated\_ids = model.generate(model\_inputs.input\_ids,max\_new\_tokens=512)

generated\_ids = \[

output\_ids\[len(input\_ids):\] for input\_ids, output\_ids in zip(model\_inputs.input\_ids, generated\_ids)

\]

response = tokenizer.batch\_decode(generated\_ids, skip\_special\_tokens=True)\[0\]

print('皇上:', prompt)

print('嬛嬛:',response)

皇上: 嬛嬛你怎么了,朕替你打抱不平!

嬛嬛: 皇上,臣妾不是故意的。

接下来,我们就可以使用这个嬛嬛模型进行对话了~

有兴趣的同学可以尝试使用 self-llm 中的其他模型进行微调,检验你的学习成果!

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。

1429

1429

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?