注:部分笔记来自视频评论

1-4 自然语言处理基础–基础与应用

Basic Tasks of NLP

视频中介绍

- Part Of Speech (POS) Tagging(词性标注,前处理相关),将输入的文本句子中的每个词语都标注上词性(动词/形容词/名词)。

- Named Entity Recognition, NER (实体识别),句法语义分析:对于给定的句子,进行分词、词性标记、命名实体识别和链接、句法分析、语义角色识别和多义词消歧

- Coreference Resolution 指代消解,是要找出文本中的哪些词汇指的是同一件东西,尤其是代词(如 he,she,it 等)所指代的实体。

- Basic dependencies 依存分析,句法分析(Parsing)有两种形式,分别是成分分析(constituency parsing)和依存分析(dependency parsing)。它们在输入输出形式是一致的,都是输入一个句子,输出一个树。

特意提到中文多一步,是中文分词,因为不像英文每个单词都有空格,工具是Jieba

应用案例

- QA,基于知识图谱挖掘的知识问答(词频分析等),需要Mechine Reading技术阅读文本,提取充实知识图谱

- 智能音响(助手),理解人说的话(指令),给予对应回复

- 机器翻译,经典任务

- Sentiment Analysis(SA) 情感分析,又称倾向性分析和Opinion Mining (意见挖掘),它是对带有情感色彩的主观性文本进行分析、处理、归纳和推理的过程

1-5 自然语言处理基础–词标识与语言模型

转换为机器能力的词

Compute word similarity

任意两个词的相关度计算(相似度),

Infer word relation

推断词关系,语义关系

Problems of synonym(近义词)/ Hypernym(上位词)

1.词语之间的较小差异无法区分(“proficient”, “good”)

2.词义会发生变化,出现新的词义(apple - 水果 - IT公司)

3.主观性的问题,受限于词典的标注

4.数据吸收

5.大量的人工去构建、维护词典

把每个词表示成独立的符号(在一个文档中,非常有效)

和词表一样长的向量去找一维跟这个词相对应,整个向量的维度跟词表的长度是相当的

用来表示文档时非常有效,能较好地完成两个文档之间的相似度计算

一个词的词义由他经常出现在的位置的上下文有密切的关系

任何一个词都可以用他出现的维度或者重要性去进行表示,可以得到关于每一个词的稠密向量,就可以在这个空间里面利用稠密向量来计算两个词之间的相似度

问题:

- 词表变大,存储需求也会变大

- 有些词出现频度特别少,上下文少,这种方法不好表示

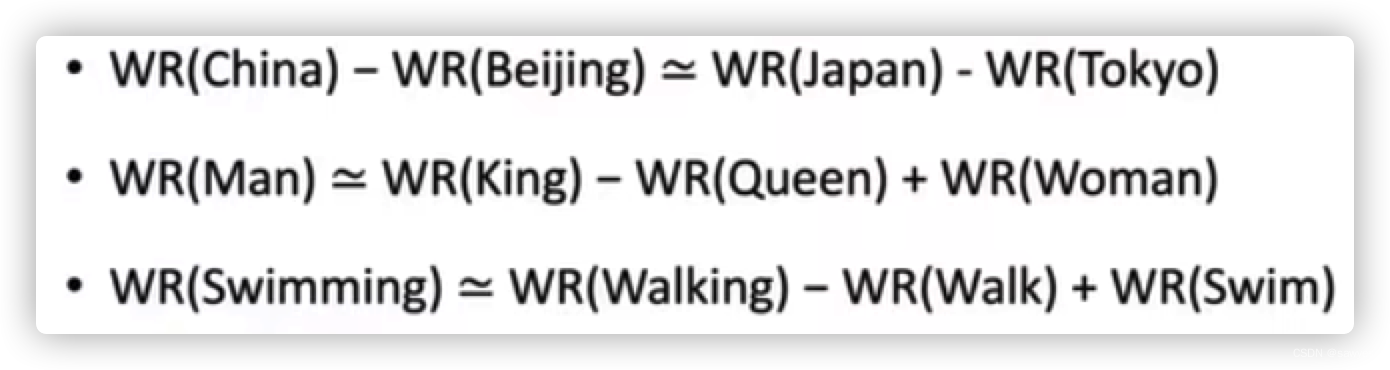

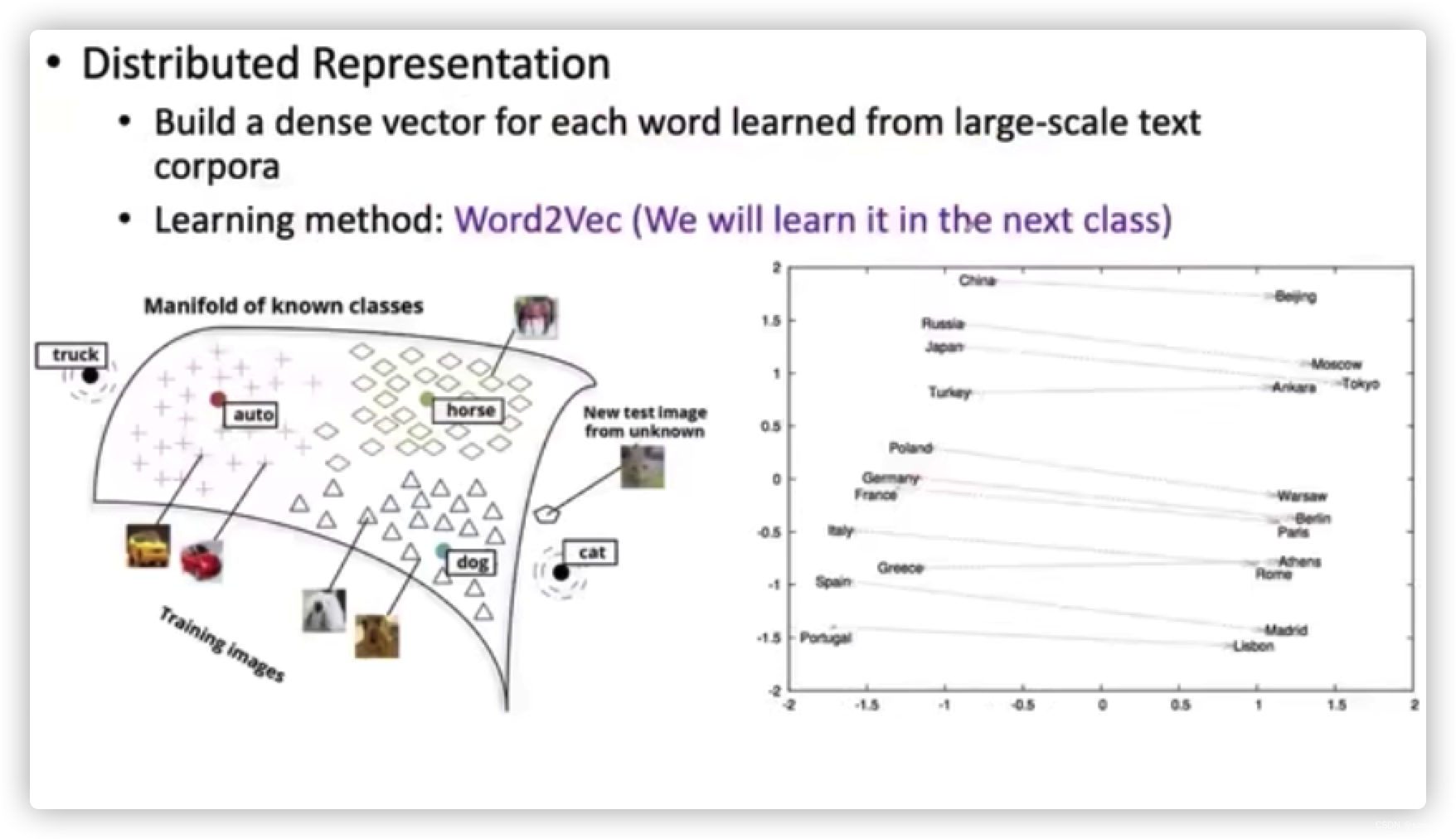

Word Embeding(文档嵌入)

分布式表示

Word2Vec 建立低维的稠密的向量空间,尝试把每一个词都学到这个空间里,用这个空间里的某一个位置所对应的向量来表示这个词,

在这个空间里我们可以自动的学习出来词与词之间可能存在的相对比较稳定的一些关系

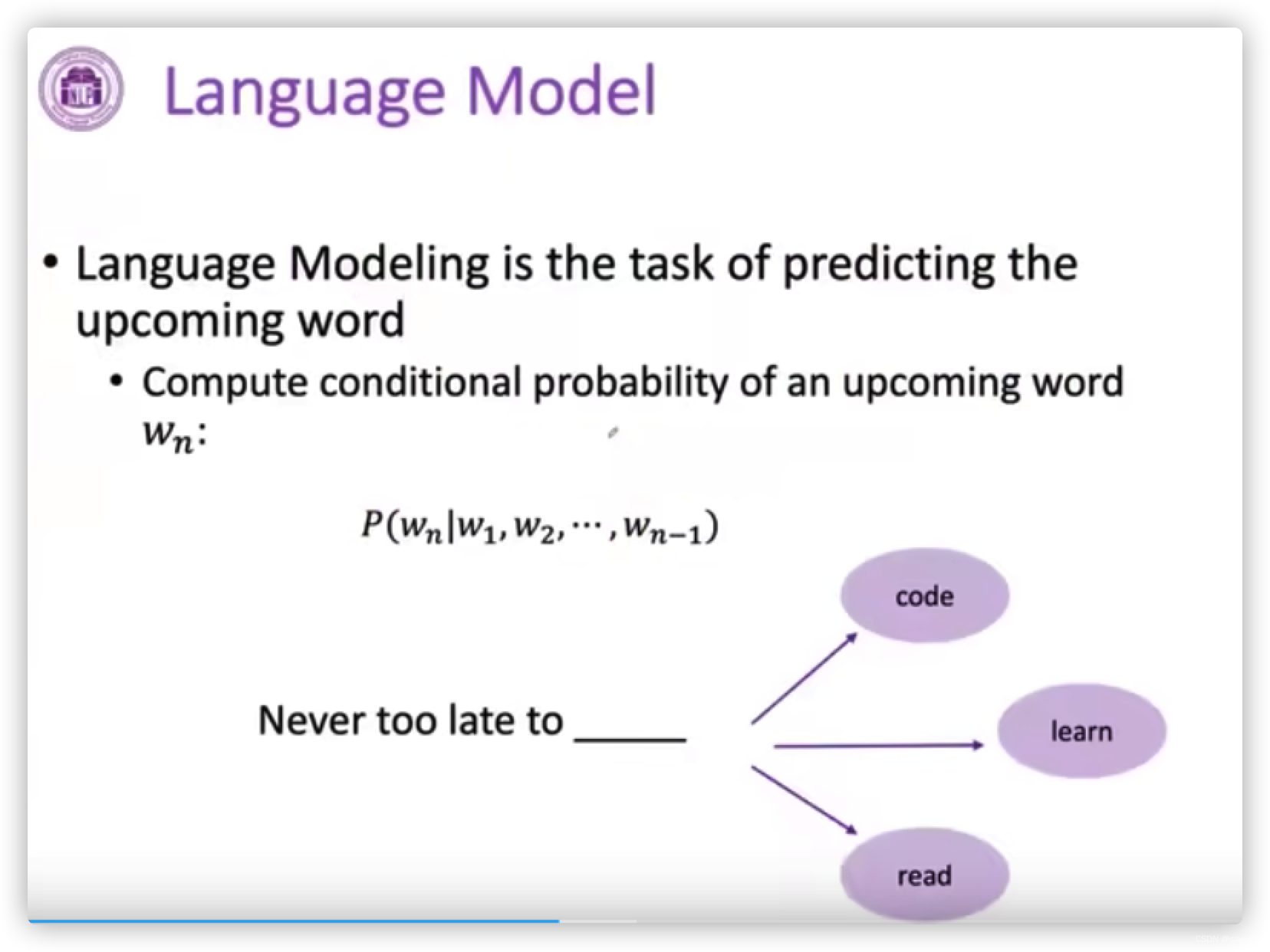

Language Model

语言模型最重要能力,掌握这个能力可以更好理解一句话,根据这句话完成如何回复

- 计算一个词的序列成为一句合法的话的概率,联合概率

- 根据前面说过的话,预测下一个词是什么

901

901

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?