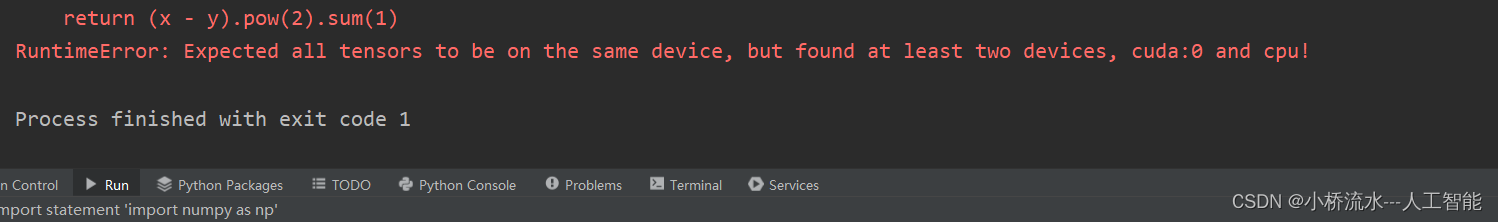

这个错误表示存在跨设备的张量操作,也就是说有些张量在 GPU 上,而有些张量则在 CPU

上。我们需要确保所有相关的张量都放在同一个设备(GPU 或 CPU)上以避免这个错误。

解决方案:

-

将所有张量移动到GPU:

如果你有一个或多个张量在CPU上,而你想在GPU上执行计算,你可以使用.to(device)方法将这些张量移动到GPU。其中device是一个PyTorch设备对象,你可以使用torch.device("cuda:0")来指定GPU设备。device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu") tensor_on_cpu = tensor_on_cpu.to(device)注意:你需要对每一个在CPU上的张量都执行上述操作。

-

确保模型和数据都在同一个设备上:

如果你的模型(即网络的权重和偏置)在GPU上,但你的输入数据在CPU上,你需要将输入数据也移动到GPU上。这通常在将数据送入模型之前进行。inputs, targets = inputs.to(device), targets.to(device) outputs = model(inputs) # 假设model已经在GPU上 -

检查所有相关的张量:

确保你的代码中所有参与计算的张量都位于同一设备上。这包括模型参数、输入数据、中间结果以及任何你可能在计算过程中创建的张量。 -

使用

.to()或.cuda()和.cpu()方法时要小心:

当你使用.to(device)、.cuda()或.cpu()方法时,这些操作会返回新的张量,而不是在原地修改原张量。因此,你需要确保将新返回的张量赋值给变量,并在后续的计算中使用这个新变量。 -

使用

.to()时考虑数据类型:

如果你的张量包含半精度浮点数(torch.half)或其他非默认数据类型,并且你的GPU支持这些数据类型,确保在调用.to(device)时也指定了数据类型。 -

检查是否有库或函数在后台自动改变设备:

有时,某些库或函数可能会在你的不知情下改变张量的设备。确保你了解你正在使用的所有库和函数,并检查它们的文档以了解它们是否可能影响张量的设备。 -

使用

torch.nn.DataParallel或torch.distributed进行多GPU训练:

如果你正在使用多个GPU进行训练,并且希望自动处理跨设备的数据传输,你可以考虑使用torch.nn.DataParallel或PyTorch的分布式模块。但是,这些工具通常用于高级用例,并且在大多数情况下,简单地确保所有张量都在同一个设备上更为简单和直接。

总结

这个错误表明你的PyTorch代码试图在CPU和GPU(在这个例子中是CUDA设备cuda:0)之间对张量(tensors)进行操作,但是PyTorch不允许这样的跨设备操作。要解决这个问题,你需要确保所有参与计算的张量都在同一个设备上。

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?