引言

近年来,Transformer模型在神经网络领域中引起了广泛关注,尤其在自然语言处理(NLP)领域表现出色。本文将详细介绍Transformer在神经网络中的位置、其工作原理、优势以及在不同领域的应用。

Transformer概述

Transformer是一种基于注意力机制的深度学习模型,于2017年由Vaswani等人在论文《Attention is All You Need》中首次提出。不同于传统的循环神经网络(RNN)和卷积神经网络(CNN),Transformer完全依赖于注意力机制来捕捉输入序列中的全局依赖关系。

Transformer在神经网络中的位置

Transformer模型在神经网络的发展中具有里程碑意义,其结构和机制使其在许多任务中优于传统的RNN和CNN。以下是Transformer在神经网络中的关键位置:

1. 自然语言处理(NLP)

Transformer在NLP中具有革命性影响,特别是在以下任务中表现突出:

- 机器翻译:Transformer的多头注意力机制使其能够更好地捕捉句子中词与词之间的关系,从而提高翻译质量。

- 文本生成:如GPT(Generative Pre-trained Transformer)和BERT(Bidirectional Encoder Representations from Transformers)等模型在文本生成和理解任务中表现出色。

- 问答系统:Transformer模型在阅读理解和问答任务中展现了强大的能力,能够准确地从文本中提取答案。

2. 图像处理

虽然Transformer最初设计用于处理序列数据,但其自注意力机制在图像处理任务中也表现出了巨大的潜力。例如,Vision Transformer(ViT)通过将图像分割成一系列的块(patch)并应用Transformer结构来处理图像分类任务。

3. 语音处理

Transformer在语音识别和生成任务中也有应用,如语音到文本转换(ASR)和语音合成(TTS)。Transformer的并行处理能力和全局注意力机制使其在处理长时间序列数据时表现优异。

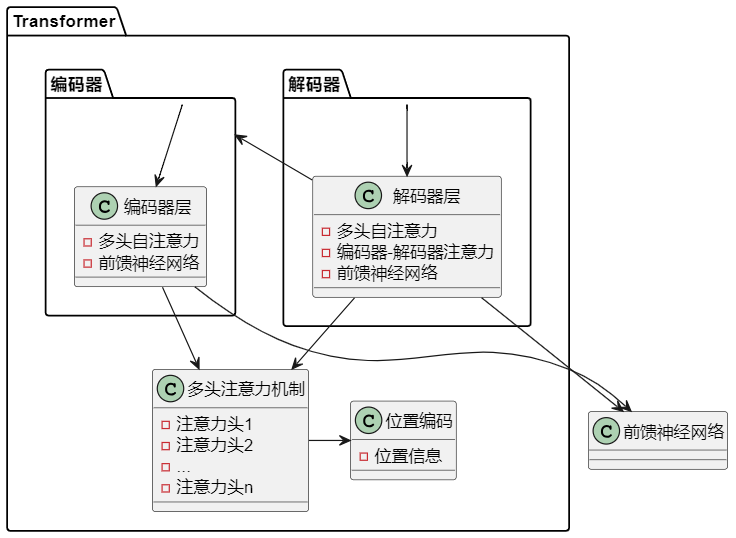

Transformer的工作原理

Transformer模型的核心是自注意力机制和多头注意力机制,其主要组件包括:

- 编码器(Encoder):由多个相同的层堆叠而成,每层包含一个多头自注意力机制和一个前馈神经网络。

- 解码器(Decoder):结构与编码器类似,但每层还包括一个编码器-解码器注意力机制,用于将编码器的输出与解码器的输入结合。

- 多头注意力机制(Multi-Head Attention):通过并行计算多个注意力头,使模型能够关注输入序列的不同部分,从而捕捉更丰富的信息。

- 位置编码(Positional Encoding):由于Transformer不包含循环或卷积操作,因此通过位置编码来提供序列中位置信息。

Transformer的优势

- 并行处理:Transformer能够并行处理整个输入序列,显著提高了训练速度和效率。

- 长程依赖:自注意力机制使Transformer能够捕捉输入序列中的长程依赖关系,而不依赖于序列的顺序。

- 灵活性:Transformer适用于各种序列到序列的任务,包括文本、图像和语音处理。

应用领域

- 机器翻译:如Google Translate和DeepL等翻译系统广泛使用Transformer模型。

- 文本生成:如OpenAI的GPT系列模型在生成自然语言文本方面表现出色。

- 图像分类:Vision Transformer在多个图像分类基准测试中表现出色。

- 语音识别:Transformer在语音识别任务中表现优异,如Google的ASR系统。

结论

Transformer模型通过其独特的注意力机制和并行处理能力,在神经网络领域中占据了重要位置。其广泛的应用和优越的性能,使其成为现代深度学习中的关键模型。未来,随着技术的不断进步,Transformer及其变体将在更多领域中发挥更大的作用。

1601

1601

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?