### 使用CNN-LSTM-Attention模型进行锂电池SOC估计

#### 方法概述

为了实现锂电池SOC(State of Charge)的精确估计,可以采用一种融合卷积神经网络(CNN)、长短期记忆网络(LSTM)和注意力机制(Attention Mechanism)的混合深度学习架构。这种结构能够充分利用CNN的空间特征提取能力、LSTM的时间序列建模能力和注意力机制对重要特征的关注特性。

具体而言,在锂电池SOC估计中,CNN负责从原始传感器数据或实验测量数据中提取局部空间特征[^3];随后,LSTM接收由CNN提取的特征作为输入,并进一步分析其时间维度上的动态行为[^2];最后,引入注意力机制来增强模型对于关键时间节点上特征的学习能力[^5]。

以下是详细的实现方法:

---

#### 数据预处理

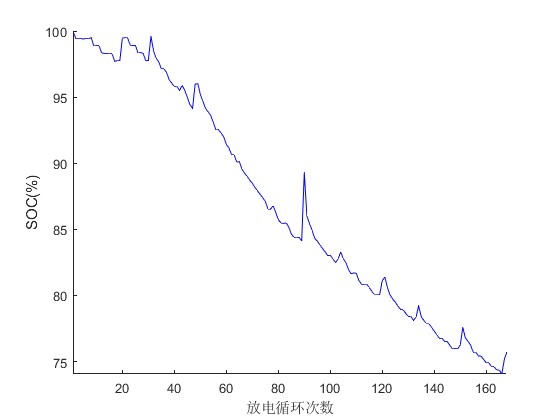

在构建模型之前,需准备高质量的历史数据集,通常包括电压、电流、温度以及其他可能影响SOC的因素。这些多维信号应被标准化至相同尺度范围以减少数值差异带来的干扰[^1]。此外还需划分训练样本与测试样本以便后续验证算法有效性。

```python

import numpy as np

from sklearn.preprocessing import MinMaxScaler

def preprocess_data(data, seq_length=100):

scaler = MinMaxScaler(feature_range=(0, 1))

scaled_data = scaler.fit_transform(data)

X, y = [], []

for i in range(seq_length, len(scaled_data)):

X.append(scaled_data[i-seq_length:i])

y.append(scaled_data[i, -1]) # Assuming SOC is the last column

return np.array(X), np.array(y)

```

上述代码片段展示了如何将原始数据转换成适合喂入深度学习框架的形式,其中`seq_length`定义了每条记录所含有的历史步数长度[^4]。

---

#### 构建CNN-LSTM-Attention模型

下面给出一个完整的Keras/TensorFlow实现方案,展示如何搭建这样一个复合型神经网络结构来进行SOC估算任务。

```python

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Conv1D, MaxPooling1D, LSTM, Dense, Bidirectional, Attention, Concatenate

# 输入层

input_layer = Input(shape=(None, data_dim))

# 卷积部分

conv1d_1 = Conv1D(filters=64, kernel_size=3, activation='relu')(input_layer)

max_pooling_1 = MaxPooling1D(pool_size=2)(conv1d_1)

# 双向LSTM部分

bi_lstm_1 = Bidirectional(LSTM(64, return_sequences=True))(max_pooling_1)

# 注意力机制应用

attention_output = Attention()([bi_lstm_1, bi_lstm_1])

# 合并所有输出

concatenated = Concatenate()([bi_lstm_1, attention_output])

output_layer = Dense(1)(concatenated)

model = Model(inputs=input_layer, outputs=output_layer)

model.compile(optimizer='adam', loss='mse')

```

此段脚本首先创建了一个具有多个子模块的整体架构图景——先经由一维卷积操作捕获短程内的相互作用模式,再借助双向循环单元追踪长时间跨度下的演变轨迹,最终通过注意力建构突出显示那些最能反映当前荷电状态的关键时刻点的信息权重分布情况。

---

#### 训练过程

完成以上准备工作之后就可以启动实际训练流程啦!

```python

history = model.fit(

train_X,

train_y,

epochs=50,

batch_size=32,

validation_split=0.2

)

```

这里设置了总共执行五十轮迭代更新操作(`epochs`)以及每次批量加载三十二组样本来参与计算(`batch_size`)的同时保留百分之二十比例的数据专门用来评估泛化表现的好坏程度。

---

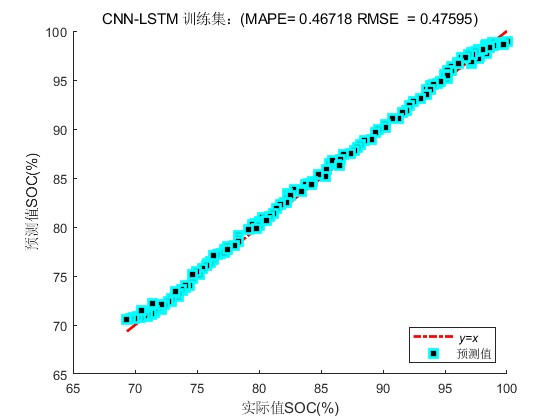

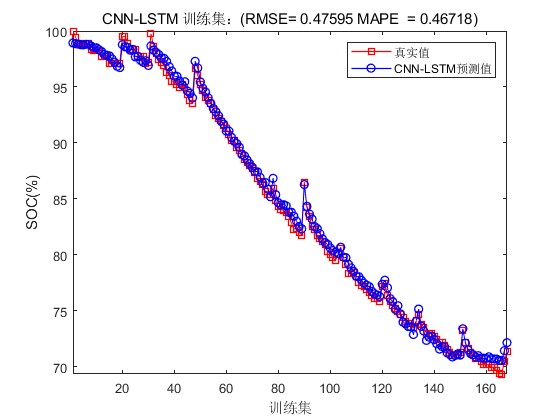

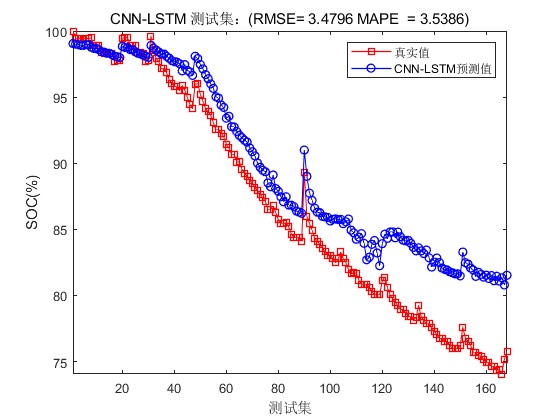

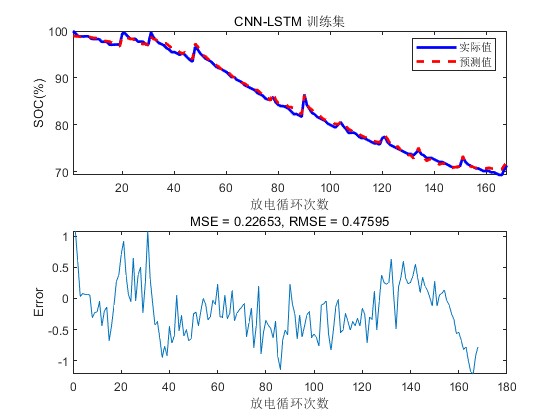

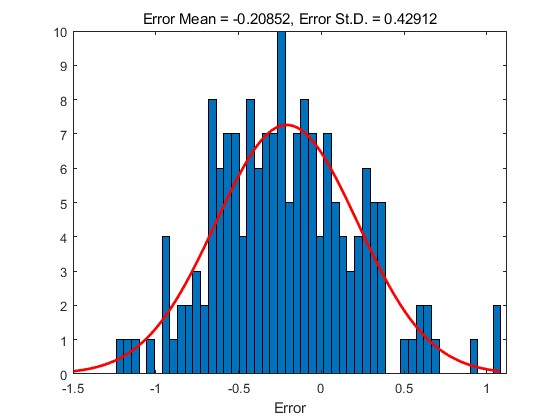

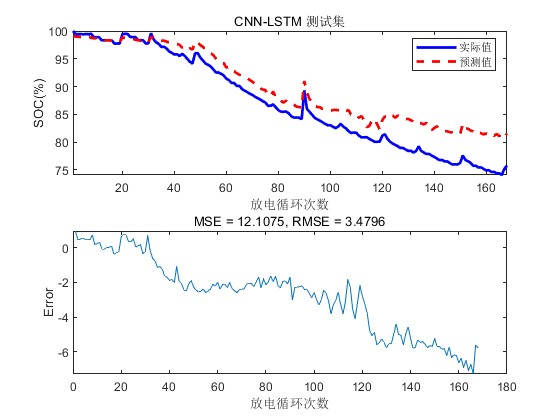

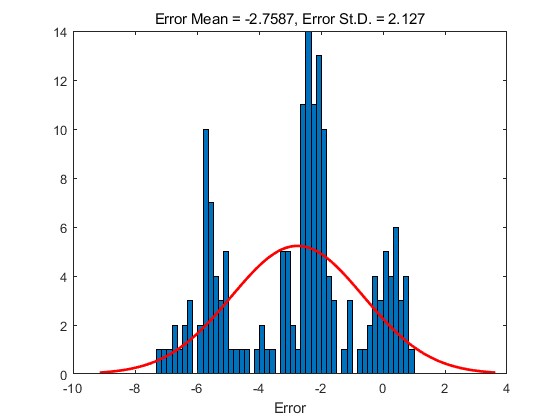

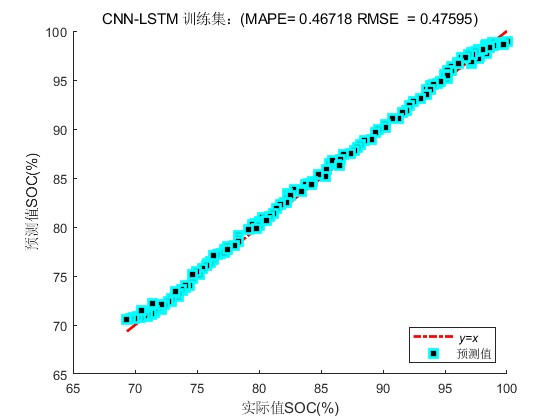

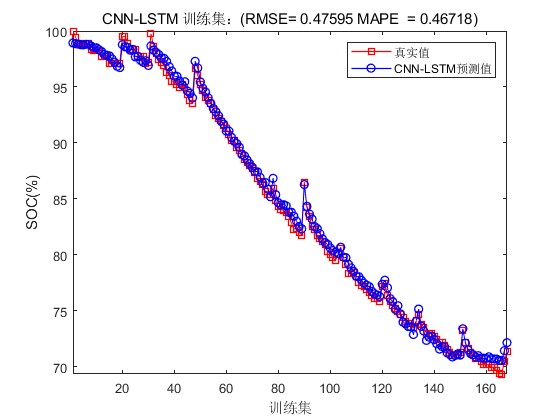

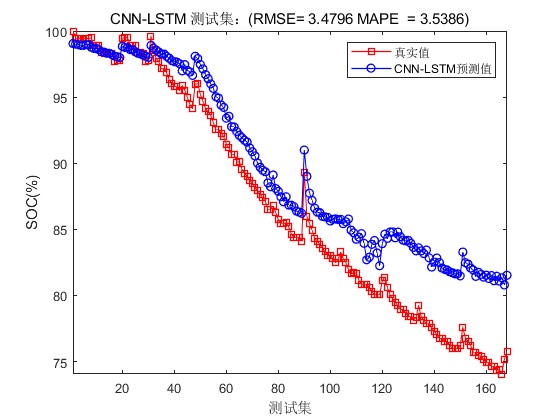

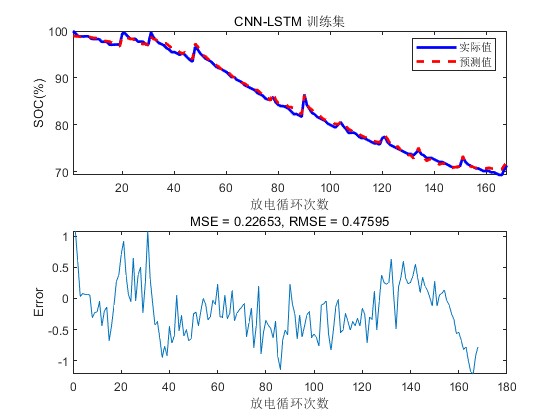

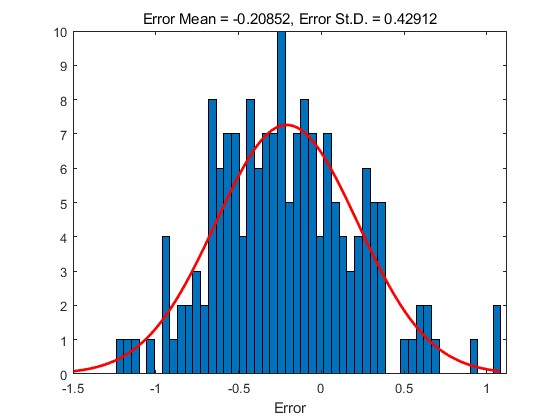

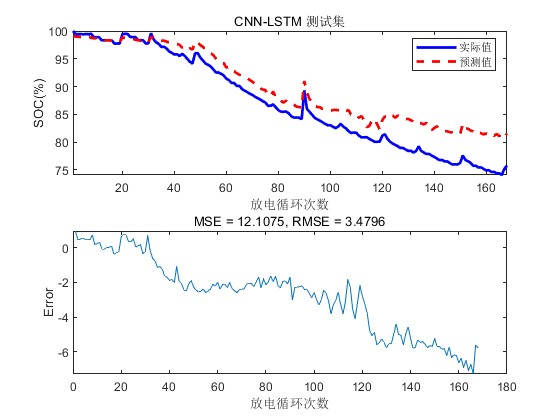

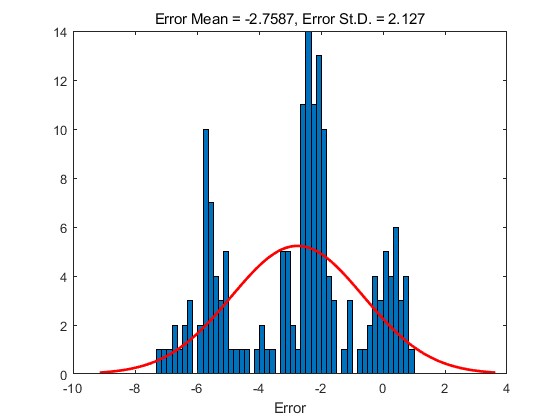

#### 性能评价

当整个学习周期结束以后我们还需要仔细考察所得结果的质量水平到底怎样呢?可以通过绘制损失函数曲线或者对比真实值同预测值得方式直观感受一下哦~

```python

import matplotlib.pyplot as plt

plt.plot(history.history['loss'], label='Training Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.legend()

plt.show()

predictions = model.predict(test_X)

plt.figure(figsize=(8, 6))

plt.plot(test_y[:100], color="blue", linewidth=2.0, linestyle="-", label="True Values")

plt.plot(predictions[:100].flatten(), color="red", linewidth=2.0, linestyle="--", label="Predicted Values")

plt.title('Comparison Between True and Predicted SOC')

plt.xlabel('Time Steps')

plt.ylabel('SOC Value')

plt.legend()

plt.grid(True)

plt.show()

```

---

### 结论

综上所述,运用CNN-LSTM-Attention相结合的技术手段确实能够在一定程度上提升针对复杂非线性系统的建模精度,特别是像电动汽车领域内至关重要的电池管理系统组成部分之一即电量监测功能方面更是如此.

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?