数据挖掘-超参数优化简介

超参数调优方法简介

本文对机器学习中的常用的超参数方法进行介绍,希望初学者在机器学习的过程中能够认识到超参数的调优是非常重要的一个步骤。

首先我们明确,什么是超参数。超参数其实就是不属于模型本身的一种参数,这种参数不受模型本身所控制。比如在梯度下降法中使用的步长、训练过程中的迭代总次数。这些在一般情况下都是人为设置的,不受模型本身影响的。一般来说,常用的超参数调优方法有网格搜索、随机搜索、贝叶斯优化、启发式搜索等方法。本质上来说其实都是搜索,如果搜索的范围较大并且超参数的个数非常多,那么就会非常慢。如果超参数的数量较少,搜索范围也不大,那么其实使用网格搜索方法就可以了,因为网格搜索法是在规定的超参数范围之内,按照指定的步长进行搜索的,理论上是可以找到最优值的,但是速度较慢,因为其实是一种暴力的枚举方法。

而随机搜索、贝叶斯优化、启发式搜索其实都是为了减少计算量而产生的方法。比如有7个超参数,每个超参数取值范围都是0-100 ,如果规定搜索步长是10的话,那么就要搜索10101010101010次,即1000万次,即计算量是呈现幂次增长的趋势。所以为了更快的进行搜索,我们引出了随机搜索、贝叶斯优化、启发式搜索等。

随机搜索本质上和网格搜索差不多,其实是在指定的范围内进行随机搜索,即随机进行搜索,而不是按照指定的步长和顺序进行搜索。因为随机搜索的思想就是,只要我的搜索次数较多,是可以找到最优结果的。直观感受上随机搜索方法可能比网格搜索要快一些,但是其实也没有比网格搜索快很多,因为不同的问题超参数分布是不同的,所以找到全局最大值或最小值的速度是不确定的,即没有办法严格证明随机搜索的速度比网格搜索快很多。

贝叶斯优化的思路和网格搜索不同,之前的网格搜索和随机搜索其实都是独立的进行搜索遍历,没有将历史的搜索信息进行利用,而贝叶斯优化则对之前历史的信息加以利用。给定一个初始的搜索函数,通过增加新的搜索样本对这个函数的后验分布进行更新,反复重复上述步骤更新迭代到一定次数后,学习出一个比较好的搜索函数,那么新的样本点的选取就会更加合理。对比网格搜索来说,贝叶斯优化的搜索次数更少,并且对于一些非凸的分布也是较为有效的,但是贝叶斯优化受到初始化搜索函数的选择以及搜索范围和搜索步长的影响,可能会导致搜索效率下降。

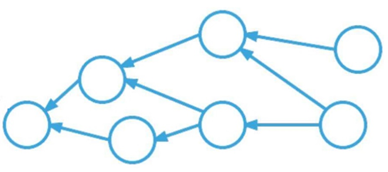

启发式搜索本质上是一种搜索策略而不是一种算法,通过对每一个搜索的样本进行评估,在当前样本的基础上选择下一个搜索的目标,直到达到最终的最优结果。其实启发式搜索本质上是一种跳动路径的思路,即不是像网格搜索按部就班的一步步搜索,启发式每次搜索都是基于上一次样本的评估值的基础上进行搜索,所以它的搜索速度比网格搜索要快很多。但是该策略受到评估函数的确定的影响,如果评估函数选择错误,那么会导致无法找到最终的最优化参数。常见的启发式搜索方法比如遗传算法、蚁群算法、元胞自动机、模拟退火算法等。初学者可以对这些方法进行了解,在比赛或者实际项目会用到一些。

总的来说,没有特别好的超参数优化方法,大多数问题会通过网格搜索来进行参数寻找,而受到计算资源的限制后会使用如蚁群算法、遗传算法等方法进行智能化搜索,加快搜索速度。

3054

3054

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?