概述

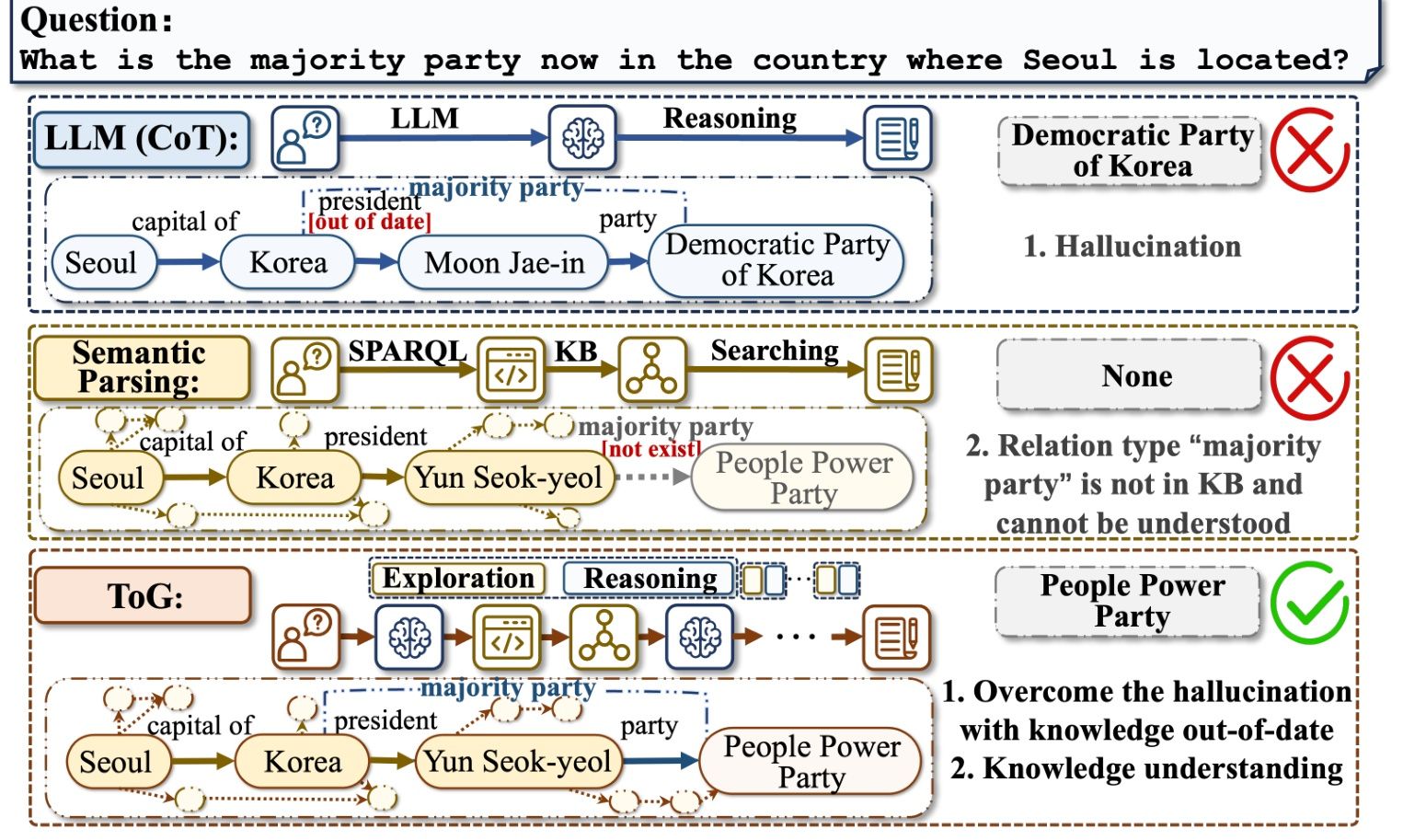

本文的研究背景是大规模语言模型在复杂推理任务中存在困难并展示了较低的性能,特别是在需要知识的追溯能力、及时性和准确性的场景中。

过去的方法主要面临两个问题:推理不负责任容易生成虚构或带有有害文本,以及模型在预训练阶段无法提供超出所学知识范围的专业知识。本文的方法通过整合外部知识库,特别是知识图谱,来解决这些问题。

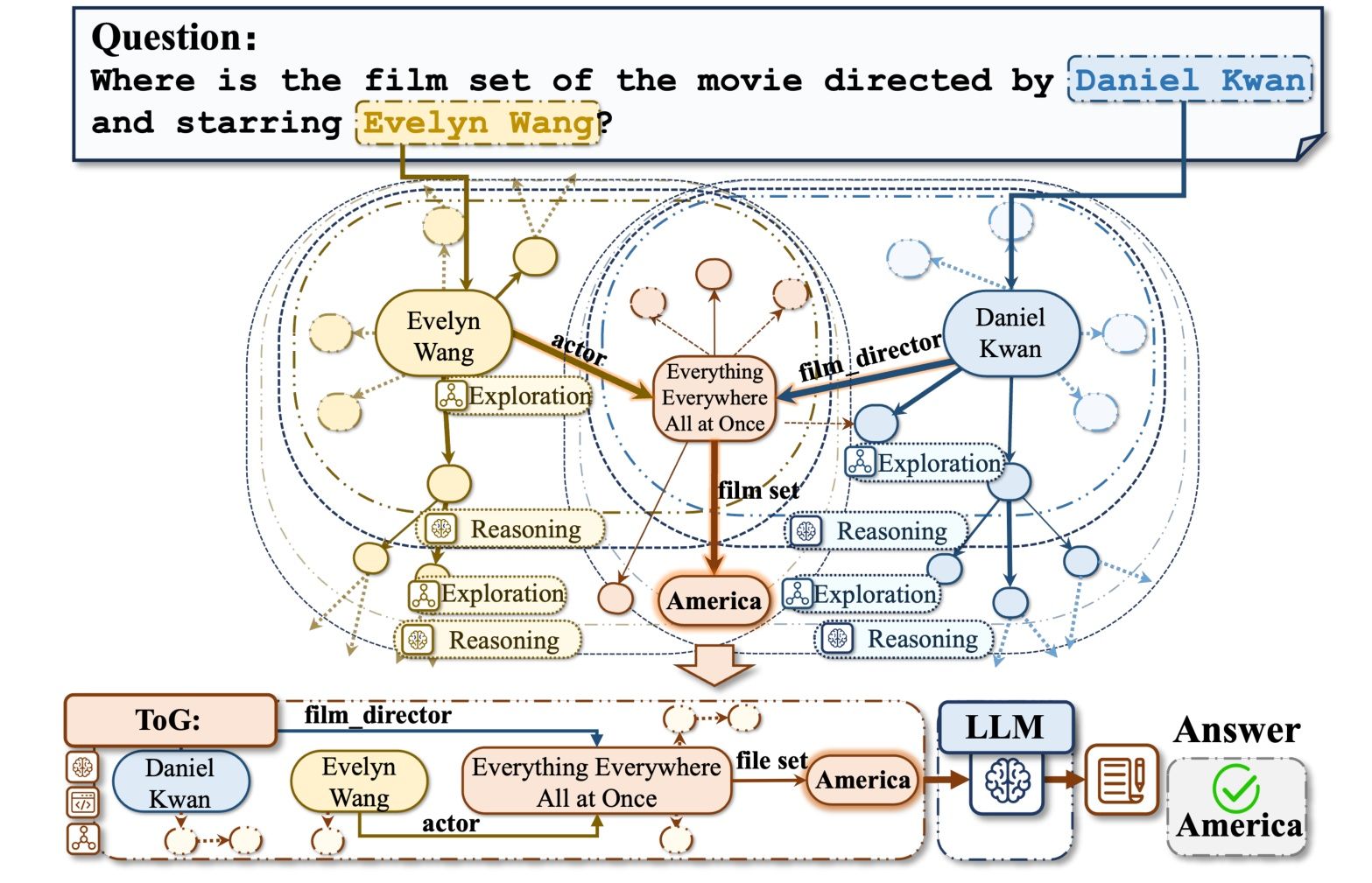

本文提出了Think-on-Graph(ToG)框架,利用知识图谱增强大规模语言模型进行深入和负责任的推理。该框架通过识别与给定问题相关的实体,并从外部知识数据库中检索相关三元组,进行探索和推理。这个迭代的过程生成多个推理路径,直到收集到足够的信息回答问题或达到最大深度。

本文在复杂的多跳推理问答任务中进行了实验,证明了ToG方法优于现有方法,有效地解决了大规模语言模型的限制,而不需要额外的训练成本。所达到的性能支持了他们的目标。

重要问题探讨

1. 在实验结果中,ToG方法在复杂Web问题数据集上相对于其他基线方法表现出优势。你认为这是因为什么原因导致的?请详细解释。

答:ToG方法相对于其他基线方法在复杂Web问题数据集上表现出优势,可能有以下几个原因。首先,ToG采用了探索和推理的过程&

文章提出Think-on-Graph(ToG)框架,通过整合知识图谱来提升大规模语言模型在复杂推理任务中的性能,尤其在需要追溯知识和准确性时。ToG通过识别问题中的实体和检索相关三元组进行推理,解决了模型的不负责任推理和知识局限性问题。实验显示,ToG在复杂Web问题数据集上优于现有方法,无需额外训练成本。

文章提出Think-on-Graph(ToG)框架,通过整合知识图谱来提升大规模语言模型在复杂推理任务中的性能,尤其在需要追溯知识和准确性时。ToG通过识别问题中的实体和检索相关三元组进行推理,解决了模型的不负责任推理和知识局限性问题。实验显示,ToG在复杂Web问题数据集上优于现有方法,无需额外训练成本。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

794

794

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?