Ollama Chatbox DeepSeek 本地部署

本地部署的好处

- 对于个人用户,模型本地部署的好处包括:

- 隐私保护:个人数据无需上传至云端,减少隐私泄露风险。

- 快速响应:模型在本地运行,响应速度更快,无需等待网络传输。

- 成本节约:无需支付云服务费用,长期来看可节省开支。

- 离线使用:即使在无网络环境下也能使用模型,提高灵活性。

- 定制化:用户可以根据自己的需求定制模型,满足个性化需求。

前提条件

在开始之前,请确保您的系统满足以下条件:

- 操作系统:[Windows, macOS, Linux]

- 硬件要求:[大于16GB 内存和一块支持 CUDA 的 NVIDIA GPU]

- 软件依赖:[Python 3.8 以上版本,有安装Docker或者conda经验的可忽略]

Ollama

- Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。

- 其主要特点和功能包括:简化部署、轻量级与可扩展、API支持、预构建模型库、模型导入与定制。

- Ollama的设计目标是简化在Docker容器中部署大型语言模型的过程,使得非专业用户也能方便地管理和运行这些复杂的模型。

- 作为一个轻量级框架,Ollama保持了较小的资源占用,同时具备良好的可扩展性,允许用户根据需要调整配置以适应不同规模的项目和硬件条件。

- Ollama提供了一个简洁的API,使得开发者能够轻松创建、运行和管理大型语言模型实例,降低了与模型交互的技术门槛。

步骤1:下载Ollama

步骤2:安装Ollama

- 软件默认安装在C盘 如果想安装其他路径 ,直接将C盘里面安装好的ollama 移到自定义的路径

windows + r 输入 sysdm.cpl打开环境变量设置 在系统设置里面进行如下配置:

新增4个 ollama 的变量 , 并在path里面添加ollama的最终安装路径 以便增加系统调用

| 变量 | 值 |

|---|---|

| OLLAMA_HOME | D:\work\LLM\app |

| OLLAMA_HOST | 0.0.0.0 |

| OLLAMA_MODELS | D:\work\LLM\models |

| OLLAMA_ORIGINS | * |

并在系统变量里面的path路径里面 将ollama的安装路径添加进去 如上图所示

步骤3:验证安装

完成后 在命令行里面输入 ollama -v 能查看到版本后 ,代表安装成功

Chatbox

- Chatbox 是一款跨平台的人工智能桌面客户端应用,它能够连接各种先进的语言模型,如 OpenAI 的 GPT-4、GPT-3.5 ,深度求索的DeepSeek R1 等等 ,让用户通过简洁直观的界面与这些强大的 AI 进行交互。

- 它支持 Windows、macOS 和 Linux 三大主流桌面操作系统,为不同系统偏好的用户提供了统一的使用体验。

- Chatbox 具备丰富多样的功能,在语言能力上,它支持多语言对话,无论是中文、英文、日文还是其他语言,Chatbox 都能理解并给出准确的回复,打破了语言的壁垒,让全球用户都能轻松使用。

- 在团队协作方面,它支持 OpenAI API 资源共享,团队成员可以方便地共享使用同一个 API 资源,共同与 Chatbox 进行交互,提高团队协作效率。

- 此外,Chatbox 作为一个开源的聊天框架或平台,旨在帮助开发者快速构建和集成聊天功能,支持即时消息、语音和视频通话、聊天机器人等,能够轻松集成到网站、移动应用和桌面应用中。

步骤1:下载Chatbox

步骤2:安装Chatbox

-

解压下载安装包并安装到自定义的路径

-

运行安装脚本或程序 ,下图即为chatbox 工作中的状态 。

Deepseek/安装模型

步骤1:选择模型

- 根据您的需求选择一个合适的模型。

- 访问模型的下载页面。

步骤2:下载模型

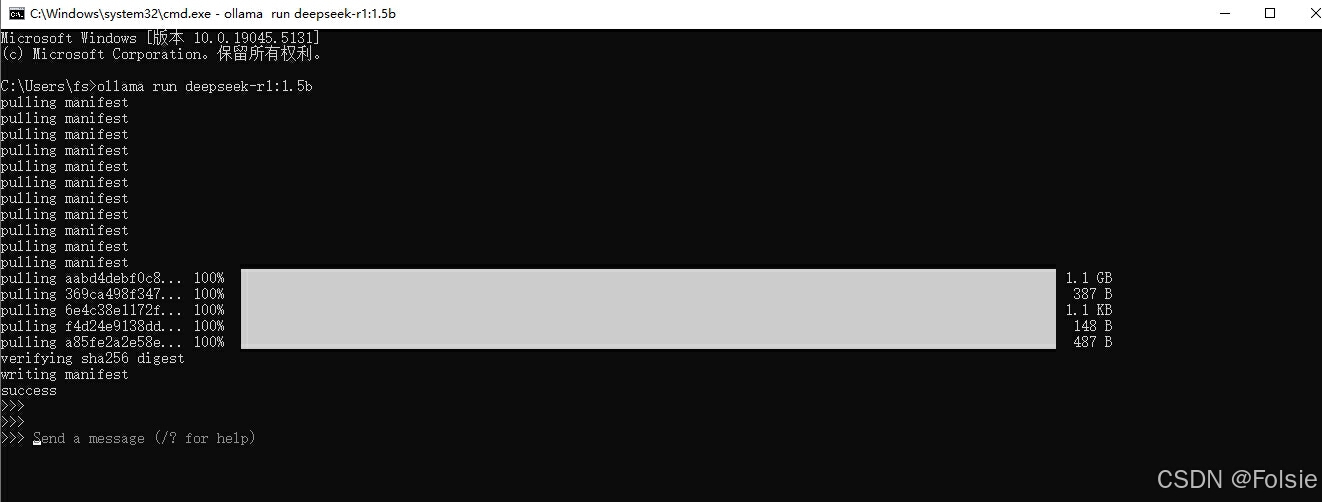

- 打开命令行或终端 。

- 蓝色按键copy 指令 ,直接输入

ollama run deepseek-r1:1.5b就可以开始下载对应的模型。

下载完毕后就可以在命令行中与模型进行对话

步骤3:启动模型

- 每次在新的命令行里面输入

ollama run deepseek-r1:1.5b命令 ,如果之前有下载过,就会打开对应的模型; - 如果没有下载过 ,就会下载新的模型。

- 命令行界面不直观的话 ,可以用下述chatbox–GUI界面进行交互。

使用Chatbox与模型交互

步骤1:启动Chatbox

- 运行Chatbox应用程序。

步骤2:连接到模型

-

在Chatbox中选择或输入模型名称 点击新对话 ,再点击设置按钮 ,在按键3处 选择 ollama api

-

在模型处 选择刚下载的大模型 保存后就可以进行对话了

步骤3:开始对话

-

在Chatbox界面中输入您的问题或指令。

-

观察模型的响应。

结论

通过这篇博客,我们了解了如何下载、安装Ollama和Chatbox,以及如何在本地部署和使用大型语言模型。希望这些步骤能帮助您顺利开始您的本地模型部署之旅。

2277

2277

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?