一、引言

SLAM(Simultaneous Localization and Mapping,即同时定位与建图)是机器人与计算机视觉领域的核心问题。传统 SLAM 系统依赖滤波器、优化方法和几何推理,但在动态环境、感知模糊、纹理缺失等场景中面临挑战。

近年来,人工智能(AI)技术——尤其是深度学习(Deep Learning),在特征提取、语义理解、位姿估计等方面展现出强大能力,为 SLAM 带来革命性变化。AI 与 SLAM 的融合已成为热点方向,催生出多个子领域,如学习型SLAM(Learning-based SLAM)、语义SLAM(Semantic SLAM)、端到端SLAM(End-to-End SLAM) 等。

二、AI 在 SLAM 中的关键应用方向

1. 特征提取与匹配

传统特征如 ORB、SIFT、SURF 对纹理变化敏感。AI 提供更稳健的替代方案:

- SuperPoint:用 CNN 学习局部关键点及描述子。

- LF-Net, R2D2:端到端训练鲁棒特征提取器。

- D2-Net, DISK:联合检测和描述,适用于高动态环境。

优势:更强的鲁棒性与区分性,适应极端光照、尺度变化。

2. 语义理解与地图增强

AI 模型可将视觉数据转换为语义信息,构建更高层次地图:

- 语义分割(Semantic Segmentation):如使用 DeepLab、Mask R-CNN 等模型将物体分类。

- 语义地图(Semantic Map):将场景中“椅子”、“墙”、“人”等物体标签融合进地图,提升定位与规划能力。

应用:

- 过滤动态目标(如行人)

- 构建可解释地图

- 支持任务规划

3. 深度估计与场景理解

- 单目深度估计:通过 CNN(如 Monodepth, DPT)从单张图像预测稠密深度。

- 学习立体匹配:如 PSMNet、RAFT-Stereo。

- 神经隐式表示(NeRF, Gaussian Splatting):基于神经场构建 3D 表达。

优势:

- 弥补稀疏激光或单目信息的不足

- 实现稠密重建

- 可集成于 VO/VIO 系统

4. 位姿估计与运动建模

- 视觉里程计替代(Learning-based VO/VIO):如 DeepVO, VINet 使用序列图像直接回归位姿。

- IMU 融合增强:AI 预测加速度漂移或动态补偿。

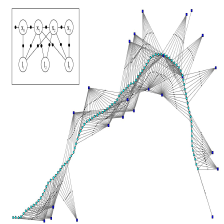

- 端到端 SLAM(如 DROID-SLAM):使用 Transformer/CNN/LSTM 模块实现直接回归或优化模块。

挑战:需要大量数据训练、泛化能力较弱。

5. 回环检测与重定位

- 基于图像检索的 AI 回环检测:

- NetVLAD、DELG:学习图像全局表示用于匹配。

- SuperGlue:图神经网络用于图像匹配。

- 鲁棒回环构造:适应不同视角与遮挡。

三、典型系统与代表工作

| 系统 | 说明 |

|---|---|

| ORB-SLAM3 + AI | 用 SuperPoint/NetVLAD 替换传统前端模块,提升鲁棒性 |

| DynaSLAM / Detect-SLAM | 利用语义分割剔除动态物体,改进建图稳定性 |

| DeepFactors / CodeSLAM | 使用学习型深度因子图建图 |

| DROID-SLAM (CVPR’2021) | 基于深度神经网络的端到端稠密 SLAM |

| GS-SLAM (2024) | 结合高效神经渲染(3D Gaussian Splatting)构建地图 |

四、AI + SLAM 的优势与挑战

优势

- 更强的鲁棒性与适应性

- 可融合高语义信息,实现高层次理解

- 支持弱监督、无监督训练,降低标注成本

- 推动传统系统向端到端迁移

挑战

- 泛化性差:训练数据和实际环境差异大

- 高计算成本,实时性难以保障

- 与传统几何约束整合仍在探索

- 可解释性与稳定性问题

五、未来发展趋势

- 几何 + AI 融合(Geo-AI Hybrid SLAM):结合可解释性与学习能力

- 轻量化模型部署(Tiny SLAM Networks):适应嵌入式设备

- 跨模态融合:视觉 + IMU + LiDAR + 语音等多源数据协同

- 图神经网络(GNN)在 SLAM 图优化中的应用

- Neural SLAM / Neural Map:用神经隐式表达替代传统地图结构

六、总结

AI 技术正深刻改变 SLAM 系统的架构与能力。从传统几何方法到学习驱动模型,AI 推动 SLAM 向更智能、鲁棒、语义化的方向发展。未来的 SLAM 系统将更多地融合 AI 与物理世界知识,走向真实世界中的可靠部署。

引用文献

-

D. DeTone, T. Malisiewicz, and A. Rabinovich, “SuperPoint: Self-Supervised Interest Point Detection and Description,” CVPR Workshops, 2018.

-

M. Dusmanu et al., “D2-Net: A Trainable CNN for Joint Detection and Description of Local Features,” in Proc. CVPR, 2019, pp. 8092–8101.

-

A. Kendall and R. Cipolla, “Geometric loss functions for camera pose regression with deep learning,” in Proc. CVPR, 2017, pp. 5974–5983.

-

K. Tateno, F. Tombari, I. Laina, and N. Navab, “CNN-SLAM: Real-time dense monocular SLAM with learned depth prediction,” in Proc. CVPR, 2017, pp. 6565–6574.

-

Z. Teed and J. Deng, “DROID-SLAM: Deep Visual SLAM for Monocular, Stereo, and RGB-D Cameras,” in Proc. CVPR, 2021, pp. 1201–1210.

-

Y. Tian, Z. Yang, Y. Xu, and S. Song, “GS-SLAM: Dense Visual SLAM with 3D Gaussian Splatting,” arXiv preprint arXiv:2312.11438, 2023.

-

B. Bescos, J. M. Fácil, J. Civera, and J. Neira, “DynaSLAM: Tracking, Mapping, and Inpainting in Dynamic Scenes,” IEEE Robotics and Automation Letters, vol. 3, no. 4, pp. 4076–4083, 2018.

-

R. Arandjelović, P. Gronat, A. Torii, T. Pajdla, and J. Sivic, “NetVLAD: CNN architecture for weakly supervised place recognition,” in Proc. CVPR, 2016, pp. 5297–5307.

-

M. Bloesch, J. Czarnowski, R. Clark, S. Leutenegger, and A. J. Davison, “CodeSLAM—Learning a compact, optimisable representation for dense visual SLAM,” in Proc. CVPR, 2018, pp. 2560–2568.

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?