深度学习中的注意力机制

一.注意机制可分为两种类型

根据它们所适用的范围:通道注(CA)和空间注意(SA)。CA和SA可以进一步分为三个过程:

1.squeeze:通过通道(CA)或空间区域(SA)从X中提取一个或多个统计量S的过程。统计量通过池化方法提取,SA可使用1X1的卷积。

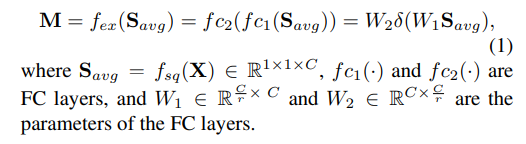

2.excitation:利用提取的统计数据,进行激励过程捕获通道(CA)或空间区域(SA)之间的相互关系,生成一个大小为1×1×C (CA)或H×W×1 (SA)。在所有的方法中,CA都使用两个全连接(FC)层,其瓶颈结构约简率为r。对于SA,使用一个或两个卷积。

3.scaling:为了重新校准输入的特征图,生成的注意力图通过一个范围为0到1的sigmoid函数进行归一化,然后用于与X进行通道或空间方向的乘法。对所有方法应用相同的缩放过程。

二.经典的注意力机制

1.RCAB

RCAB中使用的注意力机制用于分类和检测任务的挤压-激励(SE)块的注意力机制相同,该机制的目的是通过利用通道间的相关性来重新校准滤波器响应。在挤压过程中采用平均池化,激励过程如下:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2690

2690

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?