一 ,ollama的安装以及大模型下载

1.1

本文会分享如何部署本地大模型,使用到的工具有

- Ollama

本文主要分享

- 如何用Ollama在本地运行大模型

2.1 安装ollama

官方下载地址:ollama.com/download

当安ollama之后,我们可以通过访问如下链接来判断ollama是否安装成功

http://127.0.0.1:11434/

2.2 使用ollama运行本地大模型

当安装完成ollama之后,我们就可以在命令行中运行如下命令

ollama run 模型

其中模型就是你想运行的本地大模型的名称,可以通过model library进行查看。这里我们选择llama3大模型:llama3

考虑到机器的配置以及不同版本的内存要求,我这里选择默认参数的模型

当我们运行大模型的时候,ollama会自动帮我们下载大模型到我们本地。

下载完之后就可以在本地进行会话了

在终端中跟大模型进行交互的方法有点不太方便。可以使用Open WebUI大模型交互客户端进行部署

二、通过Open WebUI使用大模型

2.1 安装Open WebUI

Open WebUI是github上的一个开源项目,我们参考其官方文档使用Docker进行下载和安装。

- 在安装之前,我们需要先安装Docker:

-

Win或者Mac系统,参考文档:Docker Desktop release notes

- 官方文档中推荐了两种安装Open WebUI的方式:

- ollama和open webui一起安装

- 仅仅安装open webui

第一步中已经安装了ollama,所以就可以直接安装open webui了,命令:

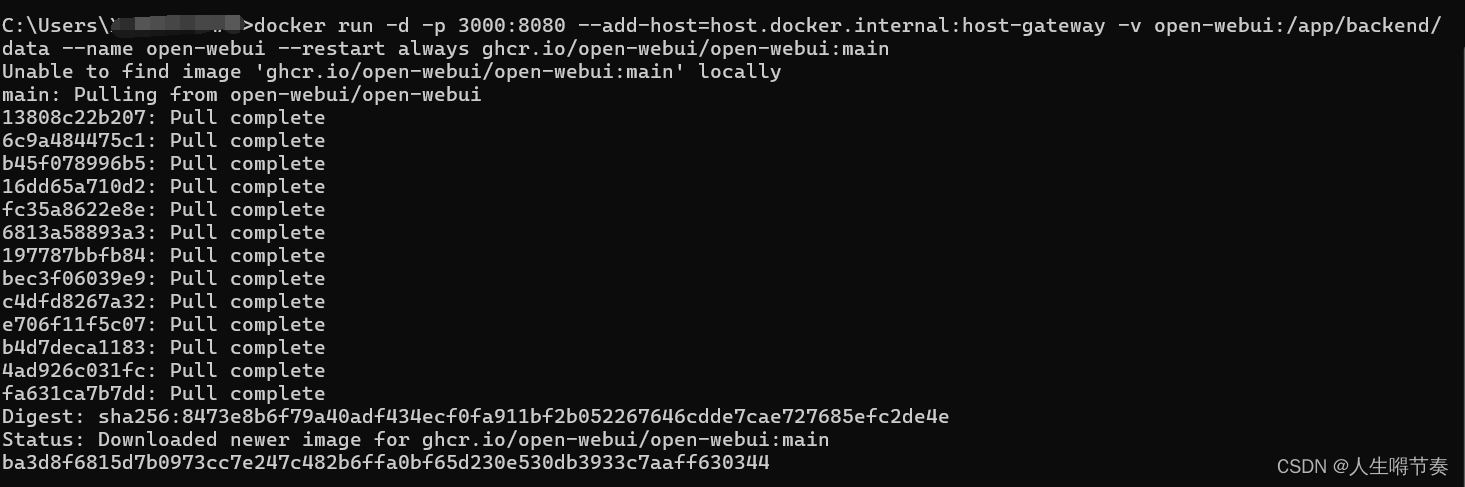

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

出现图中输出,说明Open WebUI安装下载完成

出现图中输出,说明Open WebUI安装下载完成

2.2 使用Open WebUI

- 首先访问如下网址

http://localhost:3000/auth/

打开页面会出现登陆界面,使用邮箱注册一个账号即可

和本地大模型进行对话

登陆成功之后,webui页面就出现了。

这就是使用Open WebUI进行聊天对话的方式了

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?