最近deepseek的战绩席卷全球,成为开源第一大模型。我正好有一台m4pro芯片的macbook pro,让我们看看如何在mbp上跑deepseek-r1,并测试一下速度。

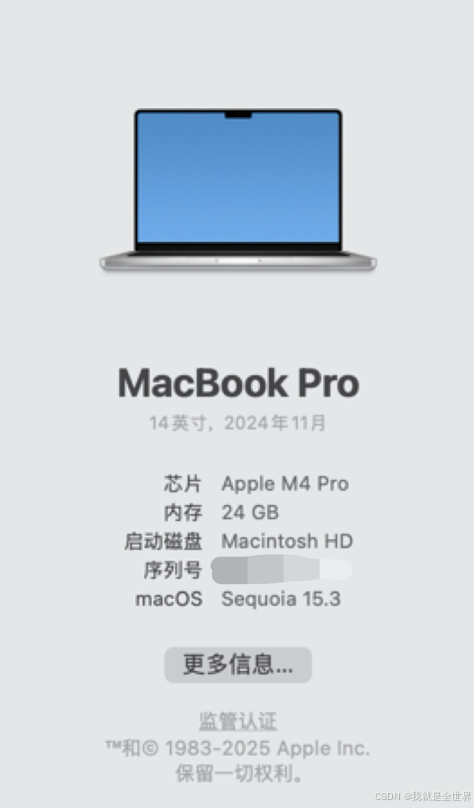

首先查看一下电脑配置,我的电脑是24G+512G的m4 pro芯片的macbook。

然后看一下deepseek-r1有哪些模型

因为内存只有24G,所以32B以上模型是跑不了的,我这次就测试蒸馏后的14B模型。

因为看模型报告对qwen2.5蒸馏后的模型性能比qwen2.5本身要好的多,所以也会加入qwen2.5的测试。还有gguf格式模型和苹果本身mlx引擎到底有什么不同。也会测试各模型的推理速度,让我们一起看看吧。

Qwen2.5-14B-Instruct-4bit

context length上下文长度:12K

mlx引擎推理效果:

生成速度平均:28 tokens/s,0.4s to first tok

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?