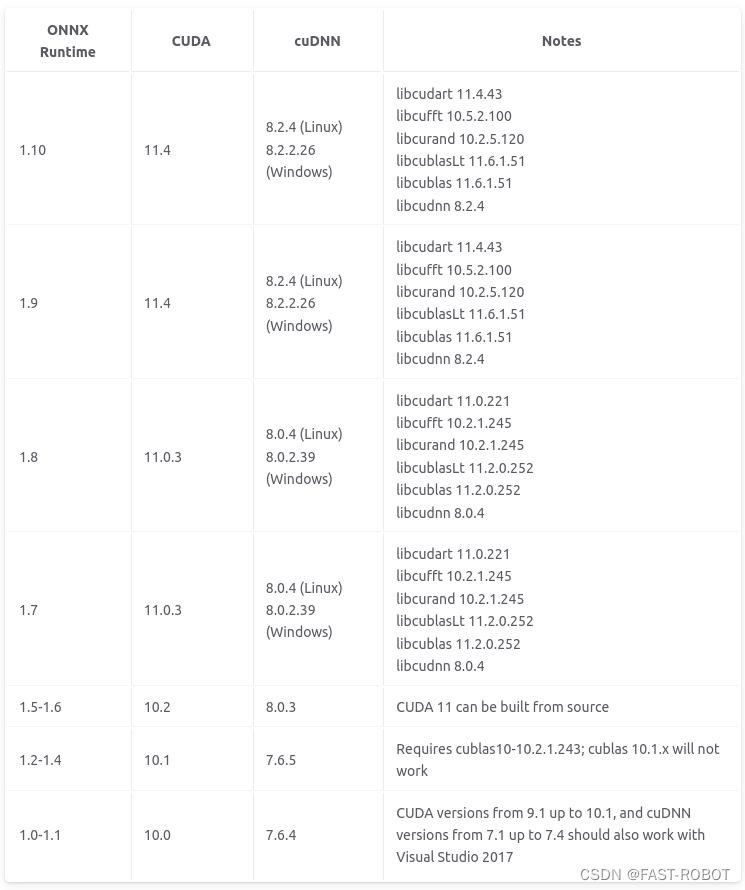

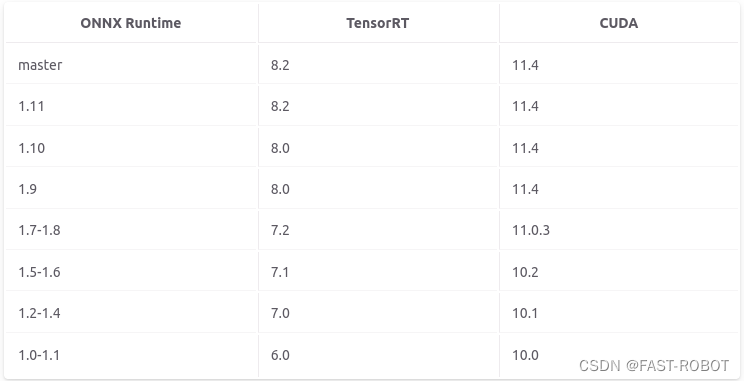

一、ONNXRuntime-gpu 和 TensorRT 的安装需要注意 cuda 和 cudnn 的版本 是否适配

1.安装 cuda 和 cudnn (具体查看这篇文章)

2.查看 版本是否适配具体详见 官网

3. 查看适配的TensorRT版本

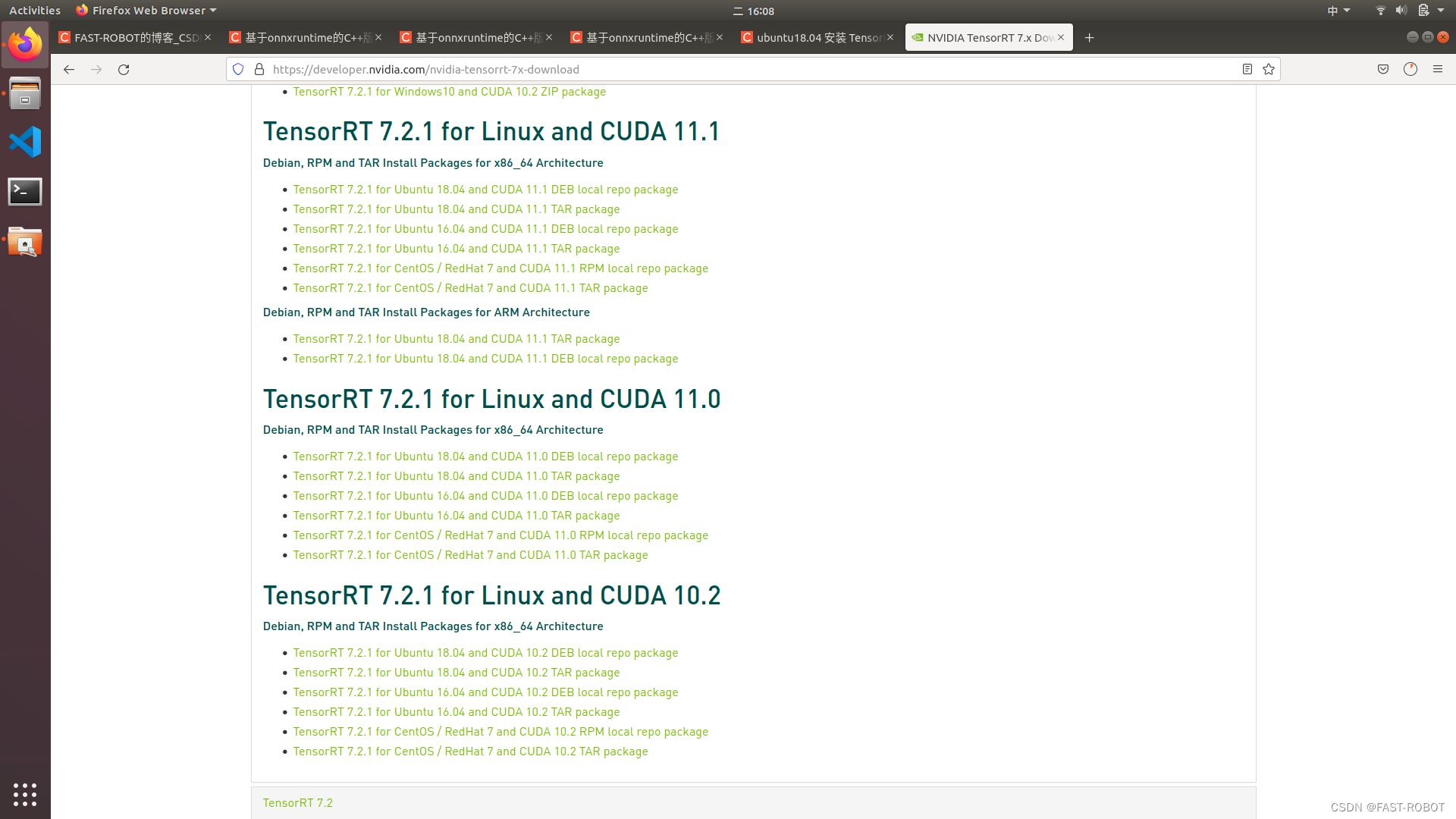

二、 安装 TensorRT 7.2.1

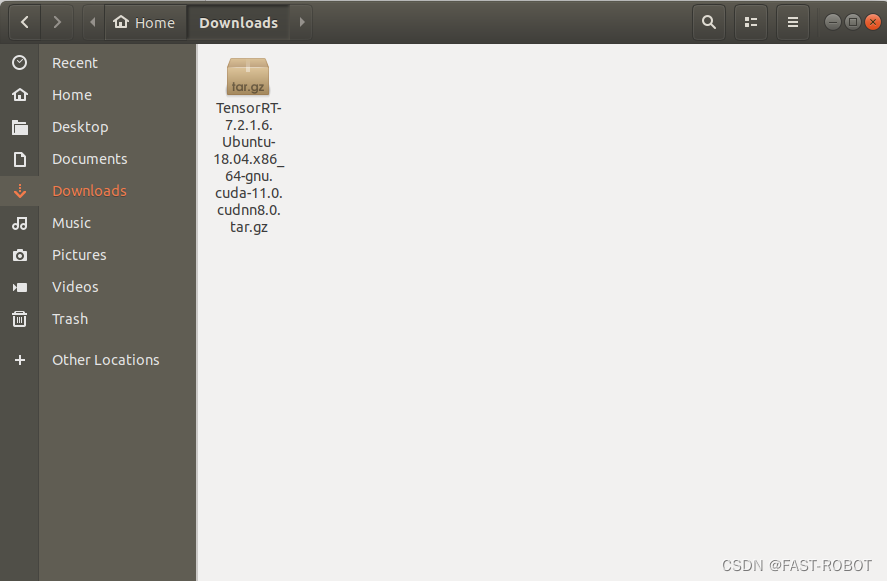

1. 下载合适的版本(官网)

(1)从这里下载18.04对应的tar包 (deb包要求cuda也是deb安装)

2. TensorRT 安装 (官网)

(1)打开配置文件gedit ~/.bashrc将tensorrt库添加到环境变量,另外将tensorrt的更目录加入环境变量,方便后面调试例程

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/home/dxy/TensorRT-7.2.1.6/lib

export PATH=$PATH:/home/dxy/TensorRT-7.2.1.6(2)保存并关闭文件,刷新环境变量

source ~/.bashrc

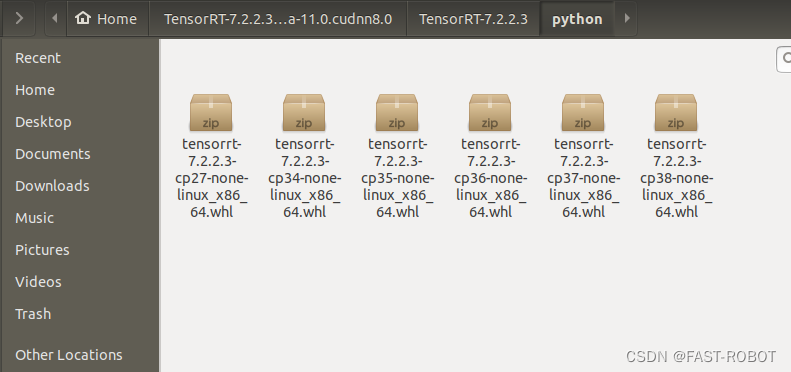

(3)安装python的TensorRT wheel文件

cd ~/TensorRT-7.2.1.6/python

(4)安装 python3.6 版本的 whl 文件

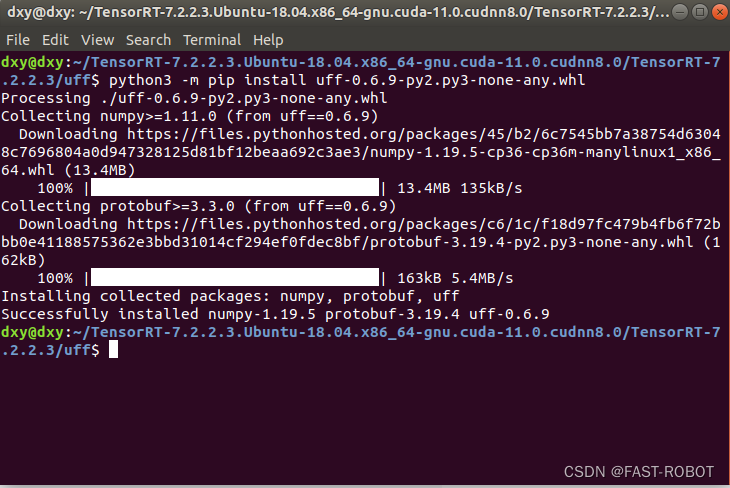

python3 -m pip install tensorrt-7.2.1.6-cp36-none-linux_x86_64.whl(5)安装python uff 的 wheel 文件,转到 uff 目录执行:

cd ~/TensorRT-7.2.1.6/uff

python3 -m pip install uff-0.6.9-py2.py3-none-any.whl

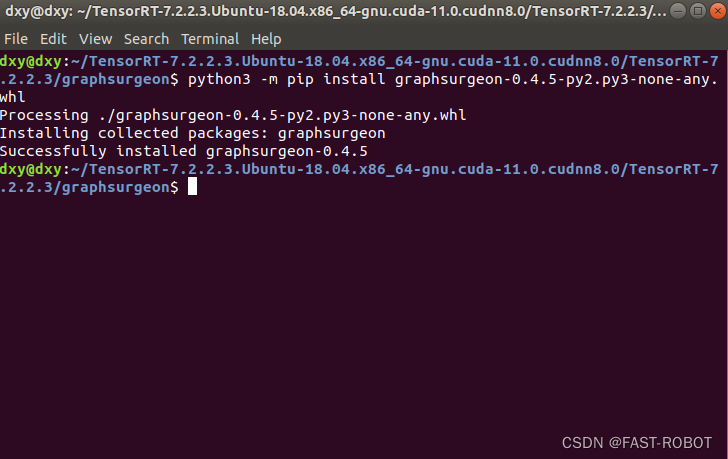

(6)安装python graphsurgeon 的wheel文件,转到graphsurgeon目录执行:

cd ~/TensorRT-7.2.1.6/graphsurgeon

python3 -m pip install graphsurgeon-0.4.5-py2.py3-none-any.whl

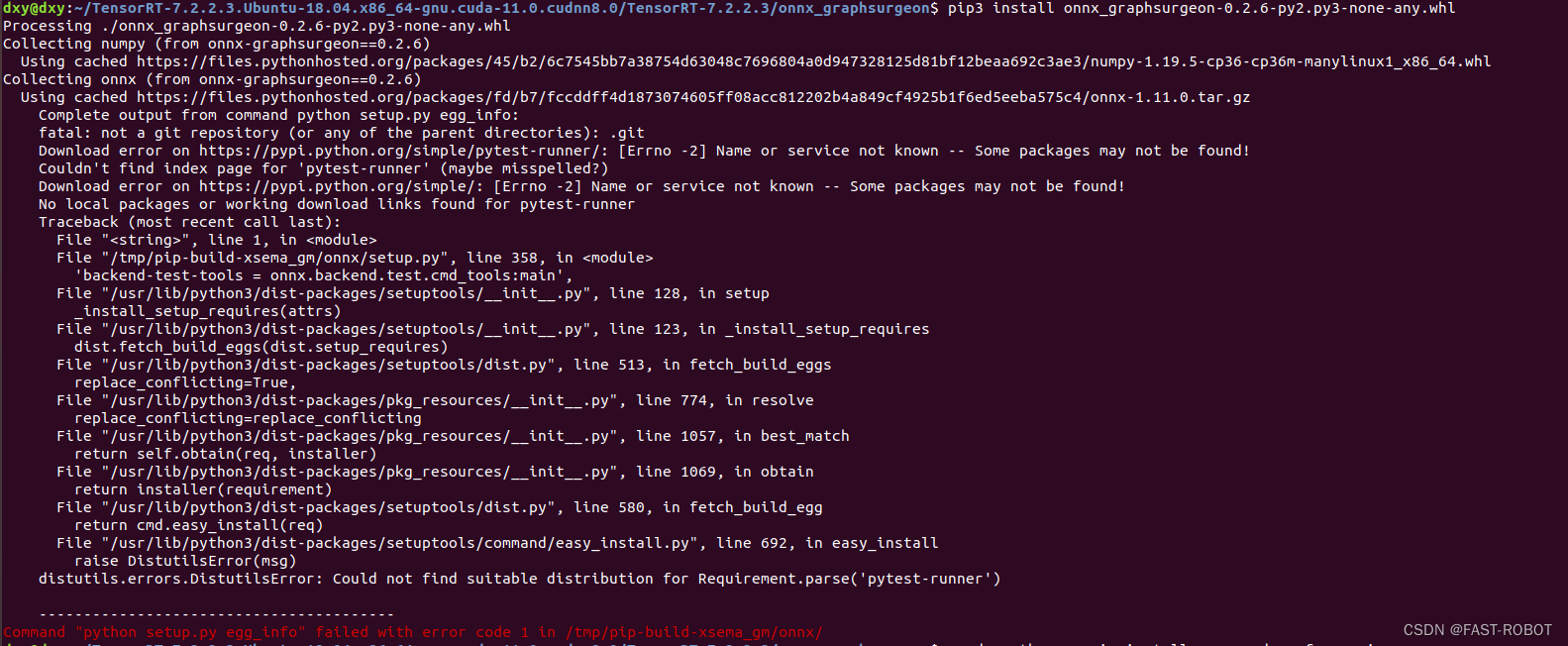

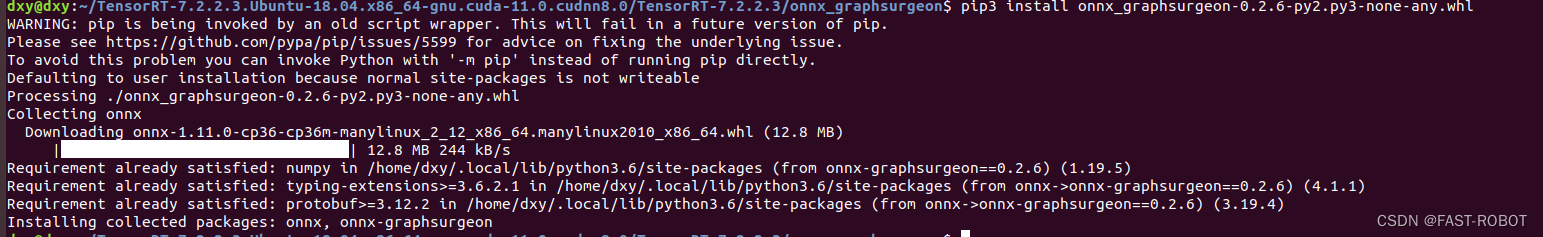

(7)安装python onnx-graphsurgeon的wheel文件,转到onnx-graphsurgeon目录执行:

cd ~/TensorRT-7.2.1.6/onnx_graphsurgeon

python3 -m pip install onnx_graphsurgeon-0.2.6-py2.py3-none-any.whl

注:这一步出现问题可参考以下方法

输入以下指令

sudo python -m pip install --upgrade --force pip

sudo pip install setuptools==33.1.1

成功安装

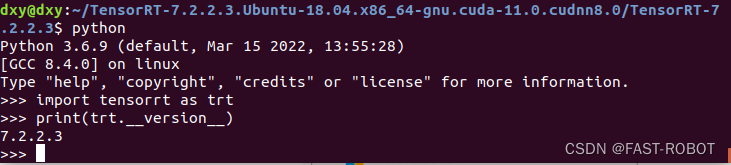

(8)验证是否安装成功

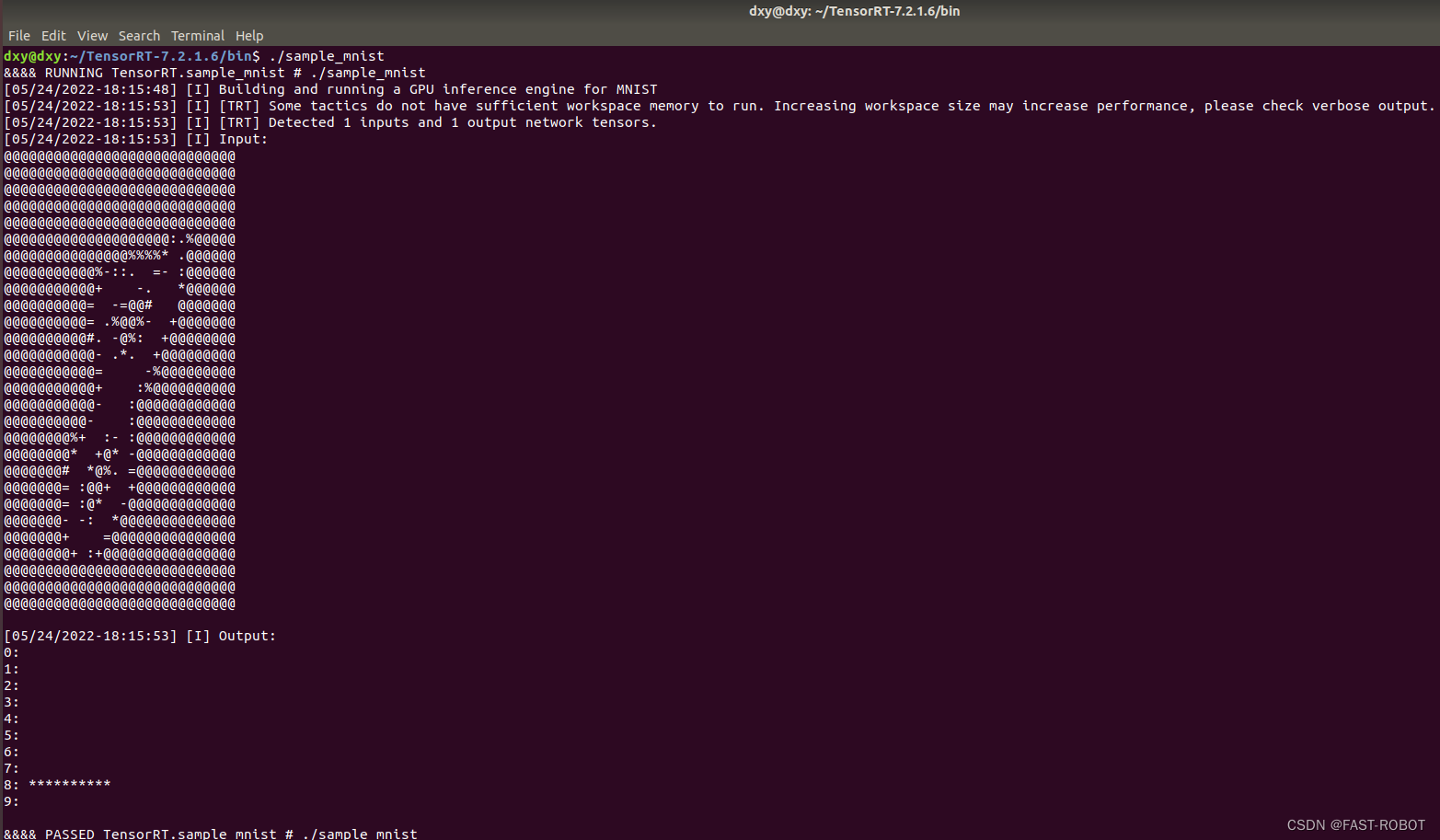

(9)例程测试

cd ~/TensorRT-7.2.1.6/samples/sampleMNIST

make

cd ~/TensorRT-7.2.1.6/data/mnist

python3 ./download_pgms.py

cd ~/TensorRT-7.2.1.6/bin

./sample_mnist

三、安装 ONNXRuntime-gpu

1. 进入ONNXRuntime的 github 下载源码(根据上面的版本适配表下载合适的源码)

2. 进入onnxruntime的代码目录,

(1)进入代码目录后,切换版本分支

git checkout v1.8.0

拉取子项:

git submodule update --init --recursive(2)编译CPU版本,命令如下:

./build.sh --skip_tests --config Release --build_shared_lib

(3)编译GPU,命令如下:

./build.sh --skip_tests --use_cuda --config Release --build_shared_lib --parallel --cuda_home /usr/local/cuda-11.0 --cudnn_home /usr/local/cuda-11.0

注:期间会出现 cmake 版本过低的报错, 需升级 cmake 版本(可参考这篇文章)

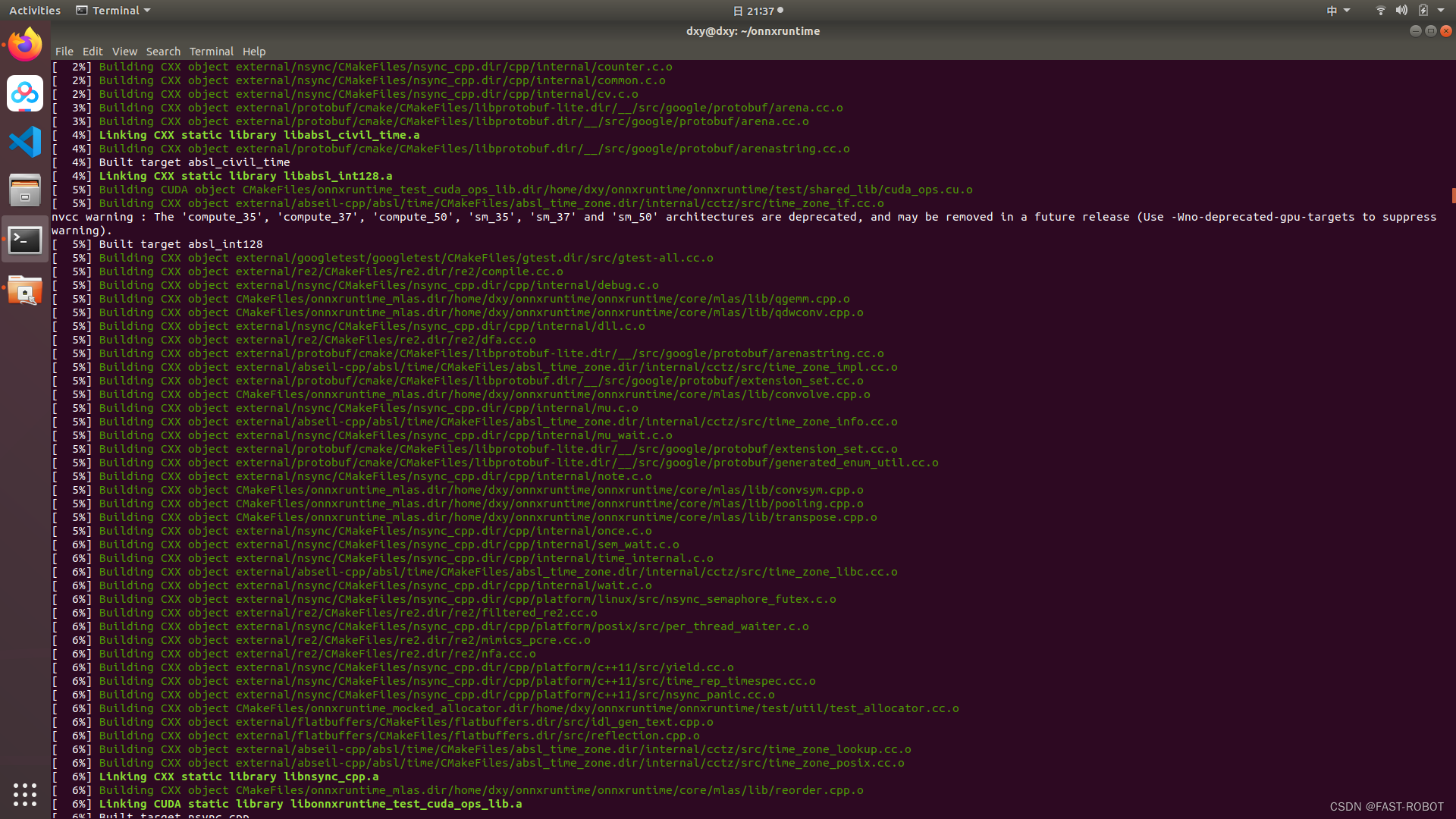

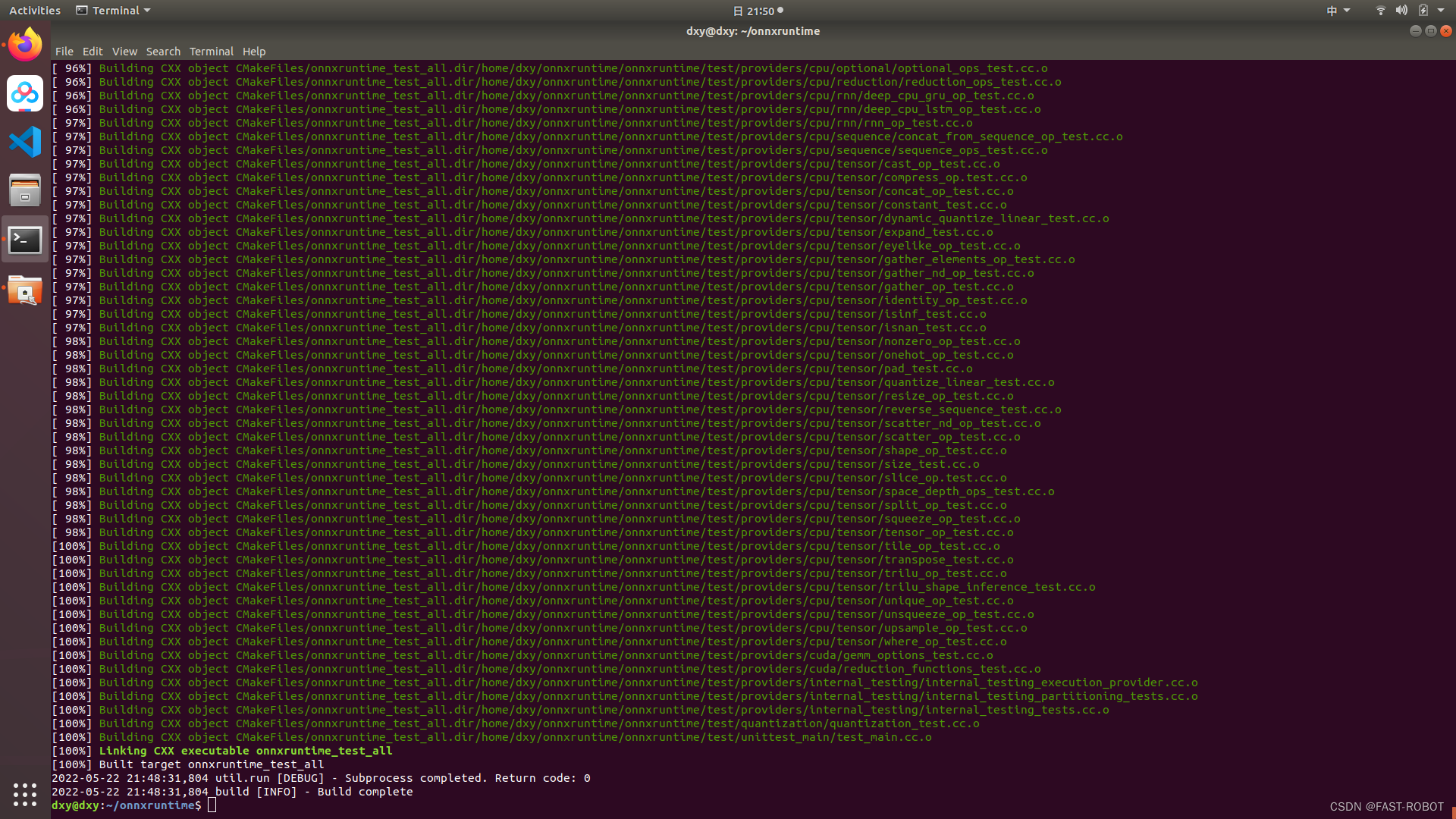

3. 编译 ONNXRuntime 中的 tensorrt,命令如下:

./build.sh --build_shared_lib --skip_tests --config Release --use_cuda --cudnn_home /usr/local/cuda/ --cuda_home /usr/local/cuda --use_tensorrt --tensorrt_home /home/dxy/TensorRT-7.2.1.6

1087

1087

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?