转载源自:

【日更】子豪兄深度学习与神经网络系列教程_哔哩哔哩_bilibili

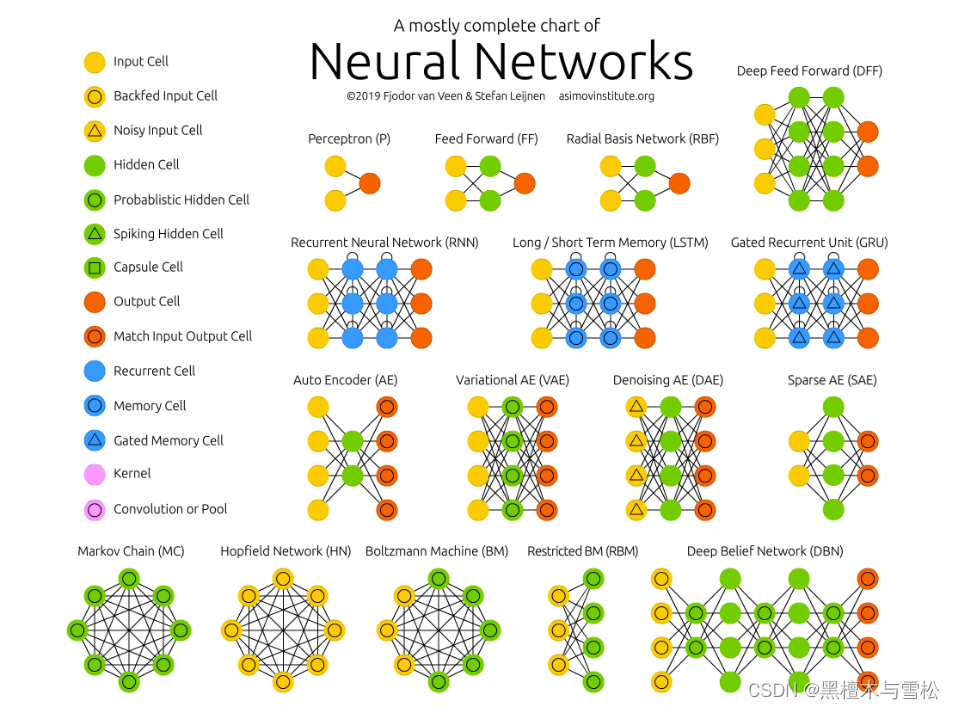

神经网络动物园链接:

The Neural Network Zoo - The Asimov Institute

其中很多诸如逻辑回归,单层感知机,多层感知机,循环神经网络,深度卷积神经网络,反卷积网络,马尔科夫链,生成对抗网络,胶囊网络,深度残差网络等神经网络

可视化逻辑回归以及sigmoid激活函数和Relu激活函数:链接:

通过泰坦尼克号的数据来通过逻辑回归来预测是否生还,网站里可以自己试一试sigmoid函数以及Relu函数的数据变化得到的函数值.

线性回归和梯度下降链接:

注:线性回归的思路,初始化w和b,也就是weight和bias,权重和截距,然后通过梯度下降算法,不断地更新权重,也可以在里面看到损失函数曲线和权重偏执曲线。通过初始化权重计算得到预测y1,将y1与实际值y计算均方误差,通过均方误差函数对不同的w求导数,更新参数更可能的使均方误差最小。

下面还有个多分类网络,使用到了softmax函数。

softmax函数的作用:在线性回归网络中,得到的softmax前的神经元得到的数值是各种各样的,softmax就是将这些神经元的数值进行归一化,得到的相对应的神经元是一个加一起等于1的概率神经元,便于后面取概率最大的神经元作为预测结果。

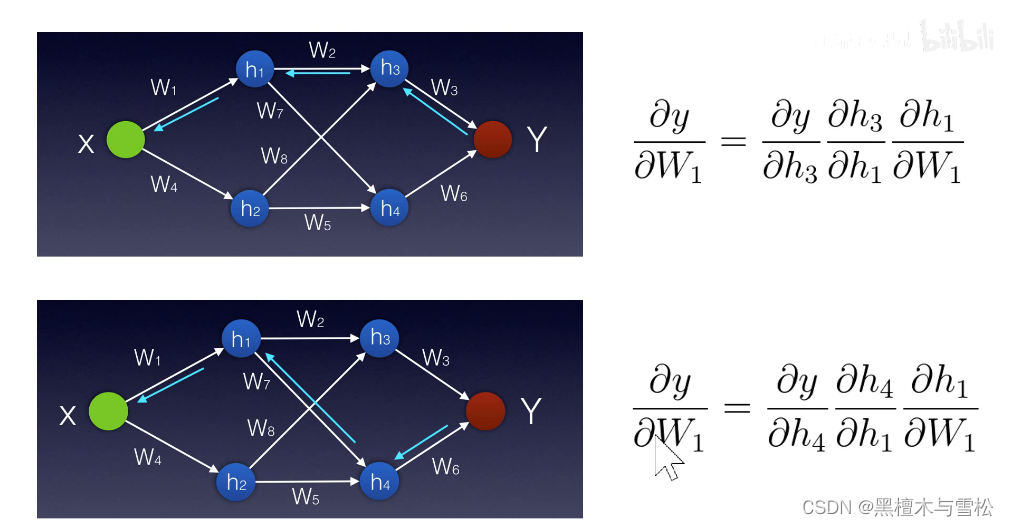

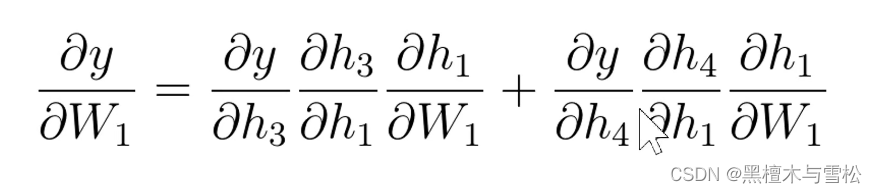

反向传播-链式法则

Y就是通过一系列wx+b,加上relu()函数得到的,若要更新W1的值,使用上述Y对W1的导数再乘以学习率得到步长,这个步长就是梯度下降的步长,在每一次迭代的时候更新W1的值。

本期到此结束啦~

1259

1259

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?