开始聊聊我对于《机器学习》(周志华)第四章4.2.1信息增益与ID3决策树训练算法的理解。

What’s that?

衡量标准-熵

要想学习理解ID3以及一些决策树训练算法首先就要引入熵这个概念

第一次看到“熵”这个名词第一反应还是小学的时候数学老师天天商商商的日子,Wow,十几年过去了,

现在咱们讨论的熵是表示:随机变量不确定性的度量(解释:说白了就是物体内部的混乱程度,比如杂货市场里面什么都有那肯定混乱呀,专卖店里面只卖一个牌子的那就稳定多啦),不确定性越大,得到的熵值也就越大!

Example: A集合[1,1,1,1,1,1,1,1,2,2]

B集合[1,2,3,4,5,6,7,8,9,1]

显然A集合的熵值要低,因为A里面只有两种类别,相对稳定一些,而B中类别太多了熵值就会大很多。

是不是很好理解?

这里我去看了些B站视频,又从一些B站视频找到了知乎YJango的视频,非常建议看看

在此附上二维码传送门!

How to measure?

熵的度量

了解了熵的定义,接下来讲一下它要如何度量

熵的度量可以分为两种情况:

一、等概率均匀分布

此时熵的度量非常简单,我们可以假设以抛硬币为单位度量熵,正反的概率都是1/2.

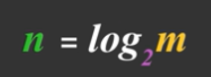

那么此时若有8种不同的情况,把8带入公式中的m,便可以得出n=3(bit)

那么此时若有4种不同的情况,把8带入公式中的m,便可以得出n=2(bit)

那么此时若有10种不同的情况,把10带入公式中的m,便可以得出n=log2 10(bit)

仿佛一切都很简单,现在我们就要考虑每种概率不相等的一般分布了

二、不等概率一般分布

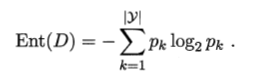

这里可以直接引用西瓜书的公式ba

把概率代入即可

信息熵(Information entropy)

其实从我的理解来讲,我认为信息熵只是熵的一个具体化或者实例化,如果你愿意,你也可以把它理解成子类继承父类(或许对,也或许不对)他里面太多的性质都在前面对于“熵”的引入中提到了,我们可以看看西瓜书上的,极其简要的说明。

在旁边我们还能看到两条小小的说明:

其中对于第二条Ent(D)的最小值和最大值的求解,我们可以参考“南瓜书”(对于西瓜书中的公式进行推导的完整记录)以下是对于南瓜书中对Ent(D)求出最大最小值的过程的链接(或许需要科学上网,我也不确定):https://datawhalechina.github.io/pumpkinbook/#/chapter4/chapter4

信息增益

在决策树算法的学习过程中,信息增益是特征选择的一个重要指标,它定义为一个特征能够为分类系统带来多少信息,带来的信息越多,说明该特征越重要,相应的信息增益也就越大。

信息熵是代表随机变量的复杂度(不确定度)

条件熵代表在某一个条件下,随机变量的复杂度(不确定度)。

而我们的信息增益恰好是:信息熵-条件熵。换句话说,信息增益代表了在一个条件下,信息复杂度(不确定性)减少的程度。那么我们现在也很好理解了,在决策树算法中,我们的关键就是每次选择一个特征,特征有多个,那么到底按照什么标准来选择哪一个特征。这个问题就可以用信息增益来度量。如果选择一个特征后,信息增益最大(信息不确定性减少的程度最大),那么我们就选取这个特征。

有了上面的基础,我们就可以来研究思考ID3算法了

ID3决策树训练算法

ID3算法其实可以简单的理解为,每一次选择可以使信息增益最大(可以使我得到的信息最大化)的条件进行分支。根据例子我们来进行理解

我们引用了《机器学习》的表4.1为例

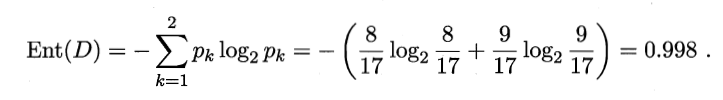

在这个数据集中,正例所占比例为8/17,反例所占比例为9/17,正如书中的那样,此时可以求出根节点的信息熵为0.998.

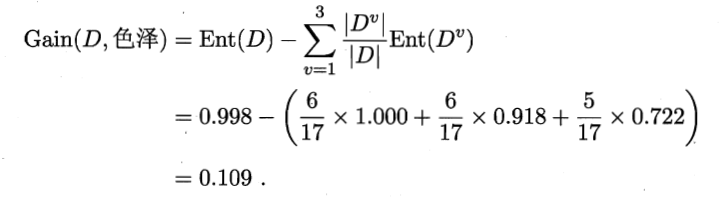

接下来看各个属性,一共六个{色泽,根蒂,敲声,纹理,脐部,触感},我们要分别求出他们各自的信息增益,这里还是以色泽为例,对所有不同色泽的成员分类,可以分为D1.{青绿},D2.{乌黑},D3.{浅白} 三个集合,再针对他们三个集合求出信息熵。

接下来,我们要求出“色泽”可以为我们带来的信息增益了

注意:这里求条件熵的时候,一定要注意乘上其所占的权重!!!

计算起来或许确实比较麻烦,不过如果只要不要求手动画出来用代码实现,应该还是…

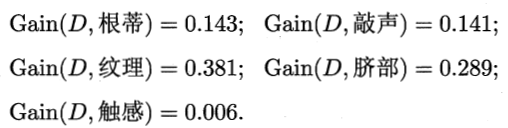

类似的,我们也要求出其他5种影响因素的信息增益!

这里直接上图

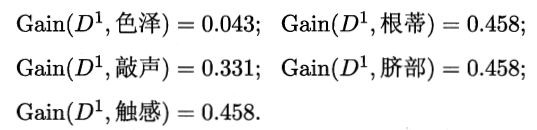

显而易见的,纹理带来的信息增益最大,那么我们就以他为根节点,以他纹理“清晰”的条件为划分,构建属性集合求出各个属性的信息增益

触感,根蒂,脐部三者的信息增益相等且最大,可以任选一个进行分支,接下来,以此类推~决策树构建结果如图

至此,以上完整的ID3算法实例讲解。

鸣谢以下参考书籍及网站

[1]. 周志华 机器学习 清华大学出版社,2016

[2].https://www.zhihu.com/question/22104055

[3].https://www.zhihu.com/people/YJango

[4].https://www.bilibili.com/video/av79015715?p=169

1796

1796

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?