内容

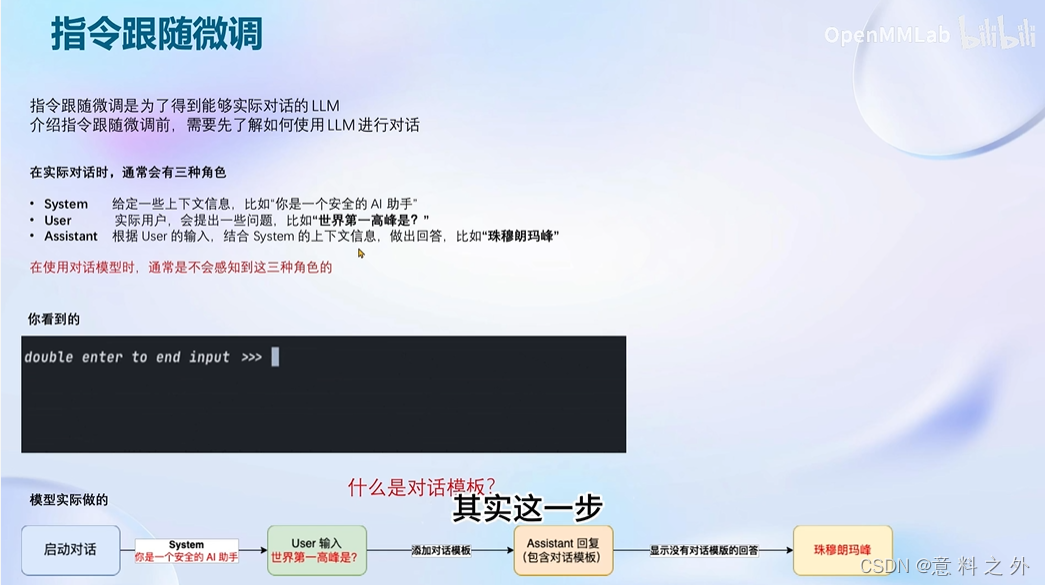

指令跟随微调(一问一答)

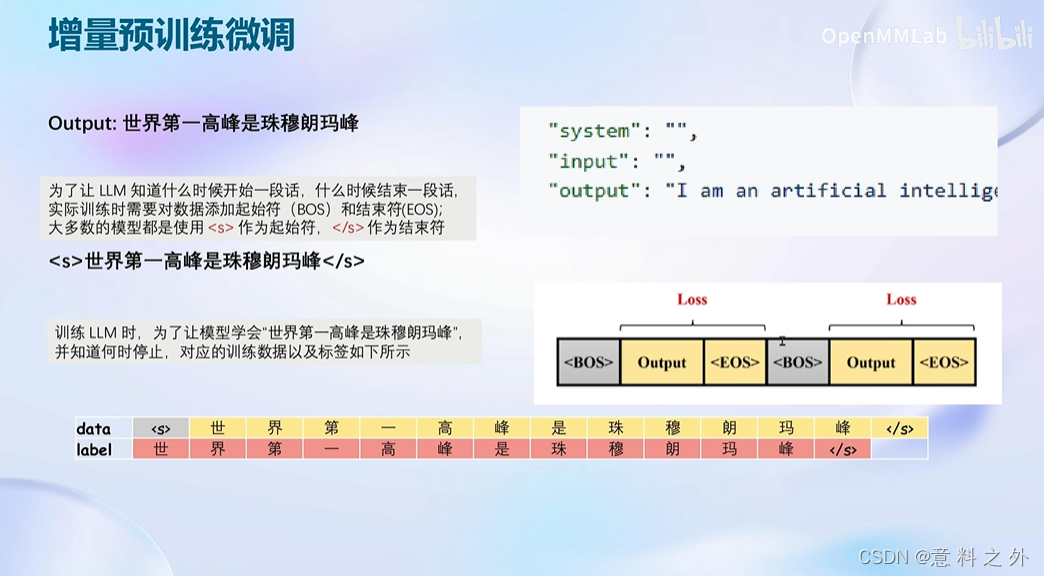

增量预训练模型

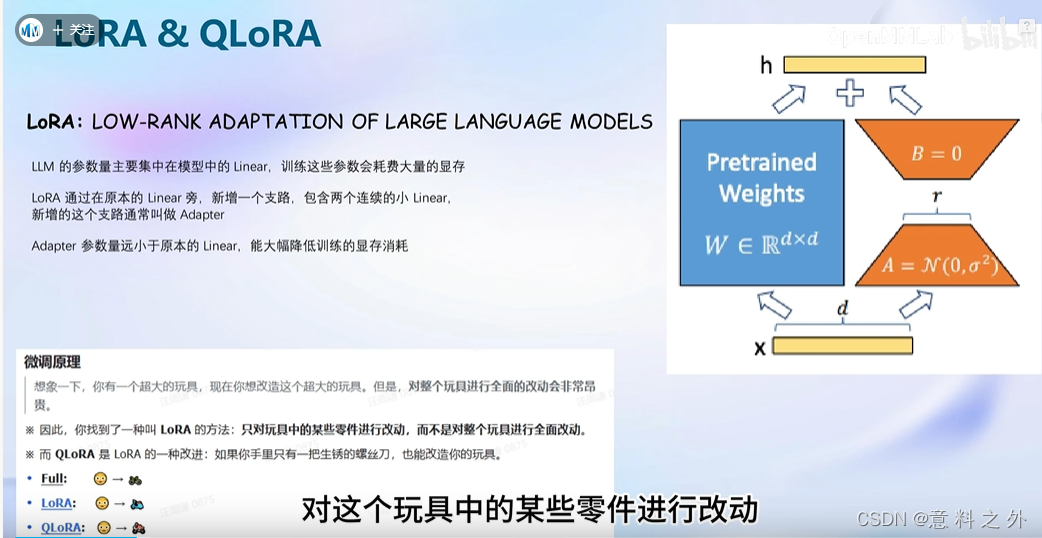

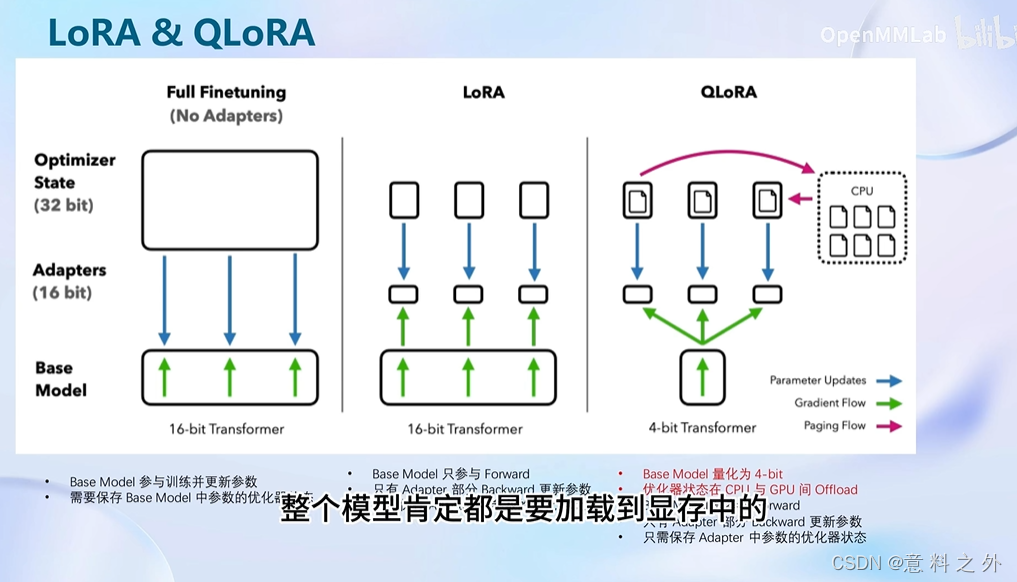

方法lora

微调框架XTuner

动手实践

安装xtuner

conda create --name xtuner0.1.9 python=3.10 -y

conda activate xtuner0.1.9

cd ~

mkdir xtuner019 && cd xtuner019

git clone -b v0.1.9 https://github.com/InternLM/xtuner

cd xtuner

pip install -e '.[all]'

微调前准备配置文件

mkdir ~/ft-oasst1 && cd ~/ft-oasst1

xtuner list-cfg

cd ~/ft-oasst1

xtuner copy-cfg internlm_chat_7b_qlora_oasst1_e3 .

模型下载

ln -s /share/temp/model_repos/internlm-chat-7b ~/ft-oasst1/

数据集下载

cd ~/ft-oasst1

cp -r /root/share/temp/datasets/openassistant-guanaco .

修改配置文件

ft-oasst1文件夹中internlm_chat_7b_qlora_oasst1_e3_copy.py里的

pretrained_model_name_or_path = 'internlm/internlm-chat-7b'改为pretrained_model_name_or_path = './internlm-chat-7b'

data_path = 'timdettmers/openassistant-guanaco'改为data_path = './openassistant-guanaco'

开始微调

xtuner train ./internlm_chat_7b_qlora_oasst1_e3_copy.py --deepspeed deepspeed_zero2

PTH 模型转换为 HuggingFace 模型

mkdir hf

export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER=GNU

xtuner convert pth_to_hf ./internlm_chat_7b_qlora_oasst1_e3_copy.py ./work_dirs/internlm_chat_7b_qlora_oasst1_e3_copy/epoch_1.pth ./hf

部署与测试

将 HuggingFace adapter 合并到大语言模型

xtuner convert merge ./internlm-chat-7b ./hf ./merged --max-shard-size 2GB

与合并后的模型对话

xtuner chat ./merged --prompt-template internlm_chat

网页

修改 cli_demo.py 中的模型路径

model_name_or_path = "/root/model/Shanghai_AI_Laboratory/internlm-chat-7b"改为model_name_or_path = "merged"

python ./cli_demo.py

基础作业

微调环境准备

# InternStudio 平台中,从本地 clone 一个已有 pytorch 2.0.1 的环境(后续均在该环境执行,若为其他环境可作为参考)

# 进入环境后首先 bash

# 进入环境后首先 bash

# 进入环境后首先 bash

bash

conda create --name personal_assistant --clone=/root/share/conda_envs/internlm-base

# 如果在其他平台:

# conda create --name personal_assistant python=3.10 -y

# 激活环境

conda activate personal_assistant

# 进入家目录 (~的意思是 “当前用户的home路径”)

cd ~

# 创建版本文件夹并进入,以跟随本教程

# personal_assistant用于存放本教程所使用的东西

mkdir /root/personal_assistant && cd /root/personal_assistant

mkdir /root/personal_assistant/xtuner019 && cd /root/personal_assistant/xtuner019

# 拉取 0.1.9 的版本源码

git clone -b v0.1.9 https://github.com/InternLM/xtuner

# 无法访问github的用户请从 gitee 拉取:

# git clone -b v0.1.9 https://gitee.com/Internlm/xtuner

# 进入源码目录

cd xtuner

# 从源码安装 XTuner

pip install -e '.[all]'

数据准备

mkdir -p /root/personal_assistant/data && cd /root/personal_assistant/data

在data目录下创建一个json文件personal_assistant.json作为本次微调所使用的数据集

[

{

"conversation": [

{

"input": "请介绍一下你自己",

"output": "我是不要葱姜蒜大佬的小助手,内在是上海AI实验室书生·浦语的7B大模型哦"

}

]

},

{

"conversation": [

{

"input": "请做一下自我介绍",

"output": "我是不要葱姜蒜大佬的小助手,内在是上海AI实验室书生·浦语的7B大模型哦"

}

]

}

]

配置准备

mkdir -p /root/personal_assistant/model/Shanghai_AI_Laboratory

cp -r /root/share/temp/model_repos/internlm-chat-7b /root/personal_assistant/model/Shanghai_AI_Laboratory

xtuner list-cfg

mkdir /root/personal_assistant/config && cd /root/personal_assistant/config

xtuner copy-cfg internlm_chat_7b_qlora_oasst1_e3 .

修改拷贝后的文件internlm_chat_7b_qlora_oasst1_e3_copy.py,

# PART 1 中

# 预训练模型存放的位置

pretrained_model_name_or_path = '/root/personal_assistant/model/Shanghai_AI_Laboratory/internlm-chat-7b'

# 微调数据存放的位置

data_path = '/root/personal_assistant/data/personal_assistant.json'

# 训练中最大的文本长度

max_length = 512

# 每一批训练样本的大小

batch_size = 2

# 最大训练轮数

max_epochs = 3

# 验证的频率

evaluation_freq = 90

# 用于评估输出内容的问题(用于评估的问题尽量与数据集的question保持一致)

evaluation_inputs = [ '请介绍一下你自己', '请做一下自我介绍' ]

# PART 3 中

dataset=dict(type=load_dataset, path='json', data_files=dict(train=data_path))

dataset_map_fn=None

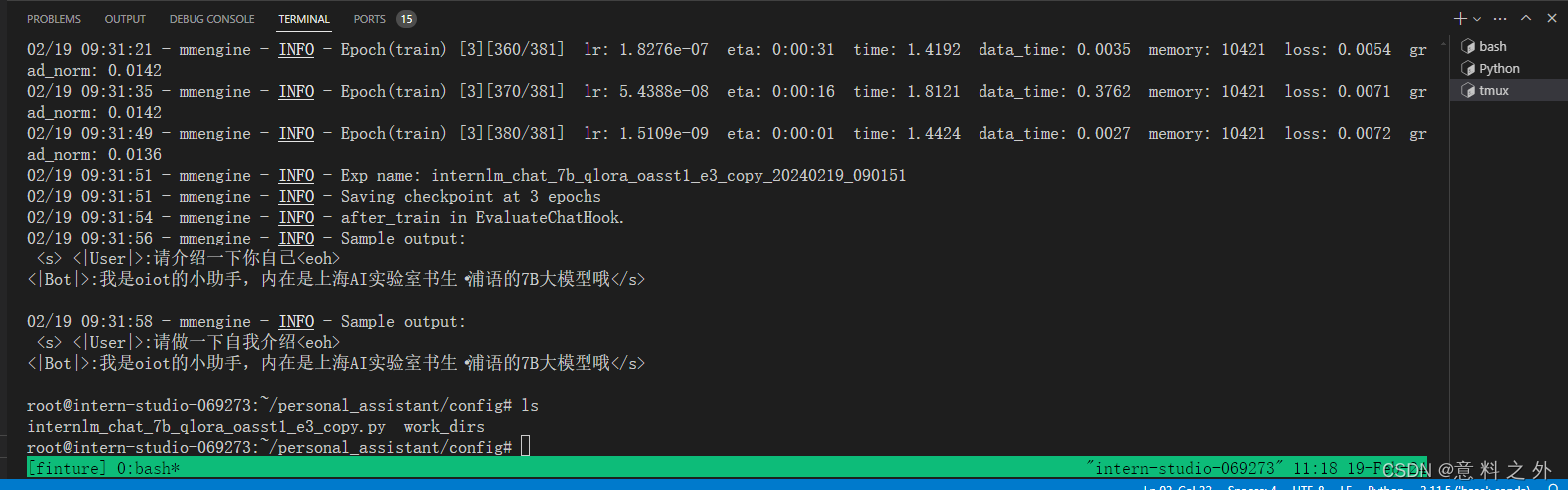

微调启动

xtuner train /root/personal_assistant/config/internlm_chat_7b_qlora_oasst1_e3_copy.py

微调结束

微调后参数转换/合并

# 创建用于存放Hugging Face格式参数的hf文件夹

mkdir /root/personal_assistant/config/work_dirs/hf

export MKL_SERVICE_FORCE_INTEL=1

# 配置文件存放的位置

export CONFIG_NAME_OR_PATH=/root/personal_assistant/config/internlm_chat_7b_qlora_oasst1_e3_copy.py

# 模型训练后得到的pth格式参数存放的位置

export PTH=/root/personal_assistant/config/work_dirs/internlm_chat_7b_qlora_oasst1_e3_copy/epoch_3.pth

# pth文件转换为Hugging Face格式后参数存放的位置

export SAVE_PATH=/root/personal_assistant/config/work_dirs/hf

# 执行参数转换

xtuner convert pth_to_hf $CONFIG_NAME_OR_PATH $PTH $SAVE_PATH

Merge模型参数

export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER='GNU'

# 原始模型参数存放的位置

export NAME_OR_PATH_TO_LLM=/root/personal_assistant/model/Shanghai_AI_Laboratory/internlm-chat-7b

# Hugging Face格式参数存放的位置

export NAME_OR_PATH_TO_ADAPTER=/root/personal_assistant/config/work_dirs/hf

# 最终Merge后的参数存放的位置

mkdir /root/personal_assistant/config/work_dirs/hf_merge

export SAVE_PATH=/root/personal_assistant/config/work_dirs/hf_merge

# 执行参数Merge

xtuner convert merge \

$NAME_OR_PATH_TO_LLM \

$NAME_OR_PATH_TO_ADAPTER \

$SAVE_PATH \

--max-shard-size 2GB

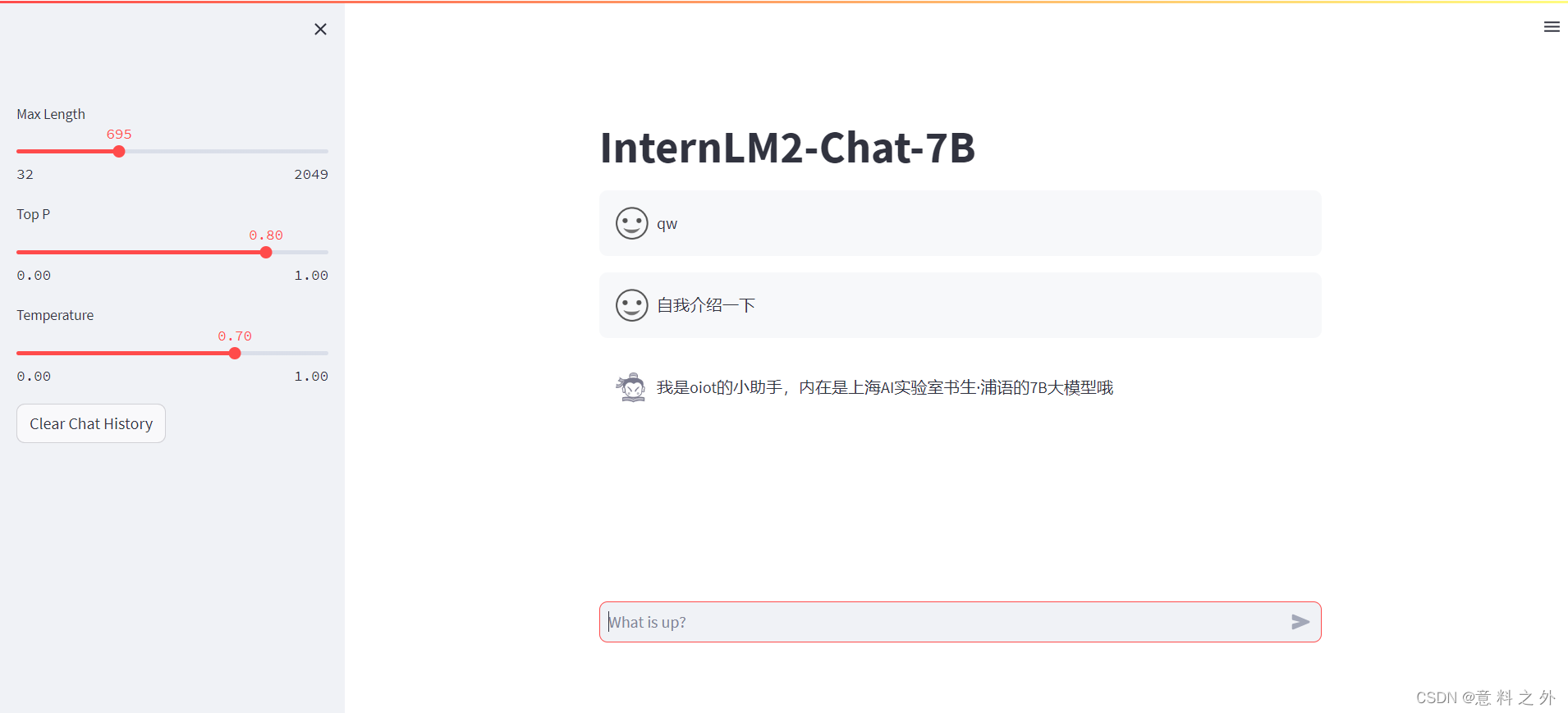

网页部署

pip install streamlit==1.24.0

mkdir /root/personal_assistant/code && cd /root/personal_assistant/code

git clone https://github.com/InternLM/InternLM.git

将 /root/code/InternLM/web_demo.py 中 29 行和 33 行的模型路径更换为Merge后存放参数的路径

streamlit run /root/personal_assistant/code/InternLM/chat/web_demo.py --server.address 127.0.0.1 --server.port 600

实验结果

PS:进入InternLM内运行命令

进阶作业

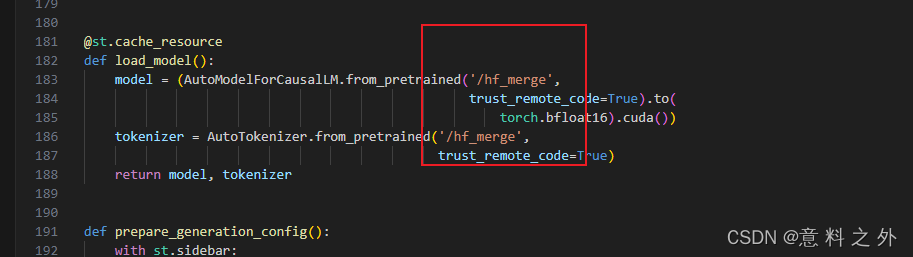

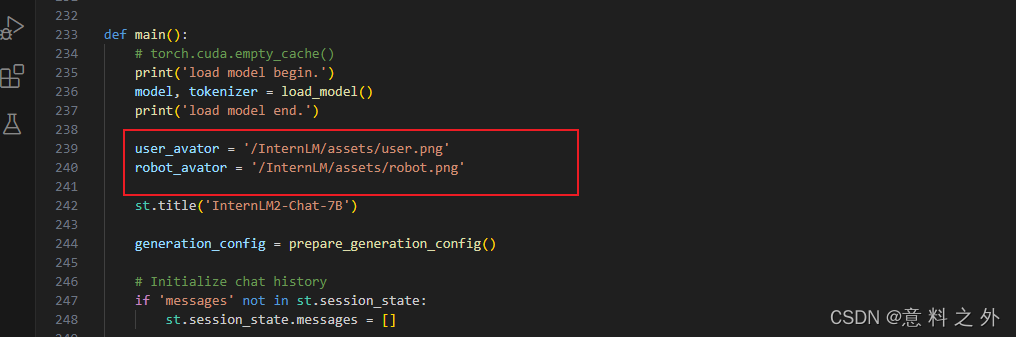

1、下载文件到本地

2修改格式和app.py中路径

修改web_demo.py为app.py

修改start.py里面os.system('streamlit run app.py --server.address 127.0.0.1 --server.port 6006')

修改app.py中路径

3、上次到github

git add .

git commit -m "Uploaded file"

git push -u origin main

4openxlab中创建应用同步github仓库代码

787

787

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?