Multi-Branch Network for Color Image Denoising Using Dilated Convolution and Attention Mechanisms

使用扩张卷积和注意力机制进行彩色图像去噪的多分支网络

论文:Multi-Branch Network for Color Image Denoising Using Dilated Convolution and Attention Mechanisms

Abstract:

图像去噪被认为是计算机视觉任务中的一个不适定问题,它可以消除图像传感器中的附加噪声。 最近,几种基于卷积神经网络的图像去噪方法取得了显着的进展。然而,由于图像内容的复杂性,简单的去噪网络很难恢复美观的图像。因此,本研究提出了一种多分支网络来提高去噪方法的性能。首先,所提出的网络是基于传统的自动编码器设计的,以从输入图像中学习多级上下文特征。随后,我们将两个模块集成到网络中,包括金字塔上下文模块(PCM)和残差瓶颈注意力模块(RBAM),以提取训练过程的显着信息。更具体地说,在网络的开头应用 PCM 来扩大感受野,并使用扩张卷积成功解决全局信息的丢失问题。同时,RBAM 被插入到编码器和解码器的中间,以消除退化的特征并减少不需要的伪影。 最后,大量的实验结果证明了该方法在客观和主观性能方面优于最先进的深度学习方法。

Keywords: additive noise; attention mechanism; dilated convolution; multi-branch network; image denoising

Introduction

基于深度学习的图像去噪方法仍然存在一些问题:

(1)使用简单的网络来提高去噪任务的性能具有挑战性;

(2)全局信息被忽视;

(3) 由于未能全面处理降级特征而产生的不良产物。

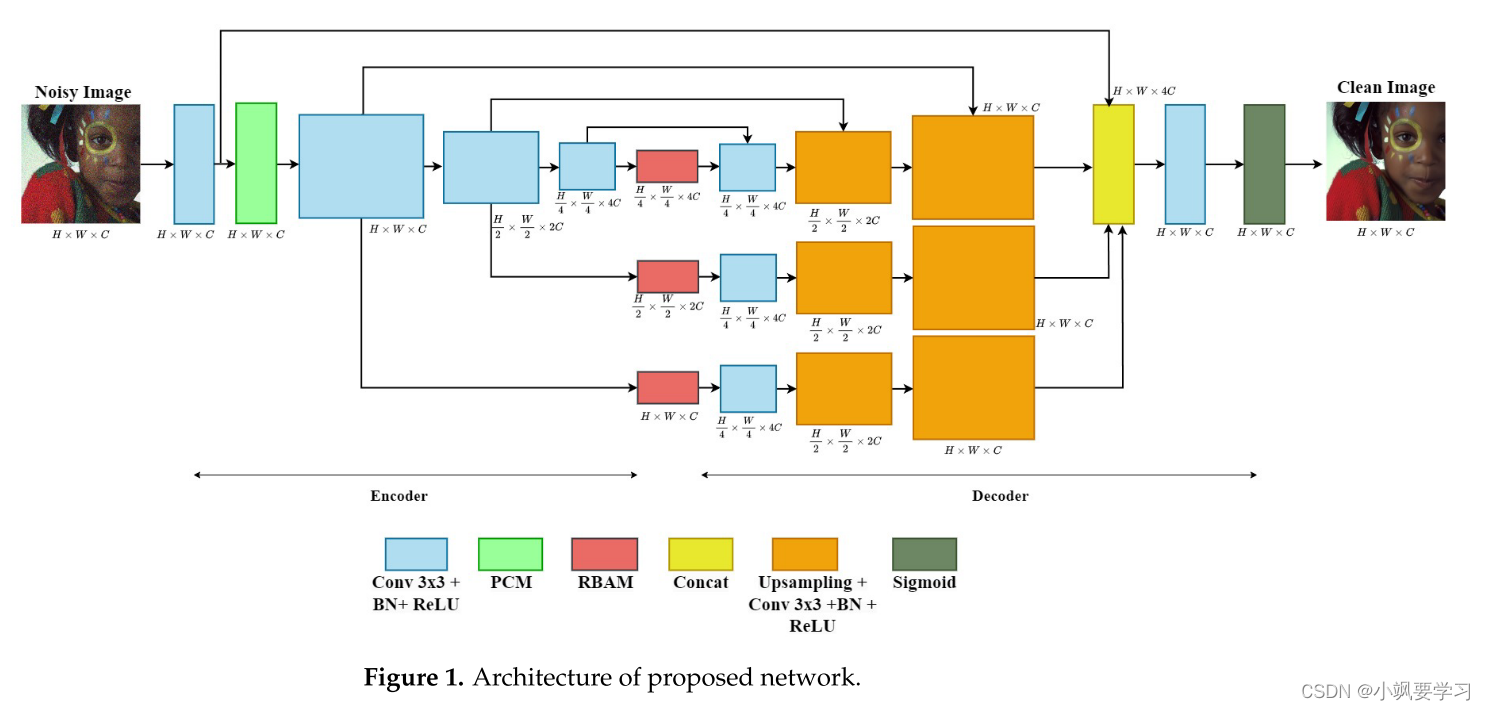

为了解决这些问题,我们提出了一种基于传统自动编码器的多分支网络,以从噪声图像中学习多级上下文特征。此外,我们将金字塔上下文模块(PCM)和残留瓶颈注意力模块(RBAM)这两个模块集成到网络中,以在训练过程中选择显着信息。所提出网络的架构如图 1 所示。更具体地说,多分支网络具有使用跳跃连接组合多级上下文特征图的结构。事实证明,这种结构通过图像的结构分析可以有效地进行学习,并且可以稳健地消除图像中的加性噪声。此外,在网络的开头添加了PCM来处理全局信息丢失问题。它使用具有四种扩张率的并行扩张卷积运算,并以金字塔形式排列。最后但并非最不重要的一点是,我们将 RBAM 插入编码器和解码器的中间,以关注有价值的特征并忽略退化的特征,而不会引入过多的额外计算。 使用各种定量指标评估所提出方法的性能。

综上所述,本文的主要贡献如下:

提出了一种有效提高图像去噪任务性能的多分支网络。

引入使用扩张卷积的 PCM 来扩大感受野并成功解决全局信息的丢失问题。

RBAM 旨在消除退化的功能并减少不需要的伪影。

在多个数据集上进行了综合实验,证明所提出的方法优于其他竞争方法。

Related Work

图像去噪的目的是从噪声图像 y 中恢复干净的图像 x。 一般来说,退化模型被表述为 y = x + n,其中 n 表示加性噪声。 图像去噪方法可以分为两大类:传统方法和深度学习方法。

传统方法可以灵活解决不同噪声水平的去噪问题。维纳滤波器已被用于去除高斯噪声,以解决均值滤波器的缺点,即容易受到高噪声水平图像过度平滑的影响。中值、加权中值和双边滤波器由于其边缘保留特性,无需特殊识别即可最大限度地减少加性噪声。总变化基于绝对图像梯度的积分,当图像包含大量细节时,绝对图像梯度会增加; 特别是,它在保留图像边界的同时减少了噪声。总的来说,这些方法的性能取决于它们的优化算法,需要仔细选择参数,并且计算成本非常高。

最近,深度学习方法已成功处理图像去噪。 最早的尝试之一是 DnCNN ,提出残差学习和批量归一化来实现端到端图像去噪。关于之前基于 CNN 的降噪方法,DRUNet是一种可靠的基于 CNN 的选项,它在解决不适定问题和开发强大的、适应性强的解决方案方面显示出了巨大的希望。此外,用于图像恢复的深度 CNN 降噪器 (IRCNN)使用已知的噪声水平来训练降噪器,然后利用该降噪器来估计噪声水平。为了提高去噪速度,FFDNet利用噪声水平和噪声图像作为基于 CNN 的网络的输入。RDUNet 是一种基于密集连接的分层网络的用于图像去噪的残差密集神经网络。最近,Transformer技术已应用于图像去噪。最具代表性的是用于图像去噪的 swin-transformer UNet(SUNet)和基于 swin-transformer 的图像恢复(SwinIR),采用 swin-transformer 作为主要模块,并将其集成到独特的去噪架构中以抑制加性噪音。 此外,夏等人引入了一种用于图像恢复的高效扩散模型(DiffIR),其中包含紧凑的红外先验提取网络(CPEN)、动态红外变换器(DIRformer)和去噪网络。 杨等人提出了一种基于线性插值的通用扩散模型的现实世界去噪方法。 MambaIR 使用残差状态空间块改进了普通 Mamba 模型,该块具有基于局部卷积的增强和用于图像去噪任务的通道关注。

简而言之,深度学习方法在一定程度上优于传统方法。然而,有很多方法可以提高去噪性能,特别是通过关注全局信息并使用高效的深度学习网络减少不需要的伪影。为此,我们设计了一个使用扩张卷积和注意力机制的多分支网络,可以丰富全局信息并消除退化特征。

Proposed Method

在本节中,我们结合两个特征提取模块(包括金字塔上下文模块(PCM)和残留瓶颈注意力模块(RBAM))展示多分支网络的架构。 随后,还引入损失函数来优化所提出的网络。

Network Architecture

图 1 描述了所提出的网络的结构。首先,提出了一种基于传统自动编码器架构的用于图像去噪的多分支网络。其次,我们在网络的开头添加了 PCM 以提取有用的全局信息。最终,RBAM 被插入到编码器和解码器的中间,以过滤掉不需要的伪影。开头和结尾的卷积层帮助网络捕获图像及其特征之间的复杂映射。

Multi-Branch Network(多分支网络)

许多科学家最近采用基于卷积神经网络(CNN)的自动编码器结构来最小化加性噪声。这些方法大多数采用编码器-解码器框架来学习各种感受野的特征。然而,编码器-解码器框架中包含的重复上采样和下采样操作会导致纹理细节丢失,严重影响图像的恢复。为了解决这个问题,我们设计了一种基于传统自动编码器架构的多分支网络,用于图像去噪。该网络使用跳跃连接组合多级上下文特征图。事实证明,通过图像的结构分析可以轻松学习结构,并有效地去除图像中的加性噪声。所提出的网络在每个编码器-解码器卷积模块中具有三个尺度。 我们在编码器中利用跨步卷积层进行下采样来压缩基本信息。在解码器中,我们应用调整大小卷积层进行上采样,并实现与其在编码器部分中的镜像相称的特征图大小。编码器和相应的解码器块之间使用跳跃连接,旨在重建通常在编码阶段丢失的特征和图像信息。但值得注意的是,它仅用于第一个分支。 此外,由于在将噪声图像输入多分支网络之前提取的低级特征包含大量颜色信息,因此我们通过全局跳跃连接将它们与三个分支的最后一个特征图连接起来。随后,使用3×3卷积层融合先前提取的低级特征和无噪声的高级特征以生成输出图像。所提出的网络中使用 sigmoid 函数来引入非线性属性及其在 0 到 1 范围内的输出。此外,我们在训练网络之前采用归一化算子将输入图像重新缩放到 0 到 1 之间。这有助于稳定梯度下降步骤,允许网络使用更大的学习率并针对给定的学习率更快地收敛。训练过程完成后,输出图像将重新缩放回原始像素值以生成彩色图像。 这些修改有望提高我们的网络在促进图像去噪和防止图像恢复过程中信息丢失方面的性能。

Pyramid Context Module(金字塔上下文模块)

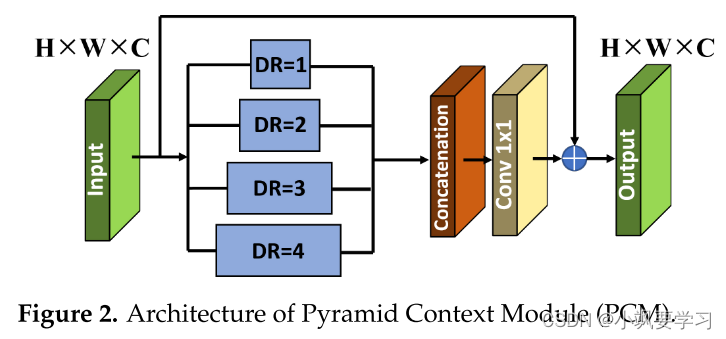

如前所述,由于感受野扩展有限,全局信息通常会在基于自动编码器的模型中丢失。受[38]的启发,扩张卷积是卷积神经网络(CNN)中使用的一种滤波器扩展技术。在此技术中,滤波器的元件之间有间隙,间隙由膨胀率 (DR) 决定。扩张卷积有助于在不显着增加参数的情况下增加网络的感受野,从而使网络能够从输入数据中捕获更多的全局信息。**它在捕获大空间范围内的上下文信息很重要的任务中非常有用,特别是图像恢复。**因此,我们引入了使用扩张卷积的金字塔上下文模块(PCM),并将其插入到网络的开头以获得丰富的感受野信息,如图2所示。具体来说,我们采用并行扩张卷积来提取受 Atrous Spatial Pyramid Pooling (ASPP) 块 [39] 启发的多上下文特征。这使得网络能够学习上下文相关的信息。通过连接所有并行扩张卷积层的输出来丰富特征金字塔。由于扩张率不断上升(DR = 1、2、3 和 4),这些并行层的上下文逐渐变宽。然后,我们采用 1 × 1 卷积层来融合来自不同感受野的特征。此外,我们应用长跳跃连接来利用浅层特征的信息。最后,融合特征与输入特征相结合,使用逐元素加法运算获得输出。

图 2.金字塔上下文模块 (PCM) 的架构。

Residual Bottleneck Attention Module (RBAM)(残差瓶颈注意力模块)

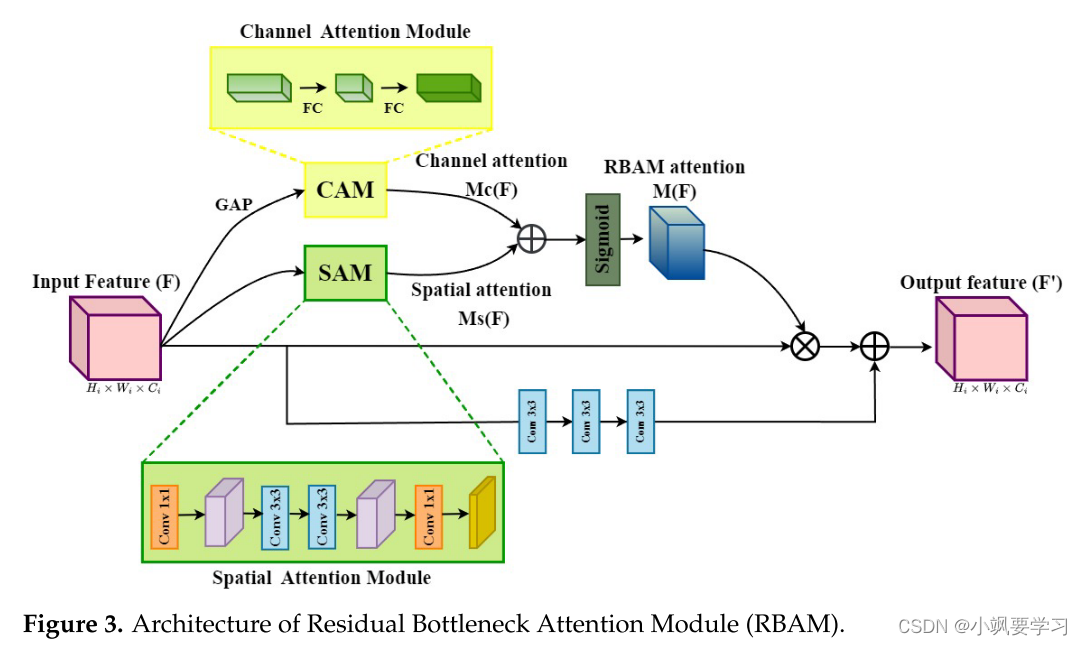

尽管具有对称跳跃连接的自动编码器结构在图像去噪任务中表现出了良好的性能,但我们观察到最终结果中仍然存在一些不需要的伪影。造成此问题的一个合理原因是降级的特征从编码器传递到解码器。为了克服这个问题,我们利用广泛用于各种图像恢复任务的注意力机制进入编码器和解码器的中间。在本研究中,我们提出了一个由两个分支组成的 RBAM,即通道注意力模块 (CAM) 和空间注意力模块 (SAM),以消除退化的特征,从而减少不需要的伪影,如图 3 所示。该模块受到[43]的启发,并在没有引入过多计算的情况下进行了证明。 然而,与之前的方法不同,我们的 RBAM 最显着的变化之一是残差学习,它可以防止梯度消失问题并且对于训练处理来说是鲁棒的。

对于输入特征图

F

∈

R

H

i

×

W

i

×

C

i

F\in\mathbb{R}^{H_{i}\times W_{i}\times C_{i}}

F∈RHi×Wi×Ci,RBAM 生成注意力图

M

(

F

)

∈

R

H

i

×

W

i

×

C

i

M(F)\in\mathbb{R}^{H_{i}\times W_{i}\times C_{i}}

M(F)∈RHi×Wi×Ci 。这里,

H

i

,

W

i

,

和

C

i

H_i,W_i,\mathrm{和~}C_i

Hi,Wi,和 Ci分别表示第i个特征图的高度、宽度和通道。 输出特征图

F

′

∈

R

H

i

×

W

i

×

C

i

F^{\prime}\in\mathbb{R}^{H_{i}\times W_{i}\times C_{i}}

F′∈RHi×Wi×Ci表示为

F

′

=

c

o

n

v

3

×

3

(

c

o

n

v

3

×

3

(

c

o

n

v

3

×

3

(

F

)

)

)

+

F

∘

M

(

F

)

F'=conv_{3\times3}(conv_{3\times3}(conv_{3\times3}(F)))+F\circ M(F)

F′=conv3×3(conv3×3(conv3×3(F)))+F∘M(F)

其中 o 表示逐元素乘积。

我们利用残差学习与注意力机制相结合来改善梯度流。 为了设计一个高效而鲁棒的模块,我们首先计算两个隔离分支的通道注意力

M

c

(

F

)

∈

R

1

×

1

×

C

i

M_{c}(F)\in\mathbb{R}^{1\times1\times C_{i}}

Mc(F)∈R1×1×Ci和空间注意力

M

s

(

F

)

∈

R

H

i

×

W

i

×

1

M_{s}(F)\in\mathbb{R}^{H_{i}\times W_{i}\times1}

Ms(F)∈RHi×Wi×1。 最后,注意力图 M(F) 计算为

M

(

F

)

=

σ

(

M

c

(

F

)

+

M

s

(

F

)

)

M(F)=\sigma(M_c(F)+M_s(F))

M(F)=σ(Mc(F)+Ms(F))

其中 σ 代表 sigmoid 函数。

在RBAM中,CAM生成通道注意力图

M

C

(

F

)

M_{\mathcal{C}}(F)

MC(F)来关注输入特征的含义,而SAM生成空间注意力图

M

s

(

F

)

M_{s}(F)

Ms(F)来关注信息部分的位置。特别地,通道和空间注意力图计算如下:

M

C

(

F

)

=

B

N

(

M

L

P

(

G

A

P

(

F

)

)

)

M_C(F)=BN(MLP(GAP(F)))

MC(F)=BN(MLP(GAP(F)))

M

s

(

F

)

=

B

N

(

c

o

n

v

1

×

1

(

c

o

n

v

3

×

3

(

c

o

n

v

3

×

3

(

c

o

n

v

1

×

1

(

F

)

)

)

)

)

M_s(F)=BN(conv_{1\times1}(conv_{3\times3}(conv_{3\times3}(conv_{1\times1}(F)))))

Ms(F)=BN(conv1×1(conv3×3(conv3×3(conv1×1(F)))))

其中 BN(·) 是批量归一化层,MLP(·) 表示具有一个隐藏层的多层感知器。GAP(·)表示在特征图F上进行全局平均池化以生成通道向量。

Loss Function

在本节中,提出了一个三项损失函数,包括 Charbonnier 损失、结构损失和感知损失。 总损失函数可以表示为

L

t

o

t

a

l

=

L

c

h

a

r

+

L

s

t

r

+

L

p

e

r

\mathcal{L}_{total}=\mathcal{L}_{char}+\mathcal{L}_{str}+\mathcal{L}_{per}

Ltotal=Lchar+Lstr+Lper

Charbonnier 损失函数用于测量去噪图像与真实图像之间的差异。与L1损失函数相比,它可以更好地解决异常值并提高模型性能。 它被定义为

L

c

h

a

r

=

∥

X

−

Y

∥

2

+

ϵ

2

\mathcal{L}_{char}=\sqrt{\parallel X-Y\parallel^2+\epsilon^2}

Lchar=∥X−Y∥2+ϵ2

其中 X 和 Y 分别代表无噪声图像和真实图像。 ϵ 是损失函数从近似二次变为近似线性的系数。

此外,结构相似性指数矩阵(SSIM)比较两幅图像之间的相似性。 为了更好地保留图像的结构信息,我们使用结构损失作为SSIM损失,其表示为

L

s

t

r

=

1

−

S

S

I

M

(

X

,

Y

)

\mathcal{L}_{str}=1-SSIM(X,Y)

Lstr=1−SSIM(X,Y)

其中SSIM(·)表示SSIM操作。

S

S

I

M

(

x

,

y

)

=

(

2

μ

x

μ

y

+

C

1

)

(

2

σ

x

y

+

C

2

)

(

μ

x

2

+

μ

y

2

+

C

1

)

(

σ

x

2

+

σ

y

2

+

C

2

)

SSIM(x,y)=\frac{(2\mu_x\mu_y+C_1)(2\sigma_{xy}+C_2)}{(\mu_x^2+\mu_y^2+C_1)(\sigma_x^2+\sigma_y^2+C_2)}

SSIM(x,y)=(μx2+μy2+C1)(σx2+σy2+C2)(2μxμy+C1)(2σxy+C2)

其中 µx 和 µy 是两个图像的平均值; σx和σy是两个图像的方差值,σxy是两个图像之间的协方差,C1和C2是防止分母为零的两个常数。

一般来说,基于每像素的损失函数很难确定无噪声图像和真实图像之间高级特征的差异。本研究利用感知损失函数来最小化从预训练的 VGG-16 网络中提取的高级特征的差异,可以表示为

L

p

e

r

=

1

W

n

H

n

C

n

(

∥

ρ

(

X

)

−

ρ

(

Y

)

∥

2

2

)

\mathcal{L}_{per}=\frac1{W_nH_nC_n}(\parallel\rho(X)-\rho(Y)\parallel_2^2)

Lper=WnHnCn1(∥ρ(X)−ρ(Y)∥22)

其中ρ(·)表示从VGG-16网络获得的特征图。 Wn、Hn、Cn 分别表示对应特征图的宽度、高度和通道数。

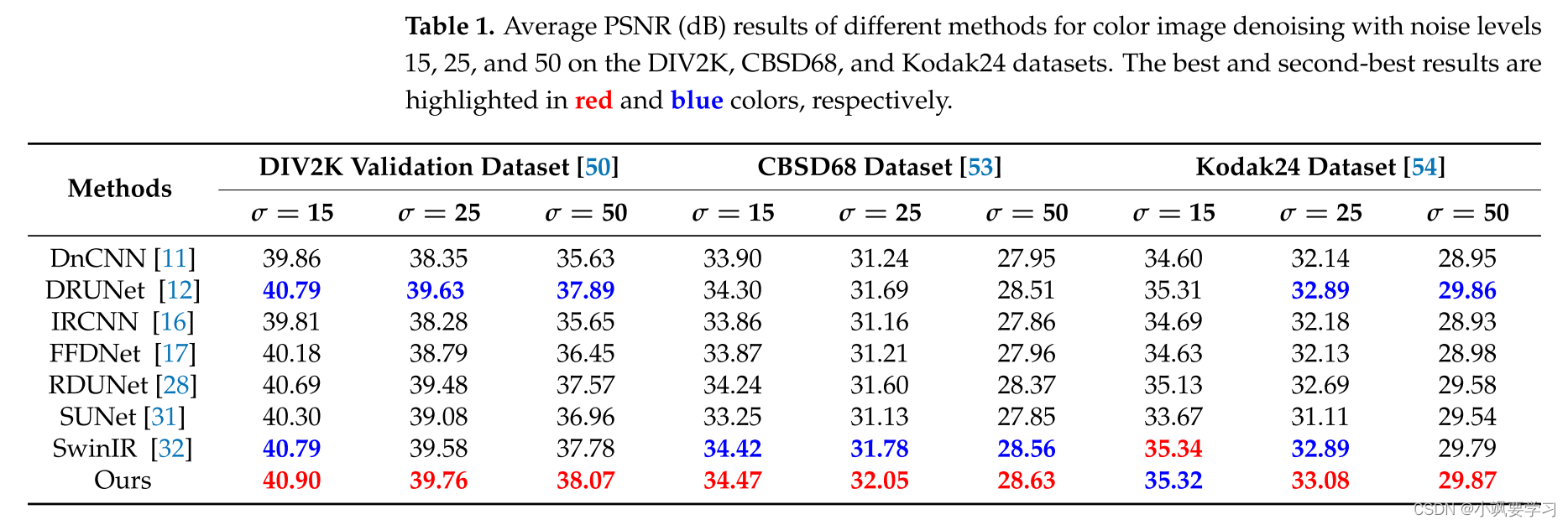

Experimental Results

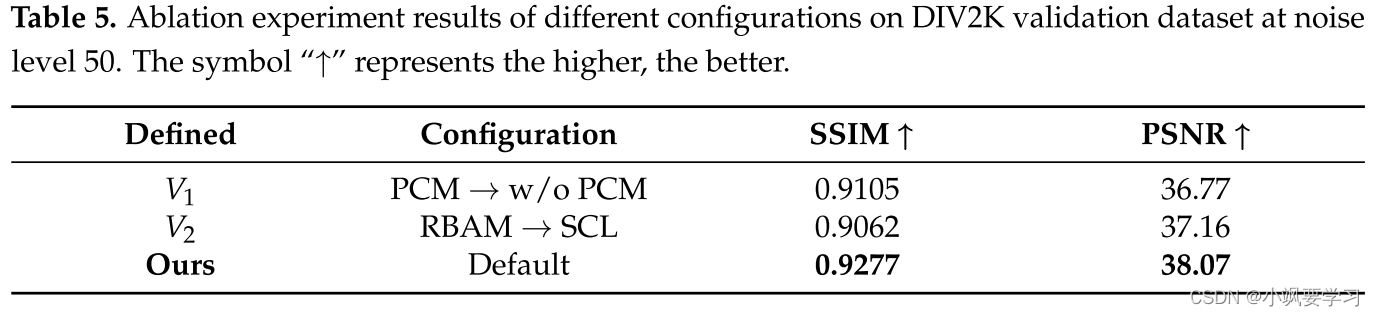

Ablation Study

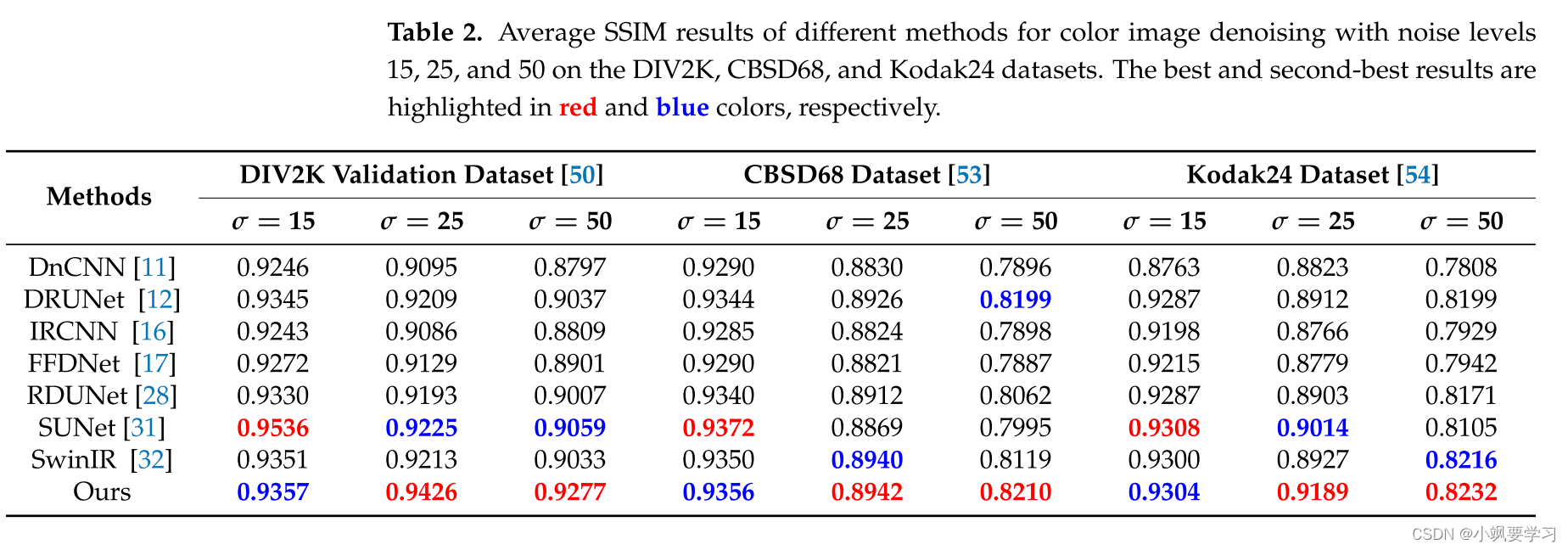

在本节中,我们进行了一些实验来强调所提出的网络中不同模块的有效性。 表 5 说明了在噪声级别 50 的 DIV2K 验证数据集上基于不同配置(V1 和 V2)的消融研究的性能比较。

Effectiveness of PCM

我们通过在提议的网络中省略 PCM(定义为 w/o PCM)来评估 PCM 的有用性。 结果表明,使用 PCM 的网络在 SSIM 方面比不使用 PCM 的网络高 0.0172,在 PSNR 方面比不使用 PCM 的网络高 1.30 dB。 总之,消融结果表明 PCM 可以有效地捕获全局和上下文信息。

Effectiveness of RBAM

我们评估了 RBAM 的优越性,并将其与单个卷积层(定义为 SCL)进行比较。 然后我们在网络中用 SCL 替换 RBAM。 我们提出的 RBAM 在 SSIM 方面超过 SCL 0.0215,在 PSNR 方面超过 SCL 0.91 dB。 因此,消融结果意味着所提出的 RBAM 可以有效地提取显着特征并忽略退化特征。

Conclusions

在这项研究中,提出了一种使用扩张卷积和注意模块进行彩色图像去噪的多分支网络。 所提出的方法丰富了全局信息并消除了图像去噪过程中退化的特征。实验表明,与其他最先进的深度学习方法相比,所提出的方法获得了主观和客观上有希望的结果。特别是,经验证,所提出的方法可以有效抑制加性噪声并减少不需要的伪影。 目前,正在研究的方法同时应用其他图像恢复任务以获得高质量图像,并有望取得有希望的性能。

236

236

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?