训练方法

Anaconda训练

先裝好anaconda

创建3DGS的conda环境

conda env create --file environment.yml

在bashrc中加入cuda环境

export PATH=/usr/local/cuda-11.6/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda-11.6/lib64:$LD_LIBRARY_PATH

下载数据

按需下载 T&T+DB COLMAP (650MB) | Pre-trained Models (14 GB) | Viewers for Windows (60MB) | Evaluation Images (7 GB) 等数据。

T&T+DB COLMAP (650MB) :包含了4个场景的图片,并已经通过convert.py进行colmap转换。可以直接用来做train.py训练测试。

Pre-trained Models (14 GB):论文中提到的各种场景的预训练模型。可以通过viewer查看效果

Viewers for Windows (60MB):作者已经编译好的SIBR点云查看工具,不需要按照教程再编译。

Evaluation Images (7 GB) :这是项目训练过程中,同一批数据在不同的算法之下训练出来的场景数据对比图片。

colmap下载(如需使用自己的图片训练):可以从照片集合中进行三维重建,可以识别运动结构 (Structure-from-Motion, SfM)、也可以进行多视图立体 (Multi-View Stereo, MVS)构建。

ImageMagick下载(如需针对自己的图片进行裁剪)。

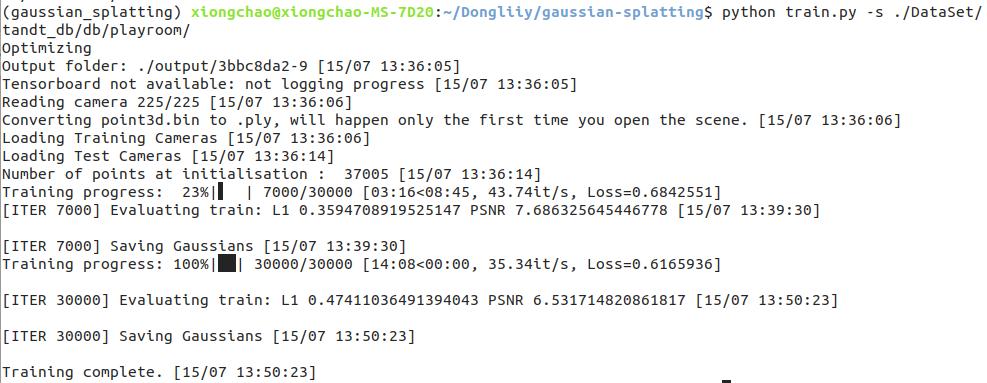

开始训练

使用刚才下载的T&T+DB COLMAP (650MB) 进行训练测试,验证环境是否正常。

运行以下代码

# 示例代码

python train.py -s <path to COLMAP or NeRF Synthetic dataset> --iterations #迭代次数

# 实际代码

python train.py -s ./DataSet/tandt_db/db/playroom/ --iterations 6000

注意:如果不指定输出目录,默认存储在项目根的output文件中

利用docker容器训练

dockerhub查看需要的镜像

拉取镜像

docker pull zzhopezhou/3dgs:1.1

创建容器

docker run -it --name 3dgs --gpus all -v /home/leador/Dongliiy:/home/leador/Dongliiy c627639e3920 /bin/bash

开始训练

运行以下代码

# 示例代码

python train.py -s <path to COLMAP or NeRF Synthetic dataset> --iterations #迭代次数

# 实际代码

python train.py -s ./DataSet/tandt_db/db/playroom/ --iterations 6000

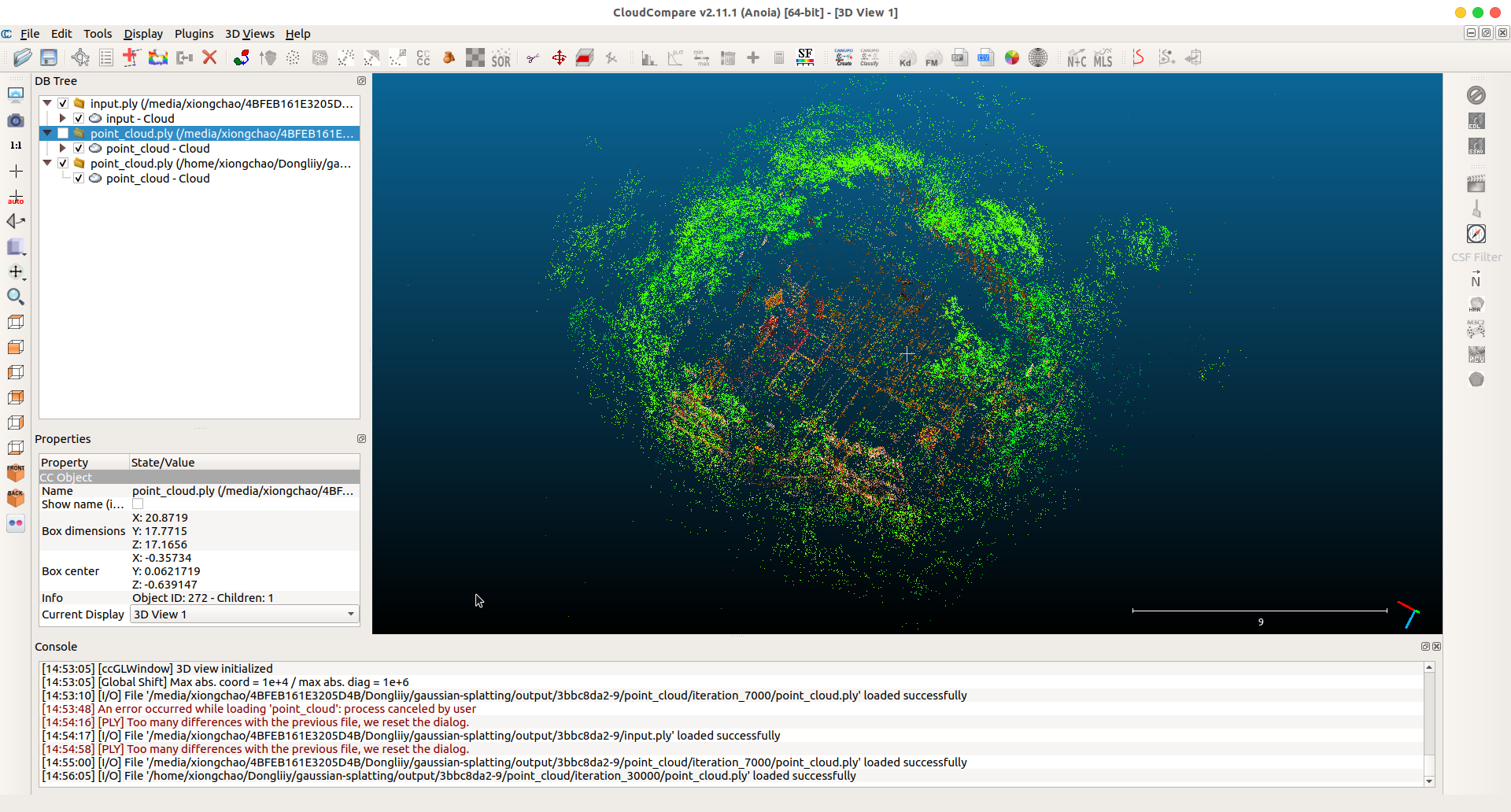

查看结果

Cloudcompare查看点云

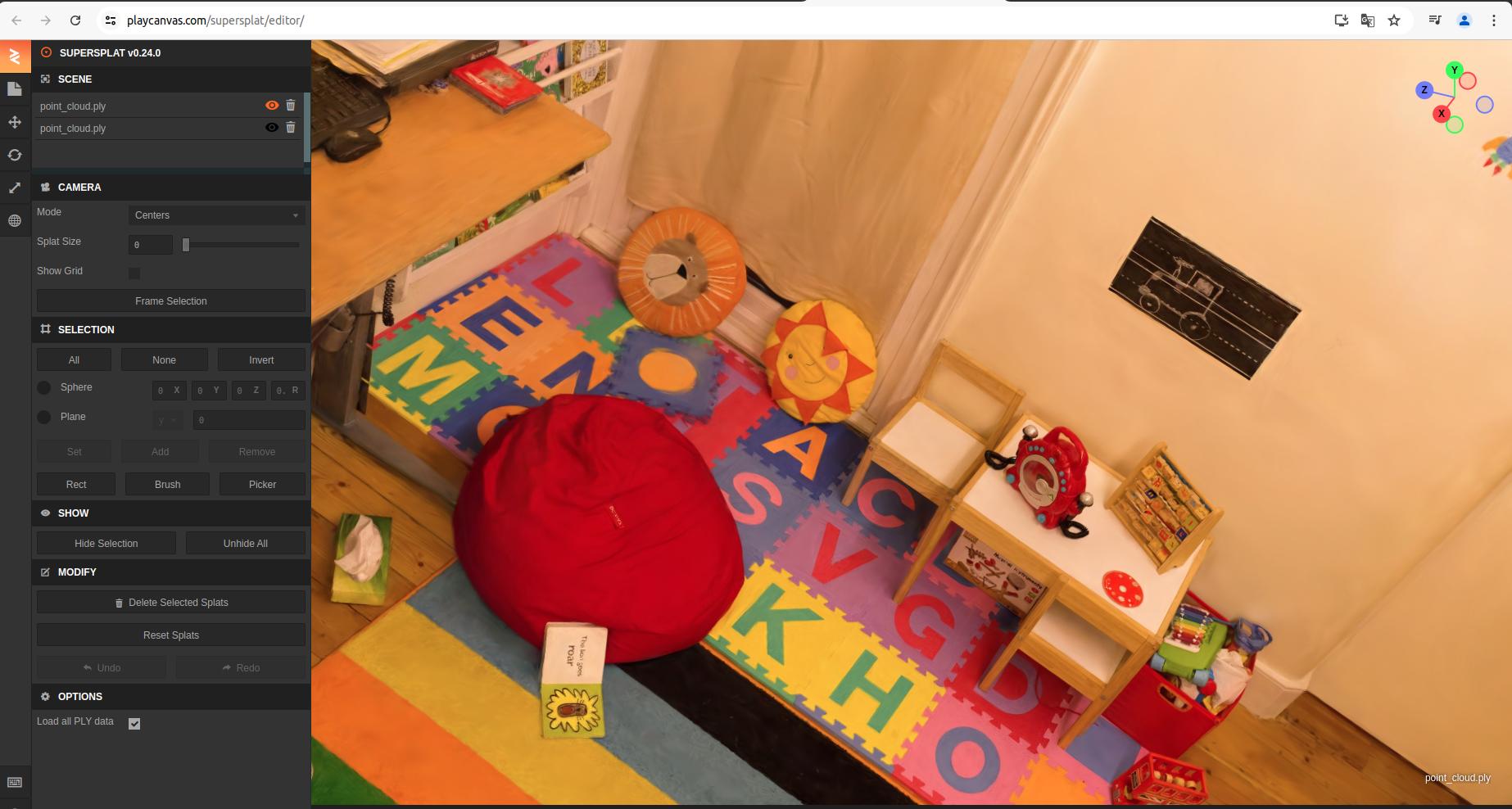

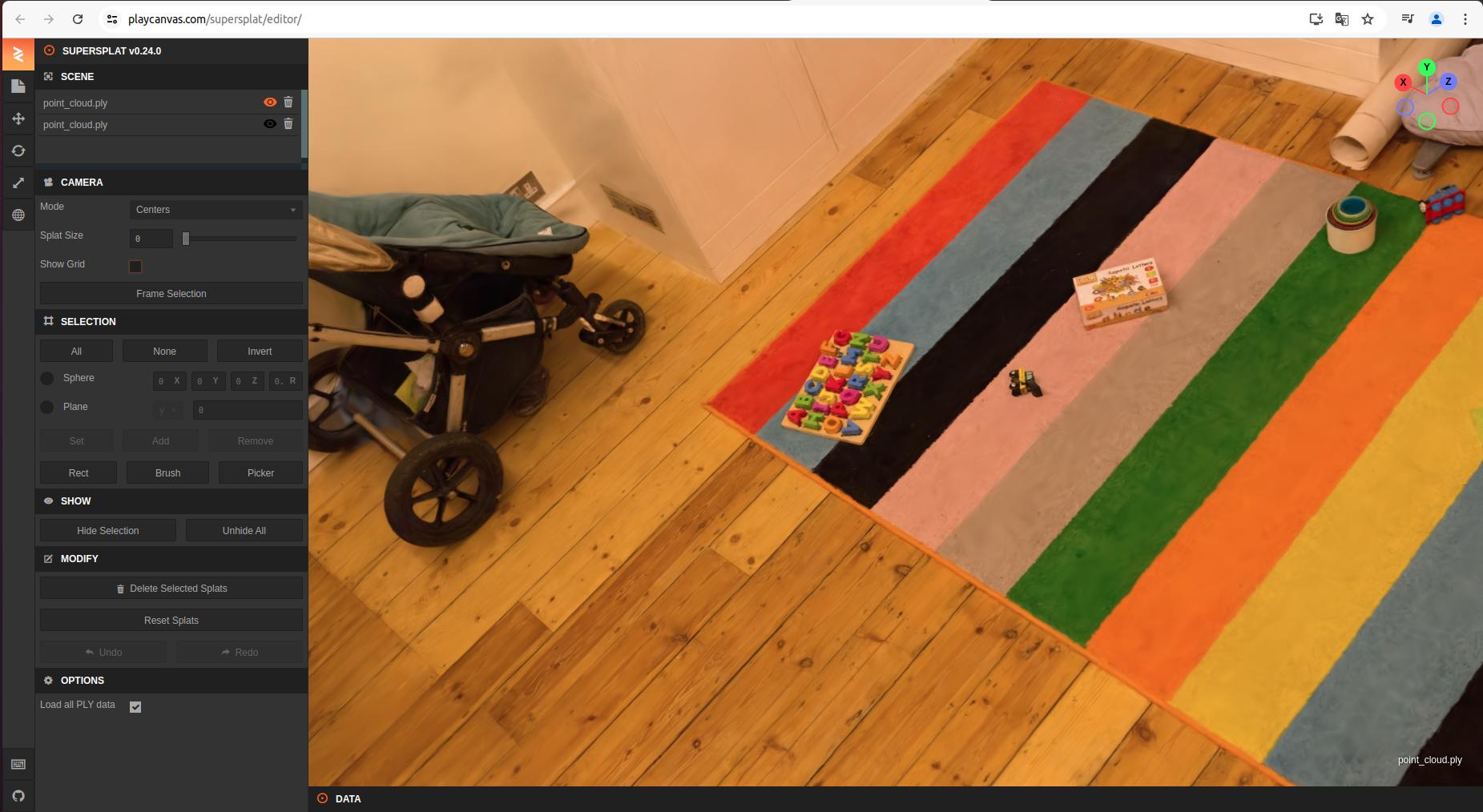

在线点云查看网站:

在线点云查看网站:

https://playcanvas.com/supersplat/editor/

565

565

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?