文章目录

数据集

ImageNet是一个庞大的、大规模的图像数据库,它包含超过100万个带有标注的图像,覆盖了超过1000个不同类别的物体,是计算机视觉领域中最受欢迎和广泛使用的数据集之一。

ImageNet数据集的目标是将物体识别推向更加挑战性的任务,以促进计算机视觉的发展。它的构建和维护由斯坦福大学的计算机科学家负责,是一个由专业标注员标注的大规模数据集,其中每个图像都被标注为属于1000个不同的物体类别之一。

ImageNet数据集的每个图像都被分类为属于1000个不同的类别之一,例如动物、交通工具、自然景观等。其中包含的图像涵盖了各种不同的视角、尺寸和颜色,以及各种不同的物体实例。ImageNet数据集的每个类别都至少有50个不同的图像,每个图像的分辨率为256x256像素或更高。

ImageNet数据集的目标是推动计算机视觉研究的发展,它已经成为深度学习算法的重要基准测试数据集之一,许多研究者使用ImageNet数据集进行算法训练和评估。此外,ImageNet数据集也推动了计算机视觉领域中的其他应用和技术的发展,例如目标检测、语义分割和图像生成等。

基础术语

epoch

**在深度学习中,一个epoch是指将整个训练集(training set)中的所有样本都在神经网络中训练一次的过程。**也就是说,将所有训练集中的数据送入神经网络中进行一次前向传播和反向传播,更新网络中的参数。

一个epoch通常包括多次迭代,每次迭代(iteration)是指将一个batch的数据送入神经网络进行前向传播和反向传播的过程。batch size是指每个迭代中训练集中选取的样本数量,通常的取值范围是几十到几百不等,根据实际情况进行选择。

训练深度神经网络需要进行多个epoch的迭代,每个epoch都是一个完整的训练周期,通过迭代不断更新网络参数,逐渐优化模型的性能。通常,我们会将训练集随机打乱,然后按照一定的比例划分为训练集、验证集和测试集,其中训练集用于训练模型,验证集用于调节模型的超参数(如学习率、正则化参数等),测试集用于评估模型的性能。

在实际训练中,一个epoch的时间往往较长,可能需要数小时或数天,而且过多的epoch会导致过拟合问题。因此,在训练深度神经网络时,需要根据具体问题进行合理的epoch数目选择,通常通过观察验证集的性能来判断是否应该停止训练。

batch

在深度学习中,**一个batch是指每次迭代中从训练集中随机抽取的一部分样本数据。**将训练集划分成一个个batch是为了更好地利用计算资源,例如在GPU上并行处理多个样本可以提高计算效率,加快训练速度。

batch size是指每个batch中包含的样本数量。通常,一个batch中的样本数可以在几十到几百之间取值,具体取值要根据数据集的大小、计算资源的限制和模型的结构等因素进行选择。

在训练过程中,每个batch都会被送入神经网络中进行前向传播和反向传播,根据反向传播计算得到的梯度来更新网络中的参数。然后,下一个batch的样本就会被送入网络中进行训练,如此往复,直到完成整个训练集的训练**。完成一轮对整个训练集的训练称为一个epoch。**通过多次迭代更新网络参数,不断优化网络的性能,从而得到最终的模型。

Normalization

在深度学习中,**Normalization(标准化或归一化)**指的是对输入数据或中间层输出数据进行处理,使其符合特定的分布或尺度。其目的是为了更好地进行训练和优化,防止梯度消失和梯度爆炸等问题,提高模型的鲁棒性和泛化能力。

在深度学习中,常见的Normalization方法包括以下几种:

Batch Normalization(批标准化):对每个mini-batch的输入进行标准化,使其均值为0,方差为1,可以加速训练和提高模型准确度。

Layer Normalization(层标准化):对每个神经元的输入进行标准化,使其均值为0,方差为1,可以提高模型的泛化能力。

Instance Normalization(实例标准化):对每个通道的数据进行标准化,使其均值为0,方差为1,主要应用于图像风格转换等领域。

Group Normalization(组标准化):对每个通道的数据进行标准化,将通道分组处理,可以提高模型的泛化能力。

这些Normalization方法都是为了在训练过程中减少内部协变量移位(Internal Covariate Shift)的影响,使得模型更容易收敛并提高准确度。其中Batch Normalization是最常用的一种,也被证明对于深度神经网络的训练具有很好的效果。

网络架构

深度学习中的网络架构通常是指由一系列层(layers)组成的神经网络模型结构。这些层可以是全连接层、卷积层、池化层、循环层等不同类型的层,它们可以被组合在一起形成不同的网络架构,例如前馈神经网络(feedforward neural network)、卷积神经网络(convolutional neural network)、循环神经网络(recurrent neural network)等。

在深度学习中,网络架构的设计非常重要,因为它直接影响着模型的性能和效率。一个好的网络架构应该具有足够的模型表达能力(model capacity),使其可以对数据中的复杂模式进行建模,同时还应该避免过拟合和提高模型的泛化能力(generalization)。

以下是一些常见的深度学习网络架构:

前馈神经网络(Feedforward Neural Network)

前馈神经网络是最基础的神经网络结构,它由一系列的全连接层(Dense layer)组成。每个层接收上一层的输出作为输入,并将其传递给下一层。前馈神经网络通常用于解决分类和回归问题。

卷积神经网络(Convolutional Neural Network)

卷积神经网络是一种用于处理具有网格结构的数据的神经网络结构,例如图像、声音、文本等。它由一系列卷积层、池化层和全连接层组成。卷积层可以学习提取输入数据中的空间特征,池化层可以对特征图进行下采样以减小维度,全连接层可以对特征进行分类或回归预测。

循环神经网络(Recurrent Neural Network)

循环神经网络是一种能够处理序列数据的神经网络结构,例如文本、音频等。它通过在时间上展开来处理序列数据,并使用循环层(Recurrent layer)来传递上一个时间步的输出到当前时间步的输入。循环神经网络可以学习序列数据中的时间依赖关系,通常用于语音识别、自然语言处理等任务。

深度残差网络(Deep Residual Network)

**深度残差网络是一种用于解决深度神经网络中梯度消失问题的神经网络结构。**它通过引入残差块(Residual block)来构建深度网络,使得网络的层数可以达到很深,而不会导致训练过程中的梯度消失。

参数

在神经网络中,参数Parameters是指用来控制神经网络的行为和输出的可调整量,也就是在神经网络中需要被学习的变量。这些参数通常由权重和偏置组成。

**权重(weights)**是指连接神经网络中不同节点之间的线条的权值,也就是每个输入节点到输出节点的连接强度。权重的值会根据网络的训练数据和损失函数不断进行调整,从而使网络能够更好地适应训练数据,达到更好的性能。

**偏置(bias)**是指每个神经元的偏移量,它是一个常数,用于将神经元的激活函数的输入值调整到适当的范围。与权重类似,偏置的值也会在网络的训练过程中不断进行调整,以使得网络的输出更加准确。

神经网络的参数数量通常非常庞大,特别是在深度学习中。因此,神经网络的训练通常需要大量的计算资源和时间。同时,精心调整网络的参数也是提高网络性能的重要手段之一。

神经元

在神经网络中,神经元(neurons)是构成神经网络的基本单元之一。每个神经元通常由三个部分组成:输入层,权重(weights)和激活函数(activation function)。

输入层接收来自其他神经元或外部数据的输入,每个输入都乘以对应的权重,这些权重反映了输入的相对重要性。神经元将所有加权的输入相加,形成一个加权和(weighted sum)。

激活函数将加权和转换为神经元的输出。激活函数通常是非线性的,以便神经元可以学习复杂的关系。常见的激活函数包括sigmoid、ReLU、tanh等。

神经元可以根据网络结构的不同,分为不同类型,例如全连接神经元、卷积神经元、循环神经元等。全连接神经元是最简单的神经元类型,每个输入都与该神经元的每个权重相乘。卷积神经元则具有权重共享和局部连接的特性,可以有效处理图像、语音等具有局部相关性的数据。循环神经元则可以处理序列数据,并具有记忆功能,可以记住之前的状态。

神经元在神经网络中扮演着重要的角色,其组合构成了神经网络。神经网络通过不断调整权重和激活函数的参数,可以学习输入与输出之间的映射关系,实现任务如分类、回归、生成等。

卷积层

卷积层(convolutional layers)是卷积神经网络(CNN)的核心组成部分之一,主要用于处理图像、语音等具有空间相关性的数据。

卷积层的输入通常是一个多通道的二维图像,比如RGB彩色图像,每个通道对应于不同的颜色通道。卷积层由多个卷积核(或称为滤波器,filters组成,每个卷积核都是一个小的二维矩阵,大小通常为3x3或5x5。卷积核通过滑动窗口的方式在输入图像上进行卷积操作,每次将卷积核的权重与输入图像对应位置的像素相乘,并将结果相加,得到一个卷积输出值。

卷积层通过多个卷积核并行处理输入图像,生成多个卷积输出图像,每个输出图像对应一个卷积核。这些卷积输出图像可以看作是对输入图像的不同特征提取结果,不同的卷积核可以提取出不同的特征,比如边缘、角点、纹理等。

卷积层还包括偏置(bias)和激活函数(activation function)两个重要的组件。偏置是一个常数项,用于控制每个卷积核的输出偏移。激活函数则通常是非线性的,以便卷积层可以学习非线性的特征。

在卷积层之后,通常会添加一个池化层(pooling layer),用于减少卷积输出图像的大小并且增加网络的不变性,常用的池化方式包括最大池化和平均池化。

卷积层的训练过程通常采用反向传播算法,通过梯度下降法来优化卷积核和偏置的权重参数,使其能够更好地提取输入数据的特征,从而提高神经网络的性能。

例子

假设我们要训练一个用于图像分类的卷积神经网络。网络的输入是一张大小为28x28的灰度图像。该神经网络包括两个卷积层和一个全连接层。

第一个卷积层有16个大小为5x5的卷积核,每个卷积核的步长(stride)为1,且使用ReLU作为激活函数。在输入图像上进行卷积操作后,每个卷积核都会生成一个大小为24x24的卷积输出图像。此外,该卷积层还包括一个大小为2x2的最大池化层,每个池化窗口的步长为2,将卷积输出图像的大小降为12x12,减少了网络的计算量。

第二个卷积层有32个大小为5x5的卷积核,每个卷积核的步长为1,且使用ReLU作为激活函数。在第一层的池化输出图像上进行卷积操作后,每个卷积核都会生成一个大小为8x8的卷积输出图像。此外,该卷积层还包括一个大小为2x2的最大池化层,每个池化窗口的步长为2,将卷积输出图像的大小降为4x4。

最后,将卷积输出图像展平为一个向量,并将其输入到一个全连接层中,该全连接层包括128个神经元和一个softmax激活函数,用于将输入图像分类为10个不同的类别。

在训练过程中,通过反向传播算法来优化卷积核和偏置的权重参数,使其能够更好地提取输入图像的特征,从而提高神经网络的分类性能。

池化(pooling)

在深度学习中,池化(Pooling)是一种用于减小卷积神经网络(CNN)中特征图(feature map)尺寸的常见操作。池化操作通常会应用于卷积层之后,以减少特征图的尺寸和参数数量,从而减少计算量和内存占用,防止过拟合。

池化操作可以分为最大池化(Max Pooling)和平均池化(Average Pooling)两种。

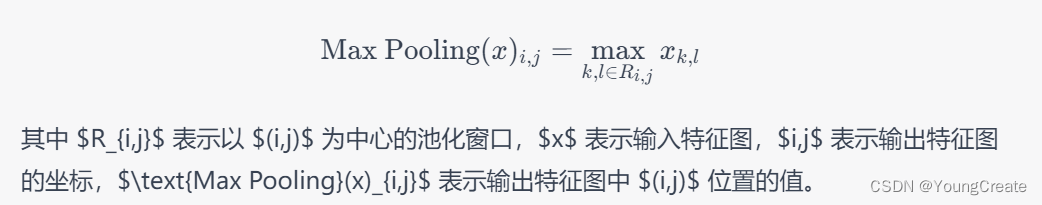

最大池化是从每个特征图的不重叠的子区域中选取最大值,将其作为下采样后的特征图的对应位置的值。最大池化的主要作用是保留特征图中的主要特征,同时减小特征图的尺寸。在最大池化过程中,因为只选择最大值,所以可以有效地减小噪声的影响。最大池化的公式如下:

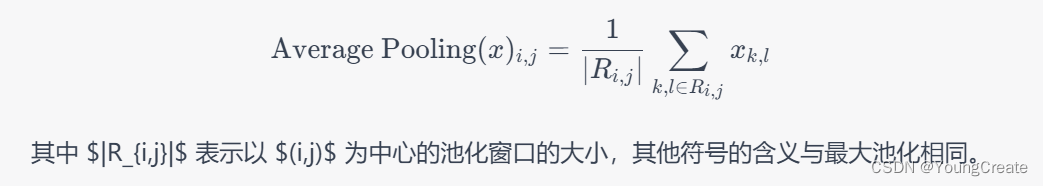

平均池化是从每个特征图的不重叠的子区域中取平均值,将其作为下采样后的特征图的对应位置的值。平均池化的主要作用是减小特征图的尺寸,同时可以减小特征图中的噪声和提高特征的稳定性。平均池化的公式如下:

平均池化是从每个特征图的不重叠的子区域中取平均值,将其作为下采样后的特征图的对应位置的值。平均池化的主要作用是减小特征图的尺寸,同时可以减小特征图中的噪声和提高特征的稳定性。平均池化的公式如下:

除了最大池化和平均池化,还有一些其他的池化方式,如 Lp 池化、随机池化(Random Pooling)等。这些池化方式可以根据不同的任务和数据集选择使用。池化操作在深度学习中扮演了重要的角色,可以帮助网络提取更加抽象的特征并提高网络的性能。

除了最大池化和平均池化,还有一些其他的池化方式,如 Lp 池化、随机池化(Random Pooling)等。这些池化方式可以根据不同的任务和数据集选择使用。池化操作在深度学习中扮演了重要的角色,可以帮助网络提取更加抽象的特征并提高网络的性能。

overlap

在深度学习中,overlap通常指的是卷积神经网络(Convolutional Neural Network, CNN)中的卷积操作中滑动窗口的重叠部分。

卷积神经网络是一种常用的深度学习算法,它广泛应用于图像识别、自然语言处理、语音识别等领域。卷积操作是CNN中最重要的组成部分之一,它通常用于图像或其他二维数据的处理。

卷积操作中的滑动窗口指的是在图像或数据上沿着两个方向(通常是水平和垂直)移动的固定大小的窗口。这个窗口可以是3x3、5x5或7x7等不同大小的矩阵。

在进行卷积操作时,滑动窗口通常以固定的步长进行移动,通常为1或2个像素。如果步长是1,窗口将在相邻的像素上移动;如果步长是2,窗口将在相隔一个像素的位置上移动。步长越大,图像尺寸就越小。

重叠部分指的是相邻滑动窗口之间的部分,通常称为卷积核的重叠部分。卷积核是一组固定的权重值,用于对图像或数据进行卷积运算。在卷积操作中,滑动窗口通过乘以卷积核中的权重值,并将结果相加,生成卷积后的输出。

通常情况下,重叠部分的大小是根据滑动窗口的大小和步长来决定的。如果步长是1,重叠部分通常是滑动窗口大小的一半;如果步长是2,重叠部分通常是滑动窗口大小的一半或更多。重叠部分的大小对于卷积操作的效果和速度都有影响。如果重叠部分太小,可能会丢失一些重要的信息;如果重叠部分太大,计算量会增加,从而导致卷积操作的速度变慢。

在卷积神经网络的训练中,通常可以通过调整滑动窗口大小、步长和重叠部分大小等超参数来控制卷积操作的效果和速度。

预处理

在深度学习中,预处理是指在模型训练之前对数据进行一系列的处理,以提高模型的准确性和训练速度。预处理通常包括以下几个方面:

数据清洗:对数据进行去重、去噪、去除异常值等处理,以确保数据的质量和准确性。数据清洗可以通过手动处理或使用各种工具和算法实现。

数据归一化:将数据转换为相同的尺度和范围,以消除不同特征之间的比例差异。常见的归一化方法包括Z-score归一化、Min-Max归一化等。

特征选择:从原始数据中选择最具代表性和重要性的特征,以减少数据维度和复杂性,并提高模型的效率和准确性。特征选择可以基于相关性分析、信息增益、主成分分析等方法实现。

特征提取:从原始数据中提取更高级别的特征表示,以捕捉数据的更复杂和抽象的结构。常见的特征提取方法包括卷积神经网络、循环神经网络、自编码器等。

数据增强:通过对原始数据进行旋转、平移、缩放、翻转等变换,生成更多的样本数据,以扩充数据集并减轻模型的过拟合。数据增强可以通过各种图像处理和数据增强技术实现。

数据划分:将原始数据划分为训练集、验证集和测试集,以评估模型的性能和泛化能力。通常情况下,训练集用于训练模型,验证集用于调整模型超参数,测试集用于评估模型性能。

预处理对于深度学习的成功至关重要,因为它可以使数据更加适合用于训练深度学习模型,并且可以提高模型的准确性和泛化能力。不同的数据预处理技术可以根据具体的数据类型、任务需求和模型结构进行选择和组合,以获得最佳的预处理效果。

数据增强

数据增强是一种常见的深度学习技术,用于增加训练数据集的数量和多样性,以提高模型的泛化能力和鲁棒性。数据增强的主要思想是通过对原始图像进行一系列变换来生成新的训练样本,这些变换包括旋转、平移、翻转、缩放、剪切、添加噪声等。

数据增强在深度学习中具有重要的作用,可以帮助模型更好地学习数据的不变性和特征,同时减轻过拟合的影响。以下是一些常用的数据增强方法:

随机翻转:将图像随机水平或垂直翻转,以增加数据集的多样性。

随机旋转:在一定角度范围内对图像进行随机旋转,以增加数据集的多样性。

随机剪切:在图像中随机剪切一块区域并将其放缩回原始大小,以增加数据集的多样性。

随机缩放:在一定比例范围内对图像进行随机缩放,以增加数据集的多样性。

随机添加噪声:向图像中添加随机噪声,例如高斯噪声或椒盐噪声,以增加数据集的多样性。

随机亮度和对比度调整:随机调整图像的亮度和对比度,以增加数据集的多样性。

随机颜色偏移:在一定范围内对图像的RGB颜色通道进行随机偏移,以增加数据集的多样性。

除了上述方法外,还有许多其他的数据增强技术,如随机扭曲、随机仿射变换、随机擦除等。选择哪些数据增强技术应该基于具体的任务和数据集进行评估。在训练深度学习模型时,数据增强可以有效地提高模型的性能和泛化能力,因此在实际应用中具有广泛的应用前景。

模型并行

在深度学习中,模型并行是一种将大型深度神经网络拆分成多个小型网络,并将它们分配到不同的设备(如多个GPU或多个计算节点)上进行训练的技术。模型并行可以大大减少单个设备上的内存消耗,提高训练速度和模型规模,以处理更大的数据和更复杂的任务。

模型并行主要分为两种类型:数据并行和模型并行。

数据并行:在数据并行中,训练数据被分成多个批次,并分配到不同的设备上进行处理。每个设备上的模型副本使用相同的参数,但对于不同的批次进行训练。在每个批次训练结束后,设备之间的参数被同步并更新。这种方法可以处理大量的训练数据,并且可以使用异构计算设备来处理更大的数据集和更复杂的模型。

模型并行:在模型并行中,深度神经网络被分割成多个子模型,并在不同的设备上训练。每个设备上的子模型负责处理整个模型的一个部分,并将结果传递给其他设备上的子模型。这种方法适用于大型模型,其中单个设备的内存无法容纳整个模型。

模型并行技术可以与其他深度学习技术结合使用,例如异步训练、模型蒸馏、优化器等,以提高模型的准确性和训练速度。然而,模型并行也存在一些挑战,例如设备之间的通信和同步开销、模型拆分的复杂性和性能瓶颈等,需要深度学习专家在实际应用中进行权衡和优化。

max-pooling

Max-pooling是深度学习中常用的一种池化操作,主要用于减少特征图(Feature Map)的大小和参数量,同时可以提取出特征图中最重要的特征。Max-pooling会在输入的特征图中以固定步幅滑动一个固定大小的窗口,对每个窗口内的数值取最大值作为输出。一般来说,max-pooling的窗口大小和步幅大小是相同的,常用的窗口大小为2x2或3x3。

Max-pooling有几个优点:

减少计算量和参数量:Max-pooling可以减少输入特征图的大小,降低计算量和参数量。

防止过拟合:Max-pooling可以减少输入特征图的维度,降低模型的复杂度,从而防止过拟合。

提取特征:Max-pooling可以保留输入特征图中最显著的特征,可以帮助模型更好地提取特征。

当然,也有一些缺点:

信息损失:Max-pooling会丢失部分信息,因为它只选择了每个窗口中最显著的数值作为输出,而舍弃了其它数值。

粗化特征:Max-pooling将特征图降低了尺寸,从而使得模型无法获取更为细节的信息,这可能会对某些任务造成影响。

总的来说,Max-pooling在深度学习中被广泛应用,并且被证明是一种非常有效的特征提取方法。

全连接层

全连接层(Fully Connected Layer),也称为线性层(Linear Layer),是神经网络中常用的一种层。它的输入是一个二维的张量,通常是一个大小为(batch_size, input_size)的张量,其中batch_size表示每个批次中的样本数,input_size表示输入特征的数量。

全连接层将输入张量与一个权重矩阵进行矩阵乘法,并加上一个偏置向量,然后通过一个激活函数进行非线性变换,最终输出一个二维的张量,通常是一个大小为(batch_size, output_size)的张量,其中output_size表示该层的输出特征数量。

具体地,全连接层的输出可以表示为:

output = activation_function(input @ weight + bias)

其中,input是输入张量,weight是权重矩阵,bias是偏置向量,@表示矩阵乘法运算,activation_function是激活函数。

在训练过程中,权重矩阵和偏置向量会被不断调整,以最小化损失函数。

全连接层(Fully Connected Layer),也被称为密集层(Dense Layer),是深度学习中最基本的层之一。

全连接层通常是神经网络的最后一层,它接收来自前一层的所有输入,并将其转换为一组输出。

在全连接层中,每个输入节点都连接到每个输出节点。具体来说,**全连接层将所有输入节点与所有输出节点连接起来,通过权重矩阵进行线性变换,并添加偏置项。**这个过程可以用以下公式表示:

y = Wx + b

其中,x表示输入向量,W表示权重矩阵,b表示偏置项,y表示输出向量。

全连接层的输出向量通常会经过激活函数,如ReLU、sigmoid或tanh等,以产生非线性的特征。全连接层的输出可以作为整个神经网络的预测结果,也可以作为下一个全连接层的输入。

全连接层的优点是可以学习到输入之间的复杂关系,并且可以适用于各种不同的输入数据类型,如图像、文本、语音等。但是,全连接层有很多参数,当输入数据很大时,参数的数量会非常庞大容易导致过拟合。此外,全连接层无法处理变长的输入,比如文本,因为输入的长度会影响参数数量。因此,在处理文本等变长输入时,需要使用一些特殊的层,如循环神经网络(Recurrent Neural Network)或卷积神经网络(Convolutional Neural Network)。

总之,全连接层是深度学习中最基本的层之一,可以学习到输入之间的复杂关系,但是需要注意参数数量和过拟合问题。

sequential模型

Sequential模型是Keras中最简单的一种模型类型,它是一个简单的线性堆栈模型,由一系列层按顺序排列而成。在Sequential模型中,每个层都是通过add()方法添加到模型中的,而且每个层只有一个输入张量和一个输出张量。Sequential模型的结构非常直观,适用于构建简单的神经网络,如前馈神经网络(Feedforward Neural Network)。

下面是一个简单的Sequential模型的例子,它由三个全连接层组成:

from keras.models import Sequential

from keras.layers import Dense

model = Sequential()

model.add(Dense(units=64, activation='relu', input_dim=100))

model.add(Dense(units=10, activation='softmax'))

model.add(Dense(units=1, activation='sigmoid'))

这个模型的输入是一个100维的向量,经过一个64维的全连接层和一个10维的全连接层之后,输出了一个1维的向量。

Sequential模型的主要优点是易于使用和快速搭建。但是,它的缺点是不能构建包含多个输入和多个输出的模型,也不能共享层(即同一个层可以被多次调用)。

在实际使用中,我们通常使用Sequential模型来构建简单的神经网络模型,如图像分类、文本分类等任务。如果模型的结构比较复杂,可以使用函数式API来构建模型。

SoftMax

softmax是一种常用的激活函数,用于多分类问题中。它的主要作用是将神经网络的输出转换为一个概率分布,以便于计算每个类别的概率。

softmax函数的定义如下:

softmax ( x i ) = e x i ∑ j = 1 k e x j , i = 1 , … , k \text{softmax}(x_i) = \frac{e^{x_i}}{\sum_{j=1}^{k} e^{x_j}},\quad i=1,\dots,k softmax(xi)=∑j=1kexjexi,i=1,…,k

其中, x i x_i xi表示网络输出中的第 i i i个元素, k k k表示类别数。softmax函数将每个元素的值映射到[0, 1]区间内,同时保证所有元素的和为1,因此可以看作是对原始输出的概率归一化。

在神经网络中,softmax函数通常作为最后一层的激活函数,用于多分类问题的输出在使用softmax函数时,需要将每个类别对应的输出的值作为输入,并通过softmax函数计算每个类别的概率值。最终,可以选择概率值最大的类别作为网络的预测结果。

下面是一个使用softmax函数的例子,假设我们有一个包含4个类别的分类问题,神经网络的输出是一个4维向量,分别表示4个类别的得分。我们可以将这个向量作为softmax函数的输入,得到每个类别的概率值,如下所示:

import numpy as np

# 假设网络输出为 [2.0, 1.0, 0.5, 1.5]

x = np.array([2.0, 1.0, 0.5, 1.5])

# 计算softmax概率

probabilities = np.exp(x) / np.sum(np.exp(x))

# 打印每个类别的概率

print(probabilities) # 输出 [0.4967462 0.13799052 0.05632275 0.30994053]

在使用Keras构建神经网络时,可以通过在层中设置activation参数为"softmax"来使用softmax激活函数,如下所示:

from keras.models import Sequential

from keras.layers import Dense

model = Sequential()

model.add(Dense(units=64, activation='relu', input_dim=100))

model.add(Dense(units=10, activation='softmax'))

在这个例子中,我们定义了一个包含两个全连接层的神经网络模型,第二个全连接层的激活函数设置为softmax。这个模型可以用于10分类问题,其中第二个全连接层的输出表示每个类别的概率。最终,可以选择概率值最大的类别作为模型的预测结果。

SVM

**SVM(Support Vector Machine,支持向量机)**是一种常用的监督学习算法,它可以用于分类和回归问题。SVM通过找到一个超平面来将不同的类别分开,使得在该超平面上距离最近的数据点到该超平面的距离最大化,这个距离被称为“间隔”(margin)。SVM可以用于解决线性可分和线性不可分的问题。

在SVM中,我们希望找到一个超平面,将不同类别的数据分开。如果数据是线性可分的,那么这个超平面就可以直接找到。如果数据不是线性可分的,那么可以使用核函数将数据映射到高维空间中,然后在高维空间中寻找一个超平面,使得在低维空间中的数据可以被分开。常用的核函数包括线性核函数、多项式核函数和高斯核函数等。

SVM的优点包括:

可用于解决线性和非线性问题

在高维空间中可以非常有效地进行分类

可以有效地处理具有大量特征的数据集

可以通过使用不同的核函数来适应不同的数据类型

SVM的缺点包括:

对于非常大的数据集来说,训练时间可能会比较长

对于噪声较多的数据集来说,容易过拟合

下面是一个使用Python和scikit-learn库实现SVM分类器的例子:

from sklearn import datasets

from sklearn import svm

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

iris = datasets.load_iris()

X = iris.data

y = iris.target

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=0)

# 训练SVM分类器

clf = svm.SVC(kernel='linear', C=1)

clf.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = clf.predict(X_test)

# 计算模型的准确率

accuracy = accuracy_score(y_test, y_pred)

print('Accuracy:', accuracy)

在这个例子中,我们使用了鸢尾花数据集进行分类任务。我们将数据集分为训练集和测试集,并使用SVM分类器对训练集进行训练。在测试集上进行预测,并计算模型的准确率。由于数据集较小,我们使用了线性核函数和C=1的超参数。如果需要处理更大的数据集,可以考虑使用非线性核函数和调整C的值来提高模型的性能。

有监督学习和无监督学习

有监督学习和无监督学习是机器学习中两个重要的概念。

有监督学习是指从带有标签的训练数据中学习出一个模型,然后使用这个模型对未知数据进行预测或分类。在有监督学习中,每个样本都有一个标签或类别,算法需要学习如何将输入和输出联系起来,以便于在未知数据上进行预测或分类。常见的有监督学习算法包括决策树、支持向量机、逻辑回归、神经网络等。

无监督学习是指从未标记的训练数据中学习出一个模型,然后使用这个模型对数据进行聚类或降维等操作。在无监督学习中,数据没有标签或类别,算法需要学习如何将相似的数据聚合在一起,或者如何将高维数据降维成低维数据。常见的无监督学习算法包括聚类、主成分分析(PCA)、自编码器等。

有监督学习和无监督学习之间的区别在于是否有标签或类别信息。有监督学习需要使用带有标签的数据进行训练,可以学习输入和输出之间的映射关系,以便在未知数据上进行预测或分类。无监督学习则不需要标签信息,可以通过学习数据之间的相似性和结构,进行聚类、降维等操作。

分类器

在实际应用中,有监督学习和无监督学习往往会结合使用。例如**,可以先使用无监督学习算法对数据进行聚类或降维,然后再使用有监督学习算法对处理后的数据进行分类或预测。这种结合使用的方法被称为半监督学习。同时,也有一些算法可以同时进行有监督学习和无监督学习,例如自编码器和生成对抗网络(GAN)。**

在深度学习中,分类器是一种用于将输入数据映射到一组离散输出标签的算法。它是训练好的神经网络的最后一层,用于将神经网络学到的特征映射到不同的类别标签。分类器在图像分类、语音识别、自然语言处理等领域中广泛使用,是深度学习模型的重要组成部分。

**分类器的训练目标是最小化误差或损失函数,以提高模型的准确性。**分类器的训练通常是通过监督学习来实现的,其中输入数据与其对应的输出标签被用作训练样本。在训练过程中,分类器通过反向传播算法和梯度下降优化算法来更新其权重和偏置参数,以使损失函数最小化。训练完成后,分类器可以用于对新数据进行分类预测。

常用的分类器包括逻辑回归、支持向量机、决策树、随机森林、朴素贝叶斯等。在深度学习中,常用的分类器包括softmax分类器和多层感知机分类器(MLP)。softmax分类器常用于多分类问题,它将神经网络的输出转化为概率分布,以便进行多分类预测。MLP分类器则使用多层神经网络来提取输入数据的高层次特征,并输出一个概率分布来预测不同类别的概率。

分类器的性能通常使用准确率、精确率、召回率和F1得分等指标进行评估。准确率是分类器正确分类样本的比例,精确率是指分类器正确预测为正类别的样本占预测为正类别的样本比例,召回率是指分类器正确预测为正类别的样本占实际为正类别的样本比例,F1得分是精确率和召回率的加权平均值。分类器的选择取决于问题的特征和需求,以及数据的规模和类型。

向量

在深度学习中,输入输出向量是指在训练过程中输入到神经网络的数据和神经网络输出的结果。输入向量通常是一组特征值,而输出向量则是预测的标签或者是一组连续值。

**这些向量的形成是通过数据预处理和特征提取过程来实现的。**在深度学习中,输入向量需要经过数据预处理,包括数据清洗、标准化、归一化、缩放等操作。接着,特征提取过程会将预处理后的数据转换为具有更高抽象层次的表示形式,以便神经网络更好地学习数据中的模式和规律。

在训练过程中,输入向量被输入到神经网络中,经过一系列的计算和变换后,最终输出一个输出向量,该向量表示了神经网络对输入数据的预测结果。这个过程通常被称为前向传播。

输出向量在深度学习中有着广泛的应用。例如,在图像分类问题中,输出向量通常表示不同的类别标签,用于对图像进行分类。在自然语言处理问题中,输出向量可以表示文本的情感极性、情感倾向等,用于情感分析和文本分类。在回归问题中,输出向量通常表示预测的连续值,如房价、股票价格等。

总之,输入输出向量在深度学习中扮演着至关重要的角色。**输入向量是训练数据的表示形式,而输出向量则是神经网络对数据的预测结果。**深度学习中的优秀的输入输出向量的选择和处理,可以提高神经网络的训练效果和预测准确性。

import numpy as np

# 输入数据

input_data = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 数据预处理

mean = np.mean(input_data)

std = np.std(input_data)

input_data = (input_data - mean) / std

# 特征提取

hidden_layer = np.dot(input_data, np.array([[1, 0, 0], [0, 1, 0], [0, 0, 1]]))

# 输出数据

output_data = np.array([0, 1, 2])

print("输入数据:")

print(input_data)

print("特征提取结果:")

print(hidden_layer)

print("输出数据:")

print(output_data)

训练集,测试集,验证集

在深度学习中,通常将数据集分为三个部分:训练集、验证集和测试集。下面是对这三种数据集的详细介绍:

训练集

**训练集是用于训练模型的数据集。**深度学习模型通常依靠大量的数据进行训练,以便从数据中学习特征并进行预测。训练集通常是数据集中的一部分,可以是整个数据集的80%或70%,甚至更少。训练集的目的是让模型学习数据中的模式和规律,以便更好地进行预测。

验证集

验证集是用于评估模型性能的数据集。验证集通常是训练集中划分出来的一部分数据,它的大小通常是整个数据集的10%或20%。在训练过程中,模型将使用训练集进行训练,并使用验证集评估模型的性能。这个过程被称为交叉验证。

验证集的主要目的是用于调整模型的超参数,例如学习率、正则化参数、激活函数等。通过不断地调整这些超参数,我们可以找到一个最优的模型,以便在测试集上获得最佳的预测结果。

测试集

测试集是用于最终评估模型性能的数据集。测试集通常是数据集中剩余的部分,通常占整个数据集的10%或20%。测试集在模型训练完成之后使用,以便对模型进行最终的评估。**测试集的主要目的是检查模型是否能够在新数据上进行准确的预测。**我们应该尽量避免在训练和验证过程中使用测试集。

总之,训练集、验证集和测试集在深度学习中都非常重要。训练集用于训练模型,验证集用于调整模型的超参数,测试集用于最终评估模型的性能。合理地划分这三种数据集可以提高模型的泛化能力和预测准确率。

假设我们有一个包含1000个图像和标签的数据集。我们希望将其划分为训练集、验证集和测试集,分别为80%、10%和10%。

import numpy as np

from sklearn.model_selection import train_test_split

# 加载数据

X = np.load("images.npy")

y = np.load("labels.npy")

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_test, y_test, test_size=0.5, random_state=42)

# 输出数据集大小

print("训练集大小:", X_train.shape[0])

print("验证集大小:", X_val.shape[0])

print("测试集大小:", X_test.shape[0])

在这个示例中,我们使用了NumPy库加载图像和标签数据,并使用sklearn库中的train_test_split()函数将数据集划分为训练集、验证集和测试集。我们将整个数据集划分为80%的训练集和20%的测试集,然后将测试集划分为50%的验证集和50%的测试集。最后,我们输出了每个数据集的大小。

过拟合

**过拟合(Overfitting)是指模型在训练集上表现良好,但在测试集或新数据上表现较差的现象。**过拟合是深度学习中最常见的问题之一,其主要原因是模型过于复杂或数据量不足,导致模型在训练集上过度拟合了噪声和细节,而无法很好地泛化到新数据。

过拟合的主要表现是模型在训练集上的误差较小,但在测试集上的误差较大。此外,当模型的复杂度增加时,过拟合的风险也会增加。

以下是一些常用的解决过拟合问题的方法:

增加数据量:通过增加数据量来减少模型的过拟合问题,因为更多的数据可以帮助模型学习更多的特征,从而更好地泛化到新数据。

数据增强(Data Augmentation):通过对训练数据进行旋转、翻转、缩放等变换,增加数据集的多样性,从而减少过拟合的风险。

减少模型复杂度:通过减少模型的复杂度来避免过拟合,例如减少神经元数量、缩小网络结构等。

正则化(Regularization):通过在损失函数中添加正则化项来惩罚模型的复杂度,从而减少过拟合的风险。L1正则化和L2正则化是常用的正则化方法。

**Dropout:**在训练过程中,以一定的概率随机丢弃神经元,从而减少模型复杂度,避免神经元之间的相互适应,从而减少过拟合的风险。

Early Stopping:在训练过程中,根据验证集的表现来决定何时停止训练,以避免过度拟合。

from keras.models import Sequential

from keras.layers import Dense, Dropout

from keras.regularizers import l1_l2

# 定义一个带有正则化和dropout的神经网络模型

model = Sequential()

model.add(Dense(64, input_shape=(784,), activation='relu', kernel_regularizer=l1_l2(l1=0.01, l2=0.01)))

model.add(Dropout(0.5))

model.add(Dense(10, activation='softmax'))

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, batch_size=128, epochs=10, validation_data=(x_val, y_val))

# 在测试集上测试模型

score = model.evaluate(x_test, y_test, verbose=0)

print('Test loss:', score[0])

print('Test accuracy:', score[1])

在上述代码中,我们使用了L1和L2正则化来惩罚模型的复杂度,并使用dropout来减少模型复杂度。通过这些技术,我们可以在训练集和测试集上获得更好的性能,从而避免过拟合的风险。

正则化

深度学习中的正则化是一种用来减小模型过拟合的技术。在模型过拟合时,模型在训练集上表现很好,但在测试集上表现较差,这是由于模型在训练集上学习了噪声或者局部的特征,而这些特征并不具有泛化能力。

正则化是通过在模型损失函数中添加额外的惩罚项来减少模型的复杂度。常用的正则化方法包括L1正则化和L2正则化。

L1正则化是指将模型的权重向量中的每个元素的绝对值加和作为惩罚项,即:

L 1 r e g u l a r i z a t i o n : λ ∑ i = 1 n ∣ w i ∣ L1\ regularization:\ \lambda\sum_{i=1}^{n}|w_i| L1 regularization: λi=1∑n∣wi∣

其中, λ \lambda λ是正则化强度, w i w_i wi是模型的权重。

L2正则化是指将模型的权重向量中每个元素的平方加和作为惩罚项,即:

L 2 r e g u l a r i z a t i o n : λ ∑ i = 1 n w i 2 L2\ regularization:\ \lambda\sum_{i=1}^{n}w_i^2 L2 regularization: λi=1∑nwi2

在深度学习中,我们通常使用L2正则化,因为它相对于L1正则化更易于优化。

在Keras中,我们可以使用kernel_regularizer参数来指定正则化方法和正则化强度。下面是一个例子:

from keras.models import Sequential

from keras.layers import Dense

from keras.regularizers import l2

model = Sequential()

model.add(Dense(64, input_dim=784, activation='relu', kernel_regularizer=l2(0.01)))

model.add(Dense(10, activation='softmax'))

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

在上述代码中,我们使用了L2正则化,并将正则化强度设置为0.01。这将对模型的权重进行L2正则化惩罚,从而减小过拟合风险。

激活函数

ReLU(Rectified Linear Unit)是一种常用的激活函数,其数学表达式为 f ( x ) = max ( 0 , x ) f(x)=\max(0,x) f(x)=max(0,x)。ReLU函数将输入信号 x x x 直接输出,当 x x x 大于等于0时,输出值与输入值相等;当 x x x 小于0时,输出值为0。

ReLU函数有以下几个特点:

非线性:ReLU函数是非线性的,因此可以处理非线性问题;

稀疏性:当输入为负数时,ReLU函数的输出为0,这种稀疏性有助于提高模型的泛化能力;

计算简单:ReLU函数的计算非常简单,只需要比较输入值和0即可。

ReLU函数在深度学习中广泛应用,特别是在卷积神经网络中。ReLU函数的非线性特性可以使神经网络拟合非常复杂的函数关系,同时,它的计算简单、速度快也使得神经网络的训练更加高效。

虽然ReLU函数在实际应用中表现优异,但是它也存在一些问题,比如当输入为负数时,ReLU函数的导数为0,这就导致了一些梯度消失的问题。为了解决这个问题,后续出现了一些改进的版本,比如LeakyReLU、PReLU、ELU等。

tanh(双曲正切)和sigmoid函数是深度学习中常用的激活函数。

tanh函数的数学表达式为 f ( x ) = e x − e − x e x + e − x f(x) = \frac{e^{x} - e^{-x}}{e^{x} + e^{-x}} f(x)=ex+e−xex−e−x,它的取值范围为[-1, 1],函数曲线关于原点对称。与sigmoid函数相比,tanh函数的导数在0处取值更大,因此在神经网络中使用tanh激活函数时,其表现力更强,能够学习更复杂的函数关系。

sigmoid函数的数学表达式为 f ( x ) = 1 1 + e − x f(x) = \frac{1}{1+e^{-x}} f(x)=1+e−x1,它的取值范围为(0,1),函数曲线在x=0处取值最大,往两端逐渐趋近于0和1。sigmoid函数常用于二分类问题,因为它的输出可以表示为一个概率值,而且可以对输出概率进行直观的解释。

在深度学习中,tanh和sigmoid函数在某些情况下仍然被广泛使用,但是由于它们在极值处的梯度接近于0,会导致梯度消失的问题,因此后来出现了一些改进的版本,如ReLU、LeakyReLU等激活函数。但是,在某些任务中,仍然可以使用tanh和sigmoid函数来实现较好的效果。

ResNet

ResNet(Residual Network)是一种深度神经网络结构,由微软亚洲研究院(Microsoft Research Asia)的研究员Kaiming He等人在2015年提出。ResNet是一种解决深度神经网络中梯度消失问题的方法,通过使用残差连接(residual connection)来构建深层网络。

在传统的深层神经网络中,每个层都是通过将输入映射到输出来构建的,即 y = f ( x ) y=f(x) y=f(x),其中 x x x 是输入, y y y 是输出, f f f 是层的函数。在ResNet中,每个层都由残差块(residual block)组成,每个残差块包含两个或三个卷积层和一个残差连接。

残差连接将输入信号 x x x 直接添加到输出信号 y y y 中,产生残差信号 r = x − y r=x-y r=x−y,将残差信号加到输出信号中,即 y = f ( x ) + r y=f(x)+r y=f(x)+r。这种残差连接使得模型可以学习到原始输入的映射,同时学习到残差信号,从而避免了梯度消失问题。

ResNet的架构非常灵活,可以根据任务的不同自由组合残差块。其中最有名的是ResNet50,它包含了50个卷积层和一个全连接层。在ImageNet数据集上,ResNet50的准确率达到了当时最先进的水平。此后,各种变体的ResNet也被广泛应用于计算机视觉、自然语言处理和语音识别等领域,成为深度学习中重要的基础模型之一。

from tensorflow.keras import layers, models

def identity_block(X, f, filters):

# 定义残差块

F1, F2, F3 = filters

X_shortcut = X

X = layers.Conv2D(F1, (1, 1), padding='same')(X)

X = layers.BatchNormalization()(X)

X = layers.Activation('relu')(X)

X = layers.Conv2D(F2, (f, f), padding='same')(X)

X = layers.BatchNormalization()(X)

X = layers.Activation('relu')(X)

X = layers.Conv2D(F3, (1, 1), padding='same')(X)

X = layers.BatchNormalization()(X)

X = layers.add([X, X_shortcut])

X = layers.Activation('relu')(X)

return X

def conv_block(X, f, filters, s=2):

# 定义带有下采样的残差块

F1, F2, F3 = filters

X_shortcut = X

X = layers.Conv2D(F1, (1, 1), strides=(s, s), padding='same')(X)

X = layers.BatchNormalization()(X)

X = layers.Activation('relu')(X)

X = layers.Conv2D(F2, (f, f), padding='same')(X)

X = layers.BatchNormalization()(X)

X = layers.Activation('relu')(X)

X = layers.Conv2D(F3, (1, 1), padding='same')(X)

X = layers.BatchNormalization()(X)

X_shortcut = layers.Conv2D(F3, (1, 1), strides=(s, s), padding='same')(X_shortcut)

X_shortcut = layers.BatchNormalization()(X_shortcut)

X = layers.add([X, X_shortcut])

X = layers.Activation('relu')(X)

return X

def ResNet50(input_shape=(224, 224, 3), classes=1000):

# 定义ResNet50模型

X_input = layers.Input(input_shape)

X = layers.ZeroPadding2D((3, 3))(X_input)

X = layers.Conv2D(64, (7, 7), strides=(2, 2))(X)

X = layers.BatchNormalization()(X)

X = layers.Activation('relu')(X)

X = layers.MaxPooling2D((3, 3), strides=(2, 2))(X)

X = conv_block(X, f=3, filters=[64, 64, 256], s=1)

X = identity_block(X, 3, [64, 64, 256])

X = identity_block(X, 3, [64, 64, 256])

X = conv_block(X, f=3, filters=[128, 128, 512], s=2)

X = identity_block(X, 3, [128, 128, 512])

X = identity_block(X, 3, [128, 128, 512])

X = identity_block(X, 3, [128, 128, 512])

X = conv_block(X, f=3, filters=[256, 256, 1024], s=2)

X = identity_block(X, 3, [256, 256,1024])

X = identity_block(X, 3, [256, 256, 1024])

X = identity_block(X, 3, [256, 256, 1024])

X = identity_block(X, 3, [256, 256, 1024])

X = identity_block(X, 3, [256, 256, 1024])

X = conv_block(X, f=3, filters=[512, 512, 2048], s=2)

X = identity_block(X, 3, [512, 512, 2048])

X = identity_block(X, 3, [512, 512, 2048])

X = layers.AveragePooling2D((2, 2))(X)

X = layers.Flatten()(X)

X = layers.Dense(classes, activation='softmax')(X)

model = models.Model(inputs=X_input, outputs=X, name='ResNet50')

return model

以上代码定义了一个包含50个层的ResNet模型,其中包含了残差块和卷积块,

以及一个全连接层用于分类。这个模型可以用于图像分类任务。

PCA

PCA(Principal Component Analysis,主成分分析)是一种常见的无监督学习方法,可以用于降维和数据压缩。PCA旨在找到数据的主要变化方向,并将数据转换为与这些主要方向正交的新坐标系。这些新坐标称为主成分。

在进行PCA时,首先需要对数据进行中心化,即将每个特征的均值减去整个数据集中的均值。接下来,通过计算协方差矩阵来找到数据的主要变化方向。协方差矩阵是一个对称矩阵,描述不同特征之间的相关性。PCA的目标是找到协方差矩阵的特征向量(也称为主成分),这些特征向量与协方差矩阵相乘可以得到数据在新坐标系中的投影。

PCA中的主要思想是将数据沿着最大的方差方向进行投影,以尽可能地保留原始数据的信息。这通常意味着保留前k个主成分,其中k是要保留的新坐标系中的维数。PCA的另一个优点是,它可以通过选择保留的主成分的数量来控制数据的压缩程度。

一些应用PCA的例子包括图像压缩、语音识别、遥感图像处理、金融风险管理、基因组学数据分析等领域。PCA是一种强大而通用的数据分析工具,可以用于处理各种类型的数据

DropOut

**Dropout是一种常见的正则化技术,**用于防止深度神经网络的过拟合。Dropout的主要思想是在网络的训练过程中,随机丢弃一部分神经元,以使模型更加鲁棒和泛化。具体而言,Dropout是通过将一些神经元的输出置为0来实现的,从而减少相互依赖的神经元,强制模型学习更加鲁棒和泛化的特征。

在实践中,Dropout通常应用于全连接层和卷积层之间,其过程如下:

随机选择一些神经元,将它们的输出置为0,这个过程可以看作是一种“删除”。

在这个“删除”的神经元组成的子网络上进行前向和反向传播,计算梯度和更新权重。

恢复被“删除”的神经元,重复以上步骤。

在实际应用中,Dropout的概率通常设为0.2-0.5之间,取决于数据集的大小和复杂性**。使用Dropout时,通常需要增加训练迭代次数,以便模型可以在被“删除”的神经元子网络上进行更多的训练。**

使用Dropout有助于减轻深度神经网络的过拟合,提高模型的泛化能力和鲁棒性。此外,Dropout可以被看作是一种模型集成的技术,因为每个“删除”的神经元子网络都可以看作是模型空间中的一个不同的模型,使用Dropout可以有效地减少模型的方差和提高模型的鲁棒性。在实践中,Dropout是一种非常有效的正则化技术,被广泛应用于深度学习领域。

Weight decay

Weight decay是一种常见的正则化技术,用于减少深度神经网络的过拟合。在深度学习中,模型的参数通常使用梯度下降法进行优化,而Weight decay则是在优化过程中通过添加一项权重惩罚项来限制模型的参数,从而达到正则化的目的。具体而言,Weight decay的想法是通过惩罚较大的权重来降低模型的复杂度,从而减少模型的过拟合。

在实践中,Weight decay通常通过在模型的损失函数中添加一个L2正则化项来实现。L2正则化项是指将所有权重的平方和乘以一个系数λ,然后将其添加到损失函数中。这个系数λ通常需要手动调整,以平衡正则化和训练数据的拟合程度。

在优化过程中,Weight decay的惩罚项会对权重梯度进行修改,从而降低权重的大小。这个过程可以被看作是一个“弹簧”的作用,当权重变大时,惩罚项会对梯度进行惩罚,使权重逐渐减小。因此,Weight decay可以被看作是一种对权重的“缩小”操作,它可以有效地减少模型的方差和提高模型的泛化能力。

总的来说,Weight decay是一种非常有效的正则化技术,**可以有效地减少深度神经网络的过拟合问题,提高模型的泛化能力和鲁棒性。**在实践中,Weight decay通常与其他正则化技术如Dropout一起使用,以进一步提高模型的性能和稳定性。

SGD,GNN

SGD(Stochastic Gradient Descent)和GNN(Graph Neural Network)是深度学习中常用的两种技术,分别用于优化和图神经网络的建模。下面分别对它们进行详细介绍。

SGD

SGD是深度学习中最常见的优化算法之一。它的基本思想是通过不断地迭代,从而找到使损失函数最小化的模型参数。在每次迭代中,SGD会从训练集中随机选择一个小批量的样本进行训练,然后根据这个小批量样本计算梯度,并用梯度来更新模型参数。

具体而言,SGD可以描述为以下步骤:

随机选取一批样本

根据这批样本计算损失函数的梯度

使用梯度来更新模型参数

重复以上步骤,直到满足停止条件

在实际应用中,SGD还有一些改进的算法,如动量SGD、AdaGrad、Adam等,这些算法通常可以加速SGD的收敛速度和提高模型的泛化能力。

import torch

import torch.nn as nn

import torch.optim as optim

# 定义一个简单的神经网络模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.fc1 = nn.Linear(784, 256)

self.fc2 = nn.Linear(256, 10)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 定义训练函数

def train(model, optimizer, criterion, train_loader, num_epochs):

for epoch in range(num_epochs):

running_loss = 0.0

for i, data in enumerate(train_loader, 0):

inputs, labels = data

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

print('Epoch %d, loss: %.3f' % (epoch+1, running_loss/len(train_loader)))

# 加载数据集

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True)

# 定义模型、损失函数和优化器

model = Net()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.001, momentum=0.9)

# 训练模型

train(model, optimizer, criterion, train_loader, num_epochs=10)

在这段代码中,我们首先定义了一个简单的神经网络模型Net,然后定义了训练函数train,该函数使用SGD优化器来更新模型参数。最后,我们加载了训练数据集,并调用train函数进行训练。

GNN

GNN是一种用于处理图数据的神经网络模型。与传统的深度学习模型不同,**GNN考虑了节点之间的连接关系,**从而能够有效地处理图数据中的结构信息。GNN通常是由多个图卷积层组成的,其中每个图卷积层都可以被看作是一个基于邻接矩阵的卷积操作。

具体而言,GNN可以描述为以下步骤:

输入一个图,其中节点表示对象,边表示它们之间的关系。

将每个节点的特征向量作为输入,通过多个图卷积层进行信息传递和特征抽取。

在每个图卷积层中,节点的特征向量会被更新,同时考虑了节点和它们的邻居节点之间的信息传递。

最后,将输出层的特征向量用于任务的预测或分类。

GNN已被广泛应用于社交网络分析、推荐系统、计算机视觉等领域,并取得了一定的成功。近年来,GNN的研究方向也不断扩展,如图注意力机制、动态图神经网络等,这些进展为GNN在更广泛的应用场景中的应用提供了更多可能性。

import dgl

import torch

import torch.nn as nn

import torch.optim as optim

from dgl.data import CoraGraphDataset

# 加载Cora数据集

dataset = CoraGraphDataset()

g = dataset[0]

# 定义一个简单的GNN模型

import torch

import torch.nn.functional as F

from torch_geometric.datasets import Planetoid

from torch_geometric.nn import GCNConv

# 加载Cora数据集

dataset = Planetoid(root='data/Cora', name='Cora')

data = dataset[0]

# 定义GCN模型

class GCN(torch.nn.Module):

def __init__(self, in_channels, hidden_channels, out_channels):

super(GCN, self).__init__()

self.conv1 = GCNConv(in_channels, hidden_channels)

self.conv2 = GCNConv(hidden_channels, out_channels)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, p=0.5, training=self.training)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)

# 定义训练函数

def train(model, optimizer, data):

model.train()

optimizer.zero_grad()

out = model(data.x, data.edge_index)

loss = F.nll_loss(out[data.train_mask], data.y[data.train_mask])

loss.backward()

optimizer.step()

return loss.item()

# 定义测试函数

def test(model, data):

model.eval()

logits, accs = model(data.x, data.edge_index), []

for _, mask in data('train_mask', 'val_mask', 'test_mask'):

pred = logits[mask].max(1)[1]

acc = pred.eq(data.y[mask]).sum().item() / mask.sum().item()

accs.append(acc)

return accs

# 定义模型、优化器和训练参数

model = GCN(dataset.num_node_features, 16, dataset.num_classes)

optimizer = torch.optim.Adam(model.parameters(), lr=0.01, weight_decay=5e-4)

num_epochs = 200

# 训练模型

for epoch in range(num_epochs):

loss = train(model, optimizer, data)

train_acc, val_acc, test_acc = test(model, data)

print(f'Epoch: {epoch+1:03d}, Loss: {loss:.4f}, Train: {train_acc:.4f}, Val: {val_acc:.4f}, Test: {test_acc:.4f}')

在这段代码中,我们首先加载了Cora数据集,并定义了一个基于GCN的图分类模型GCN。接着,我们定义了训练函数train和测试函数test,分别用于训练模型和测试模型在训练集、验证集和测试集上的分类准确率。最后,我们定义了模型、优化器和训练参数,并在训练集上训练模型,每个epoch输出训练损失和分类准确率。

shallow,残差(residual)

在深度学习网络中,shallow(浅层)通常指的是网络层数比较少、比较浅的网络结构。在神经网络中,每层都会将输入数据进行一些特征变换,通过一系列非线性变换,将输入数据转化为更高级别的特征表示。网络层数越多,就意味着对输入数据进行的特征变换次数越多,从而可以捕捉到更复杂的特征,提高网络的表征能力。

相比而言,浅层网络层数较少,特征变换次数较少,可能会导致网络表征能力不足,难以学习到复杂的特征和模式。但是,在某些场景下,浅层网络也可以取得很好的效果,比如针对某些简单任务或数据集,或者是为了减小模型复杂度和计算量等考虑。

需要注意的是,shallow并不是一个严格的概念,它的定义很大程度上取决于具体的网络结构和任务场景。例如,在某些领域中,两层或三层的网络就被称为shallow,而在其他领域中,需要更多的层数才能满足任务需求。因此,在设计和选择深度学习模型时,需要根据具体的任务场景和数据特点来综合考虑网络深度、宽度、层间连接等因素,以获得最佳的模型性能。

在深度学习中,residual(残差)通常指的是通过跳过一些层或者跨越一些层来构建的“shortcut”或“skip connection”。Residual connections是由He等人提出的,**旨在解决深度神经网络中的梯度消失和梯度爆炸问题。**其主要思想是将输入和输出进行相加,将浅层的特征与深层的特征结合起来,从而避免了梯度在传递过程中的损失,使得深度神经网络更容易训练和优化。

例如,在ResNet(Residual Network)中,每个基本块都包含一个shortcut,用于跳过一些层或者跨越一些层。具体地,对于一层网络,假设输入为x,输出为H(x),则ResNet的shortcut可以写成:

Shortcut(x) = H(x) - x

通过这种方式,ResNet可以很容易地进行网络加深,同时还能保证网络的表现力和效率。在实践中,residual connections已经成为了构建深度神经网络的一种重要方法,被广泛应用于图像识别、自然语言处理等领域。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?