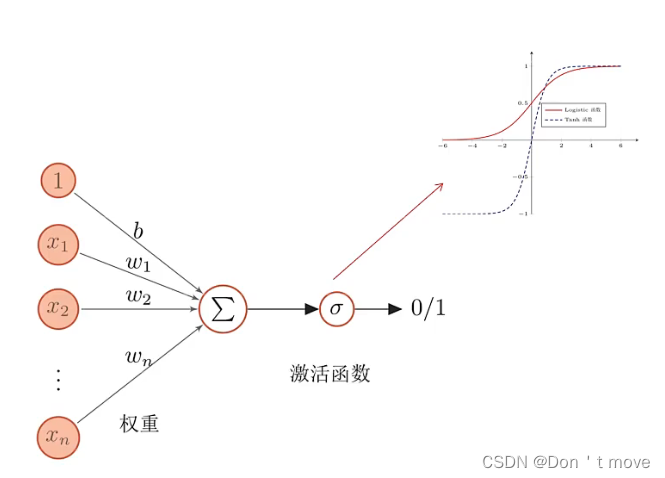

人工神经元

如上图表示对多个神经元接受的信号进行加权求和,结果通过激活函数计算得到一个值,通过设置阈值来表示对应的具体含义(比如大于0.5表示神经元兴奋、小于表明神经元不兴奋)

人工神经网络

大量人工神经元以及它们之间的有向连接构成人工神经网络,这种许多神经元组成的信息处理网络具有并行分布结构。对人工神经网络主要考虑:

- 神经元激活规则:神经元输入输出间的映射关系(即激活函数的考虑,一般为非线性函数)

- 网络拓扑结构:不同神经元之间的连接关系

- 学习算法:通过训练数据来学习神经网络的参数(比如机器学习中的梯度下降过程)

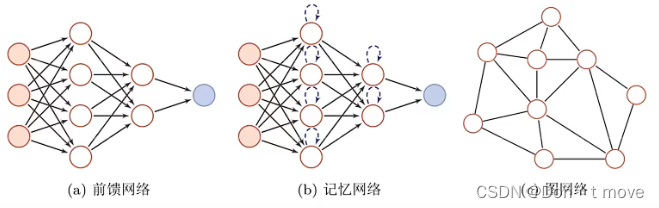

人工神经网络基本结构分为三类:

- 前馈网络:网络中的信息从前向后单向传递

- 记忆网络:网络中存在反馈,神经元在不同时刻有不同状态/记忆

- 图网络:网络结构由一个额外的图来确定,连接更加灵活,更具一般性

大多数的人工神经网络都是三者的复合结构

一个前馈深度学习神经网络的数学描述示例

x x x代表输入层, f 1 f^1 f1、 f 2 f^2 f2为隐藏层, f 3 f^3 f3为输出层(分类器),其中隐藏层是表示学习,输出层为浅层学习,这是一个端到端的前馈深度学习

用神经网络贡献度分配问题

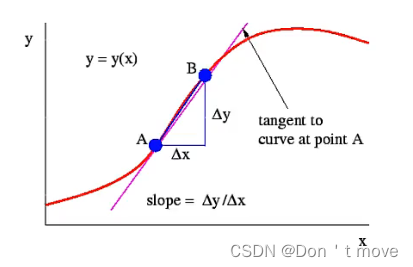

偏导数:对于函数 y = f ( x ) y=f(x) y=f(x),偏导数表示当 x x x发生变化时,对y的影响大小。从几何上看,即函数在任意点的斜率

对 x x x做扰动( Δ x \Delta{x} Δx)后看 y y y的变化( Δ y \Delta{y} Δy),表示 x x x对 y y y的影响有多大

贡献度

∂

y

∂

W

(

l

)

=

y

(

W

(

l

)

+

Δ

W

)

−

y

(

W

(

l

)

)

Δ

W

\frac{\partial{y}}{\partial{W^{(l)}}}=\frac{y(W^{(l)}+\Delta{W})-y(W^{(l)})}{\Delta{W}}

∂W(l)∂y=ΔWy(W(l)+ΔW)−y(W(l))

其中

y

y

y表示神经网络的输出,

W

(

l

)

W^{(l)}

W(l)表示第

l

l

l层的参数,后面是偏导数,对

W

W

W做扰动(

Δ

W

\Delta{W}

ΔW)后

y

y

y的变化(

y

(

W

(

l

)

+

Δ

W

)

−

y

(

W

(

l

)

)

y(W^{(l)}+\Delta{W})-y(W^{(l)})

y(W(l)+ΔW)−y(W(l)))

通过计算每一层结果对最终结果的贡献度,可以最终确定每个层的贡献度分配

1469

1469

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?