一、背景

针对经典的组合优化的调度模型,动态柔性作业车间调度问题(DFJSP),提出一种多目标的求解方法。以最小化延期率和最小化机器总负荷作为目标函数。以随机机器故障、新工件插入作为动态随机事件。以改进的DQN作为求解算法,设计一种两阶段的DDQN算法求解多目标问题。

二、相关研究领域所用方法或模型

论文:Efficient Multi-Objective Optimization on Dynamic Flexible Job Shop Scheduling Using Deep Reinforcement Learning Approach

目标函数:最小化延期时间、最小化makespan

模型:多目标柔性作业车间调度模型

算法:双层DDQN

State(5种):

1、机器的最大完成时间

2、工件的最大完成时间

3、机器的平均利用率

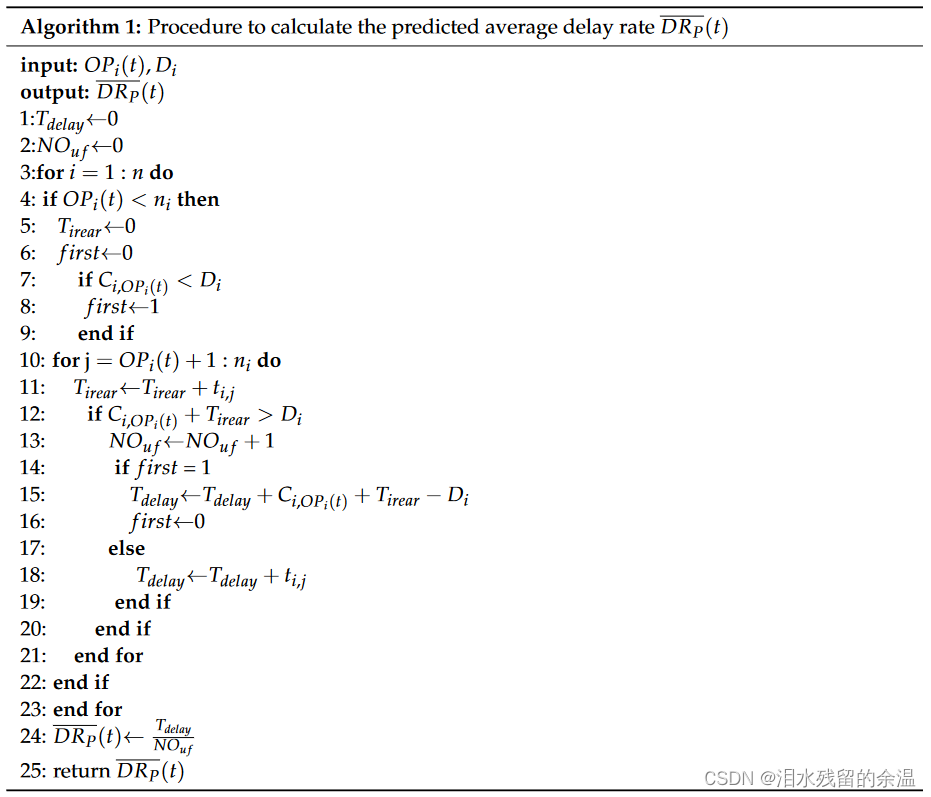

4、未完成加工的工件的预期平均延期率

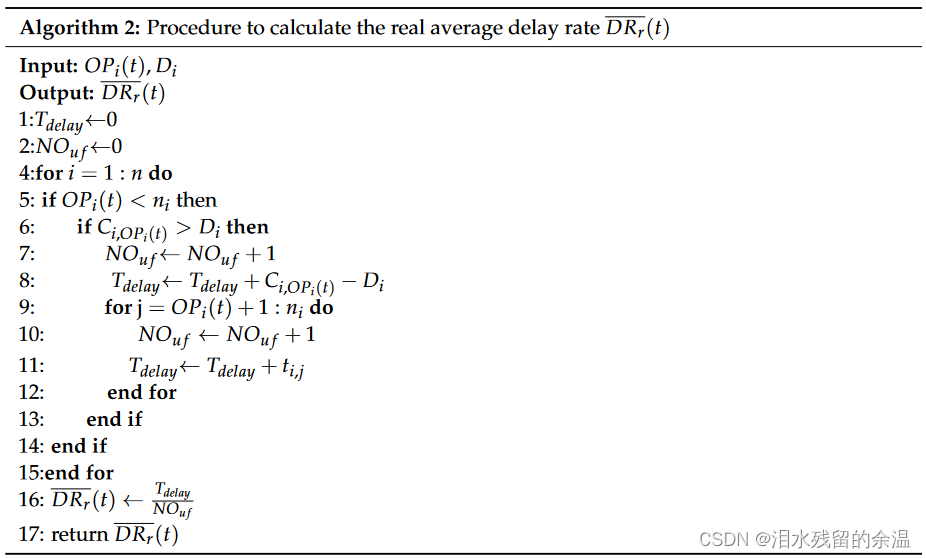

5、未完成加工工件的实际平均延期率

Action(7种):

Reward(6种):

其余参数:

论文:Dynamic multi-objective scheduling for flexible job shop by deep reinforcement learning

目标函数:最小化总加权延期、最大化平均机器利用率

模型:多目标柔性作业车间调度模型

算法:双层DDQN

State(7种):

1、机器的平均利用率

2、机器利用率的标准偏差

3、总工序的完工率

4、工件的平均完工率

5、工件完工率的标准偏差

6、预估延期率

7、实际延期率

Action(6种):

Reward(4种):

算法流程:

三、模型构建及算法建立

目标函数:最小化延期时间、最大化机器利用率

模型:多目标柔性作业车间调度模型

算法:两阶段DDQN

State(7种):

1、机器的平均利用率

2、机器利用率的标准偏差

3、工件的完工率

4、工件完工率的标准偏差

5、预估延期率

6、实际延期率

7、每个工件工序的完工率的平均值

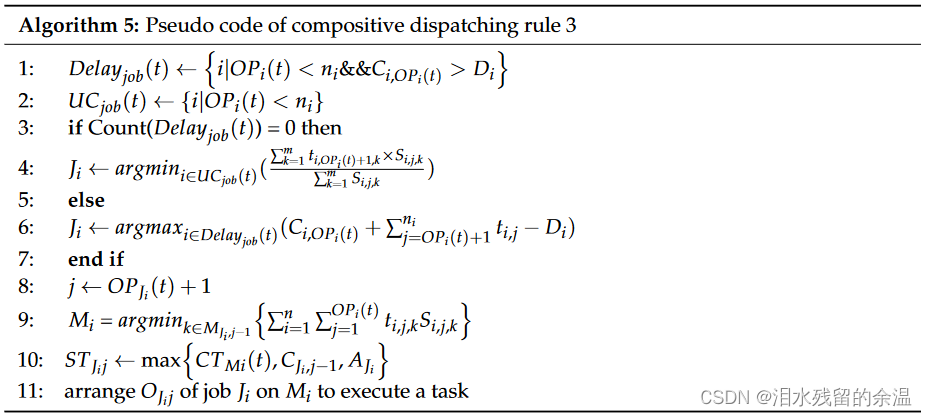

Action(6种):

Reward(4种):

本文探讨了使用改进的DQN算法解决动态柔性作业车间调度问题,提出了一种两阶段DDQN方法,目标是同时最小化延期率和机器总负荷,考虑了随机事件影响。模型包括机器利用率、工件完成情况和延期率等状态,以及多种动作策略和奖励机制。

本文探讨了使用改进的DQN算法解决动态柔性作业车间调度问题,提出了一种两阶段DDQN方法,目标是同时最小化延期率和机器总负荷,考虑了随机事件影响。模型包括机器利用率、工件完成情况和延期率等状态,以及多种动作策略和奖励机制。

1081

1081

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?