深度学习

多层神经网络的劣势:数学不漂亮,优化算法只能获取局部极值,算法性能与初始值有关。不可解释。训练神经网络获得的参数与实际任务的关联性非常模糊。模型可调整的参数很多,使得训练神经网络变成了一门“艺术”。如果要训练相对复杂的网络,需要大量的训练样本。

自编码器

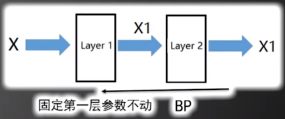

采用的是分层初始化的思想

步骤1:先训练这个网络:

假设:X的维度是4维,第一层有3个神经元

通过第一层Layer1后4维变成3维,而这三维数据通过后面一层能够大致恢复原有的四维数据X,这三维数据浓缩了原有的四维数据信息

我们可以通过后向传播算法训练这个神经网络。

步骤2:训练好第一层后,接着训练第二层

步骤M:以此类推,训练好第M-1层后,接着训练第M层

最后用BP对网络进行微调,大概率找到了局部最小值

基于LENET的卷积神经网络(CNN)

卷积核从左上到右下以步长为1在图像上滑动,每滑到一个位置,将卷积核与该位置重合的数值相乘然后在相加得到一个数,将得到的数排列起来就得到一个28*28*1的特征图。

这6个卷积核的参数是待定的,我们可以通过后向传播算法进行更新

求解卷积核参数的梯度

以上式子等价与权值共享网络

假设目标函数为E,那么通过链式求导法则我们可以算出

卷积神经网络中的降采样层

我们通过卷积层C1后,得到了6个28*28的特征图,接着我们将这些特征图通过C2降采样层获得6个14*14的特征图。

在leanft中降采样层采用取平均值的方式,即把相邻四个像素的值取平均后获得。这种方式叫平均降采样。

以步长(2,2)进行降采样,28*28的特征图变成14*14的特征图

对降采样层进行梯度的后向传播

来到卷积层C3,再次用16个5*5的卷积核对三层14*14*6的特征图进行卷积运算,获得16个10*10的特征图,再次通过降采样层获得16个5*5的特征图

全连接层C5将16个5*5的特征图展开成400个像素作为一个整体向量输入近全连接层,C5中有120个神经元,所以它的输出是一个120维度的向量,接下来另一个全连接层F6对C5的输出进行操作,F6有84个神经元,因此输出84个维度的向量

LENET是识别0~9数字,因此有10个类别,所以最后输出层是10个维度,最后输出层也是全连接层,这10个维度的输出用SOFTMAX+CROSS ENTROPY的目标函数

层与层之间都有非线性函数连接,可以采用SIGMOID或者TANH作为连接层与层的非线性函数

计算LENET带估计的参数个数

第一层(C1):5*5*6=150

第二层(S2):0

第三层(C3):5*5*6*16=2400

第四层(S4):0

第五层(C5):(5*5*16+1)*120=48120

第六层(F6):(120+1)*84=10164

第六层(输出层):(84+1)*10=850

将7层参数个数相加,可以得到LENET中总共有61684个待估计参数

6206

6206

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?