在不断发展的计算机视觉领域,姿态估计作为一项关键创新脱颖而出,改变了我们理解视觉数据以及与视觉数据交互的方式。 Ultralytics YOLOv8 处于这一转变的最前沿,提供了一个强大的工具来捕捉图像中物体方向和运动的微妙之处。

NSDT工具推荐: Three.js AI纹理开发包 - YOLO合成数据生成器 - GLTF/GLB在线编辑 - 3D模型格式在线转换 - 可编程3D场景编辑器 - REVIT导出3D模型插件 - 3D模型语义搜索引擎

传统上,跟踪图像中对象的关键点非常复杂,但使用 YOLOv8,它变得无缝且直观。 这一进步不仅令人兴奋,而且还为各个领域开辟了一个充满可能性的世界,其中包括体育分析、医疗保健和零售等。

在本文中,我们将探索使用 YOLOv8 进行姿态估计的过程。 我们将介绍以下内容:

- 使用 CVAT 进行姿势估计的数据标注:我们首先将数据集上传到 CVAT 平台,配置工具,标注关键点,然后导出数据。

- 转换 Ultralytics YOLOv8 的标注:标注后,我们将数据转换为与 YOLOv8 兼容的格式,确保我们的模型可以正确解释它。

- 数据分割:构建数据至关重要,因此我们将其分为训练集、验证集和测试集,以促进有效的模型训练。

- 训练 YOLOv8 模型进行姿势估计:组织好数据后,我们将训练 YOLOv8 模型来识别和估计姿势。

- 使用 YOLOv8 进行推理:最后,我们将使用经过训练的模型对新数据进行姿势估计,看看我们努力的结果。 你还可以浏览我们关于使用 Ultralytics YOLOv8 进行姿势估计的 YouTube 视频 。

让我们开始吧🚀

1、使用 CVAT 标注姿态数据

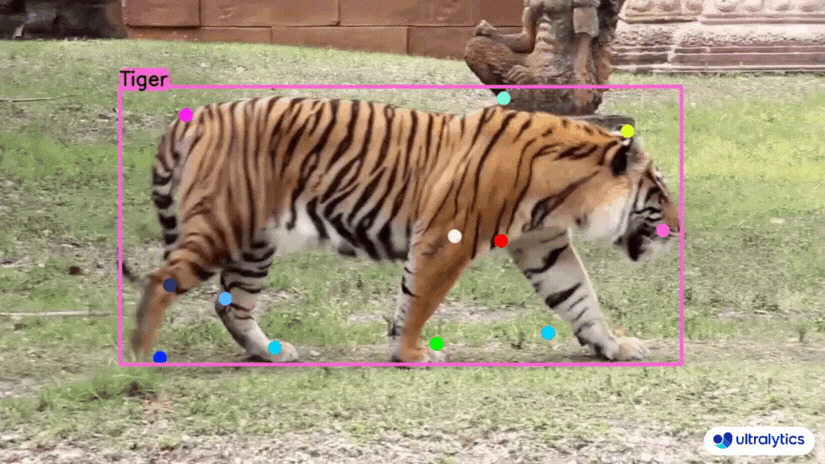

数据标注过程在计算机视觉领域至关重要。 我们将在本教程中使用老虎数据集来演示如何准确注释关键点,这是训练姿势估计模型的重要步骤。

图 1.2:Ultralytics Tiger-Pose 数据集

注意: Ultralytics Tiger-Pose数据集可以从这里下载并解压缩,为即将到来的任务做好准备。 这些图像将作为我们训练过程的基础,因此请确保它们存储方便。

如果你是 CVAT 新手,值得花时间查看 CVAT 文档来熟悉其功能。 这将为更加简化的标注过程提供基础。

1.1 上传数据集

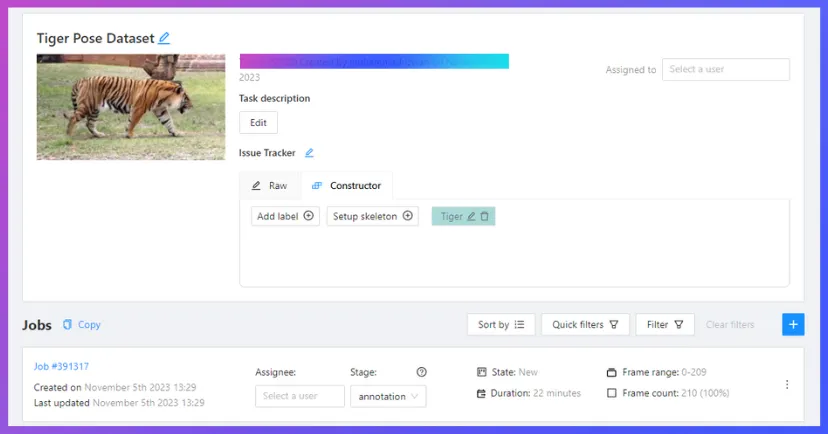

下载Tiger-Pose图像后,请务必解压缩文件。 接下来,将所有图像作为新任务上传到 CVAT 平台,然后单击“提交并打开”。

完成后,你将被引导至如下所示的页面:

图1.3:Ultralytics Tiger-pose 数据集上传

1.2 设置标注工具 CVAT

在 CVAT 中打开任务后,系统会提示你选择一个特定作业,该作业将作为你的标注工作区。 每个用户的作业编号(例如此处提到的“作业#391317”)都会有所不同。 这将引导你进入标注界面,其中设置将完成,你可以开始标记数据。

图 1.4:使用 CVAT 的 Ultralytics YOLOv8 Tiger-pose 数据集标注工作流程

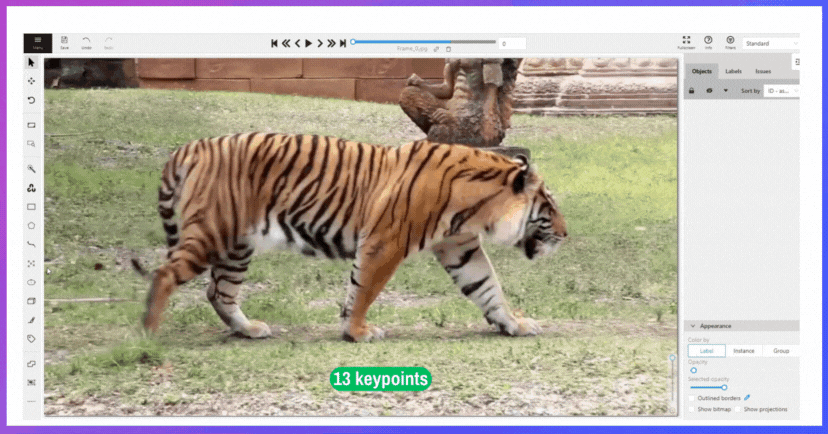

1.3 数据标注

使用 CVAT,你可以选择使用不同的格式进行标注。 对于Tiger-Pose数据集,我们将利用点标注来标记关键点。 该过程在教程中提供的详细 gif 中进行了可视化,指导你完成标注的每个步骤:

图 1.5:使用 CVAT 的 Ultralytics Tiger-pose 数据标注过程

1.4 数据导出

完成标注后,可以使用“CVAT for images 1:1”格式导出数据集,该格式适合稍后在工作流程中转换为 YOLOv8 格式。

2、将标注转换为YOLOv8 格式

从 CVAT 导出标注后,你将收到一个 zip 文件。 解压该文件以显示 annotations.xml文件,其中包含你分配的关键点和标签。 该文件至关重要,因为它包含 YOLOv8 将学习的结构化数据。

要将其与 YOLOv8 集成,请将annotations.xml文件放入与图像数据集相同的目录中。 如果你需要重新下载数据集,可以从 Ultralytics Tiger-Pose 数据集获取。 确保下载后解压缩文件,为下一步做好准备。

现在,创建一个名为 cvat_to_ultralytics_yolov8.py的 Python 脚本。 将提供的代码复制到这个新文件中。 运行此脚本会将你的标注转换为 YOLOv8 格式,为训练模型奠定基础:

import ast

import os.path

from xml.dom import minidom

out_dir = './out'

if not os.path.exists(out_dir):

os.makedirs(out_dir)

file = minidom.parse('annotations.xml')

images = file.getElementsByTagName('image')

for image in images:

width = int(image.getAttribute('width'))

height = int(image.getAttribute('height'))

name = image.getAttribute('name')

elem = image.getElementsByTagName('points')

bbox = image.getElementsByTagName('box')[0]

xtl = int(float(bbox.getAttribute('xtl')))

ytl = int(float(bbox.getAttribute('ytl')))

xbr = int(float(bbox.getAttribute('xbr')))

ybr = int(float(bbox.getAttribute('ybr')))

w = xbr - xtl

h = ybr - ytl

label_file = open(os.path.join(out_dir, name + '.txt'), 'w')

for e in elem:

label_file.write('0 {} {} {} {} '.format(

str((xtl + (w / 2)) / width),

str((ytl + (h / 2)) / height),

str(w / width),

str(h / height)))

points = e.attributes['points']

points = points.value.split(';')

points_ = []

for p in points:

p = p.split(',')

p1, p2 = p

points_.append([int(float(p1)), int(float(p2))])

for p_, p in enumerate(points_):

label_file.write('{} {}'.format(p[0] / width, p[1] / height))

if p_ < len(points_) - 1:

label_file.write(' ')

else:

label_file.write('\n')运行脚本后,删除 annotations.xml以避免后续步骤中出现任何潜在的混乱。

3、数据分割

对数据集进行标注和转换后,下一步是将图像和标注组织成不同的集合以进行训练和评估。

- 在项目中创建两个目录:一个名为

images,另一个名为labels。 - 将图像及其相应的标注文件分别分发到这些文件夹中。

- 为了促进此数据分割过程,请创建一个名为

splitdata.py的 Python 文件。 - 将提供的代码复制并粘贴到

splitdata.py文件中。 - 通过运行该文件来执行 Python 脚本

此过程可确保你的数据被适当地划分为训练和测试子集,为 Ultralytics YOLOv8 训练做好准备。

import splitfolders

input_fol_path = "path to folder, that includes images and labels folder"

splitfolders.ratio(input_fold_path, output="output",

seed=1337, ratio=(.8, .2, .0), group_prefix=None, move=False)结果将是一个包含两个不同目录的输出文件夹: train和 test。 这些文件夹已准备好在 YOLOv8 训练过程中使用。

4、训练 YOLOv8 模型进行姿势估计

下一阶段涉及制作一个 data.yaml文件,该文件充当 YOLOv8 的路线图,将其定向到你的数据集并定义训练类。 将必要的代码插入 data.yaml,自定义数据集目录的路径。

请根据需要调整数据集目录路径。 配置 data.yaml后,就可以开始训练模型了。

path: "path to the dataset directory"

train: train

val: val

kpt_shape: [12, 2]

flip_idx: [0,1,2,3,4,5,6,7,8,9,10,11]

names:

0: tiger一旦完成,就可以开始了! 你可以使用提供的命令来启动 YOLOv8 模型的训练以进行老虎姿势估计。

yolo task=pose mode=train data="path/data.yaml" model=yolov8n.pt imgsz=640训练持续时间会有所不同,并且取决于你拥有的 GPU 设备。

5、使用 YOLOv8 进行推理

训练后,通过对新数据进行推理来测试你的模型。 运行提供的命令以应用姿势估计模型来检测和分析姿势。

# Run inference using a tiger-pose trained model

yolo task=pose mode=predict \

source="https://www.youtube.com/watch?v=MIBAT6BGE6U" \

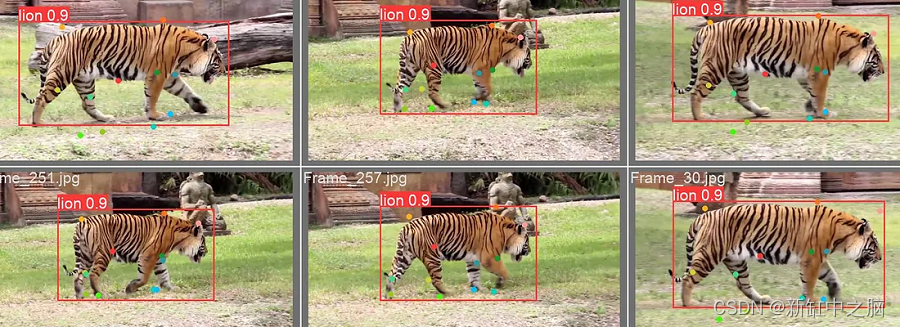

show=True model="path/to/best.pt"下图显示推理结果,展示了模型将所学知识应用到现实场景的能力:

图 1.7:使用 Tiger-Pose 估计模型估计老虎姿势

6305

6305

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?