在过去的两年里,人工智能(AI)领域见证了大型语言模型(LLM)的前所未有的探索和进步。LLM已经逐步发展到处理越来越复杂的任务,如编程和解决高级数学问题。

OpenAI o1的发布标志着大型语言模型(LLM)开发的重要里程碑,展示了令人印象深刻的功能。这一突破突出了扩展思想链(CoT)和强化学习以提高LLM性能的潜力。o1模型大大超越了以前LLM的推理能力,达到了与博士水平相当的性能。其卓越的推理成就标志着人类进入了通用人工智能(AGI) 的新时代。

本文将盘点几个具有代表性的类o1工作:包括OpenAI o1、来自阿里巴巴团队的QwQ、QVQ、Marco-o1、和Deepseek团队的R1、以及智谱团队的GLM-Zero、还有增强LLaVA性能的LLaVA-CoT,以及面向医学大模型的Huatuo-o1、来自微信团队的DRT-o1等

因为很多模型都只发布了线上版,而没有公布技术细节,所以部分模型只介绍其性能

目录

-

基本原理

思维链

与人类在回答一个难题之前可能会思考很长时间类似,o1 在尝试解决问题时也会使用一连串的思维。

思维链(Chain of Thought, CoT)是一种帮助人工智能模型进行推理的技术。其核心思想是通过让模型在回答复杂问题时,逐步解释每一步的推理过程,而不是直接给出答案。这种方法类似于人类在解决问题时的思考方式,即先分析问题的各个部分,逐步构建逻辑链条,最终得出结论。

在AI模型中,思维链的实现通常涉及以下几个步骤:

-

问题分解:首先,模型需要将复杂问题分解为更小、更易于处理的部分。例如,在解决一个数学问题时,模型会将其分解为多个子问题或计算步骤。

-

逐步推理:接着,模型会逐步处理每个子问题或步骤,并在每一步中生成推理过程的解释。这包括对输入数据的分析、逻辑推理、假设验证等。模型会尝试不同的解决方案,并根据结果调整其推理路径。

-

生成思路链:在推理过程中,模型会生成一个内部的思路链,记录每一步的推理过程和结果。这个思路链类似于人类的思考过程,帮助模型更好地理解和解决问题。

-

自我修正与优化:通过强化学习等技术,模型可以在推理过程中识别错误或不足之处,并进行自我修正和优化。例如,如果某个推理步骤导致错误的结果,模型会调整其策略,尝试其他方法来解决问题。

思维链技术的优势在于,它使AI模型能够更深入地理解和处理复杂问题,而不仅仅是简单地生成答案。这种方法提高了模型的推理能力和准确性,使其在解决需要逻辑推理和结构化思维的任务时表现得更像人类.

强化学习

强化学习是一种无监督的机器学习方法,其灵感来源于动物的学习行为,特别是通过奖励和惩罚来学习的过程。在强化学习中,智能体(Agent)通过与环境(Environment)的交互来学习如何做出最优决策,以最大化长期累积奖励。

强化学习的过程通常包括以下几个步骤:

- 初始化:智能体开始时通常对环境一无所知,需要从零开始学习。

- 观察状态:智能体观察当前环境的状态。

- 选择动作:根据当前策略,智能体选择一个动作来执行。在早期,智能体可能更多地依赖随机选择(探索),以发现可能的奖励。随着学习的进行,智能体会逐渐倾向于选择已知的最优动作(利用)。

- 执行动作:智能体将选择的动作应用于环境。

- 接收奖励和新状态:环境根据智能体的动作提供奖励,并进入新的状态。

- 更新策略和价值函数:智能体根据奖励和新状态更新其策略和价值函数,以更好地预测未来的奖励。

- 重复:智能体继续与环境交互,重复上述步骤,直到达到某个终止条件,如达到最大步数或环境进入终止状态。

强化学习的核心在于通过不断的试错和学习,智能体能够逐渐发现最优的策略,以在给定的环境中实现最大化长期累积奖励的目标。

-

-

openAI o1

无技术报告,故不解释细节

OpenAI最近发布了名为OpenAI o1的新模型,也被称为“草莓”模型。这个模型在推理能力上取得了显著进展,主要通过强化学习来实现。与之前的模型不同,o1在回答问题前会进行类似于人类的“深思熟虑”,通过生成内部思路链和尝试不同策略来识别错误。

OpenAI o1 在编程竞赛题(Codeforces)中排名第 89 位,在美国数学奥林匹克预选赛(AIME)中跻身全美前 500 名学生行列,在物理、生物和化学问题(GPQA)基准测试中的准确率超过了人类博士水平。

作者评估了 AIME 考试的数学成绩,该考试旨在挑战美国最聪明的高中数学学生。在 2024 年的 AIME 考试中,GPT-4o 平均只解决了 12% 的问题(1.8/15)。o1 在每个问题只有一个样本的情况下平均得分 74% (11.1/15),在 64 个样本达成共识的情况下平均得分 83% (12.5/15),在使用学习的评分函数对 1000 个样本重新排序的情况下平均得分 93% (13.9/15)。13.9 的得分使它跻身全国前 500 名学生之列,并高于美国数学奥林匹克竞赛的分数线。

o1系列包括三个版本:OpenAI o1、OpenAI o1-preview和OpenAI o1-mini,分别针对不同的使用需求和频率。开发者和研究人员可以通过ChatGPT和API访问这些模型。尽管o1的开发和应用前景广阔,但其高昂的训练和运行成本也给OpenAI带来了财务压力,公司正在寻求新一轮融资以支持其快速发展。

官方网站:https://chatgpt.com/

官方API网站:https://platform.openai.com/

Marco-o1

Marco-o1不仅专注于具有标准答案的学科,如数学,物理和编码,这些学科非常适合强化学习(RL),而且更加强调开放式解决方案。作者的目标是解决这个问题:“o1模型能否有效地推广到更广泛的领域,在那里缺乏明确的标准和奖励是难以量化的?”

通过微调Qwen2 - 7B-Instruct,结合过滤后的指令数据集,Marco-o1改进了其对复杂任务的处理。MCTS允许探索多个推理路径,从而引导模型找到最优解。

数据集

为了增强Marco-o 1模型的推理能力,作者采用了一种使用各种数据集的监督微调(SFT)策略。

- Open-O 1 CoT数据集(已过滤):作者通过应用启发式和质量过滤流程改进了Open-O1项目的CoT数据集。这种增强使模型能够有效地采用结构化推理模式。

- Marco-o1 CoT数据集(合成):作者使用MCTS生成了Marco-o1 CoT数据集,这有助于制定复杂的推理路径,进一步增强了模型的推理能力。

- Marco指令数据集:认识到强大的指令跟随(instruction-following)能力在执行复杂任务中的关键作用,我们纳入了一组指令跟随(instruction-following)数据。这种集成确保模型在广泛的任务中保持能力,保持其一般有效性,同时显着提高其推理能力。

{

"instruction": "The House of Lords operates as part of the political system of the United Kingdom.\\nIs the above claim true?\\nOptions:\\n- yes\\n- no Let's think first. Step-by-step reasoning process:",

"response": "<Thought>\nok, i need to determine whether the statement \"The House of Lords operates as part of the political system of the United Kingdom\" is true. let's break this down step by step.\n\nfirst, i recall that the United Kingdom has a parliamentary system of government, which includes the House of Commons and the House of Lords. the House of Commons is the lower house, while the House of Lords is the upper house. both houses work together to create and pass laws.\n\nbut wait, is the House of Lords truly part of the political system? or is it just a ceremonial body? i think historically, the House of Lords has been involved in lawmaking, but its role has evolved over time. maybe it's not as powerful as it used to be, but it still plays a role in the legislative process.\n\nlet me consider the current status. i believe the House of Lords is composed of appointed members, not elected ones, which differentiates it from the House of Commons. this appointment process might limit its influence, but it still contributes to the overall political landscape by providing expertise and experience.\n\nalso, there have been debates about reforming the House of Lords to make it more representative. some argue for an elected upper house, while others support its current structure. regardless of the ongoing discussions, the House of Lords remains an integral part of the UK's political system, even if its powers are somewhat limited compared to the House of Commons.\n\nanother angle to consider is the role of the House of Lords in scrutinizing legislation and providing a second chamber for debate. this function ensures that laws are thoroughly examined before they become binding, which is a crucial aspect of the political system.\n\nbut then again, some might argue that with the increasing power of the House of Commons, the House of Lords' role is diminishing. however, its presence and functions still make it a significant component of the UK's political structure.\n\nin summary, while the House of Lords may not hold the same level of power as the House of Commons, it is indeed part of the political system of the United Kingdom, serving as a legislative body alongside the House of Commons.\n\n</Thought>\n<Output>\nyes\n</Output>"

},

通过MCTS扩展解决方案空间

作者将LLM与MCTS集成,以增强Marco-o1模型的推理能力:

- 节点作为推理状态:在MCTS框架中,每个节点代表问题解决过程的推理状态。

- 作为LLM输出的动作:来自节点的可能动作是由LLM生成的输出。这些输出表示推理链中的潜在步骤或小步骤。

- 推出和奖励计算:在推出(rollout)阶段期间,LLM继续推理过程,直到最终状态。

- 引导MCTS:该奖励分数用于评估和选择MCTS内有希望的路径,有效地引导搜索朝向更自信和可靠的推理链。

"rollout"(或称为模拟)是指从当前节点开始,随机选择动作直到到达一个终端状态的过程。这个过程用于估计当前节点的潜在价值或奖励。Rollout是MCTS中用于探索和评估搜索空间的重要机制之一,通过多次rollout,模型可以更好地估计不同路径的价值,从而指导搜索过程向更有希望的区域扩展.

此外,作者通过计算置信度得分来获得每个状态的值。对于在推出过程中生成的每个令牌概率,作者通过将softmax函数应用于其对数概率和前5个备选令牌的对数概率来计算其置信度得分。这由下式给出:

在获得展示序列中所有令牌的置信度分数后,计算所有令牌的平均置信度分数,以获得整体奖励分数:

其中,置信度是rollout中的第i个token的置信度得分。

是由LLM生成的第i个token的对数概率。

是在第i步骤中前5个预测token的对数概率。𝑛是rollout序列中的token总数。该等式有效地将分数归一化为0和1之间。v是rollout路径的总体奖励分数。该平均值用作奖励信号,用于评估rollout过程中所采用的推理路径的质量。更高的平均值表示更可能准确的推理路径。

简单来说:Marco-o1模型通过蒙特卡洛树搜索(MCTS)增强其推理能力,将每个节点视为推理过程中的一个状态,利用大型语言模型(LLM)生成的输出作为可能的动作,通过模拟和计算每个token的置信度分数来评估推理路径的价值,从而引导MCTS选择更优的推理路径,有效扩展解决方案空间,提高模型在复杂任务中的推理能力.

推理行为策略

作者观察到,使用动作(actions)作为MCTS搜索的粒度相对较粗,通常会导致模型忽略对解决复杂问题至关重要的细微推理路径。为了解决这个问题,作者探索了MCTS搜索中的不同粒度级别。

"actions"指的是从当前节点(状态)可以采取的可能动作或步骤。这些动作决定了如何从当前状态转移到下一个状态。具体来说,actions的层次可以有不同的解释,取决于模型的设计和任务的需求:

- 粗粒度动作(Step-level Actions)

- 细粒度动作(Mini-step Actions)

最初,作者使用步骤(steps)作为搜索单位。为了进一步扩展模型的搜索空间并增强其解决问题的能力,作者尝试将这些步骤划分为64或32个标记的较小单元,称为“mini-step”。这种更细的粒度允许模型更详细地探索推理路径。虽然token级搜索提供了理论上的最大灵活性和粒度,但由于所需的大量计算资源以及与设计此级别的有效奖励模型相关的挑战,目前还不切实际。

- Step as Action:作者允许模型生成完整的推理步骤作为动作。每个MCTS节点代表一个完整的思想或行动标签。这种方法可以进行有效的探索,但可能会错过复杂问题解决所必需的更细粒度的推理路径。

- Mini-step作为Action:作者使用32或64个token的mini-step作为action。这种更细的粒度扩展了解决方案空间,并通过考虑搜索过程中更细微的步骤来提高模型导航复杂推理任务的能力。通过在这个层次上探索解决方案空间,模型可以更好地找到可能被较大的行动单位忽略的正确答案。

反思

作者通过在每个思考过程的最后添加短语“Wait!也许我犯了一些错误!我需要从头开始重新思考。”。这促使模型进行自我反思并重新评估其推理步骤。这种反射已经产生了显著的改进,特别是在最初模型错误解决的困难问题上。加上反思,这些具有挑战性的问题中大约有一半得到了正确的回答。

从自我批评的角度来看,这种方法允许模型充当自己的批评者,识别其推理中的潜在错误。通过明确地提示模型质疑其最初的结论,作者鼓励它重新表达和完善其思维过程。这种自我批评机制利用模型的能力来检测其自身输出中的不一致或错误,从而实现更准确和可靠的问题解决。反射步骤充当内部反馈循环,增强模型在没有外部干预的情况下进行自我校正的能力。

实验

基于Qwen 2 - 7 B-Instruct,作者使用训练数据执行SFT以创建Marco-o 1-CoT。此外,作者在MCTS树搜索的框架内使用了Marco-o 1-CoT,通过动作进行区分:

- Marco-o 1-MCTS(步骤):使用每个推理步骤作为动作(步骤)。

- Marco-o 1-MCTS(mini-step of 64 tokens):使用64 tokens mini-step作为动作(64 tokens)。

- Marco-o 1-MCTS(mini-step of 32 tokens):使用32 tokens mini-step作为动作(32 tokens)。

仿真实验结果验证了方法的有效性,提高了模型在不同语言和配置下的推理能力。

案例

-

LLaVA-o1/LLaVA-CoT

原名LLaVA-o1,后改名为LLaVA-CoT

本文引入了LLaVA-o1,它是一个新的用于进行自主多级推理的VLM。与思维链提示不同,LLaVA-o1独立地参与了总结、视觉解释、逻辑推理和结论生成的顺序阶段。这种结构化的方法使LLaVA-o1能够在推理密集型任务的精确度方面实现显著的改进。

具体来说,LLaVA-o 1能够生成四个不同的阶段:摘要、标题、推理和结论。在推理过程中,每个阶段都有其独特的目的。

- 摘要:一个简短的大纲,其中模型总结了即将到来的任务。

- 标题:图像相关部分的描述(如果存在),重点是与问题相关的元素。

- 推理:模型系统地考虑问题的详细分析。

- 结论:对答案的简要总结,根据前面的推理提供最终的反应。

论文地址:https://arxiv.org/abs/2411.10440v2

代码地址:https://github.com/PKU-YuanGroup/LLaVA-CoT

-

结构化推理阶段

作者提出的模型LLaVA-o1将答案生成过程分解为四个结构化推理阶段:

- 总结阶段:在这一初始阶段,LLaVA-o1提供了对问题的高层次简要解释,概述了它打算解决的问题的主要方面。

- 字幕阶段:如果存在图像,LLaVA-o1提供与问题相关的视觉元素的简要概述,有助于理解多模态输入。

- 推理阶段:在初步总结的基础上,LLaVA-o 1进行结构化的逻辑推理,得出初步答案。

- 结论阶段:在最后阶段,LLaVA-o 1根据前面的推理合成一个答案。在这里,结论阶段的输出是提供给用户的直接响应,而前三个阶段是代表LLaVA-o 1推理过程的内部“隐藏阶段”。这一阶段的产出适应用户的要求:例如,如果用户要求一个简短的答案,结论将是简洁的;如果需要详细的解释,结论提供了一个彻底的,全面的反应。

每个阶段都是由模型自行决定启动的,没有外部提示工程框架或额外的提示。具体来说,作者为模型提供了四对特殊标记:<SUMMARY></SUMMARY>,<CAPTION></CAPTION>, <REASONING></REASONING>,和 <CONCLUSION></CONCLUSION>.。这些标签分别对应于总结响应方法、描述相关图像内容、进行推理和准备最终答案。

在训练时,模型会根据需要自主选择这些标签,并根据自己的判断激活每个阶段。与OpenAI o1 [6一样,所有阶段都由模型在单个推理过程中完成。这种结构化的方法使模型能够独立地管理其推理过程,提高其适应性和复杂推理任务的性能。

-

数据集

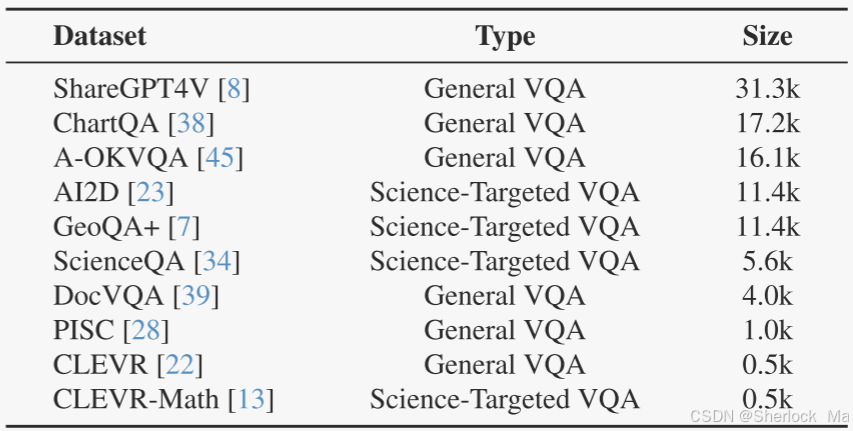

大多数现有的VQA数据集缺乏训练LLaVA-o1模型所需的详细推理过程。因此,作者编译了一个新的数据集,整合了几个广泛使用的VQA数据集的样本,总共产生了99 k个图像QA对(每个对可能包括一轮或多轮提问)。作者使用GPT-4 o [3]来生成详细的推理过程,包括摘要、标题、推理和结论,并将其编译成LLaVA-o1-100 k数据集,包括来自通用VQA数据集和科学目标VQA数据集的数据,具体如下:

- 一般VQA数据集。包括几个通用的VQA数据集。ShareGPT 4V提供来自GPT 4V交互的多轮问答数据。ChartQA专注于解释图表和图形。A-OKVQA强调可见内容之外的外部知识。DocVQA涉及需要文本理解的基于文档的问题。还包括PISC来理解社会关系,以及CLEVR来解决对象属性,空间关系和计数任务。

- 科学目标VQA数据集。这些数据集包括用于几何推理的GeoQA+ ,沿着针对科学问题的AI 2D 和ScienceQA。CLEVR-Math是CLEVR的扩展,专注于视觉环境中的算术分析。表显示了从每个数据集中选择的QA对的数量。

数据集示例:

数据集地址:https://huggingface.co/datasets/Xkev/LLaVA-CoT-100k

[

{ "from": "human", "value": "Which country is highlighted?\nContext: N/A\nOptions: (A) Solomon Islands (B) Nauru (C) Vanuatu (D) Fiji" },

{ "from": "gpt", "value":

"<SUMMARY> I will determine the highlighted country by examining its location on the map and comparing it with the given options. I will then conclude if this country has any territorial disputes based on the supplied context. </SUMMARY>\n\n

<CAPTION> The image depicts a map highlighting a country in the South Pacific region. The highlighted area is in a boxed section between Australia and New Zealand, directly addressing the region known to include several Pacific island countries. </CAPTION>\n\n

<REASONING> The highlighted country is within the Pacific Islands region. Based on its position relative to neighboring larger landmasses like Australia and nearby countries such as Papua New Guinea and New Zealand, the highlighted country aligns with the location of Vanuatu. According to the context, Vanuatu has a territorial dispute over Matthew and Hunter Islands, claimed by both Vanuatu and France. Therefore, the presence of a dashed box labeled \"Disputed island\" suggests the inclusion of this dispute in the overview of the country's territories. </REASONING>\n\n

<CONCLUSION> The answer is C. </CONCLUSION>"

}

]作者选择Llama-3.2-11BVision-Instruct模型作为基础模型,并使用LLaVA-o1-100k数据集进行了全参数微调。训练在具有8个H100 GPU的单个节点上进行。

-

阶段级波束搜索(Stage-level Beam Search)

训练后,作者的目标是进一步提高模型在推理过程中的推理能力。具体来说,作者利用LLaVA-o1的基于阶段的输出,作者的方法遵循以下步骤:

- 在第一阶段的采样N个响应。

- 随机抽取2个响应,让模型确定哪个更好,保留更好的响应。

- 重复N-1次,保留最佳反应。

- 对下一阶段的N个响应进行采样,然后重复步骤2-4,直到处理完所有阶段。

值得注意的是,LLaVA-o 1的结构化输出设计使这种方法变得可行,从而能够在每个阶段进行有效和准确的验证。这验证了结构化输出在提高推理时间尺度方面的有效性。

值得注意的是,LLaVA-o 1的结构化输出设计使这种方法变得可行,从而能够在每个阶段进行有效和准确的验证。这验证了结构化输出在提高推理时间尺度方面的有效性。

-

实验

作者在六个常用的多模态基准上比较LLaVA-o 1与基础模型Llama-3.2-11B-Vision-Instruct,以证明作者的方法在训练阶段的有效性。在此比较之后,作者进行了消融研究,以评估作者方法中每个成分的贡献,解决了以下三个关键问题:

- 作者的LLaVA-o 1 - 100 k数据集是否比直接使用原始数据集的问答对更有效?

- 结构化标记对性能有何影响?具体地说,作者通过隐含地分割反应的不同阶段来探索LLaVA-o1是否可以在没有标签的情况下发挥功能。

- 与基础模型相比,作者的模型在哪些特定方面表现出了最大的改进?它是否真正增强了推理能力?

基准测试:作者选择了六个广泛使用且具有挑战性的基准测试:MMStar、MMBench V1.1、MMVet、MathVista、AI2D和HallusionBench。MMStar、MMBench和MMVet主要评估模型的一般视觉问答能力,而MathVista和AI2D则侧重于模型在数学和科学推理方面的熟练程度。HallusionBench专门评估了模型对语言幻觉和视觉错觉的处理。

为了确保公平性和可重复性,所有评估都使用VLMEvalKit进行,这是一个用于大型视觉语言模型的开源评估工具包。所有基准模型的性能指标均来自VLMEvalKit的测试结果。

实验结果:作者发现,LLaVA-o1实现了显着的性能改进,尽管只使用10万数据,与基础模型Llama-3.2-11BVision-Instruct相比,LLaVA-o1在一般VQA、数学推理、科学VQA和幻觉控制任务方面表现出显着的改进,平均基准得分增加了6.9%,从而验证了作者方法的有效性。

LLaVA-o 1 - 100 k与原始数据集相比的有效性。尽管直接在原始Q&A对上训练的模型在基本模型上显示出一些整体改进,但其平均性能仍然显着降低。特别是在需要更详细响应的MMVet基准测试中,其性能甚至比Baseline模型还要差。这一结果强调了LLaVA-o 1 - 100 k数据集的多级格式对于训练能够进行高级推理的模型的重要性。

结构化标记对于增强性能至关重要。为了检验作者引入的四个标签是否提高了模型的性能,作者将LLaVA-o1与在去除了结构化标签的LLaVA-o1-100 k数据集上训练的模型进行了比较。如表2所示,结果显示,当标签被移除时,性能显著下降,这表明结构化标签有助于推理并提高模型性能。据我们所知,LLaVA-o 1是第一次尝试通过使用标签的结构化推理来成功地增强模型的推理能力和整体性能。

在推理密集型领域,性能优先。为了分析LLaVA-o 1与基础模型相比有所改进的具体领域,作者对MMStar基准测试中不同技能的模型性能进行了详细评估(表3)。MMStar旨在评估六个关键能力:粗略感知,细粒度感知,实例推理,逻辑推理,数学和科学技术。在表3中,作者将基本模型与LLaVA-o 1进行了比较。分析表明,LLaVA-o 1在需要系统推理的任务中表现出显着的改善,例如实例推理,逻辑推理,数学和科学技术,而在粗感知和细粒度感知方面表现出相对较小的增益。这表明,作者的方法可以主要提高模型的推理能力。

如表4所示,阶段级波束搜索在利用LLaVA-o 1的结构化推理阶段方面表现出了实质性的有效性。通过评估每个推理阶段的输出,该方法在严格的质量控制和计算效率之间取得了平衡,在复杂的推理任务中产生了更高的推理精度,而没有显着的计算开销。这些研究结果表明,阶段级波束搜索,这是可能的LLaVA-o 1的结构化输出设计,是一种有效的和强大的推理时间缩放的方法。

为了进行公平的比较,作者的stage-level波束搜索方法和基线模型使用可比较的推理时间计算水平进行评估。具体来说,作者将N = 10设置为best-of-N方法,对于作者的stage-level波束搜索,每个阶段生成4个候选响应,并且使用每个句子生成2个候选的sentence-level波束搜索。如表5所示,best-of-N方法仅产生0.6%的适度改进,而sentence-level波束搜索甚至显示出1.9%的性能下降。作者检查了子分数,发现sentence-level波束搜索性能下降的主要原因是粒度过大的并行级方法,它很难有效地解决开放式问题。相比之下,作者的阶段级波束搜索将性能提高了2.6%,突出了基于阶段的搜索的优越性。

为了更好地说明随着推理时间计算的增加,作者的阶段级波束搜索的有效性,作者在MMVet基准上评估了具有不同波束大小的LLaVA-o 1。如表6所示,作者通过在每个推理阶段生成1个(即没有推理时间缩放)、2个、3个和4个候选答案来测试模型的性能,允许模型从这些选项中选择最佳答案。作者的研究结果表明,随着候选响应数量的增加,模型的性能不断提高,证实了作者的阶段级波束搜索方法是可扩展的。由于计算资源的限制,作者在所有基准测试中只测试了2的波束尺寸。

作者在需要高级推理功能的六个基准测试中将LLaVA-o 1与其他最先进的开源和闭源视觉语言模型(VLM)进行了比较。

作者的研究结果表明,LLaVA-o1始终优于许多类似甚至更大尺寸的开源模型,例如InternVL 2 -8B ,Ovis1.5-Gemma 2-9 B,MiniCPM-V2.6-8B,Llama-3.2- 90 B-VisionInstruct和VILA-1.5- 40 B 。值得注意的是,LLaVA-o 1甚至超过了某些闭源模型,如GPT-4 o-mini和Gemini-1.5-pro,强调了结构化推理方法的有效性。这种比较验证了作者的方法的优势,特别是在严重依赖于推理技能的基准测试中,并突出了LLaVA-o1作为推理密集型VLM任务领域的竞争模型。

-

O1-CODER

这是一种复制OpenAI的o 1模型的尝试,专注于编码任务。它集成了强化学习(RL)和蒙特卡罗树搜索(MCTS),以增强模型的系统思维能力。该框架包括训练用于标准化代码测试的测试用例生成器(TCG),使用MCTS生成具有推理过程的代码数据,以及迭代地微调策略模型以最初产生伪代码,然后生成完整代码。

概览

将o1应用于代码生成有两个主要挑战需要解决。

- 第一个挑战是结果评价,即评估生成代码的质量。与数学等任务不同,这些任务可以根据游戏规则或正确答案直接评估结果,评估代码需要在测试环境中运行生成的代码,并根据测试用例对其进行验证。

- 第二个挑战涉及定义思维和搜索行为,即,确定状态转换和进程奖励的粒度。对于代码生成,关键问题是如何设计推理过程和策略空间来有效地指导模型的行为。

为了解决第一个挑战,作者建议训练一个测试用例生成器(TCG),它会根据问题和标准答案代码自动生成测试用例。这种方法将有助于构建标准化的代码测试环境,为强化学习提供结果奖励。

对于第二个挑战,可以考虑两种可能的方法。一种是“三思而后行”,模型首先形成一个完整的思想链,然后一次性生成最终答案。另一种方法是“边行动边思考”,涉及生成部分答案,同时通过任务进行推理。在本研究中,作者选择了前一种方法。

该框架由六个步骤组成。

- 第一步是训练测试用例生成器(TCG),它负责基于问题自动生成测试用例。

- 在第二步中,在原始代码数据集上运行MCTS以生成具有推理过程

的代码数据集,其中包括用于区分正确和不正确推理步骤的有效性指示器。

- 一旦有了包含推理过程的数据,第三步是微调策略模型πθ,训练它以“三思而后行”的方式行事。

- 推理过程数据还可以用于初始化过程奖励模型(PRM),其评估推理步骤的质量。

- 第五步是最关键的:通过PRM ρPRM提供过程奖励,γTCG提供结果奖励,使用强化学习更新策略模型πθ。

- 在第六步中,基于更新的策略模型,可以生成新的推理数据。然后,可以使用该新数据再次微调PRM(第4步)。

因此,步骤4、5和6形成了一个迭代循环,其中自我发挥继续推动模型改进。

训练

训练过程被分为两个不同的阶段:监督微调(SFT)和直接偏好优化(DPO)。

我们将未微调的发生器记为。SFT阶段的主要目标是确保生成器的输出符合预定义的格式,从而能够对生成的测试用例进行准确的解析和提取。该阶段的训练数据来自TACO数据集,其遵循格式{问题,解决方案,测试用例}。为了使模型的输入和输出标准化,作者开发了一个模板格式,如下所示:

生成器在SFT之后表示为。

DPO阶段的目标是指导模型生成符合特定偏好的测试用例,从而增强测试用例生成器的性能和可靠性。在这项研究中,作者采用DPO方法与人工构建的样本对,以提高模型的能力,通过构建一个偏好数据集,以符合所需的偏好。

DPO微调依赖于预先构建的偏好数据集DPO = {x,yw,yl},其中x是提示,包括指令,问题和代码; yw是正面示例,即,与偏好一致的测试用例;以及yl是反例,即,与首选项不一致的测试用例。

作者采用以下规则来构造偏好数据:对于yw,作者直接使用三个完全匹配的样本测试用例作为正例;对于yl,作者将三个样本测试用例的输出打乱,然后连接原始输入,使得三个测试用例的输入输出对不完全匹配,并使用三个不完全匹配的测试用例作为负例。训练目标旨在基于初始SFT模型优化

,同时将隐式奖励建模与代表初始SFT模型

的参考模型

相结合。

实验

作者利用DeepSeek-1.3B-Instruct作为测试用例生成器的基本模型,其次是SFT和DPO。微调阶段采用QLoRA技术,其中秩参数r = 1。学习率设置为5 × 10−4,以平衡训练稳定性和收敛速度。训练数据来自TACO训练数据集的子集,该数据集遵循ACM竞赛格式,包含大约10,000个样本。同样,测试数据是从TACO测试数据集的子集中获得的,也符合ICPC竞争格式,由314个样本组成。

MBPP基准测试中基于伪代码的代码生成结果如下。Pass@1表示总体通过率。ASPR(Average Sampling Pass Rate)表示在最后一步到达正确推理路径的平均成功率。

案例

-

DRT-o1

本文介绍了DRT-o 1,它是将长CoT的成功应用于神经机器翻译(MT)的一个尝试。具体而言,由于文化差异,文学作品中可能会涉及到明喻和隐喻,在实际翻译中这些文本是非常困难的。

作者首先从现有的文学书籍中挖掘出含有明喻或隐喻的句子,然后开发了一个多Agent框架来通过长时间思考翻译这些句子。在多智能体框架中,翻译器根据顾问提供的建议对源句进行迭代翻译。为确保长思考的有效性,最后根据评估模型来量化每一轮的翻译。

代码地址:https://github.com/krystalan/DRT-o1

数据

作者利用了古滕贝格计划公共领域图书库中的文献书籍,这些书籍通常都有50多年的历史,而且版权已经过期。大约有400本英语书被用来挖掘含有明喻或隐喻的句子。

首先,作者从这些书中提取所有的句子,并过滤掉过短或过长的句子,即少于10个单词或多于100个单词,产生了577.6K的文学句子。其次,对于每个句子,作者使用Qwen2.5- 72 B-Instruct来判断句子是否包含明喻或隐喻,并丢弃不包含明喻或隐喻的句子。第三,对于剩下的句子,作者让Qwen2.5- 72 B-Instruct逐字翻译成中文,然后判断翻译是否符合中文母语环境。如果答案是否定的,相应的句子将被保留,并被视为“适合通过长时间的思考来翻译”。通过这种方式,作者最终收集了63 K(从577.6K中)涉及明喻或隐喻的文学句子,这些句子的直译也有缺陷,称为预收集句子(pre-collected sentences)。

对于每个预先收集的句子(记为s),作者设计了一个多Agent框架,通过长时间的思考将其从英语翻译成汉语。

作者的多代理框架包括三个代理:一个翻译器、一个顾问和一个评估器。合成过程如下:

- 词级翻译:翻译器首先识别句子中的关键词,然后在考虑上下文的情况下提供它们的译文。这些关键字表示为

,其中

表示s中的第i个关键字,k是关键字的个数。关键字的翻译被表示为

。该步骤使得模型能够通过将整个句子分解成子问题(即,单词级翻译)。

- 初步翻译:然后,翻译器根据源句及其关键词双语对(

)提供初步的句子翻译(t0)。

- 翻译优化循环。在优化循环中,三个代理一起工作以迭代地精化翻译。在每个迭代步骤k(从k = 1开始)中,顾问首先评估前一步骤中的翻译,即,

,并提供详细的反馈

用于优化。然后,评估器在预定义的评分标准和

的条件下给出

的总评分,该评分表示为

。在迭代步骤的最后,翻译器考虑其先前的翻译

、对应的反馈

和总得分

以提供新的翻译

。当总分达到预定义的阈值或迭代步骤数达到最大值时,翻译优化循环将停止。

如果推理步骤n < 3,将丢弃整个样本。

最后,经过长时间的思考,作者得到了22,264个机器翻译样本。

DRT-o 1数据中的细化步骤/轮次数如下图所示,范围从3到8。可以发现,大多数样本(73.22%)涉及三个细化步骤,而只有一个样本涉及八个步骤。此外,为了更深入地理解细化过程,作者计算每个细化步骤前后的平均编辑距离。具体来说,前三个细化步骤导致21.44、13.16和10.90字符级编辑距离。这种观察与直觉是一致的。随着细化的进行,修改的幅度逐渐减小。

实验

评估指标:根据先前的工作,作者采用BLEU、无参考的CometKiwi和基于参考的CometScore以评估模型翻译。BLEU评估生成的译文和相应参考文献之间的n-gram重叠,而CometScore评估译文与参考文献的语义相似性。CometKiwi使用一种语言模型来判断一个翻译是否传达了源句的语义。为了计算CometKiwi和CometScore,利用了官方代码和官方模型。为了计算BLEU分数,作者使用sacrebleu工具箱来计算语料库级别的BLEU。

作者在基于引用和无引用的评估中还使用GPT-4 o实现的求值器,分别将其称为GRB和GRF。由于GRB和GRF需要API成本,作者从测试集中随机抽取400个样本,进行GRB和GRF评估。

骨干:作者采用以下三个LLM作为DRT-o 1的主干:(1)Llama-3. 18 B-Instruct;(2)Qwen 2. 5 7 B-Instruct 7和(3)Qwen2.5- 14 B-Instruct。

细节:LLaMA-Factory用于调整LLM。所有LLM均在8×NVIDIA A100 GPU(40 G)上进行了调整,学习速率为1 e-5,批量大小为8(8×1)。使用DeepSpeed优化,并设置ZeRO-3优化,将训练时期的数量设置为3,7 B和14 B模型的训练过程分别花费70个GPU小时和124个GPU小时。当在测试集上评估模型性能时,使用vLLM工具包加快生成。作者使用temperature=0.1的采样解码策略,并将重复惩罚(repetition penalty)设置为1.05。

结果:下表显示了实验结果。在对长期思考的MT训练数据进行指令调整后,DRT系列LLM的性能明显优于相应的vanilla主干。此外,DRT-o 1 - 14 B在所有指标方面都优于所有基线(包括QwQ-32 B-preview和Marco-o1 - 7B),显示了长期思考的有效性。

案例

结果案例

思维链案例

-

HuatuoGPT-o1

OpenAI o1的突破突出了增强推理以改进LLM的潜力。然而,大多数关于推理的研究都集中在数学任务上,而医学等领域却没有得到充分的探索。作者在这篇文章中介绍了HuatuoGPT-o1,这是一个能够进行复杂推理的医学LLM,它仅使用40 K可验证问题进行训练就超过了通用和特定医学大模型baseline。

代码地址:https://github.com/FreedomIntelligence/HuatuoGPT-o1

论文地址:https://arxiv.org/pdf/2412.18925

-

数据集

数据来源:

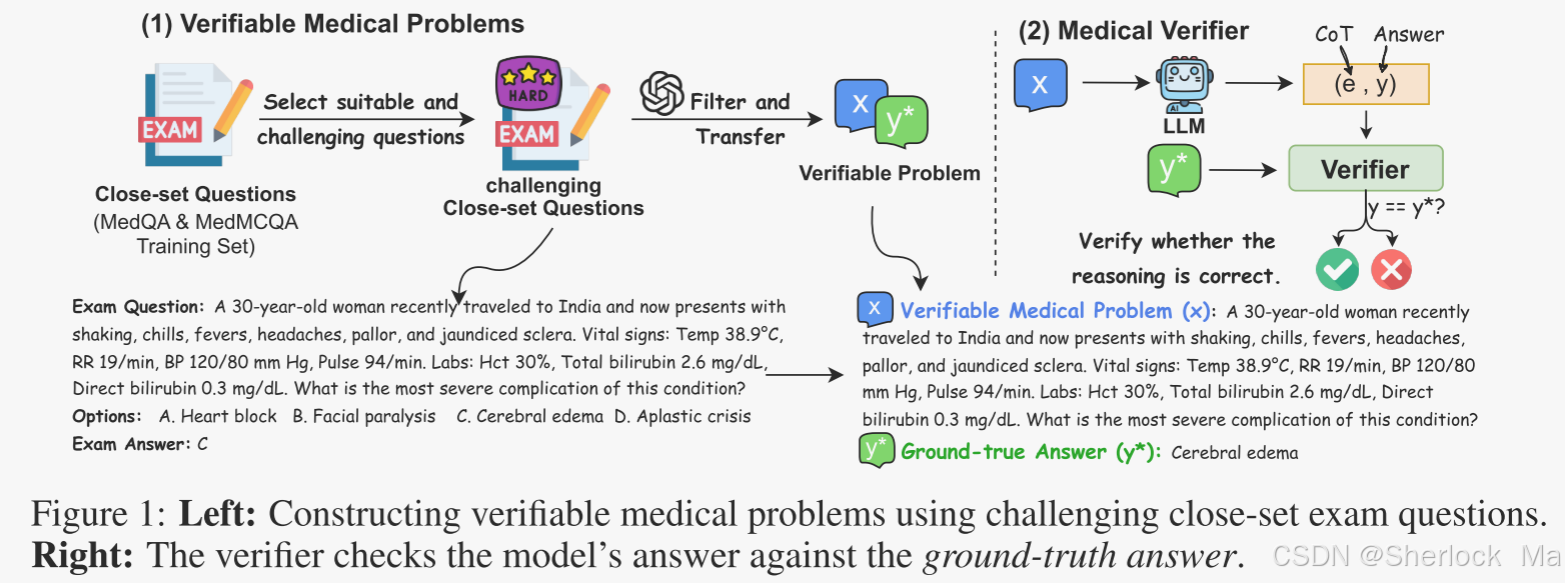

作者利用闭源的真实考试问题。有两个关键原因:1)有大量现成的医学考试问题可用; 2)这些考试问题通常是客观和准确的。具体来说,作者从MedQA-USMLE和MedMcQA的训练集中收集了192 K个医学多项选择题。

数据清洗:

然而,这些医疗问题是封闭的,这意味着它们提供的答案选择有限。这使得模型很容易在没有适当推理的情况下猜测正确答案。此外,有些问题是不合适的,因为它们可能没有唯一的正确答案来验证,或者太简单而不需要推理。为了解决这个问题,作者选择和处理的问题如下:

- 删除了三个小LLM(Gemma 2-9B,LLaMA-3.1-8B,Qwen2.5- 7B)都正确回答的问题,并丢弃了简短的问题,以保留那些需要更深入推理的问题。

- 确保唯一答案:作者排除了要求“不正确选项”或有多个正确答案的问题。LLM(GPT-4o)进一步用于删除正确答案可能不唯一或可能不明确的问题。

- 重新格式化为开放式形式:使用LLM(GPT-4 o),作者将每个封闭式问题重新格式化为开放式问题x和标准答案y,如图所示。

经过这种过滤和处理,作者最终构建了一个由40 K个可验证的医学问题组成的数据集,表示为,其中x是一个可验证的问题,y*是标准答案。

开发医学验证器(Medical Verifier):

针对这些可验证的问题,作者提出了一个验证器来评估模型输出的正确性。给定一个医学可验证问题x,该模型生成一个思想链(CoT)e和一个结果y。验证器对照标准答案y检查y,提供二值反馈,如下所示:。

作者使用GPT-4 o [22]作为验证器,编写提示词命令它执行验证。

这个验证器的意思就是根据参考答案y*判断模型的输出y是否准确。

-

方法

作者方法有两个阶段:第一阶段:掌握复杂推理,第二阶段,用强化学习(RL)增强复杂推理。

第一阶段:

思维链数据集合成

给定一个可验证的医学问题作为元组,即(问题,标准答案),使用LLM(例如,GPT-4o)生成初始CoT e0和答案y0:

,验证器检查y0是否与y*匹配。如果不正确,则模型使用随机选择的搜索策略

,改善先前的想法

,产生新的推理ei和新的答案yi:

。其中i表示第i次迭代。

作者定义了四个搜索策略K来指导细化过程:

- 探索新的路径:LLM探索一种新的方法ei,不同于先前的e0,...,ei-1,得到一个新的答案yi。

- 回溯:LLM重新访问先前的推理过程ej,yj,其中j < i − 1,并从那里继续推理。注意,回溯仅在i ≤ 2时采样。

- 验证:LLM评估当前推理ei-1和结果yi-1,提供验证过程ei和验证结果yi。

- 修正:LLM对当前的推理ei-1进行批判和修正,得到修正后的推理ej和答案yi。

该过程迭代直到yi被验证为正确。如果达到最大迭代计数N = 3,则重新开始搜索。每个数据点(x,y)最多可尝试T = 3次;如果全部失败,则丢弃该数据点。

当成功的轨迹被发现,它被重新格式化为一个连贯的自然语言推理过程

,即Complex CoT:

这种重新格式化使用平滑过渡(例如,“hmm,”“also,”“wait”)来简化推理并减少令牌的使用。然后,模型使用以下结论为问题x生成正式响应:

监督微调(SFT):

作者使用GPT-4o从可验证的问题集合成20K SFT数据

。

用于微调LLM以生成复杂的CoT

,然后是正式的响应y。

这个微调过程教会模型在回答之前思考,鼓励模型在回答之前深入探索和完善其推理。

数据集示例:

https://huggingface.co/datasets/FreedomIntelligence/medical-o1-reasoning-SFT

【Question】:In assessing the truthfulness of statements about brain tumors, what are the accurate details regarding the commonality of astrocytomas as primary brain tumors, the role of radiation exposure and genetic abnormalities as risk factors, the association of MEN-2 and NF-1 with increased risk, the cardinal symptoms, the effect of dexamethasone on peritumoral edema, the primary goals of surgery, the use of anti-epileptics for tumors near the sensorimotor strip, and the application of craniospinal irradiation for tumors associated with CSF spread?

【COT】:Let's think about astrocytomas. They're part of a bigger group called gliomas, which are pretty common when it comes to primary brain tumors. Basically, they start from these brain cells known as astrocytes, which means they happen quite a lot as primary tumors in the brain. Now, when it comes to what puts someone at risk, radiation really stands out. If someone's had radiation therapy to their head, that's a known risk factor for developing these tumors. Then there are genetic factors. Some hereditary syndromes come with genetic abnormalities that can make someone more likely to get a brain tumor. Alright, let's talk about something that's a bit tricky. MEN-2, or Multiple Endocrine Neoplasia type 2, isn't usually linked to brain tumors, which is important to note. On the flip side, NF-1, or Neurofibromatosis type 1, does relate to a higher chance of brain tumors. While NF-1 has stronger ties with optic pathway gliomas, it's important to think a bit more about its link with astrocytomas. So, maybe we should reconsider that connection. When someone has a brain tumor, there are some key symptoms you might notice. Headaches are common, and seizures can happen as well. Then there might be changes in how someone thinks or acts, or neurological issues depending on where the tumor is. If you consider treatment, dexamethasone is something doctors use to deal with swelling around the tumor. It’s a corticosteroid, and it really helps with inflammation and lowering pressure within the skull. Okay, surgery. What's the main objective there? Generally, surgeons aim to figure out exactly what they’re dealing with through a biopsy and to remove as much of the tumor as they can, as long as it’s safe to do so. This helps people feel better and can improve their outlook. Let’s not forget about anti-epileptic drugs. When a tumor’s near the part of the brain that controls movement, like the sensorimotor strip, these meds are often used to prevent seizures. It makes sense because these areas can be particularly sensitive because of the tumor. Now, craniospinal irradiation. It's mostly used when a tumor might spread through the cerebrospinal fluid, which isn't really the case for astrocytomas as they usually stay in one place. Although, I suppose if something unusual happened and the tumor did spread in that way, this type of irradiation could be considered. So, to wrap it up, astrocytomas are definitely common primary brain tumors. Radiation exposure and genetic issues are major risk factors, while MEN-2 doesn't relate to these tumors. But NF-2, and maybe to some extent NF-1, could relate to brain tumors due to genetic connections. The big symptoms are headaches, seizures, and neurological deficits. Dexamethasone helps with edema. Surgery's about diagnosis and safe removal. Anti-epileptic drugs help with seizures from tumors near critical brain areas. Craniospinal irradiation is more for tumors that spread in the CSF, which isn’t typically what astrocytomas do. I think that clears it up pretty well, and it's all consistent with what we know about the brain and these tumors.

【Response】:Astrocytomas are indeed common primary brain tumors, originating from astrocytes, which are a type of glial cell in the brain. Radiation exposure, particularly from previous radiation therapy to the head, is a well-established risk factor for developing such tumors. Additionally, genetic abnormalities, especially those found in certain hereditary syndromes, can increase the likelihood of brain tumors. Regarding genetic syndromes, Multiple Endocrine Neoplasia type 2 (MEN-2) is not linked to an increased risk of brain tumors. However, Neurofibromatosis type 1 (NF-1) is associated with a higher risk of developing brain tumors, including gliomas, although it is more commonly linked to optic pathway gliomas. Key symptoms of astrocytomas and other brain tumors include headaches, seizures, cognitive and behavioral changes, and neurological deficits which vary depending on the tumor's location. Dexamethasone is effective in reducing peritumoral edema, as it is a corticosteroid that helps alleviate inflammation and decrease intracranial pressure. The primary goals of surgery for brain tumors include obtaining a tissue diagnosis through biopsy and achieving maximal safe resection of the tumor. This can alleviate symptoms and potentially improve the patient's overall prognosis. Anti-epileptic drugs are used to prevent or manage seizures, which may occur if a tumor is located near or affects the sensorimotor strip or other areas of the brain involved in motor control. Craniospinal irradiation is typically considered for tumors that have the potential to spread through the cerebrospinal fluid (CSF). Astrocytomas generally do not spread in this manner, so craniospinal irradiation is not routinely used for them unless atypical circumstances indicate a need.

-

第二阶段

在这个阶段,我们使用强化学习(RL)进一步增强复杂的推理技能。虽然LLM在第1阶段学习了成功的推理轨迹,但通过搜索得出的这些路径可能不是最佳的。阶段2中的策略学习旨在改进模型,以实现更好的复杂CoT推理。

RL奖励:奖励在指导RL训练目标方面发挥着至关重要的作用。给定一个可验证的问题x和生成的响应,奖励分配为:

即正确的答案得到1的奖励,不正确的答案得到0.1,而缺乏回答前思考行为的回答得到0。

此外,在相关工作之后,总奖励将该函数得分与学习的RL策略和初始策略

之间的Kullback-Leibler(KL)散度相结合,由系数β缩放:

强化学习:对于强化学习,作者使用带有裁剪目标(clipped objective)的邻近策略优化(Proximal Policy Optimization,PPO)算法。微调后的模型作为策略模型πθ。对剩余的可证实的医学问题进行训练。该策略对输入x的响

进行采样,计算奖励,并更新参数θ。

-

实验

训练数据:最后,作者从MedQA-USMLE和MedMCQA的训练集构建了一个40 K的医疗验证数据集。其中,20 K用于阶段1中的SFT,20 K用于阶段2中的RL。此外,还包括来自D的4K未转换数据(带有选项答案的封闭式问题),以增强泛化能力。

模型训练:作者分别基于LLaMA-3.1-8B-Instruct和LLaMA-3.1- 70 B-Instruct训练模型HuatuoGPT-o 1 -8B和HuatuoGPT-o 1 - 70 B。在第一阶段,模型在DSFT上微调3个epoch,学习率为5e-6,批量大小为128。在第二阶段,使用PPO进行RL,学习率为5e-7,批量大小为128,β设置为0.03。PPO参数设置为:3个PPOepoch,折扣因子1.0,价值系数1.0,限幅范围0.2。

评估标准医学基准:MedQA(USMLE测试集),MedMCQA(验证集)和PubMedQA(测试集)。随后,作者评估了一些具有挑战性的LLM基准的医学部分,包括MMLU-Pro的健康和生物学轨道,以及GPQA的遗传学和分子生物学轨道。由于GPQA问题的数量有限,作者运行了5次评估并对结果进行了平均。

消融研究:作者对8B模型进行了消融研究,以分析ComplexCoT和RL的影响。表2所示的结果揭示了以下见解:

- 简单的多项选择训练是无效的:作者比较了仅在数据集D的原始医学多项选择问题上训练的模型的性能。具体来说,作者使用多项选择题作为输入,正确的选项作为输出进行微调。结果表明,仅在多项选择题(微调基线)上进行训练,与基本模型(LLaMA-3.1-8B-Instruct)相比,改进最小。这表明仅仅学习正确答案并不能提高解决问题的能力。

- 复杂CoT的有效性:作者进一步研究了不同类型的思想链(CoT)推理的影响。结果表明,直接学习的响应(

)表现最差,而简单的CoT(y0,e0)只提供了很少的好处。相比之下,Complex CoT(

)显著提升了性能,这表明了这种完善答案与反思的教学模式的重要性。

- 复杂CoT提升RL:我们比较了不同CoT策略下的RL增强,如表3所示。结果表明,复杂CoT涉及更长的CoT(平均712个令牌),与简单CoT(2.6分)和无CoT(1.1分)相比,产生了显著更大的收益(3.6分)。这可能表明,更长的自我推理路径提供了更丰富的思维过程和反馈,使模型能够发现更高回报的解决方案。

- PPO产生最佳性能:使用相同的奖励函数,作者进一步比较了不同的RL相关算法,包括偏好学习算法DPO和REINFORCE风格的算法RLOO。比较PPO、RLOO和DPO,作者发现PPO表现最好,其次是RLOO和DPO。DPO较弱的性能可能是由于其脱离策略的性质,而PPO则受益于其价值模型的使用,尽管内存消耗更高。

验证器的可靠性:验证器在引导路径搜索和强化学习(RL)中起着至关重要的作用。在作者的方法中,GPT-4 o作为验证者,根据标准答案评估模型结果。

为了评估其可靠性,作者手动验证了从第1阶段和第2阶段取样的200个评分实例。如图4所示,GPT-4 o在第1阶段达到96.5%的准确度,在第2阶段达到94.5%,证明了其可靠性。相比之下,使用正则表达式来确定响应中是否存在正确答案的精确匹配方法表现得更差,第1阶段的准确率仅为70.5%,第2阶段为74.5%。这突出了基于LLM的验证器的关键作用。此外,作者基于LLaMA 3.1 -8B微调了8B验证器,具有20000个评分样本。微调的验证器也证明了可行性,达到了90%以上的准确率。

-

CoMCTS

本文提出了一种新的学习-推理方法--集体蒙特卡罗树搜索(Collective Monte Carlo Tree Search,CoMCTS),它将集体学习的概念引入到“树搜索”中,以实现高效的推理路径搜索和学习。

使用CoMCTS,作者构建了Mulberry-260 k,一个多模态数据集,其中每个问题都有一个丰富、明确和定义良好的推理节点树。利用Mulberry 260 k,作者训练了模型Mulberry,这是一系列具有类似于o 1的逐步推理和反射能力的MLLM。

代码地址:GitHub - HJYao00/Mulberry

CoMCTS的核心思想是利用集体知识协同推测、搜索和识别通往正确答案的有效推理路径。具体来说,CoMCTS迭代地搜索有效的推理路径,在每次迭代中,它利用来自多个MLLM的集体知识,共同

- 从给定的开始节点开始扩展多样化且互补的候选后续推理节点直到结束,

- 模拟推理结果,定位错误候选节点并沿着它们的子节点修剪它们,

- 反向传播以自下而上的方式更新每个推理节点的得分和访问计数,

- 选择具有最高置信上界值的叶推理节点作为下一个开始节点。

有效推理过程

CoMCTS的核心思想是利用集体知识以迭代的方式协同推测、搜索和识别有效的推理节点,旨在找到通向正确答案的有效推理路径。

作者将策略模型表示为π,它由预训练的MLLM初始化。作者利用来自一组MLLM 来共同搜索和学习有效的推理路径。给定多模态输入问题Q(例如,具有图像的文本任务指令,Q = {text,image}),每个模型π可以经由自回归next-token预测生成朝向最终答案的中间推理状态序列

。每个推理步骤由一个或几个包含多个单词token的句子组成。

CoMCTS算法从根节点开始,通过一定数量的迭代执行推理路径搜索,其中每个迭代包括四个关键操作:(a)扩展,(B)模拟和错误定位,(c)反向传播,以及(d)选择

- 扩展:在CoMCTS中,该操作的目标是扩展当前叶子推理节点(如果它不是终端节点)以集成新的后续候选推理节点。给定当前叶节点

(即,由操作(d)选择所选择的节点或根节点),CoMCTS利用来自一组MLLM的集体知识

,共同并行扩展一组多样互补的候选推理路径

,直到终端节点:

,其中,

返回

的所有父节点,并且(

,

)表示从根节点到sk m的当前推理路径。

代表从

开始由模型

生成的潜在推理路径。

- 模拟和错误定位:在该操作中,CoMCTS利用

来联合估计子节点

(在操作(a)中添加)的潜在得分,并将低得分节点视为错误推理节点,并将它们与其子节点一起沿着定位和剪枝掉。

- 反向传播法:给定在操作(a)-(b)中使用集体知识扩展和模拟的新推理树,CoMCTS执行从叶节点回到根节点的自底向上的更新。在推理树中沿着新扩展的路径的每个节点s更新其统计,包括子节点计数N和节点值V:

- 选择:在操作(a)、(B)和(c)之后,CoMCTS遍历更新后的推理树以选择下一个开始节点。此选择由置信上限(Upper Confidence Bound,UCB)值指导,该值平衡了搜索探索和利用。节点s的UCB值是使用节点奖励值V(s)和访问奖励N(s)来计算的。在候选节点

中,具有最高UCB值的一个被选择作为下一次搜索迭代的开始节点

:

CoMCTS通过两个交替阶段训练Mulberry模型:在上层迭代中,它利用多个MLLM的集体知识,从起始节点扩展候选推理节点,模拟推理结果并剪枝错误节点,然后自底向上反向传播更新节点得分和访问计数,最后选择具有最高UCB值的叶子节点作为下一个起始节点,最终得到推理树数据集.

通过将CoMCTS应用于一组多模态问题,可以构造一组多模态学习推理数据三元组,这些三元组为每个问题的最终答案提供了一棵由丰富、明确和定义良好的推理节点组成的树,并使MLLM能够逐步学习推理。

反射推理路径搜索

识别有效推理路径中的负兄弟节点:具体来说,对于有效推理路径 Y 中的每个节点 s,我们使用上置信界限(UCB)来识别其负兄弟节点 。公式如下:

构造反射推理路径:具体来说,对于有效推理路径 Y 中的每个节点s,随机选择一个负兄弟节点,并将其与一个反射提示(prompt)和正节点 s连接起来,形成一个反射轨迹(

)。然后,我们使用一个替换函数Replace(⋅) 来将 s替换为这个反射轨迹,从而将 YY 转换为反思推理路径

。其中,

表示一个反射提示,例如“前面的推理步骤是错误的,让我们重新考虑一下。”然后,作者将反射推理路径

集成到数据中,作为四元组

。

训练

使用CoMCTS,作者为一组多模态输入问题搜索有效的和反射的推理路径,并构建Mulberry-260 k,一个多模态学习推理和反射数据集,每个问题都有一个丰富的,明确的和定义良好的推理节点树。

作者执行集体SFT来训练模型Mulberry模型

集体监督微调 (Collective Supervised Fine-Tuning,CoSFT):作者应用标准SFT目标来训练MLLM:

CoSFT用于反思推理:给定一个问题及其由CoMCTS构造的推理树(Q,S)∈ D,作者从S随机抽取一条反射推理路径,并进行CoSFT进行反射推理:

和

的目标是在由CoMCTS生成的推理节点S的树上最大化有效和反射推理路径Y和

的对数概率。此外,

能够通过学习校准否定推理节点来利用CoMCTS搜索过程中的否定信息。

在训练过程中,先计算CoSFT,然后再计算CoSFT-Re。通过这两个公式,模型不仅学习如何生成有效的推理路径,还学习如何进行反思,从而在推理过程中能够识别和纠正错误。

数据

作者收集了260K原始多模态输入问题(即,以图像作为输入问题的文本任务说明),涵盖广泛的领域,涵盖一般多模态理解、数学、图形理解、现实世界理解、科学、医学图像理解等。最终构建数据集,Mulberry-260 K。请注意,作者只对15 K数据进行反射推理训练,以避免反射数据过多。

具体来说,下图显示了整个Mulberry-260 K的推理步骤主要分布在6到8之间,平均为7.5。同时,对于简单的推理任务,Mulberry-260 k的推理步骤通常在6到7之间,平均为6.8。对于复杂的数学和逻辑推理任务,例如与几何相关的Mulberry-260 k子集,推理步骤主要分布在7到10个步骤之间,平均值为8.9。

在本文中数据集构建过程中,作者采用一组四个模型,包括GPT 4o,Qwen 2-VL-7 B,LLaMA-3.2- 11 B-Vision-Instruct,和Qwen 2-VL-72 B。作者将最大搜索迭代设置为20。在每次搜索迭代中,使用组中的每个模型来生成一个后续的候选推理路径,以平衡搜索探索和利用。

实验

作者采用四种流行的MLLM作为基线模型,在基线Qwen 2-VL-7 B和LLaMA-3. 2 11 B-Vision-Instruct上进行实验,以检验作者的CoMCTS的搜索有效性,并在基线Qwen 2-VL-2B和LLaVANeXT-8B上研究CoMCTS搜索数据的泛化。集体SFT实验的批量大小为128,学习率为1 e-5,训练时间为2个epoch。对于Qwen 2-VL-7 B,采用5e-6的较小学习率以稳定训练。

可以观察到,用Mulberry-260 k训练,作者的模型(即,Mulberry 2B和Mulberry-8B)增强了Qwen 2-VL-2B和LLaVANeXT-8B,在8个基准上平均增益为+5.4%和+11.0%,证明了CoMCTS搜索数据的泛化。

CoMCTS的消融研究。作者使用强大的GPT-4o作为基线,研究了集体学习组中的每个模型如何对整体树搜索性能做出贡献。基线GPT-4 o在没有树搜索的情况下工作得不是很好。在最后,包括所有四个模型在建议的CoMCTS显然表现最好,即80.2%,验证了集体学习的有效性推理树搜索。

案例

-

QVQ

暂无技术报告,故仅展示其测试得分

想象一下,人工智能能够像物理大师一样,在面对复杂的物理问题时,有条不紊地推理出解决方案。这一愿景激励作者在 Qwen2-VL-72B 的基础上创建了 QVQ - 一个用于多模态推理的开放重量模型。QVQ 代表着人工智能在视觉理解和复杂问题解决能力方面的重大飞跃。与 Qwen2-VL-72B-Instruct 相比,QVQ 在 MMMU 上获得了 70.3 分,并在数学相关的基准测试中取得了大幅提升。通过细致的逐步推理,QVQ 在视觉推理任务中表现出更强的能力,尤其是在需要复杂分析思维的领域中表现出色。

作者在 4 个数据集上对 QVQ-72B-Preview 进行了评估,其中包括

- MMMU:大学级别的多学科多模态评估数据集,旨在评估模型的视觉相关综合理解和推理能力。

- MathVista: 以数学为重点的视觉推理测试集,用于评估利用谜题测试图形进行逻辑推理、利用函数图形进行代数推理以及利用学术论文数字进行科学推理等能力。

- MathVision: 源自真实数学竞赛的高质量多模态数学推理测试题集,与 MathVista 相比,具有更高的问题多样性和学科广度。

- OlympiadBench: 奥林匹克竞赛级双语多模态科学基准测试集,包含来自奥林匹克数学和物理竞赛(包括中国高考)的 8,476 个问题。每个问题都附有专家级注释,详细说明了逐步推理的过程。

其中,QVQ-72B-Preview 在 MMMU 基准测试中取得了 70.3 分的骄人成绩,大大超过了其前身 Qwen2-VL-72B-Instruct。此外,在其余三个以数学和科学问题为重点的基准测试中,该模型也表现出了卓越的性能,有效地缩小了与最先进的 o1 模型之间的差距。

-

QwQ

暂无技术报告,故仅展示其测试得分

具体而言,QwQ在这些基准测试中表现出色,在GPQA测试中取得了65.2%的优异成绩,展示了其研究生水平的科学推理能力;在AIME测试中取得了50.0%的优异成绩,彰显了其强大的数学问题解决能力;在MATH-500测试中取得了90.6%的优异成绩,展示了其对不同主题的卓越数学理解能力;在LiveCodeBench测试中取得了50.0%的优异成绩,验证了其在真实世界场景中的强大编程能力。这些成绩突显了 QwQ 在分析和解决问题能力方面的显著进步,尤其是在需要深入推理的技术领域。

- GPQA: GPQA:毕业水平的谷歌验证问答基准,这是一个通过小学水平的问题来评估科学问题解决能力的挑战性基准。

- AIME: 美国邀请数学评估,测试数学问题解决能力,包括算术、代数、计数、几何、数论和概率以及其他中学数学主题。

- MATH-500: MATH 基准的 500 个测试案例,这是一个测试数学解题能力的综合数据集。

- LiveCodeBench: 在真实世界编程场景中评估代码生成和问题解决能力的挑战性基准。

-

Deepseek-R1

DeepSeek-R1-Lite 目前仍处于迭代开发阶段,仅支持网页使用,之后,正式版 DeepSeek-R1 模型将完全开源,将公开技术报告,并部署 API 服务。

DeepSeek 全新研发的推理模型 DeepSeek-R1-Lite 预览版已经正式上线。所有用户均可登录官方网页 (chat.deepseek.com),一键开启与 R1-Lite 预览版模型的超强推理对话体验。

DeepSeek R1 系列模型使用强化学习训练,推理过程包含大量反思和验证,思维链长度可达数万字。该系列模型在数学、代码以及各种复杂逻辑推理任务上,取得了媲美 o1-preview 的推理效果,并为用户展现了 o1 没有公开的完整思考过程。

DeepSeek-R1-Lite 的推理过程长,并且包含了大量的反思和验证。下图展示了模型在数学竞赛上的得分与测试所允许思考的长度紧密相关。

-

红色实线展示了模型所能达到的准确率与所给定的推理长度呈正相关;

-

相比传统的多次采样+投票(Majority Voting),模型思维链长度增加展现出了更高的效率。

-

用户可登录 chat.deepseek.com,在输入框中选择“深度思考”模式,即可开启与 DeepSeek-R1-Lite 预览版的对话。

“深度思考” 模式专门针对数学、代码等各类复杂逻辑推理问题而设计,相比于普通的简单问题,能够提供更加全面、清晰、思路严谨的优质解答,充分展现出较长思维链的更多优势。

-

GLM-Zero

智谱AI预计未来将全面开源GLM-Zero,敬请期待。

2024年12 月 31 日,智谱宣布深度推理模型 GLM-Zero 的初代版本 GLM-Zero-Preview 上线。据官方介绍,这是智谱首个基于扩展强化学习技术训练的推理模型。

GLM-Zero-Preview 专注于增强模型推理能力,擅长处理数理逻辑、代码和需要深度推理的复杂问题。同基座模型相比,GLM-Zero-Preview 在不显著降低通用任务能力的情况下,在专家任务能力方面表现大幅提升。其在 AIME 2024、MATH500 和 LiveCodeBench 评测中,效果与 OpenAI-o1-Preview 相当。

-

总结

OpenAI的o1模型代表了人工智能领域在推理能力方面的一个重要进步。通过强化学习和思维链技术的应用,o1能够在处理复杂问题时表现出类似于人类的深思熟虑的过程。模型在训练过程中会逐步构建内部的思路链,尝试不同的策略,并通过不断的试错和反馈来优化其推理路径。这种能力使得o1在科学、数学和编程等需要高级逻辑推理的领域表现出色,甚至能够达到与领域专家相媲美的水平。尽管o1在直接执行浏览器或系统操作方面的功能尚未实现,但其在文本交互中的问题解答和分析能力已经显著提升,为多个行业的应用提供了广阔的可能性。随着技术的不断发展,o1模型有望在更多领域发挥重要作用,推动人工智能技术的进一步突破.

-

如果你对人工智能的最新进展感兴趣,或者对如何利用技术解决复杂问题充满好奇,那么请不要错过我们的内容!我们致力于分享前沿的科技动态和深入的分析,帮助你更好地理解人工智能的潜力和应用。如果你喜欢我们的文章,请点赞、关注和收藏,以便获取更多相关资讯。你的支持是我们不断进步的动力,感谢你的关注!

351

351

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?