开源大模型部署——ollama

前言

本文是基于ollama来部署llama3大模型的一个例子,在ollama官网库中有其他模型(qwen2、phi3等)选择。

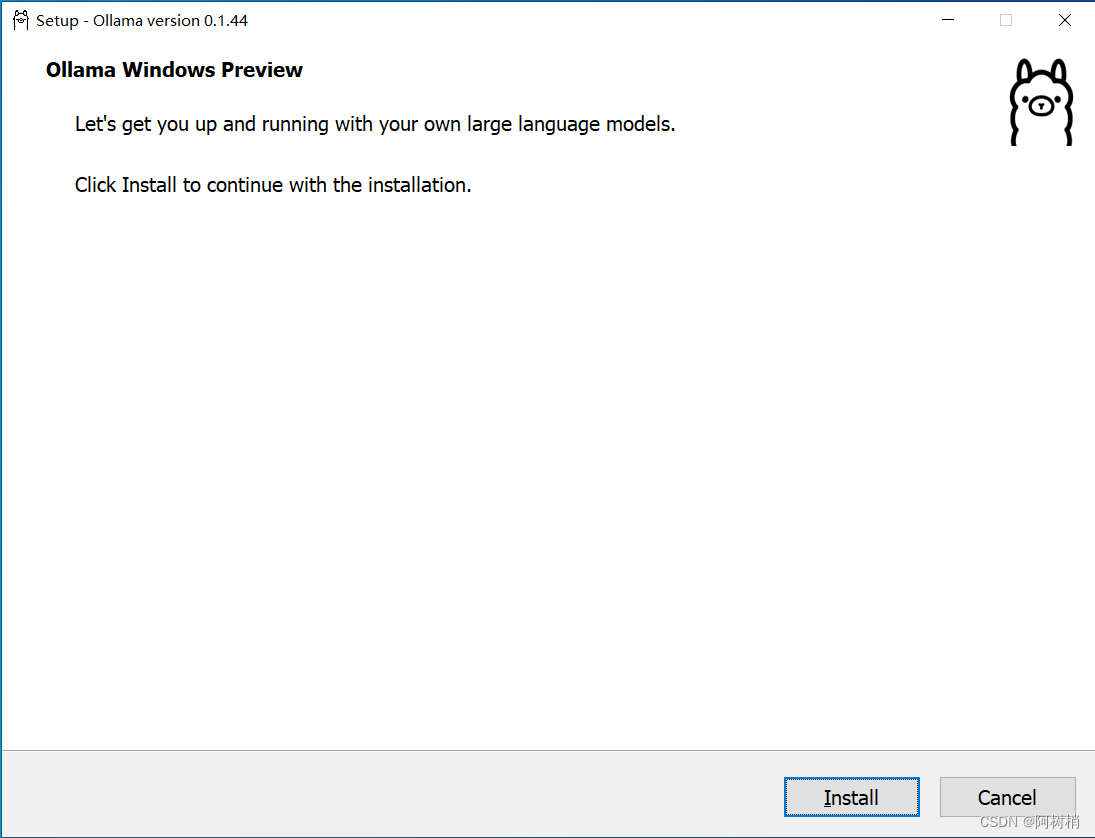

一、下载并安装ollama

Ollama官网下载地址:https://ollama.com/download

安装成功后打开cmd输入ollama,若出现如下内容,则代表安装成功。

C:\Users\78609>ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

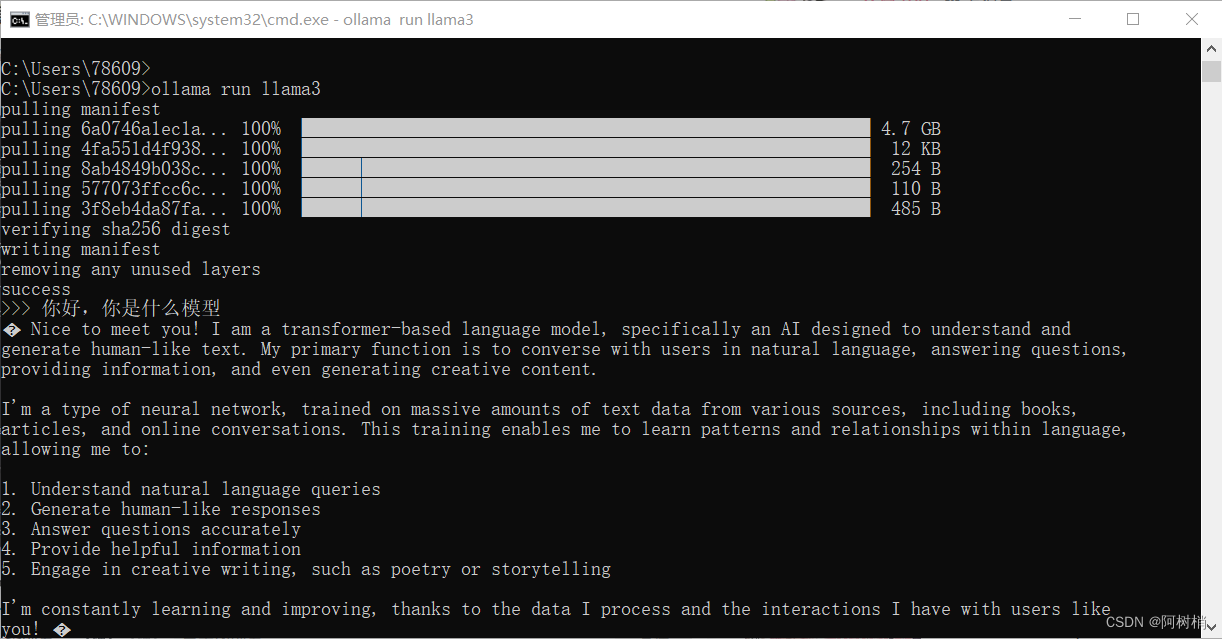

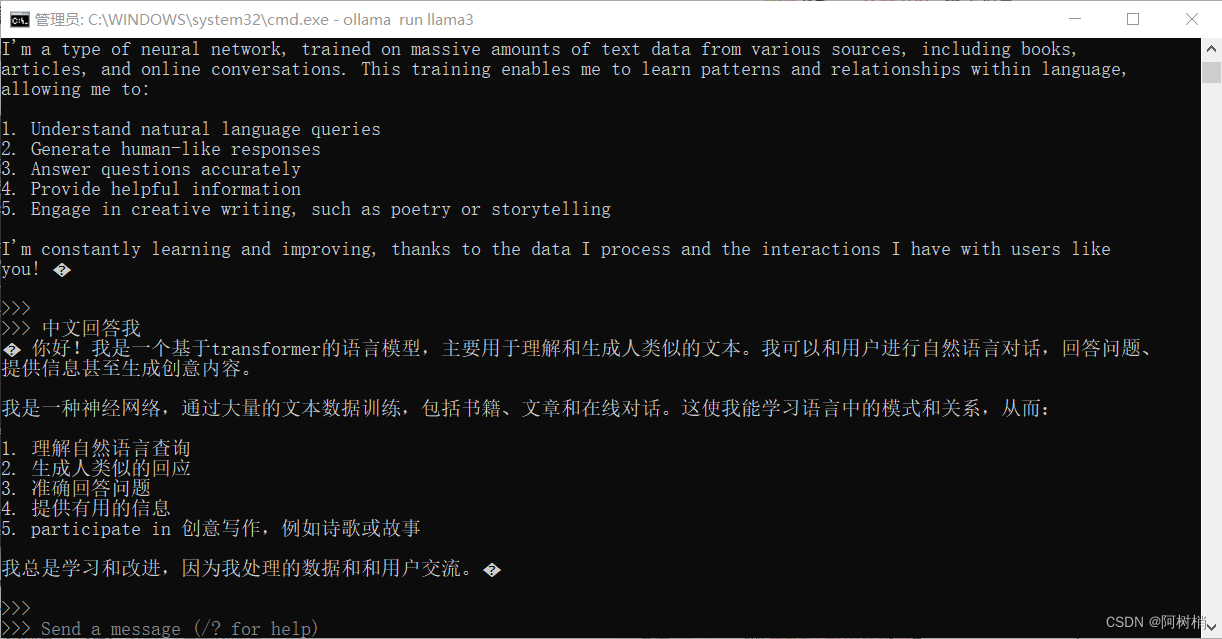

二、下载模型(以llama3的4b模型为例)

在cmd中输入

ollama run llama3

下载成功后就可以进行使用。

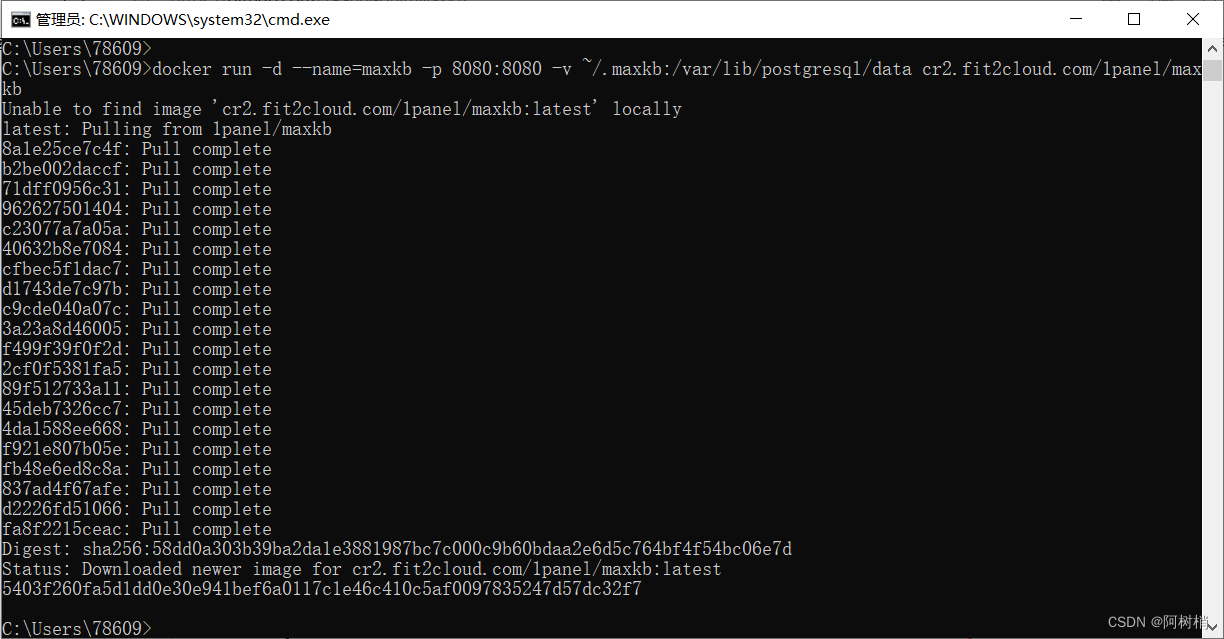

三、部署前端界面(MaxKB)

电脑上要有docker

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data cr2.fit2cloud.com/1panel/maxkb

MaxKB在GitHub上的代码

MaxKB在Ubuntu 22.04 / CentOS 7部署&离线部署教程

四、使用web界面部署模型

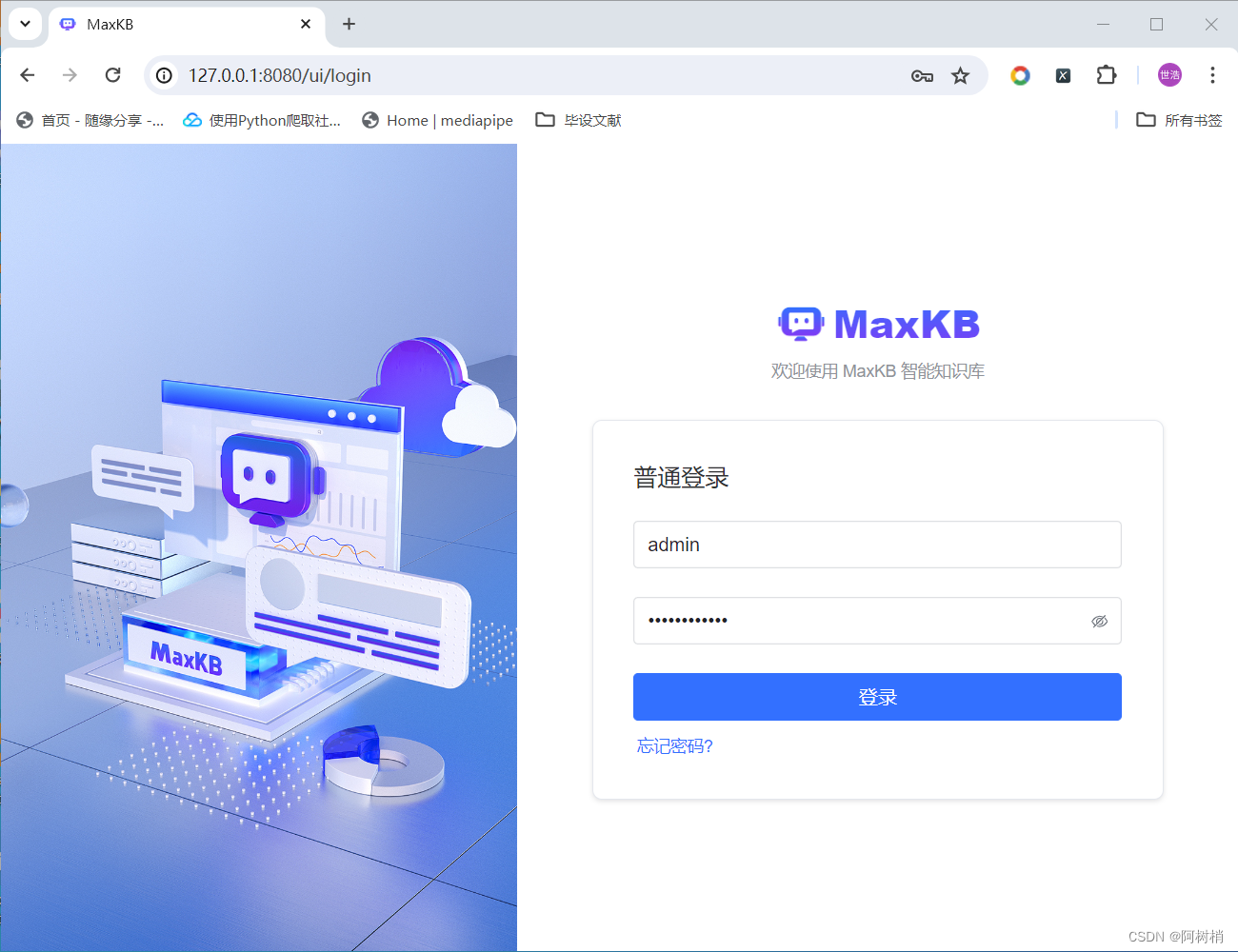

输入网址http://127.0.0.1:8080/

输入用户名: admin密码: MaxKB@123..

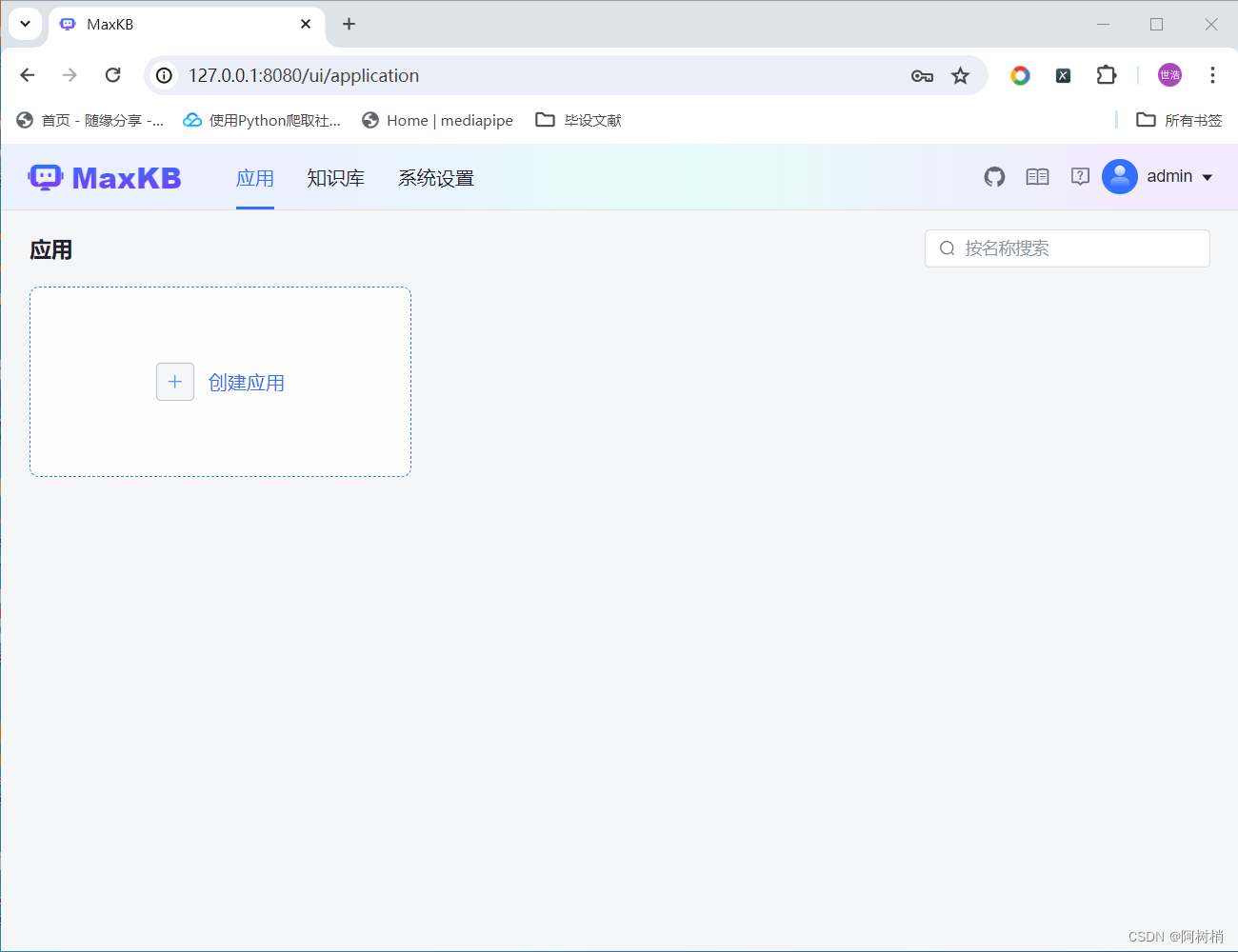

登录成功后创建应用

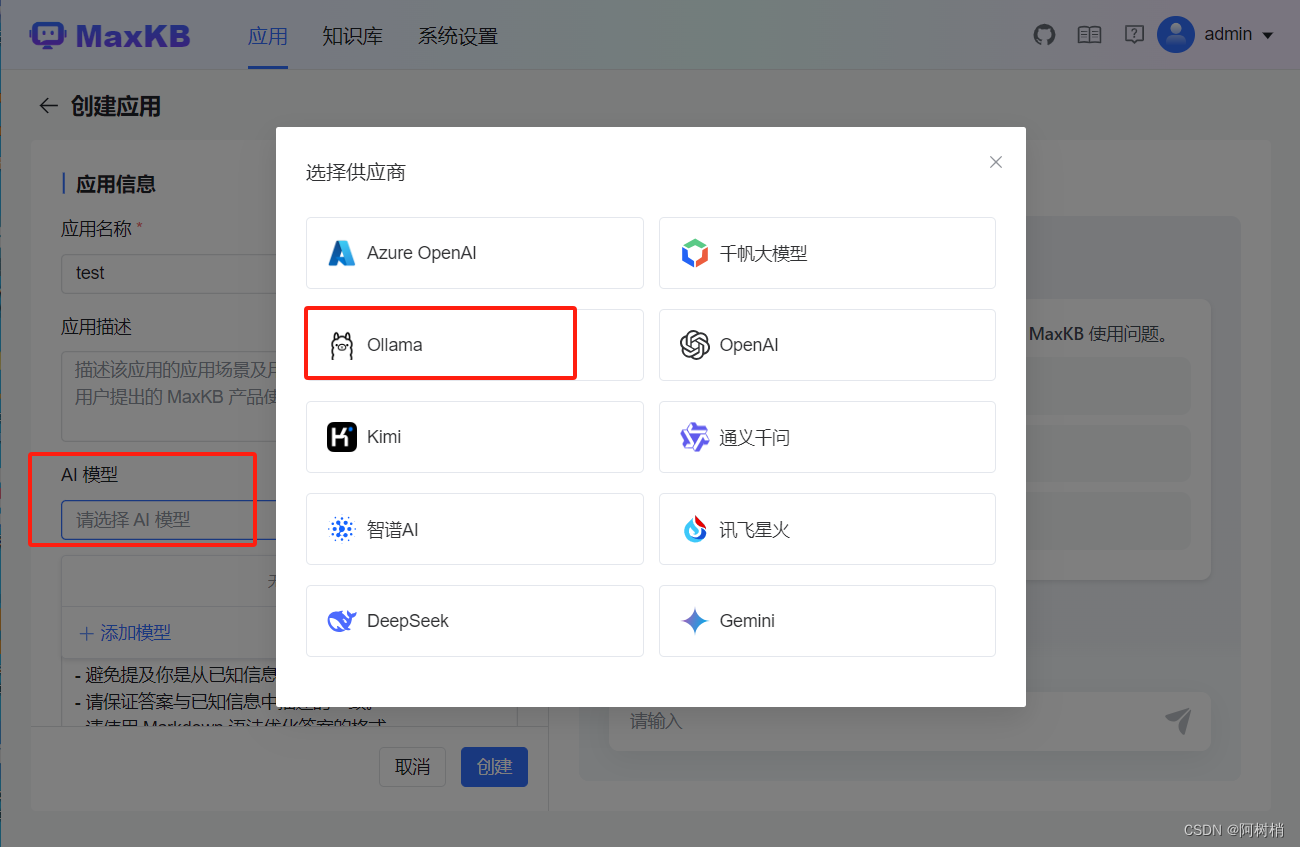

选择模型

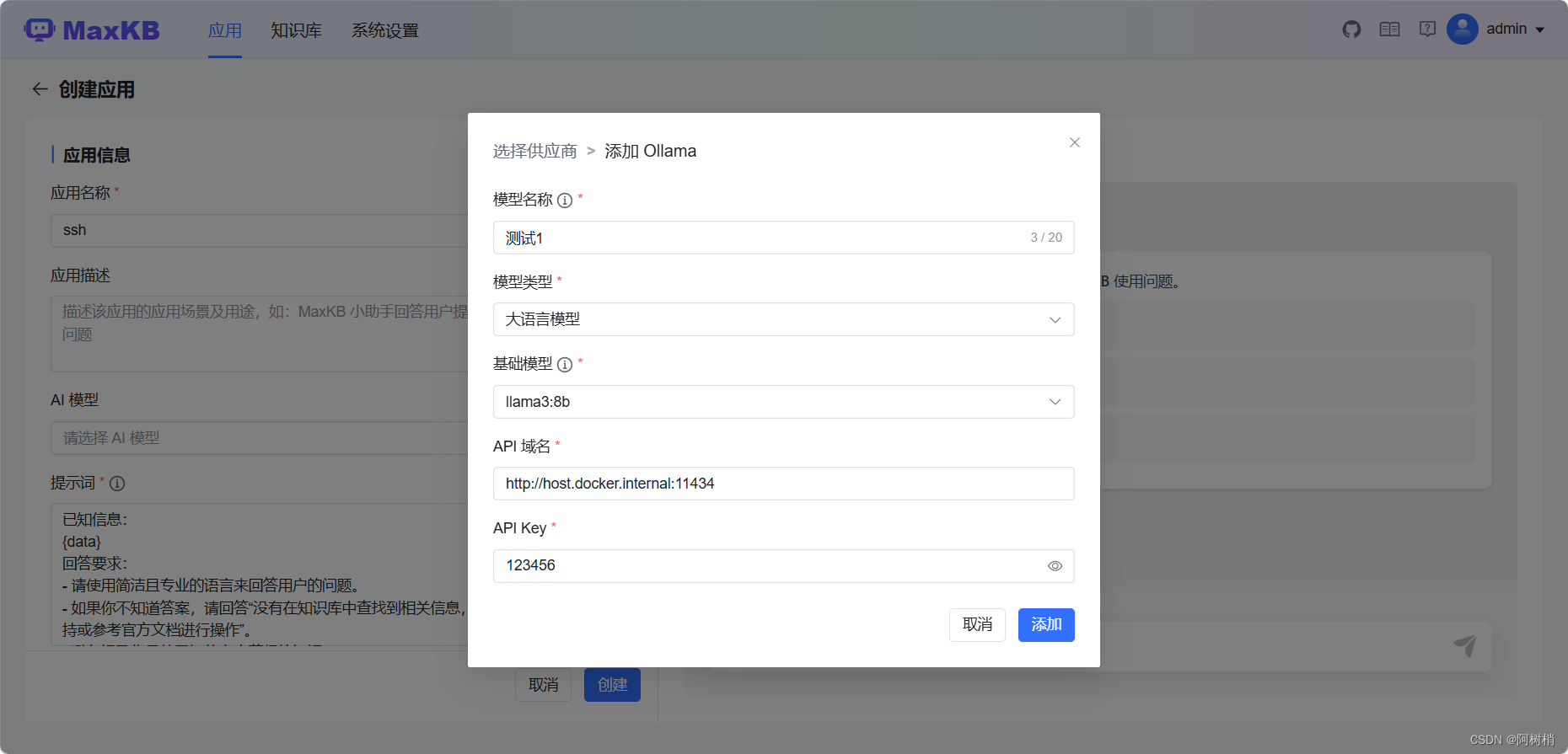

注意注意

MaxKB 版本为 0.9.0,API 域名格式为:http://您ollama所在服务的ip地址:您ollama的端口号/v1 MaxKB 版本为 0.9.1及之后的版本API 域名格式:http://您ollama所在服务的ip地址:您ollama的端口号/ 注意:API 域名不可使用 127.0.0.1 或 localhost。

API域名填写为http://host.docker.internal:11434

演示效果

五、注意事项

问题1:API 域名无效

解决方法:API域名填写为http://host.docker.internal:11434

问题2:用docker安装之后,然后重启容器之后数据全部丢失,能不能不让丢失。确定是用 docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb 启动的。

解决方法:启动的时候添加 --privileged=true

比如将数据挂载到D盘

docker run -d --name=maxkb -p 8080:8080 -v D:/maxkb/data:/var/lib/postgresql/data --privileged=true 1panel/maxkb

如果启动还是报错,那就需要使用wsl子系统

Windows PowerShell命令行窗口在Windows系统开始那里

先安装WSL(管理员运行Windows PowerShell:wsl --update)

安装Ubuntu(管理员运行Windows PowerShell:wsl --install -d Ubuntu),运行后要设置帐号密码,注:输入密码时,密码不会显示在命令行窗口,不要惊慌,实际已设置好了。

官网下载安装Docker后注册帐号(需科学上网),在Docker软件设置里,找到“Resource”项→"WSL integration"项,将“Enable integration with my default wSL distro”打勾,将“Ubuntu”打开。后连接Docker(管理员运行Windows PowerShell:docker login)

Docker是国外的软件,日常使用需加速,不加速就得科学上网(但这样不切实际),所以在Docker设置里,找到“Docker Engine”,设置Docker镜像加速代码:

注意:一个逗号都不能少,直接复制这个就可以了。

“builder”: {

“gc”: {

“defaultKeepStorage”: “20GB”,

“enabled”: true

}

},

“experimental”: false,

“registry-mirrors”: [

“https://dockerproxy.com ”,

“https://docker.mirrors.ustc.edu.cn ”,

“https://docker.nju.edu.cn ”

]

安装MaxKB镜像(点击Ubuntu图标后出现命令行窗口,后输入命令行:

docker run -d --name=maxkb -p 8080:8080 -v /maxkb:/var/lib/postgresql/data --privileged=true 1panel/maxkb

总结

本文作为开源大模型部署方法的部署手册,供大家参考。

更具体的教程可以参考【教程】Windows系统本地部署Ollama+MaxKB安装教程

MaxKB 对接Ollama模型时,提示 API 域名不可用

b站视频:部署开源大模型

我用docker安装之后,然后重启容器之后数据全部丢失

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?