昇思25天学习打卡营第6天|网络构建

前言

非常感谢华为昇思大模型平台和CSDN邀请体验昇思大模型!从今天起,笔者将以打卡的方式,将原文搬运和个人思考结合,分享25天的学习内容与成果。为了提升文章质量和阅读体验,笔者会将思考部分放在最后,供大家探索讨论。同时也欢迎各位领取算力,免费体验昇思大模型!

网络构建

神经网络模型是由神经网络层和Tensor操作构成的,mindspore.nn提供了常见神经网络层的实现,在MindSpore中,Cell类是构建所有网络的基类,也是网络的基本单元。一个神经网络模型表示为一个Cell,它由不同的子Cell构成。使用这样的嵌套结构,可以简单地使用面向对象编程的思维,对神经网络结构进行构建和管理。

下面我们将构建一个用于Mnist数据集分类的神经网络模型。

%%capture captured_output

# 实验环境已经预装了mindspore==2.3.0rc1,如需更换mindspore版本,可更改下面mindspore的版本号

!pip uninstall mindspore -y

!pip install -i https://pypi.mirrors.ustc.edu.cn/simple mindspore==2.3.0rc1

import mindspore

from mindspore import nn, ops

定义模型类

当我们定义神经网络时,可以继承nn.Cell类,在__init__方法中进行子Cell的实例化和状态管理,在construct方法中实现Tensor操作。

construct意为神经网络(计算图)构建,相关内容详见使用静态图加速。

class Network(nn.Cell):

def __init__(self):

super().__init__()

self.flatten = nn.Flatten()

self.dense_relu_sequential = nn.SequentialCell(#依序搭建网络模型

nn.Dense(28*28, 512, weight_init="normal", bias_init="zeros"),#搭建FCN网络,输入通道数为28*28(对应MNIST训练图像为28*28尺寸的图像),输出通道数为512

nn.ReLU(),

nn.Dense(512, 512, weight_init="normal", bias_init="zeros"),#输入通道数=输出通道数=512

nn.ReLU(),

nn.Dense(512, 10, weight_init="normal", bias_init="zeros")# 输入通道数为512,输出通道数为10(对应MNIST分类结果为0-9共十种情况)

)

def construct(self, x):

x = self.flatten(x) #将数据的数据展平

logits = self.dense_relu_sequential(x) #输入数据进入网络模型中

return logits

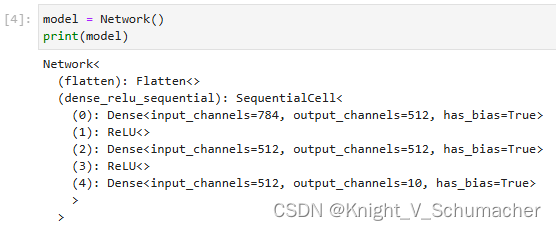

构建完成后,实例化Network对象,并查看其结构。

model = Network()

print(model) #实例化模型并查看结构

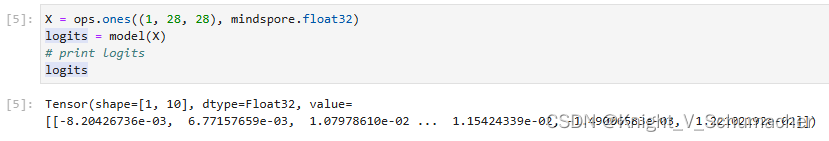

我们构造一个输入数据,直接调用模型,可以获得一个十维的Tensor输出,其包含每个类别的原始预测值。

model.construct()方法不可直接调用。

X = ops.ones((1, 28, 28), mindspore.float32) #生成(C, H, W)为(1, 28, 28)的全一矩阵,矩阵中元素的数值类型为float32

logits = model(X) #将输入数据放入模型中

# print logits

logits #得到十类中每一类结果的置信度

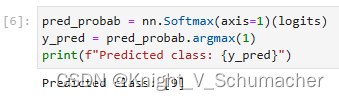

在此基础上,我们通过一个nn.Softmax层实例来获得预测概率。

pred_probab = nn.Softmax(axis=1)(logits) #将分类结果放入维度为1的softmax层中

y_pred = pred_probab.argmax(1)

print(f"Predicted class: {y_pred}") #得到分类结果为9

模型层

本节中我们分解上节构造的神经网络模型中的每一层。首先我们构造一个shape为(3, 28, 28)的随机数据(3个28x28的图像),依次通过每一个神经网络层来观察其效果。

input_image = ops.ones((3, 28, 28), mindspore.float32) #生成(C, H, W)为(3, 28, 28)的全一矩阵,矩阵中元素的数值类型为float32

print(input_image.shape)

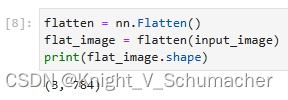

nn.Flatten

实例化nn.Flatten层,将28x28的2D张量转换为784大小的连续数组。

flatten = nn.Flatten()

flat_image = flatten(input_image) #将输入的(28, 28)尺寸的图像展平为28*28的一位数组

print(flat_image.shape)

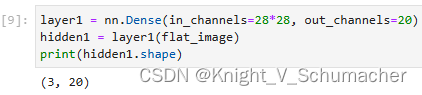

nn.Dense

nn.Dense为全连接层,其使用权重和偏差对输入进行线性变换。

layer1 = nn.Dense(in_channels=28*28, out_channels=20)#使用全连接层,输入维度为28*28,输出维度为20

hidden1 = layer1(flat_image)#隐藏层尺寸为(3, 20)

print(hidden1.shape)

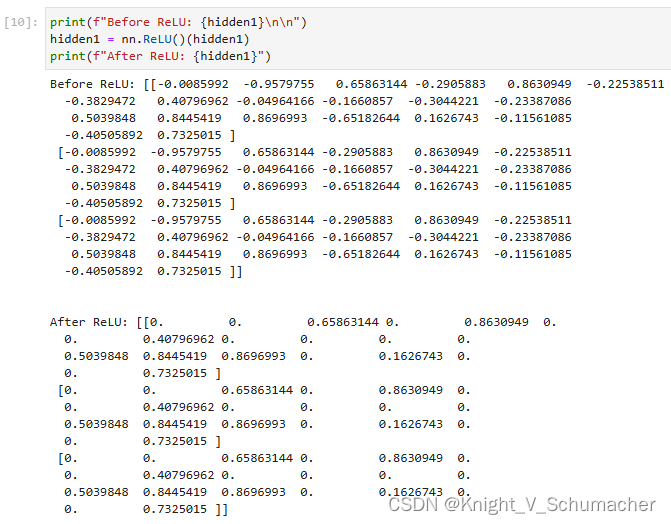

nn.ReLU

nn.ReLU层给网络中加入非线性的激活函数,帮助神经网络学习各种复杂的特征。

print(f"Before ReLU: {hidden1}\n\n")

hidden1 = nn.ReLU()(hidden1)#对隐藏层采用激活函数激活

print(f"After ReLU: {hidden1}")

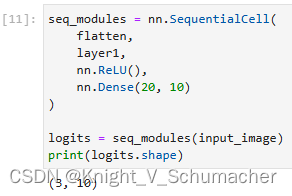

nn.SequentialCell

nn.SequentialCell是一个有序的Cell容器。输入Tensor将按照定义的顺序通过所有Cell。我们可以使用SequentialCell来快速组合构造一个神经网络模型。

seq_modules = nn.SequentialCell(

flatten,

layer1,

nn.ReLU(),

nn.Dense(20, 10)

)

logits = seq_modules(input_image)

print(logits.shape)

nn.Softmax

最后使用nn.Softmax将神经网络最后一个全连接层返回的logits的值缩放为[0, 1],表示每个类别的预测概率。axis指定的维度数值和为1。

softmax = nn.Softmax(axis=1)

pred_probab = softmax(logits)

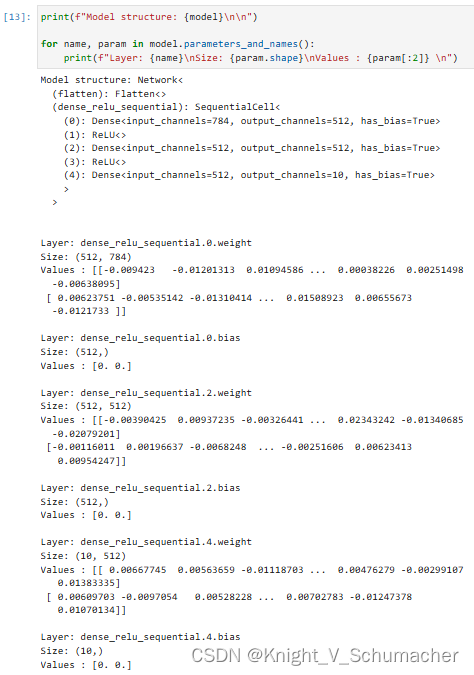

模型参数

网络内部神经网络层具有权重参数和偏置参数(如nn.Dense),这些参数会在训练过程中不断进行优化,可通过 model.parameters_and_names() 来获取参数名及对应的参数详情。

print(f"Model structure: {model}\n\n")

for name, param in model.parameters_and_names():

print(f"Layer: {name}\nSize: {param.shape}\nValues : {param[:2]} \n")#按照上文搭建的模型,依序输出模型中每一层的参数

更多内置神经网络层详见mindspore.nn API。

个人任务打卡(读者请忽略)

个人理解与总结

本章节主要介绍了搭建卷积神经网络的模型中最基础最常见的操作,如展平、全连接、ReLU激活函数、Softmax等基本层的搭建代码及其功能。以MNIST数据集的输入数据为例,输入图像的(C, H, W)为(1, 28, 28),将图像展平为一维数组后放入全连接层和ReLU激活函数所组建的神经网络中,其结果通过Softmax归一化,将置信度最高的选项作为其最终的分类结果。同时,昇思大模型还支持model.parameters_and_names() 获取神经网络的参数详情,帮助研究人员梳理神经网络模型的学习过程。

375

375

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?