《ImageNet Classification with Deep Convolutional Neural Networks》论文解读

本文出自NIPS2012,作者是大神Alex Krizhevsky,属于多伦多大学Hinton组。

概述

本文提出的神经网络结构被成为AlexNet,在我最近的研究学习中发现,这一结构及其变种在很多任务中都有使用,回过头来重温一下这篇论文仍然是有必要的。归根到底,本文网络结构相对较浅,而且能够提取到比较丰富的特征,而很多任务的数据集无法达到ImageNet的规模,使用AlexNet是比较好的特征提取方法。本文相对较“老”,其中的很多技术早已耳熟能详,有兴趣的可以去阅读相关资料。

结构

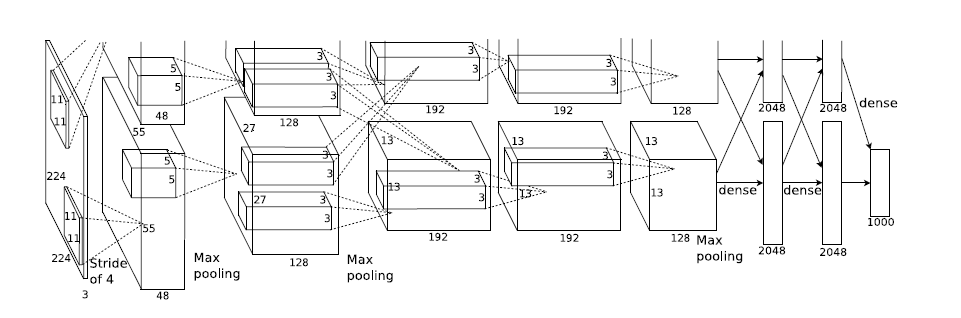

AlexNet有5个卷积层和3个全连接层,作者发现移除任意一层都会降低最终的效果。网络结构如图:

这个网络前面5层是卷积层,后面三层是全连接层,最终softmax输出是1000类。具体分析第一层:

输入图片为224*224*3,卷积核大小为11*11*3,步长为4,输出为55*55*96。

ReLU

AlexNet使用ReLU代替了传统的激活函数,而现在ReLU已经广泛地使用在了各种CNN结构中。关于ReLU这里已经没必要讲了,在2012年算是新颖的技术,到今天已经是遍地开花了。

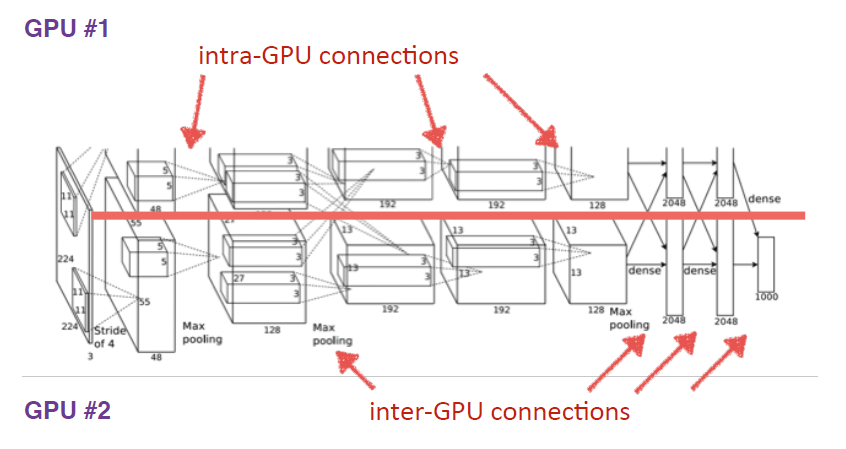

Multiple GPU

AlexNet使用两块GTX580显卡进行训练,两块显卡只需要在特定的层进行通信,当今的深度学习已经基本都是在显卡上完成的。两块GPU各训练网络的一部分,在第二个卷积层和全连接层才需要互相通信。

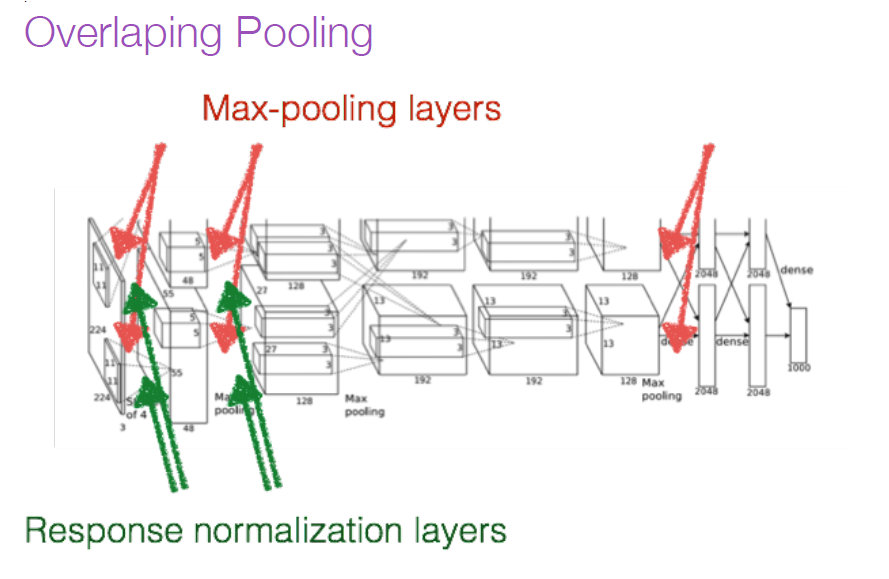

在卷积层之间还需要加上Local Response Normalization和Overlap Pooling。

Local Response Normalization

ReLU本来是不需要对输入进行标准化,但本文发现进行局部标准化能提高性能。

AlexNet是2012年NIPS论文提出的一种深度卷积神经网络,其5个卷积层和3个全连接层的设计显著提高了ImageNet分类效果。ReLU激活函数、多GPU训练、局部响应归一化和重叠池化等技术在此模型中得到应用,减少了过拟合并提升了性能。数据增强和Dropout策略进一步优化了训练过程。

AlexNet是2012年NIPS论文提出的一种深度卷积神经网络,其5个卷积层和3个全连接层的设计显著提高了ImageNet分类效果。ReLU激活函数、多GPU训练、局部响应归一化和重叠池化等技术在此模型中得到应用,减少了过拟合并提升了性能。数据增强和Dropout策略进一步优化了训练过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2735

2735

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?