19.1 计算机概述

之前的很多篇文章已经大量涉及了各种各样的硬件和技术,本篇将更加全面、系统、深入地阐述计算机的硬件组成和体系架构,从而形成自上而下的计算机体知识体系。本篇主要阐述以下内容:

- 计算机基础。

- 电子电路基础。

- 计算机硬件。

- 计算机架构和组织。

- 计算机硬件运行机制。

- 计算机硬件的UE封装和实现。

19.1.1 计算机是什么

计算机(Computer)是什么?计算机是一种通用设备,可以编程处理信息,并产生有意义的结果。它是一种被广泛使用且使我们的工作变得轻松的设备,是被动型机器,需要我们输入指令或任务来执行,从而获得我们需要的结果。

一个基础的计算机。

简单的单处理器计算机如下,提供了传统单处理器计算机内部结构的分层视图。有四个主要结构部件:CPU、主内存、I/O、系统链接。

如下图所示,向用户提供应用程序时使用的硬件和软件可以以分层或分层的方式查看。这些应用程序的用户,即最终用户,通常不关心计算机的架构,因此终端用户根据应用来查看计算机系统。该应用程序可以用编程语言表示,并由应用程序程序员开发,将应用程序开发为一组完全负责控制计算机硬件的处理器指令将是一项极其复杂的任务。为了简化此任务,提供了一组系统程序。

其中一些程序被称为实用程序。这些实现了常用的功能,有助于程序创建、文件管理和I/O设备控制。程序员在开发应用程序时使用这些工具,应用程序在运行时调用实用程序来执行某些功能。最重要的系统程序是操作系统,操作系统向程序员隐藏了硬件的细节,并为程序员提供了使用系统的方便界面。它充当中介,使程序员和应用程序更容易访问和使用这些设施和服务。

硬件之中,最重要的部件是芯片,其制造工艺如下图。从硅锭切片后,将空白晶片经过20至40个步骤,以形成图案化晶片。然后用晶片测试仪对这些图案化的晶片进行测试,并绘制出良好零件的地图。然后将晶片切成小片,在该图中,一个晶片生产了20个管芯,其中17个管芯通过了测试(X表示模具不良)。在这种情况下,好模具的产量为17/20,即85%。然后将这些好的模具粘结到包装中,并在将包装好的零件运送给客户之前再次进行测试。最终测试中发现一个包装不良的零件。

19.1.2 计算机结构

典型的台式计算机有三个主要物理部件——CPU(中央处理器)、主存储器和硬盘。CPU通常也被称为处理器或简单的机器,是计算机的大脑,是计算机的主要部分,将程序作为输入并执行。主存储器用于存储程序在执行过程中可能需要的数据(信息存储),处理器本身的存储空间有限。当电源关闭时,处理器和主存储器会丢失所有数据,但硬盘代表永久存储,程序、数据、照片、视频和文档等数据都存储在硬盘中。

下图显示了三个组件的简化框图。除了这些主要组件之外,还有一系列与计算机相连的外围组件,例如键盘和鼠标连接到计算机。它们从用户处获取输入,并将其传递给处理器上运行的程序。

类似地,为了显示程序的输出,处理器通常将输出数据发送到监视器,监视器可以以图形方式显示结果,也可以使用打印机打印结果。最后,计算机可以通过网络连接到其他计算机。所有外围设备的方框图如下所示。

19.1.3 计算机运行机制

不管底层技术如何,我们需要理解的一个基本概念是,计算机从根本上来说是一台愚蠢的机器。与我们的大脑不同,它没有被赋予抽象的思想、理性和良知。至少在目前,计算机不能自己做出非常复杂的决定,能做的就是执行一个程序。尽管如此,计算机之所以如此强大,是因为它们非常擅长执行程序,每秒可以执行数十亿条基本指令。计算机与人脑的比较如下表所示。

| 特性 | 计算机 | 人脑 |

|---|---|---|

| 智力 | 愚蠢 | 智能 |

| 算力 | 超快 | 慢 |

| 是否疲倦 | 绝不 | 一段时间后 |

| 是否厌倦 | 绝不 | 几乎总是 |

计算机无法理解人类语言,只能理解二进制数据,也就是0和1、True和False、On和Off,这些状态是通过晶体管(transistor)实现的。晶体管是用于存储2个值(1和0或开和关)的微型设备,如果晶体管打开,它的值为 1,如果它关闭,则值为 0。

例如,一个存储芯片包含数亿甚至数十亿个晶体管,每个晶体管都可以单独打开或关闭。当极少量的电流通过晶体管时,它保持状态1,当没有电流时,晶体管的状态为0。具体示例:

1 : 1

2 : 10

3 : 11

a : 01100001

A : 01000001

U : 01010101

Hello : 01001000 01100101 01101100 01101100 01101111

Hello World! : 01001000 01100101 01101100 01101100 01101111 00100000 01010111 01101111 01110010 01101100 01100100 00100001

问题在于,以上二进制代码对于人类而言,太难以理解了,此时需要各类计算机软件做翻译的桥梁作用。软件是一组指令,告诉计算机要做什么、什么时候做以及如何做。下图显示了操作流程。第一步是用高级语言(C或C++)编写程序,第二步涉及编译它,编译器将高级程序作为输入,并生成包含机器指令的程序,该程序通常称为可执行文件或二进制文件。注意,编译器本身是一个由基本机器指令组成的程序。

假设要执行2+2的指令,那么我们必须给计算机指令:

- 第1步:取2个值。

- 第2步:存储该2值。

- 第3步:使用 + 运算符对它们进行相加。

- 第4步:存储结果。

为 + 运算符提供了单独的说明,以便计算机在遇到 + 符号时知道如何进行加法。那么谁来转换这段代码呢?答案是解释器(interpreter),它把我们的语言代码转换成计算机可以理解的机器语言。同理,输入和输出数据也需要依赖特定的软件和解释器。

就像任何语言都有有限的单词一样,处理器可以支持的基本指令/基本命令的数量也必须是有限的,这组指令通常称为指令集(instruction set),基本指令的一些示例是加法、减法、乘法、逻辑或和逻辑非。请注意,每条指令需要处理一组变量和常量,最后将结果保存在变量中。这些变量不是程序员定义的变量,是计算机内的内部位置。

19.1.4 计算机设计准则

计算机设计是组件相互关联的结构。设计者一次处理特定级别的系统,并且在不同级别存在不同类型的问题。在每一层,设计者都关心结构和功能,结构是相互关联的用于通信的各个组件的骨架,功能是系统中涉及的活动。 以下是计算机设计中的问题:

- 无限速度的假设: 不能假设计算机的无限速度,因为假设无限速度是不切实际的,也给设计者的思维带来了问题。

- 内存无限的假设: 就像计算机的速度一样,内存也不能假设为无限的,总是有限的。

- 内存和处理器之间的速度不匹配: 有时内存和处理器的速度可能不匹配,可能是内存速度更快或处理器速度更快。内存和处理器之间的不匹配会导致设计中出现问题。

- 处理错误和错误: 处理缺陷和错误是任何计算机设计者的巨大责任,缺陷和错误会导致计算机系统出现故障,有时这些错误可能更危险。

- 多处理器: 设计具有多个处理器的计算机系统会导致管理和编程的巨大任务,是计算机设计中的一大问题。

- 多线程: 具有多线程的计算机系统总是对设计者构成威胁,具有多个线程的计算机应该能够进行多任务和多处理。

- 共享内存: 如果一次要执行多个进程,则所有进程共享相同的内存空间。应该以特定的方式对其进行管理,以免发生冲突。

- 磁盘访问: 磁盘管理是计算机设计的关键,磁盘访问存在几个问题,系统可能不支持多磁盘访问。

- 更好的性能: 始终是一个问题,设计者总是试图简化系统以获得更好的性能来降低功耗和降低成本。

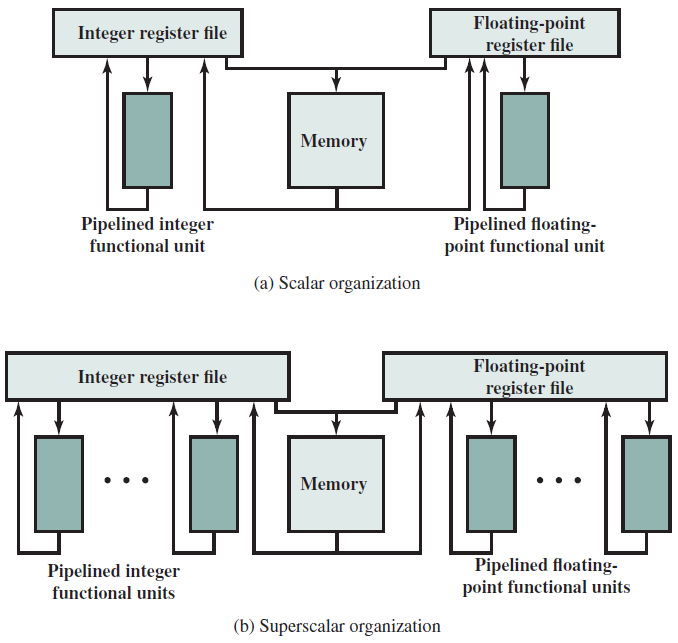

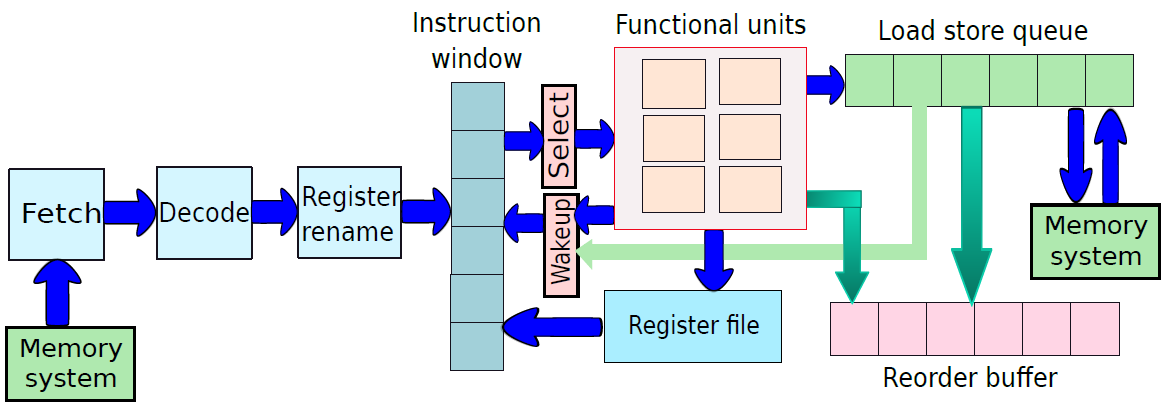

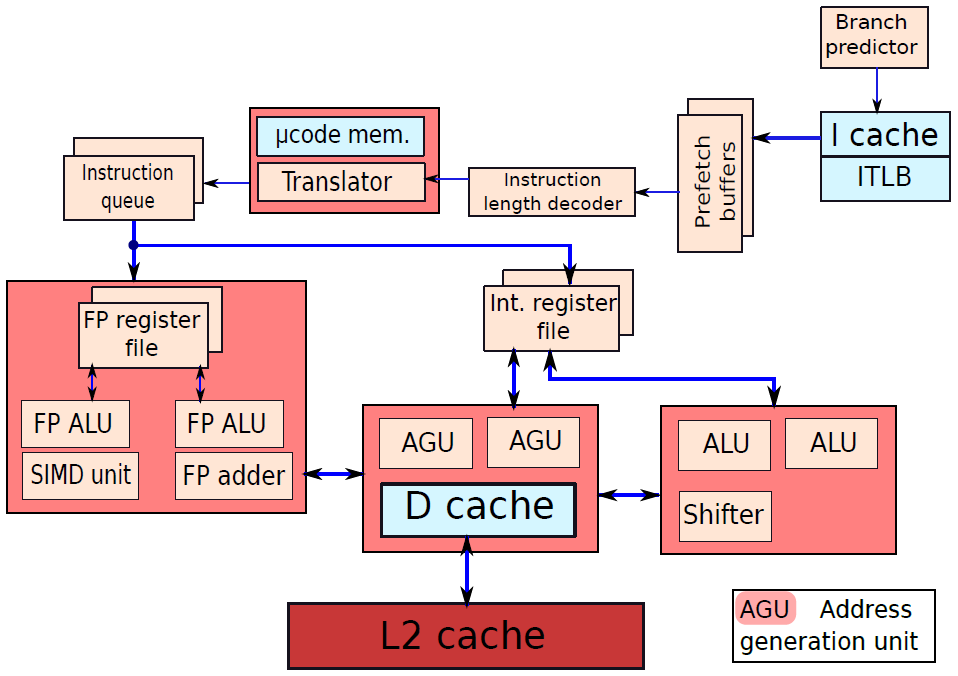

19.1.5 实用机器架构

下面阐述一下不同类型的实用机器的设计及架构。

- 哈佛架构

哈佛体系架构下图所示,有单独的结构来维护指令表和内存。指令表也被称为指令存储器,因为可以把它看作是专门为只保存指令而设计的专用存储器。内存保存程序所需的数据值,因此被称为数据存储器。处理指令的引擎分为两部分:控制和ALU,控制单元的工作是获取指令、处理指令并协调指令的执行。ALU代表算术逻辑单元,有专门的电路,可以计算算术表达式或逻辑表达式(and/or/NOT等)。

请注意,每台计算机都需要从用户/编程器处获取输入,并最终将结果传回编程器,可通过多种方法实现,例如我们如今使用的键盘和显示器。早期的计算机使用一组开关,最终结果打印在一张纸上。

- 冯诺依曼架构

约翰·冯·诺依曼提出了通用图灵完全计算机的冯·诺伊曼体系结构,实际上,Eckert和Mauchly于1946年基于该架构设计了第一台通用图灵完全计算机(有个小限制),称为ENIAC(电子数字积分器和计算器),该计算机用于计算美国陆军弹道研究实验室的火炮环表,后来在1949年被EDVAC计算机取代,该计算机也被美国陆军的弹道研究实验室使用。

作为ENIAC和EDVAC基础的基本冯·诺依曼架构如下图所示。指令表保存在内存中,图灵机的处理引擎被称为CPU(中央处理单元),包含程序计数器,其工作是获取新指令并执行它们。它有专用的功能单元来计算算术函数的结果,在内存位置加载和存储值,以及计算分支指令的结果。最后,与哈佛体系结构一样,CPU连接到I/O子系统。

这台机器的创新之处在于指令表存储在内存中,使用通常存储在内存中的同一组符号对每条指令进行编码。例如,如果内存存储十进制值,则每条指令都需要编码为十进制数字串。冯·诺依曼CPU需要解码每条指令,这个想法的核心是,指令被视为常规数据(内存值)。这个简单的想法实际上是设计优雅计算系统的一个非常强大的工具,被称为存储程序概念。

存储程序概念(stored program concept):程序存储在内存中,指令被视为常规内存值。

存储程序概念极大地简化了计算机的设计。由于内存数据和指令在概念上是以相同的方式处理的,所以我们可以有一个统一的处理系统和一个以相同方式处理指令和数据的内存系统。从CPU的角度来看,程序计数器指向一个通用内存位置,其内容将被解释为编码指令的内容,很容易存储、修改和传输程序,程序还可以在运行时通过修改自身甚至其他程序来动态更改其行为。这构成了当今复杂编译器的基础,这些编译器将高级C程序转换为机器指令。此外,许多现代系统(如Java虚拟机)动态地修改它们的指令以实现效率。

冯·诺伊曼机器或哈佛机器不像图灵机器那样拥有无限的内存,严格地说,它们并不完全等同于图灵机,对于所有实用的机器都是如此,它们需要足够的资源。然而,科学界已经学会接受这种近似。

19.2 计算机硬件基础

19.2.1 汇编语言

汇编语言可以广泛地定义为机器指令的文本表示。在构建处理器之前,我们需要了解不同机器指令的语义,在这方面,对汇编语言的严格研究将是有益的。汇编语言专用于ISA和编译器框架,因此,汇编语言有许多优点。本节将描述不同汇编语言变体的基本原理,一些通用概念和术语。随后,将描述针对基于ARM的处理器的ARM汇编语言,描述针对Intel/AMD处理器的x86汇编语言。

19.2.1.1 为什么用汇编语言?

先从软件开发者的视角阐述之。

人类懂得自然语言,如中文、英语和西班牙语。通过一些额外的训练,人类还可以理解计算机编程语言,如C或Java。然而,如前面所述,计算机是一台愚蠢的机器,不够聪明,无法理解人类语言(如英语)或编程语言(如C)中的命令,它只能理解零和一。因此,要给计算机编程,必须给它一个0和1的序列。事实上,一些早期的程序员曾经通过打开或关闭一组开关来编程计算机,打开一个开关对应于1,打开它意味着0。对于今天的大规模数百万行程序来说,不是一个可行的解决方案,需要另寻更好的方法。

因此,我们需要一个自动转换器,它可以将用C或Java等高级语言编写的程序转换为一系列0和1,称为机器代码(machine code)。机器代码包含一组称为机器指令的指令,每个机器指令都是由零和一组成的序列,并指示处理器执行特定的操作。可以将用高级语言编写的程序转换为机器代码的程序称为编译器(见下图)。

编译过程。

请注意,编译器是一个可执行程序,通常在应该为其生成机器代码的机器上运行。可能出现的一个自然问题是——谁编写了第一个编译器?

第一,鉴于编译器的普遍存在,几乎所有的程序都是用高级语言编写的,编译器用来将它们转换为机器代码,但这一规则也有重要的例外。请注意,编译器的作用有两方面:首先,它需要正确地将高级语言的程序翻译成机器指令;其次,它需要生成不占用大量空间且速度快的高效机器代码。因此,多年来编译器中的算法变得越来越复杂,但并不总是能够满足这些要求,例如在某些情况下,编译器可能无法生成足够快的代码,或者无法提供程序员期望的某种功能:

- 首先,编译器中的算法受到它们对程序执行的分析量的限制。例如,我们不希望编译过程极其缓慢,编译器领域的许多问题在计算上很难解决,因此很耗时。

- 其次,编译器不知道代码中的广泛模式。例如,某个变量可能只取一组有限的值,在此基础上,可能进一步优化机器代码,编译器很难理解这一点。聪明的程序员有时可以生成比编译器更优化的机器代码,因为他们知道一些广泛的执行模式,可以胜过编译器。

- 处理器供应商也可能在ISA中添加新指令。在这种情况下,用于旧版本处理器的编译器可能无法利用新指令,需要在程序中手动添加它们。流行的编译器(如gcc,GNU编译器集合)是相当通用的,它们不使用处理器在生成机器代码时提供的所有可能的机器指令。通常,操作系统和设备驱动程序(与打印机和扫描仪等设备接口的程序)需要大量遗漏的指令,因为它们需要对硬件的低级别访问,因此系统程序员有强烈的动机偶尔绕过编译器。

在所有这些情况下,程序员都有必要在程序中手动嵌入一系列机器指令。如上所述,这样做的两个主要原因是效率和额外的功能。因此,从系统软件开发人员的角度来看,有必要了解机器指令,以便他们在工作中更有效率。

现在,我们的目标是让现代程序员远离0和1的复杂细节。理想情况下,我们不希望程序员像50年前那样通过手动打开和关闭开关来编程,由此开发了一种称为汇编语言的低级语言。汇编语言是机器代码的一种人类可读形式,每个汇编语言语句通常对应于一条机器指令。此外,它通过不强迫程序员记住编码指令所需的0/1的确切序列,大大减轻了程序员的负担。

- 低级编程语言(low level programming language)使用通常只对应于一条机器指令的简单语句,这些语言是ISA特有的。

- 汇编语言(assembly language)是指一系列特定于每个ISA的低级编程语言,具有由一系列汇编语句组成的泛型结构。通常,每个汇编语句有两部分:

- 一个指令代码,是基本机器指令的助记符。

- 一个操作数列表。

从实际角度来看,可以编写独立的汇编程序,并使用称为汇编器的程序将其转换为可执行程序,也可以在高级语言(如C或C++)中嵌入汇编代码片段,后者更为常见。

汇编器(assembler)是将汇编程序转换为机器代码的可执行程序。

编译器确保能够将组合程序编译为机器代码。汇编语言的好处是多方面的:

- 可读性。因为汇编代码中的每一行对应于一条机器指令,所以它和机器代码一样具有表达力。

- 高效性。由于这种一对一的映射,我们不必通过在汇编中编写程序来提高效率。

- 简化性。它是一种可读的、优雅的文本表示机器代码的形式,大大简化了使用它编写程序的过程,也可以在用C等高级语言编写的软件中清晰地嵌入汇编代码片段,它定义了一个高于实际机器代码的抽象级别。两个处理器可能与同一种汇编语言兼容,但实际上对同一条指令有不同的机器编码。在这种情况下,汇编程序将在这两个处理器上兼容。

再从硬件设计者的视角阐述之。

硬件设计师的职责是设计能够实现ISA中所有指令的处理器。他们的主要目标是设计一个在面积、功率效率和设计复杂性方面最佳的高效处理器,从他们的角度来看,ISA是软件和硬件之间的关键纽带。这回答了他们的基本问题——构建什么?因此,对他们来说,理解不同指令集的精确语义是非常重要的,这样他们就可以为它们设计处理器。将指令仅仅看作一个0和1的序列是很麻烦的,通过查看机器指令的文本表示,他们可以获得很多好处,很清晰地知道是一条怎样的汇编指令。

汇编语言专用于指令集和汇编器。本节使用流行的GNU汇编器的汇编语言格式来解释典型汇编语言文件的语法,请注意,其他系统具有类似的格式,并且概念大致相同。

19.2.1.2 汇编语言基础

机器模型

汇编语言不将指令存储器和数据内存视为不同的实体,假设一个抽象的冯·诺依曼机器增加了寄存器。

有关机器模型的图示,请参见下图。程序存储在主内存的一部分中,中央处理单元(CPU)逐条指令读出程序指令,并适当地执行指令,程序计数器(PC)跟踪CPU正在执行的指令的内存地址,大多数指令都希望从寄存器中获取其输入操作数。回想一下,每个CPU都有固定数量的寄存器(通常<64),然而大量指令也可以直接从内存中获取操作数。CPU的工作是协调主存和寄存器之间的传输,CPU还需要执行所有算术/逻辑计算,并与外部输入/输出设备保持联系。

大多数类型的汇编语言在大多数语句中都采用这种抽象机器模型。但由于使用汇编语言的另一个目的是对硬件进行更细粒度和侵入性的控制,因此有相当多的汇编指令可以识别处理器的内部。

这些指令通常通过改变一些关键内部算法的行为来修改处理器的行为,它们修改内置参数,如电源管理设置,或读/写一些内部数据。最后请注意,汇编语言不区分机器无关指令和机器相关指令。

每台机器都有一组寄存器,这些寄存器对汇编程序员是可见的。ARM有16个寄存器,x86(32位)有8个寄存器,而x86_64(64位)有16个。寄存器有名称,ARM将它们命名为r0、r1、...、r14、r15,x86将它们命名成eax、ebx、ecx、edx、esi、edi、ebp和esp,可以使用这些名称访问寄存器。

在大多数ISA中,返回地址寄存器用于函数调用。让我们假设一个程序开始执行一个函数,它需要记住执行函数后需要返回的内存地址,此地址称为返回地址。在跳转到函数的起始地址之前,我们可以将返回地址的值保存在这个寄存器中。通过将保存在返回地址寄存器中的值复制到PC上,可以简单地实现返回语句。在ARM和MIPS等汇编语言中,程序员可以看到返回地址寄存器,然而x86不使用返回地址寄存器,使用堆栈。

在ARM处理器中,程序员可以看到PC,它是最后一个寄存器(r15)。可以读取PC的值,也可以设置其值,设置PC的值意味着我们希望分支到程序中的新位置。然而x86的PC是隐式的,程序员不可见。

内存视图

内存可以看作是一个大的字节数组,每个字节都有一个唯一的地址,基本上就是它在数组中的位置。第一字节的地址是0,第二字节的地址为1,以此类推。我们没有一种方法来唯一地寻址给定的位,地址在32位机器中是32位无符号整数,在64位机器中则是64位无符号。

在冯·诺依曼机器中,我们假设程序作为字节序列存储在内存中,程序计数器指向将要执行的下一条指令。

假设内存是一个大的字节数组,如果我们所有的数据项都只有一个字节长,那么就可以了,像C和Java这样的语言有不同大小的数据类型:char(1字节)、short(2字节)、integer(4字节)和long integer(8字节)。对于多字节数据类型,必须在内存中为其创建一个表示,在内存中表示多字节数据类型有两种可能的方式——小端和大端。其次,我们还需要找到表示内存中数据数组或列表的方法。

- 小端和大端表示

让我们考虑在位置0-3存储整数的问题。让整数为0x87654321,它可以分为四个字节:87、65、43和21。一个选项是将最重要的字节87存储在最低的内存地址0中,下一个位置可以存储65、43、21,这被称为大端(big endian)表示,因为我们从最大字节的位置开始。相比之下,我们可以先将最小的字节保存在位置0,然后继续将最大的字节存储在位置3,这种表示方式称为小端(big endian)。下图显示了差异。

大端和小端表示。

因此,没有理由选择一种代表而不是另一种代表,例如,x86处理器使用little-endian格式。早期版本的ARM处理器曾经是小端的,然而,现在它们是双端的,意味着ARM处理器可以根据用户设置同时作为小端和大端机器工作。传统上,IBM POWER处理器和Sun SPARC处理器都是大端的。

- 表示数组

数组是一组线性有序的对象,其中对象可以是简单的数据类型(如整数或字符),也可以是复杂的数据类型。

int a[100];

char c[100];

让我们考虑一个简单的整数数组a。如果数组有100个条目,那么内存中数组的总大小等于100 4=400字节。如果数组的起始内存位置为loc,然后将[0]存储在位置(loc + 0)、(loc + 1)、(loc + 2)、(loc + 3)中。请注意,有大端和小端两种方法保存数据。下一个数组条目a[1]保存在位置(loc + 4) ... (loc + 7)中,依此类推,我们注意到条目a[i]保存在(loc + 4 x i) ... (loc + 4 x i + 3)中。

大多数编程语言都定义以下形式的多维数组:

int a[100][100];

char c[100][100];

它们通常在内存中表示为规则的一维数组,多维数组中的位置与等效的一维数组之间存在映射函数,我们可以扩展该方案以考虑维度大于2的多维数组。

我们观察到,通过以行优先(row major)方式保存二维数组,可以将其保存为一维数组,意味着数据按行保存。我们保存第一行,然后保存第二行,以此类推。同样,也可以以列优先(column major)的方式保存多维数组,其中保存第一列,然后再保存第二列,依此类推。

行优先(row major):数组按行保存在内存中。

列优先(column major):数组按列保存在内存中。

19.2.1.3 汇编语言语法

汇编文件的确切语法取决于汇编程序,不同的汇编程序可以使用不同的语法,尽管它们可能在基本指令及其操作数格式上达成一致。本节将解释GNU系列汇编语言的语法,它们是为GNU汇编程序设计的,是GNU编译器集合(gcc)的一部分。与所有GNU软件一样,该汇编程序和相关编译器可免费用于大多数平台,汇编程序可在gnu.org上找到。请注意,其他汇编程序(如NASM、MASM)都有自己的格式,但总体结构在概念上与本节描述的没有太大区别。

汇编文件结构

程序集文件是一个常规文本文件,后缀是.s。如果安装了GNU编译器gcc,则可以通过发出以下命令快速生成C程序的汇编文件,当然也可以使用在线GCC。

gcc -S test.c

生成的程序集文件将命名为test.s。GNU程序集的结构非常简单,如下图所示。不同部分的示例包括文本(实际程序)、数据(具有初始化值的数据)和bss(初始化为0的通用数据)。每个段(section)以节标题开头,这是以“.”开头的节的名称符号,例如,文本部分以“.text”行开头。接着是汇编语言语句列表,每条语句通常以换行符结尾,同样,数据部分包含数据值列表。

汇编文件以包含格式为“.file <文件名>”的行的文件段开头。当我们使用gcc编译器从C程序生成程序集文件时,.file部分中的文件名通常与我们的原始C程序(test.C)相同。文本段是必填的,其余段是可选的,可能有一个或多个数据段,也可以使用.section指令定义新的节。本节我们主要关注文本部分,因为对学习指令集的本质感兴趣。

汇编语言文件结构。

汇编基本语句

一条基本的汇编语言语句指定了一条汇编指令,有两部分:指令及其操作数列表,如下图所示。该指令是实际机器指令的文本标识符,操作数列表包含每个操作数的值或位置。操作数的值是一个数值常量,也被称为立即值(immediate value),操作数位置可以是寄存器位置或内存位置。

汇编语言语句。

在计算机架构中,指令中指定的常数值也称为立即数(immediate)。

假设有以下语句:

add r3, r1, r2

在这个ARM汇编语句中,add指令指定了我们希望将两个数字相加并将结果保存在某个预先指定的位置的事实。在这种情况下,加法指令的格式如下:<指令><目标寄存器><操作数寄存器1><操作数寄存器2>。指令的名称为add,目标寄存器为r3,操作数寄存器为r1和r2。指令的详细步骤如下:

1.读取寄存器r1的值。让我们将该值称为v1。

2.读取寄存器r2的值。让我们将该值称为v2。

3.计算v3=v1+v2。

4.将v3保存在寄存器r3中。

现在让我们再举一个以类似方式工作的两条指令的示例:

sub r3, r1, r2

mul r3, r1, 3

sub指令减去存储在寄存器中的两个数,mul指令将存储在寄存器r1中的一个数乘以数值常数3,这两条指令都将结果保存在寄存器r3中,它们的操作模式与加法指令类似。此外,算术指令(如add、sub和mul)也称为数据处理指令。还有其他几类指令,例如从内存加载或存储值的数据传输指令,以及实现分支的控制指令。

通用语句结构

汇编语句的一般结构如下图所示,它由三个字段组成:标签(指令的标识符)、键(汇编指令或汇编程序指令)和注释。这三个字段都是可选的,但是,任何汇编语句都需要至少具有其中一个。

汇编语句的通用结构。

语句可以选择以标签开头,标签是语句的文本标识符,换句话说,标签在汇编中唯一地标识汇编语句。请注意,我们不允许在同一汇编文件中重复标签,标签在执行分支指令时非常有用。

下面的示例代码中显示了一个标签的示例,这里标签的名称是“label1”,后面是冒号。在标签之后,我们编写了一条汇编指令,并给它一个操作数列表。标签可以由有效的字母数字字符[a-z] [A-Z] [0-9] 以及符号“.”、“_”和“$”。通常,我们不能以数字作为标签的开头。在指定标签之后,我们可以将该行保持为空,也可以指定键(汇编语句的一部分)。如果键以“.”开头,那么它是一个汇编程序指令,对所有计算机都有效,它指示汇编程序执行某个操作,此操作可以包括启动新节或声明常量。该指令还可以采用参数列表,如果键以字母开头,则它是一条常规的汇编指令。

label1: add r1, r2, r3

在标签、汇编指令和操作数列表之后,可以选择插入注释。GNU汇编程序支持两种类型的注释,我们可以在插入类似C或Java风格的注释。在ARM汇编中,通过在注释前面加上“@”字符,也可以有一个小的单行注释。

label1: add r1, r2, r3 @ Add the values in r2 and r3

label2: add r3, r4, r5 @ Add the values in r4 and r5

add r5, r6, r7 /* Add the values in r6 and r7 */

汇编语句可能只包含标签,而不包含键。在这种情况下,标签本质上指向一个空语句,不是很有用。因此,汇编程序假定在这种情况下,标签指向最近的包含键的后续汇编语句。

19.2.1.4 指令类型

按功能分类

按功能,可分为四种主要类型,说明如下:

- 数据处理指令:数据处理指令通常是算术指令,如加法、减法和乘法,或按位或、异或计算的逻辑指令,比较指令也属于这个类型。

- 数据传输指令:这些指令在两个位置之间传输值,位置可以是寄存器或内存地址。

- 分支指令:分支指令帮助处理器的控制单元根据操作数的值跳转到程序的不同部分,在实现for循环和if-then-else语句时很有用。

- 异常生成指令:这些专用指令有助于将控制权从用户级程序转移到操作系统。

我们将介绍数据处理、数据传输和控制指令。

按操作数分类

GNU汇编程序中的所有汇编语言语句都具有相同的结构,它们以指令的名称开头,后面是操作数列表。我们可以根据指令所需的操作数对其进行分类,如果一条指令需要n个操作数,那么通常称它是n地址格式,例如,不需要任何操作数的指令是0地址格式指令,如果它需要3个操作数,则它是3地址格式指令。

如果一条指令需要n个操作数(包括源和目标),那么我们称其为n地址格式指令。

在ARM中,大多数数据处理指令采用3地址格式,数据传输指令采用2地址格式。然而,在x86中,大多数指令都是2地址格式。我们想到的第一个问题是,3地址格式指令与2地址格式指令的逻辑是什么?这里一定有一些权衡。

让我们阐述一些一般的经验法则。如果一条指令有更多的操作数,那么它将需要更多的位来表示该指令,因此需要更多的资源来存储和处理指令。然而,这一论点有另一面,拥有更多的操作数也会使指令更加通用和灵活,将使编译器编写者和汇编程序员的生活变得更加轻松,因为使用更多操作数的指令可以做更多的事情。反向逻辑适用于占用较少操作数的指令,占用更少的存储空间,也不那么灵活。

让我们考虑一个例子。假设我们试图将两个数字3和5相加,得到结果8。用于添加的ARM指令如下所示:

add r3, r1, r2

此指令将寄存器r1(3)和r2(5)的内容相加,并将其保存在r3(8)中。然而,x86指令如下所示:

add edx, eax

此处假设edx包含3,eax包含5,执行加法,结果8存储回edx。因此,在这种情况下,x86指令采用2地址格式,因为目标寄存器与第一源寄存器相同。

19.2.1.5 操作数类型

现在让我们看看不同类型的操作数,在汇编语句中指定和访问操作数的方法称为寻址模式。

在汇编语句中指定和访问操作数的方法称为寻址模式(addressing mode)。

指定操作数的最简单方法是将其值嵌入指令中,大多数汇编语言允许用户将整数常量的值指定为操作数,这种寻址模式被称为立即寻址模式(immediate addressing mode),此方法对于初始化寄存器或内存位置或执行算术运算非常有用。

一旦必需的常数集被加载到寄存器和内存位置,程序就需要通过对寄存器和内存进行操作来继续,这个空间有几种寻址模式。在介绍它们之前,让我们以寄存器转移符号(register transfer notation)的形式介绍一些额外的术语。

寄存器转移符号

这个符号允许我们指定指令和操作数的语义,让我们看看表示指令基本动作的各种方法:

r1←r2r1←r2

此表达式有两个寄存器操作数r1和r2,r1是目标寄存器,r2是源寄存器,我们正在将寄存器r2的内容转移到寄存器r1。我们可以用一个常数指定一个加法运算,如下所示:

r1←r2+4r1←r2+4

我们还可以使用此符号指定寄存器上的操作,将r2和r3的内容相加,并将结果保存在r1中:

r1←r2+r3r1←r2+r3

也可以使用此符号表示内存访问:

r1←[r2+4]r1←[r2+4]

上述语句中,内存地址等于寄存器r2的内容加4,然后从该内存地址的内容开始提取整数,并将其保存在寄存器r1中。

操作数的通用寻址模式

让我们将操作数的值表示为V。在随后的讨论中,我们使用了V←r1V←r1等表达式,并不意味着我们有一个新的称为V的存储位置,意味着操作数的数值由RHS指定(右侧)。让我们通过示例简要地看一下一些最常用的寻址模式:

- 立即:V←immV←imm。使用常量imm作为操作数的值。

- 寄存器:V←r1V←r1。在此寻址模式下,处理器使用寄存器中包含的值作为操作数。

- 寄存器间接:V←[r1]V←[r1]。寄存器保存包含该值的内存位置的地址。

- 基准偏移量:V←[r1+offset]V←[r1+offset]。offset是一个常数,处理器从r1获取基本内存地址,将常量offset添加到该地址,然后访问新的内存位置以获取操作数的值。offset也称为位移。

- 基址变址:V←[r1+r2]V←[r1+r2]。r1是基址寄存器,r2是索引寄存器,存储器地址等于(r1+r2)。

- 基址变址偏移:V←[r1+r2+offset]V←[r1+r2+offset]。包含该值的内存地址为(r1+r2+offset),其中offset为常数。

- 内存直接:V←addrV←addr。该值从地址addr开始包含在内存中,addr是一个常数。在这种情况下,存储器地址直接嵌入指令中。

- 内存间接:V←[[r1]]V←[[r1]]。该值存在于存储器位置中,其地址包含在内存位置M中,M的地址包含在寄存器r1中。

- PC相关:V←[PC+offset]V←[PC+offset]。offset量是一个常数,内存地址计算为PC+offset,其中PC表示PC中包含的值。此寻址模式对分支指令很有用,注意此处的PC是指程序计数器。

让我们通过考虑基偏移寻址模式来引入一个称为有效内存地址(effective memory address)的新术语。内存地址等于基址寄存器的内容加上偏移量,计算出的内存地址称为有效内存地址。在内存操作数的情况下,我们可以类似地为其他寻址模式定义有效地址。

多种寻址模式。

x86寻址模式计算。

19.2.1.6 常见指令说明

本小节将以ARM为基准,阐述常见的RISC指令用法。

数据传输指令

数据传输指令包含以下几类:

- LDR和STR

可加载寄存器和存储寄存器,包含32位字、8位无符号字节、半字、无符号字节、双字等。

LDR和STR都有四种可能的形式:零偏移量、预索引偏移、程序相关、后索引偏移。四种形式的语法顺序相同,分别为:

op{cond}{B}{T} Rd, [Rn]

op{cond}{B} Rd, [Rn, FlexOffset]{!}

op{cond}{B} Rd, label

op{cond}{B}{T} Rd, [Rn], FlexOffset

以上是针对32位字或8位无符号字节,如果需要双字则B改成D:

op{cond}D Rd, [Rn]

op{cond}D Rd, [Rn, Offset]{!}

op{cond}D Rd, label

op{cond}D Rd, [Rn], Offset

半字、有符号字节语法如下:

op{cond} type Rd, [Rn]

op{cond} type Rd, [Rn, Offset]{!}

op{cond} type Rd, label

op{cond} type Rd, [Rn], Offset

示例:

; 示例1

SUB R1, PC, #4 ; R1 = address of following STR instruction

STR PC, [R0] ; Store address of STR instruction + offset,

LDR R0, [R0] ; then reload it

SUB R0, R0, R1 ; Calculate the offset as the difference

; 示例2

LDRD r6,[r11]

LDRMID r4,[r7],r2

STRD r4,[r9,#24]

STRD r0,[r9,-r2]!

LDREQD r8,abc4

; 示例3

LDREQSH r11,[r6] ; (conditionally) loads r11 with a 16-bit halfword from the address in r6. Sign extends to 32 bits.

LDRH r1,[r0,#22] ; load r1 with a 16 bit halfword from 22 bytes above the address in r0. Zero extend to 32 bits.

STRH r4,[r0,r1]! ; store the least significant halfword from r4 to two bytes at an address equal to contents(r0) plus contents(r1). Write address back into r0.

LDRSB r6,constf ; load a byte located at label constf. Sign extend.

- LDM和STM

LDM、STM加载和存储多个寄存器,寄存器r0到r15的任何组合都可以被传送。语法如下:

op{cond}mode Rn{!}, reglist{^}

示例:

LDMIA r8,{r0,r2,r9}

STMDB r1!,{r3-r6,r11,r12}

STMFD r13!,{r0,r4-r7,LR} ; Push registers including the stack pointer

LDMFD r13!,{r0,r4-r7,PC} ; Pop the same registers and return from subroutine

- PLD

PLD缓存预加载。语法:

PLD [Rn{, FlexOffset}]

示例:

PLD [r2]

PLD [r15,#280]

PLD [r9,#-2481]

PLD [r0,#av*4] ; av * 4 must evaluate, at assembly time, to an integer in the range -4095 to +4095

PLD [r0,r2]

PLD [r5,r8,LSL 2]

- SWP

在寄存器和存储器之间交换数据,使用SWP实现信号量。语法:

SWP{cond}{B} Rd, Rm, [Rn]

通用数据处理指令

此类指令又包含以下几种:

- 灵活第二操作数

大多数ARM通用数据处理指令都有一个灵活的第二操作数,在每条指令的语法描述中显示为Operand2。语法有两种形式:

#immed_8r

Rm{, shift}

示例:

ADD r3,r7,#1020 ; immed_8r. 1020 is 0xFF rotated right by 30 bits.

AND r0,r5,r2 ; r2 contains the data for Operand2.

SUB r11,r12,r3,ASR #5 ; Operand2 is the contents of r3 divided by 32.

MOVS r4,r4, LSR #32 ; Updates the C flag to r4 bit 31. Clears r4 to 0.

- ADD、SUB、RSB、ADC、SBC和RSC

此类指令的语法如下:

op{cond}{S} Rd, Rn, Operand2

示例:

ADD r2,r1,r3

SUBS r8,r6,#240 ; sets the flags on the result

RSB r4,r4,#1280 ; subtracts contents of r4 from 1280

ADCHI r11,r0,r3 ; only executed if C flag set and Z flag clear

RSCLES r0,r5,r0,LSL r4 ; conditional, flags set

- AND、ORR、EOR和BIC

逻辑操作,语法如下:

op{cond}{S} Rd, Rn, Operand2

示例:

AND r9,r2,#0xFF00

ORREQ r2,r0,r5

EORS r0,r0,r3,ROR r6

BICNES r8,r10,r0,RRX

- MOV、MVN、CMP、CMN、TST、TEQ、CLZ

移动、对比、测试、计数前导零指令,语法如下:

MOV{cond}{S} Rd, Operand2

MVN{cond}{S} Rd, Operand2

CMP{cond} Rn, Operand2

CMN{cond} Rn, Operand2

TST{cond} Rn, Operand2

TEQ{cond} Rn, Operand2

CLZ{cond} Rd, Rm

示例:

MOV r5,r2

MVNNE r11,#0xF000000B

MOVS r0,r0,ASR r3

CMP r2,r9

CMN r0,#6400

CMPGT r13,r7,LSL #2

TST r0,#0x3F8

TEQEQ r10,r9

TSTNE r1,r5,ASR r1

CLZ r4,r9

CLZNE r2,r3

算术指令

算术指令包含大量的乘法指令,乘法的指令较多较复杂。常见算术指令如下表所示:

| 指令 | 语法 | 说明 |

|---|---|---|

| MUL、MLA | MUL{cond}{S} Rd, Rm, Rs MLA{cond}{S} Rd, Rm, Rs, Rn | 乘法和乘法累加(32位乘32位,取底部32位结果) |

| UMULL、UMLAL、SMULL、SMLAL | Op{cond}{S} RdLo, RdHi, Rm, Rs | 无符号和有符号长乘法和乘法累加(32位乘32位,64位累加或结果)。 |

| SMULxy、SMLAxy、SMULWy、SMLAWy、SMLALxy | SMLA{cond} Rd, Rm, Rs, Rn SMULW{cond} Rd, Rm, Rs SMLAW{cond} Rd, Rm, Rs, Rn | 有符号乘法(16、32位乘16、32位,结果是32位或64位,部分指令有累积)。 |

| MIA、MIAPH、MIAxy | MIA{cond} Acc, Rm, Rs MIA{cond} Acc, Rm, Rs | XScale协处理器0指令。 |

示例:

MUL r10,r2,r5

MLA r10,r2,r1,r5

MULS r0,r2,r2

MULLT r2,r3,r2

MLAVCS r8,r6,r3,r8

UMULL r0,r4,r5,r6

UMLALS r4,r5,r3,r8

SMLALLES r8,r9,r7,r6

SMULLNE r0,r1,r9,r0 ; Rs can be the same as other registers

SMLAWB r2,r4,r7,r1

SMLAWTVS r0,r0,r9,r2

MIA acc0,r5,r0

MIALE acc0,r1,r9

MIAPH acc0,r0,r7

MIAPHNE acc0,r11,r10

MIABB acc0,r8,r9

MIABT acc0,r8,r8

MIATB acc0,r5,r3

MIATT acc0,r0,r6

MIABTGT acc0,r2,r5

分支指令

分支语句的描述如下表:

| 指令 | 语法 | 说明 |

|---|---|---|

| B、BL | B/BL {cond} label | 分支和带链接的分支 |

| BX | BX{cond} Rm | 分支和交换指令集 |

| BLX | BLX{cond} Rm BLX label | 使用Link分支,并可选地交换指令集。本说明有两种可选形式: 1、链接到程序相对地址的无条件分支 2、与寄存器中保存的绝对地址链接的条件分支。 |

示例:

B loopA

BLE ng+8

BL subC

BLLT rtX

BX r7

BXVS r0

BLX r2

BLXNE r0

BLX thumbsub

条件执行

几乎所有ARM指令都可以包含可选条件代码。这在语法描述中显示为{cond}。只有当CPSR中的条件代码标志满足指定条件时,才执行带有条件代码的指令。可以使用的条件代码如下表所示(部分)。

| 后缀 | 标记 | 含义 |

|---|---|---|

| EQ | Z设置 | = |

| NE | Z清除 | != |

| CS、HS | C设置 | >=(无符号) |

| CC、LO | C清除 | =(无符号) |

| MI | N设置 | 负数 |

| PL | N清除 | 非负数 |

| VS | V设置 | 溢位 |

| VC | V清除 | 无溢位 |

| HI | C设置且Z清除 | >(无符号) |

| LS | C清除或Z设置 | <=(无符号) |

| GE | N和V一样 | >=(有符号) |

| LT | N和V不一样 | <(有符号) |

| GT | Z清除且N和V一样 | >(有符号) |

| LE | Z设置或N和V不一样 | <=(有符号) |

| AL | 任意 | 总是(通常省略) |

几乎所有ARM数据处理指令都可以根据结果选择性地更新条件代码标志。要使指令更新标志,请包含S后缀,如指令的语法描述所示。

有些指令(CMP、CMN、TST和TEQ)不需要S后缀,它们的唯一功能是更新标志,总是更新标志。

标志将保留到更新,未执行的条件指令对标志没有影响,一些指令更新标志的子集,其他标志不受这些指令的影响。详细信息在说明说明中指定。可以根据另一条指令中设置的标志,有条件地执行指令,或者:

- 紧接在更新标志的指令之后。

- 在没有更新标志的任何数量的介入指令之后。

示例:

ADD r0, r1, r2 ; r0 = r1 + r2, don't update flags

ADDS r0, r1, r2 ; r0 = r1 + r2, and update flags

ADDCSS r0, r1, r2 ; If C flag set then r0 = r1 + r2, and update flags

CMP r0, r1 ; update flags based on r0-r1.

其它指令

ARM还有协调处理器、伪指令、杂项指令等其它指令,本文限于篇幅就不接受了。更多详情参见:

19.2.2 二进制位

计算机不像人类那样理解单词或句子,只理解0和1的序列,存储、检索和处理数十亿个0和1非常容易。其次,使用硅晶体管(silicon transistor)实现计算机的现有技术与处理0和1的概念非常兼容。基本硅晶体管是一种开关,可以根据输入将输出设置为逻辑0或1,硅晶体管是我们今天拥有的所有电子计算机的基础,从手机的处理器到超级计算机的处理器。十九世纪末制造的一些早期计算机处理十进制数字,本质上大多是机械的。首先让我们明确定义一些简单的术语:

位(bit):可以有两个值的变量:0或1。

字节(byte):8个位的序列。

19.2.2.1 逻辑操作

二进制变量(0或1)最早由乔治·布尔(George Boole)于1854年描述,他使用这些变量及其相关运算来描述数学意义上的逻辑,他设计了一个完整的代数,由简单的二元变量、一组新的运算符和基本运算组成。为了纪念乔治·布尔,二进制变量也称为布尔变量(Boolean variable),布尔变量的代数系统称为布尔代数(Boolean algebra)。逻辑位操作如下:

- NOT

逻辑补码(logical complement)称为NOT运算符,任何布尔运算符都可以通过真值表来表示,真值表列出了所有可能的输入组合的运算符输出,NOT运算符的真值表如下表所示。

| 原始值 | NOT操作后 |

|---|---|

| 0 | 1 |

| 1 | 0 |

- OR

OR运算符表示任一操作数等于1的事实。例如,如果A=1或B=1,则A或B等于1。OR运算符的真值表如下所示。

| A | B | A OR B |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 1 |

- AND

AND运算符的操作是所有操作数为1,则结果才为1,其它则为0。例如,当A和B都为1时,A和B等于1。AND运算符的真值表如下所示。

| A | B | A AND B |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 0 |

| 1 | 0 | 0 |

| 1 | 1 | 1 |

- NAND、NOR

另外的两个简单的运算符,即NAND和NOR非常有用。NAND是AND的逻辑补码,NOR是OR的逻辑补。它们的真值表如下所示。

| A | B | A NAND B | A NOR B |

|---|---|---|---|

| 0 | 0 | 1 | 1 |

| 0 | 1 | 1 | 0 |

| 1 | 0 | 1 | 0 |

| 1 | 1 | 0 | 0 |

NAND和NOR是非常重要的运算符,因为它们被称为通用运算符,我们可以只使用它们来构造任何其他运算符。

- XOR

XOR是异或运算符,当A和B相等时,值为0,否则为1。真值表如下所示。

| A | B | A XOR B |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 0 |

19.2.2.2 布尔代数

让我们来看看NOT运算符的一些规则:

- 定义:¯¯¯0=1, 且 ¯¯¯1=00¯=1, 且 1¯=0,即NOT运算符的定义。

- 双重否定:¯¯¯¯¯¯¯¯A=AA¯¯=A,非A的非等于A本身。

OR和AND运算符:

- 恒等式:A+0=A,A.1=A,亦即如果计算布尔变量A与0的OR或与1的AND,结果等于A。

- 相消性:A+1=1,A.0=0,亦即如果计算A OR 1,那么结果总是等于1。类似地,A AND 0总是等于0,因为第二个操作数的值决定了最终结果。

- 幂等性:A+A=A,A.A=A,亦即计算A与自身的OR或AND的结果为A。

- 互补性:A+¯¯¯¯AA¯=1,A.¯¯¯¯AA¯=0,亦即A=1或¯¯¯¯AA¯=1。在任何一种情况下,A+¯¯¯¯AA¯都有一个项,它是1,因此结果是1。同样,A.¯¯¯¯AA¯中的一个项是0,因此结果为0。

- 交换性:A.B=B.A,A+B=B+A,亦即布尔变量的顺序无关紧要。

- 关联性:A+(B+C) = (A+B)+C,以及A.(B.C)=(A.B).C。

- 分配性:A.(B+C) = A.B+A.C,A+B.C=(A+B).(A+C),亦即可以使用这个定律来打开括号并简化表达式。

我们可以使用这些规则以各种方式操作包含布尔变量的表达式,下面看看布尔代数中的一组基本定理。

- 摩根定律(De Morgan's Laws)

有两个摩根定律可以通过构造LHS和RHS的真值表来验证。

¯¯¯¯¯¯¯¯¯¯¯¯¯¯¯A+B=¯¯¯¯A.¯¯¯¯B¯¯¯¯¯¯¯¯AB=¯¯¯¯A+¯¯¯¯BA+B¯=A¯.B¯AB¯=A¯+B¯

- 逻辑门(Logic Gate)

现在让我们尝试实现电路来实现复杂的布尔公式,“逻辑门”定义为实现布尔函数的器件,可以由硅、真空管或任何其他材料制成。

逻辑门是实现布尔函数的设备。

给定一组逻辑门,我们可以设计一个电路来实现任何布尔函数,不同逻辑门的符号如下图所示。

逻辑门列表。

19.2.3 晶体管

硅是周期表中的第14种元素,有四个价电子,虽然与碳和锗属于同一组,但其化学反应性不如后两者。

90%以上的地壳由硅基矿物组成,二氧化硅是沙子和石英的主要成分,它供应充足,而且制造起来相当便宜。硅具有一些有趣的特性,使其成为设计电路和处理器的理想衬底。让我们考虑一下硅的分子结构,它有一个致密的结构,每个硅原子都与其他四个硅原子相连,紧密相连的一组硅原子结合在一起形成一个强晶格,其他材料(尤其是金刚石)具有类似的晶体结构。因此,硅原子比大多数金属更紧密。

由于缺乏自由电子,硅没有很好的导电性能,介于良导体和绝缘体之间,因此被称为半导体(semiconductor)。通过可控的方式添加一些杂质,可以稍微改变其性质,这个过程被称为掺杂(doping)。

19.2.3.1 掺杂

通常,向硅中添加两种杂质以改变其特性:n型和p型。n型杂质通常由周期表中的V族元素组成,磷是最常见的n型掺杂剂,偶尔也会使用砷。添加具有价电子的V族掺杂剂的效果是,额外的电子从晶格中分离出来,并可用于传导电流。这种掺杂过程有效地提高了硅的导电性。

同样,可以向硅中添加III族元素,如硼或镓,以产生p型掺杂硅,会产生相反的效果,会在晶格中创建一个空隙,此空隙也称为孔(hole),孔表示没有电子。像电子一样,孔可以自由移动,也有助于传导电流。电子带负电荷,孔在概念上与正电荷相关。

现在我们已经制作了两种半导体材料:n型和p型,下面看看如果连接它们形成p-n结会发生什么。

19.2.3.2 P-N结

让我们考虑一个p-n结,如下图所示。p型区有过量的孔,n型区有过剩的电子。在结处,一些孔交叉并移动到n区,因为它们被电子吸引。类似地,一些电子越过并聚集在p区一侧。孔和电子的这种迁移称为扩散,见证这种迁移的交界处周围的区域被称为耗尽区。然而,由于电子和孔的迁移,在耗尽区中产生了与迁移方向相反的电场,这个电场感应出一种称为漂移电流的电流。在稳态下,漂移电流和扩散电流相互平衡,因此实际上没有电流流过结。

如果将p侧连接到正端子,将n侧连接到负端子,则这种配置称为正向偏置。在这种情况下,孔从结的p侧流向n侧,电子则反向流动。因此,该结传导电流。

如果我们将p侧连接到负端子,将n侧连接到正端子,则这种配置称为反向偏置。在这种情况下,孔和电子被拉离结。因此,没有电流流过结,并且在这种情况下p-n结不导电。所描述的简单p-n结被称为二极管(diode),它只在一个方向传导电流,即当它处于正向偏置时。

二极管(diode)是一种典型地由单个p-n结制成的电子器件,其仅在一个方向上传导电流。

19.2.3.3 NMOS晶体管

现在,让我们将两个p-n结相互连接,如下图(a)所示,这种结构被称为NMOS(负金属氧化物半导体)晶体管。在这张图中,有一个p型掺杂硅的中心衬底。两侧有两个小区域含有n型掺杂硅,这些区域分别被称为漏极和源极。注意,由于结构是完全对称的,这两个区域中的任何一个都可以被指定为源极或漏极,源极和漏极中间的区域称为通道。在沟道的顶部有一个通常由二氧化硅(SiO2)制成的薄绝缘层,它由金属或多晶硅基导电层覆盖,就是所谓的门(gate)。

因此,典型的NMOS晶体管有三个端子:源极、漏极和栅极,它们中的每一个都可以连接到电压源。我们现在有两个栅极电压选项——逻辑1(VddVdd伏)或逻辑0(0伏)。如果栅极处的电压为逻辑1(Vdd伏),则沟道中的电子被吸引到栅极。事实上,如果栅极处的电压大于某个阈值电压(在当前技术中通常为0.15V),则由于电子的积累,在漏极和源极之间形成低电阻导电路径。因此,电流可以在漏极和源极之间流动。如果沟道的有效电阻是R沟道,那么我们有Vdrain=IRchannel+VsourceVdrain=IRchannel+Vsource。如果流经晶体管的电流量低,则由于低沟道电阻(R沟道),VdrainVdrain大致等于VsourceVsource。因此,我们可以将NMOS晶体管视为开关(见上图b)。当栅极电压为1时,它被打开。

现在,如果我们将栅极电压设置为0,那么由电子组成的导电路径就无法在沟道中形成。因此,晶体管将不能传导电流,将处于o状态。在这种情况下,开关关闭。

NMOS晶体管的电路符号如上图(c)所示。

19.2.3.4 PMOS晶体管

像NMOS晶体管一样,我们可以有一个PMOS晶体管,如下图(a)所示,源极和漏极是由p型硅构成的区域,晶体管操作的逻辑与NMOS晶体管的逻辑完全相反。在这种情况下,如果栅极处于逻辑0,则空穴被吸引到沟道并形成导电路径。然而,如果栅极处于逻辑1,则孔被沟道排斥,不形成导电路径。

PMOS晶体管也可以被视为开关(图b),当栅极电压为0时,它打开,当栅极处的电压为逻辑1时,它关闭。PMOS晶体管的电路符号如图(c)所示。

19.2.3.5 NAND和NOR门

下图显示了如何在CMOS技术中构建NAND门。两个输入端A和B连接到每个NMOS-PMOS对的栅极,如果A和B都等于1,则PMOS晶体管将关断,NMOS晶体管将导通,将输出设置为逻辑0。但是,如果其中一个输入等于0,则其中一个NMOS晶体管将关闭,其中一个PMOS晶体管将打开。因此,输出将设置为逻辑1。

请注意,我们使用AND运算的运算符“.”,这种符号在表示布尔公式时被广泛使用。同样,对于OR运算,使用“+”符号。

下图显示了如何构建NOR门。在这种情况下,两个输入端A和B也连接到每个NMOS-PMOS对的栅极。然而,与NAND门相比,拓扑结构有所不同。如果其中一个输入为逻辑1,则其中一个NMOS晶体管将导通,其中一个PMOS晶体管将截止,输出将设置为0。如果两个输入都等于0,则两个NMOS晶体将截止,两个PMOS晶体将导通,输出将等于逻辑1。

NAND门的一些用途如下:

NOR门的一些用途如下:

19.2.4 组合逻辑电路

19.2.4.1 XOR门

让我们实现异或(XOR)的逻辑函数,使用运算符进行XOR运算,如果两个输入不相等,则异或操作返回1,否则返回0。已知A⊕B=A⋅¯¯¯¯B+¯¯¯¯A⋅BA⊕B=A⋅B¯+A¯⋅B,则真值表和实现异或门的电路如下所示。

基本逻辑门如下所示:

19.2.4.2 多路复用器和信号分离器

多路复用器(Multiplexer)的框图如下图左所示,采用n个输入位和log(n)个选择位,并根据选择位的值,选择一个输入作为输出(参见图中带箭头的线)。多路复用器在处理器设计中大量使用,我们需要从一组输入中选择一个输出。多路复用器也称为多路复用器。

信号分离器将log(n)位二进制数作为输入,1位输入,并将输入传输到n条输出线中的一条,参见下图右。多路分解器用于存储单元的设计,其中输入必须精确地反映在一条输出线中。

左:单个多路复用器结构图。中:4输入的多路复用器。右:信号分离器。

多路复用器输入至程序计数器。

19.2.4.3 编码器和解码器

解码器将log(n)位二进制数作为输入,并具有n个输出。根据输入,它将其中一个输出设置为1。

解码器的设计如下图左所示,具有两个输入和四个输出的2x4解码器的设计。假设输入是A和B。我们生成所有可能的组合:¯¯¯¯¯¯¯¯AB,¯¯¯¯AB,A¯¯¯¯B,ABAB¯,A¯B,AB¯,AB。这些布尔组合是通过计算A和B的逻辑“非”,然后将这些值路由到一组“与”门来生成的。

现在让我们考虑一个与解码器逻辑相反的电路,其框图如下图右所示。该电路有n个输入和log(n)个输出,n个输入中的一个假定为1,其余假定为0,输出位提供等于1的输入二进制编码。例如,在8输入、3输出编码器中,如果第f行等于1,则输出等于100(计数从0开始)。

左:2x4解码器的设计。右:n位编码器框图。

现在我们假设我们不存在只有一个输入行可以等于1的限制,假设有多个输入可以等于1。在这种情况下,我们需要报告具有最高索引(优先级)的输入行的二进制编码。例如,如果是第3行和第5行,那么我们需要报告第5行的二进制编码,和上图右一样。此外,4-2位编码器的电路图如下图所示。

用解码器实现解复用器:

时钟SR锁存器(下图左)和D锁存器(下图右):

J–K锁存器:

基本锁存器的比较:

19.2.5 时序逻辑电路

前面已经研究了在比特上计算不同函数的组合逻辑电路,本小节将讨论如何保存位以供以后使用,这些结构被称为顺序逻辑元件(sequential logic element),因为输出取决于过去的输入,这些输入在事件序列中较早出现。逻辑门的基本思想是修改输入值以获得所需的输出,在组合逻辑电路中,如果输入被设置为0,那么输出也被重置。为了确保电路存储一个值并在处理器通电时保持该值,需要设计一种具有某种“内置存储器”的不同类型的电路。让我们从制定一组要求开始:

1、电路应能自我维持,并在外部输入复位后保持其值。不应依赖外部信号来维持其存储的元件。

2、应该有一种方法来读取存储的值而不破坏它。

3、应该有一种方法将存储值设置为0或1。

确保电路保持其值的最佳方法是创建反馈路径,并将输出连接回输入,先看看最简单的逻辑电路:SR锁存器(SR latch)。

19.2.5.1 SR锁存器

下图显示了SR锁存器。有两个输入S(设置)和R(重置),有两个输出Q及其补码Q,包含了两个交叉耦合NAND门的电路。请注意,如果与非门的一个输入为0,则输出保证为1。然而,如果其中一个输入是1,另一个输入则为a,则输出为a。

用NOR门实现的SR锁存器:

19.2.5.2 时钟和信号

一个典型的处理器包含数百万或可能数十亿个逻辑门和数千个锁存器,不同的电路需要不同的时间,例如多路复用器可能需要1ns,解码器可能需要0.5ns。电路完成计算后,就可以转发输出了。如果没有全局时间的概念,很难在不同的单元之间同步通信,尤其是那些具有可变延迟的单元,导致难以设计、操作和验证处理器。由此需要时间概念,例如可以说加法器需要两个时间单位,在两个单元结束时,预期数据将在锁存器X中找到,其他单元可以在两个时间单元后从锁存器中获取值并继续计算。

考虑一个需要向打印机发送一些数据的处理器的例子。为了传输数据,处理器通过一组铜线发送一系列比特,打印机读取这些比特,然后打印数据。问题是,处理器什么时候发送数据?计算完成后,需要发送数据。我们可以问的下一个问题是,处理器如何知道计算何时结束?它需要知道不同单元的确切延迟,一旦计算的总持续时间过去,可以将输出数据写入锁存器,并设置用于通信的铜线的电压。因此,处理器确实需要时间概念。其次,设计者需要告诉处理器不同子单元所需的时间。与处理2.34ns和1.92ns等数字相比,处理1、2和3等整数要简单得多。这里的1、2、3表示时间单位,时间单位可以是任何数字,例如0.9333ns。

时钟信号(clock signal):发送到大型电路或处理器的每个部分的周期性方波。

时钟周期(clock cycle):时钟信号的周期。

时钟频率(clock frequency):时钟周期的倒数。

因此,大多数数字电路与时钟信号同步,该时钟信号在完全相同的时间向处理器的每个部分发送周期性脉冲。时钟信号为方波,如下图所示,大多数时间,时钟信号是由主板上的专用单元从外部生成的。让我们考虑时钟信号从1转变到0(向下/负边缘)的点作为时钟周期的开始,从时钟的一个向下沿到下一个向下边缘测量时钟周期,时钟周期的持续时间也称为时钟周期,时钟周期的倒数被称为时钟频率。

一个时钟信号。

电脑、笔记本电脑、平板电脑或移动电话通常会在其规格中列出频率。例如,规范可能会说处理器运行在3GHz,这个数字是指时钟频率。

典型的计算模型是:电路中执行所有基本动作所需的时间是按照时钟周期来测量的,如果生产者单元占用n个时钟周期,那么在n个时钟循环结束时,它将其值写入锁存器。其他用户单元知道此延迟,并且在第(n+1)个时钟周期开始时,它们从锁存器读取值。由于所有单元都与时钟明确同步,并且处理器知道每个单元的延迟,因此很容易对计算进行排序、与I/O设备通信、避免竞争条件、调试和验证电路。我们想向打印机发送数据的简单示例可以通过使用时钟轻松解决。

19.2.5.3 时钟SR锁存器

下图显示了SR锁存器,其增加了两个与非门,时钟作为输入之一,另外两个输入分别是S位和R位。如果时钟为0,则交叉耦合NAND门的两个输入都为1,将保持先前的值。如果时钟为1,则交叉耦合NAND门的输入分别为S和R,这些输入与基本SR锁存器相同。请注意,时钟锁存器通常称为触发器(flip-flop)。

时钟SR锁存器图例。

触发器(flip-flop)是一个时钟锁存器,可以保存一位(0或1)。

通过使用时钟,我们部分解决了输入和输出同步的问题。在这种情况下,当时钟为0时,输出不受输入的影响。当时钟为1时,输出受输入影响。这种锁存器也称为电平敏感锁存器(level sensitive latch)。

电平敏感锁存器(level sensitive latch)取决于时钟信号的值:0或1。通常,它只能在时钟为1时读取新值。

在电平敏感锁存器中,电路有半个时钟周期来计算正确的输出(当时钟为0时)。当时钟为1时,输出可见。最好有一个完整的时钟周期来计算输出,这需要一个边缘敏感锁存器(edge sensitive latch),边缘敏感锁存器仅在时钟的向下边缘反映输出端的输入。

边缘敏感锁存器(edge sensitive latch)仅在固定的时钟边缘(例如向下边缘,从1到0的转换)反映输出端的输入。

19.2.5.4 边缘敏感SR触发器

下图显示了边缘敏感SR触发器的结构图,连接了两个边缘敏感SR触发器,唯一的区别是第二个触发器使用了时钟信号组合。第一个触发器为主(master),而第二个为从(slave)。这种触发器也被称为主-从SR触发器。这就是这个电路的工作原理。

除了主从SR触发器,还有其它各种类型的触发器,如JK触发器、D触发器、主从D触发器等。

从上到下:JK触发器、D触发器、主从D触发器。

19.2.5.5 寄存器

我们可以通过使用一组n个主从D触发器来存储n位数据,每个D触发器连接到输入线,其输出端连接到输出线,这种n位结构被称为n位寄存器。我们可以并行加载n位,也可以在每个负时钟边沿并行读取n位。因此,这种结构被称为并行输入——并行输出寄存器。其结构如下图所示。

现在让我们考虑一个串行输入-并行输出寄存器,如下图所示,有一个输入被馈送到最左边的D触发器, 每个周期,输入都会移动到右侧的相邻触发器。因此,要加载n位将需要n个周期。 第一位将在第一个周期被加载到最左边的触发器中,它需要n个周期才能到达最后一个触发器。 到那时,其余的n - 1触发器将加载其余的n - 1位,然后我们可以并行读取所有 n 位(类似于并行并行输出寄存器)。 该寄存器也称为移位寄存器,用于实现高速I/O总线中使用的电路。

8位并行寄存器的结构图如下:

5位移位寄存器:

行波计数器:

19.2.6 内存

19.2.6.1 静态内存(SRAM)

SRAM是指静态随机存取存储器,基本SRAM单元包含两个交叉耦合的反相器,如下图所示。相比之下,基本SR触发器或D触发器包含交叉耦合的NAND门。设计如下所示。

SRAM单元的核心包含4个晶体管(每个反相器中有2个),这种交叉耦合布置足以节省单个比特(0或1)。然而,我们需要一些额外的电路来读取和写入值。此时,在锁存器中使用交叉耦合反相器到底是不是一个坏主意,它们毕竟需要更少的晶体管。我们将看到,实现用于读取和写入SRAM单元的电路的开销是非常重要的,开销不足以证明以SRAM单元为核心制作锁存器的合理性。

交叉耦合的反相器连接到每一侧(W1、W2)上的晶体管,W1和W2的栅极连接到被称为字线的相同信号,两个反相器W1和W2中的四个晶体管构成SRAM单元,它总共有六个晶体管。现在,如果字线上的电压低,则W1和W2关断,不可能读取或写入SRAM单元。然而,如果字线上的信号为高,则W1和W2导通,可以访问SRAM单元。

下图显示了一个典型的SRAM阵列,SRAM单元被布置为二维矩阵。一行中的所有SRAM单元共享字线,一列中的所有SRAM单元共享一对位线。要激活某个SRAM单元,必须打开其相关的字线,由解码器完成,获取地址位的子集,并打开适当的字线。一行SRAM单元可能包含100多个SRAM单元,通常,我们会对32个SRAM单元(在32位机器上)的值感兴趣。在这种情况下,列复用器/解复用器选择属于感兴趣的SRAM单元的位线,使用地址中的位的子集作为列选择位。这种设计方法也称为2.5D存储器组织。

SRAM单元阵列。

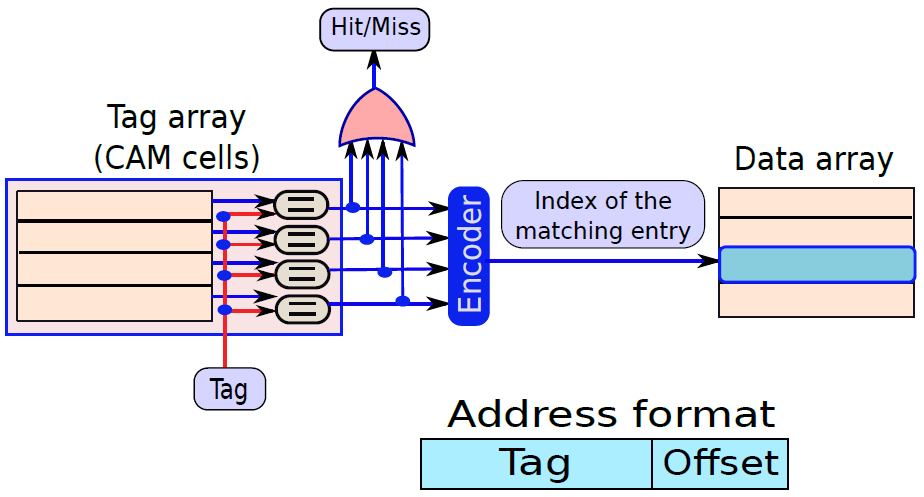

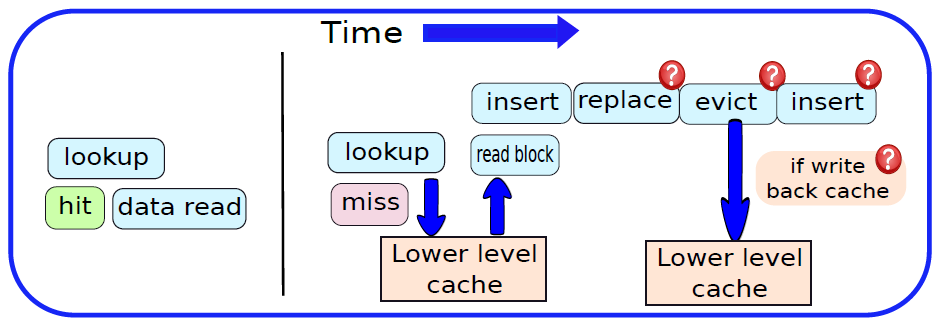

19.2.6.2 内容寻址内存(CAM)

下图是10晶体管CAM单元,如果SRAM单元中存储的值V不等于输入位AiAi,那么我们希望将匹配线的值设置为0。在CAM单元中,上半部分是具有6个晶体管的常规SRAM单元,下半部有4个额外的晶体管。现在让我们考虑晶体管T1,它连接到全局匹配线,晶体管T2。T1由存储在SRAM单元中的值V控制,T2由¯¯¯¯¯¯AiAi¯控制。假设V=¯¯¯¯¯¯AiAi¯,如果两者都为1,则晶体管T1和T2处于导通状态,并且匹配线和地之间存在直接导电路径。因此,匹配线的值将设置为0。然而,如果V和¯¯¯¯¯¯AiAi¯都为0,则通过T1和T2的路径不导通。但是,在这种情况下,通过T3和T4的路径变得导通,因为这些晶体管的栅极分别连接到¯¯¯¯VV¯和AiAi。两个栅极的输入都是逻辑1,因此匹配线将被下拉到0。读取器可以反过来验证,如果V=AiAi,则不形成导通路径。因此,如果存储的值与输入位AiAi不匹配,则CAM单元将匹配线驱动到逻辑0。

10晶体管CAM单元。

下图显示了CAM单元阵列。该结构主要类似于SRAM阵列。我们可以通过索引寻址一行,并执行读/写访问,此外可以将CAM单元的每一行与输入A进行比较。如果任何行与输入匹配,则相应的匹配线的值将为1。可以计算所有匹配线的逻辑OR,并确定CAM阵列中是否匹配,此外可以将CAM阵列的所有匹配线连接到优先级编码器,以查找与数据匹配的行的索引。

CAM单元阵列。

19.2.6.3 动态内存(DRAM)

现在来看看一种只使用一个晶体管来节省一点时间的存储器技术,它非常密集、面积大,而且能效高,但比SRAM和锁存器慢得多,适用于大型片外存储器。

基本DRAM(动态内存)单元如下图所示。单个晶体管的栅极连接到字线,从而启用或禁用它,其中一个端子连接到存储电荷的电容器。如果存储的位是逻辑1,则电容器带电,否则不带电。

一个动态内存的单元。

DRAM和SRAM单元的对比图。

因此,读取和写入值非常容易。我们需要首先设置字线,以便可以访问电容器。为了读取该值,需要感测位线上的电压。如果它处于地电位,则单元存储0,否则如果它接近电源电压,则存储1。类似地,要写入值,我们需要将位线(BL)设置为适当的电压,并设置字线,电容器将相应地充电或放电。

然而,就DRAM而言,并非一切都是免费的。让我们假设电容器被充电到等于电源电压的电压,实际上,电容器将通过电介质和晶体管逐渐泄漏一些电荷。该电流很小,但在长时间内电荷的总损失可能很大,最终会使电容器放电。为了防止这种情况,有必要定期刷新DRAM单元的值,亦即需要读取并写回数据值。这也需要在读取操作之后完成,因为电容器在对位线充电时会损失一些电荷。现在让我们尝试制作一个DRAM单元阵列。

我们可以用创建SRAM单元阵列的方法构建DRAM单元阵列(下图),有三点不同:

- 存在一条位线而不是两条位线。

- 有一个连接到位线的专用刷新电路。这在读取操作后使用,也会定期调用。

- 在这种情况下,感测放大器出现在列复用器/解复用器之前。读出放大器还为整个DRAM行(也称为DRAM页)缓存数据。它们确保对同一DRAM行的后续访问是快速的,因为它们可以直接从读出放大器进行服务。

DRAM单元阵列。

接下来简述现代DRAM的时序方面。在过去的好日子里,DRAM内存是异步访问的,意味着DRAM模块没有做出任何时序保证。但现在每个DRAM操作都与系统时钟同步,因此,如今的DRAM芯片是同步DRAM芯片(SDRAM芯片)。

截至目前,同步DRAM存储器通常使用DDR4或DDR5标准,DDR代表双倍数据速率,使用最早标准DDR1的设备在时钟的上升沿和下降沿向处理器发送8字节的数据包,DDR也被称为双峰(double pump)操作。DDR1的峰值数据速率为1.6 GB/s,后续的DDR世代通过以更高的频率传输数据来扩展DDR1,例如,DDR2的数据速率是DDR1设备的两倍(3.2 GB/s),DDR3通过使用更高的总线频率将峰值传输速率进一步提高了一倍,自2007年开始使用(峰值速率为6.4GB/s)。

19.2.6.4 只读内存(ROM)

只读内存可分为普通ROM和PROM(可编程ROM),下面分别是它们的单元图例。

(a) 存储逻辑0的ROM单元;(b) 存储逻辑1的ROM单元。

PROM单元。

19.2.6.5 可编程逻辑阵列

事实证明,我们可以很容易地用类似于PROM单元的存储单元制作组合逻辑电路,这种器件被称为可编程逻辑阵列或PLA。PLA在实践中用于实现由数十或数百个小项(minterm)组成的复杂逻辑函数,相对于由逻辑门组成的硬连线电路的优势在于它是灵活的,我们可以在运行时更改PLA实现的布尔逻辑,相比之下,由硅制成的电路永远不会改变其逻辑。其次,PLA的设计和编程更简单,而且有很多软件工具可以设计和使用PLA。最后,PLA可以有多个输出,因此可以很容易地实现多个布尔函数。这种额外的灵活性是有代价的,代价是性能。

下图(a)所示的PLA单元原则上类似于基本PROM单元。如果栅极处的值(E)等于1,则NMOS晶体管处于导通状态。因此,NMOS晶体管的源极和漏极端子之间的电压差非常小。换句话说,可以简单地假设结果线的电压等于信号的电压,X. If (E = 0),NMOS晶体管处于截止状态。结果线是浮动的,并保持其预充电电压。在这种情况下,我们建议推断逻辑1。

现在让我们构建一行PLA单元,其中每个PLA单元在其源极端子处连接到输入线,如图(b)所示。输入编号为X1…Xn,所有NMOS晶体管的漏极连接到结果线,PLA单元的晶体管的栅极连接到一组使能信号E1…En。如果任何一个使能信号等于0,则该特定晶体管被禁用,我们可以将其视为从PLA阵列中逻辑移除。

一个PLA单元。

现在让我们创建一个PLA单元格数组,如下图所示,每行对应一个minterm。对于我们的3变量示例,每行由6列组成,每个变量有2列(原始和补充),例如,前两列分别对应于A和¯¯¯¯AA¯。在任何一行中,这两列中只有一列包含PLA单元,因为A和¯¯¯¯AA¯不能同时为真。在第一行,计算最小项¯¯¯¯¯¯¯¯¯¯¯¯ABCABC¯的值,因此第一行包含对应于¯¯¯¯AA¯、¯¯¯¯BB¯和¯¯¯¯CC¯的列中的PLA单元。我们在其余行中为剩余的minterm进行类似的连接,PLA阵列的这一部分被称为AND平面,因为我们正在计算变量值(原始值或补码值)的逻辑AND。PLA阵列的AND平面独立于我们希望计算的布尔函数,给定输入,它计算所有可能的最小项的值。

PLA单元阵列。

典型的内存封装引脚和信号。

256 KB内存组织。

1MB内存组织。

DDR代次演进图。

非易失性RAM技术。

上:简化的DRAM读取时序;下:Signetics 7489 SRAM的脉冲串。

19.2.7 计算机算术

本节将设计算术运算的硬件算法,先阐整数运算的算法,如两个二进制数相加的基本算法,有很多方法可以完成这些基本操作,每种方法都有自己的优缺点。注意,二进制减法的问题在概念上与2的补码系统中的二进制加法相同。因此,我们不需要单独对待它。随后,我们将看到,n个数的相加问题与乘法问题密切相关,而且这是一个硬件上的快速操作。遗憾的是,整数除法并不存在非常有效的方法。然而,我们将考虑两种用于划分正二进制数的流行算法。

整数算术之后,我们将研究浮点(带小数点的数字)算术的方法,大多数整数算法稍作修改后都可以移植到浮点数领域。与整数除法相比,浮点除法可以非常有效地完成。

19.2.7.1 加法

让我们看看将两个1位数字a和b相加的问题,a和b都可以取两个值:0或1,因此,a和b有四种可能的组合,它们的二进制和可以是00、01或10。当a和b均为1时,它们的和将是10,两个1位数字的总和可能有两位长。让我们将结果的LSB称为和,将MSB称为进位,例如,把8和9相加,和是7,进位是1。

可以将和和进位的概念扩展到加三个1位数字。如果我们将三个1位数字相加,那么结果的范围是二进制的00到11之间。

和(sum):总和是两个或三个1位数字相加结果的LSB。

进位(carry):进位是两个或三个1位数字相加结果的MSB。

对于可以将两个1位数字相加的加法器,将有两个输出位:和s和进位c,将两个位相加的一个加法器称为半加法器(half adder)。半加法的真值表如下表所示。

| a | b | s | c |

|---|---|---|---|

| 0 | 0 | 0 | 0 |

| 0 | 1 | 1 | 0 |

| 1 | 0 | 1 | 0 |

| 1 | 1 | 0 | 1 |

半加法器。

可以加3位的加法器称为全加法器(full adder),它的电子构造如下:

n位加法器被称为纹波进位加法器(ripple carry adder),其设计如下所示:

考虑将两个数字A和B相加的问题,首先将比特集划分为4比特的块,如下图所示,每个块包含一个a片段和一个B片段。通过考虑块的输入进位将这两个片段相加,并生成一组和位和一个进位,此进位是后续块的输入进位。

此外,还有超前进位加法器(Carry Lookahead Adder),其分为两个阶段,每个阶段都拥有复杂的电子构造。

19.2.7.2 乘法

现与加法类似,先看看两个十进制数相乘的最简单的方法,不妨尝试将13乘以9。在这种情况下,13被称为被乘数(multiplicand),9被称为乘数(multiplier),117是乘积(product)。

下图(a)显示了十进制的乘法,(b)显示了二进制的乘法。请注意,两个二进制数相乘的方法与十进制数完全相同。我们需要考虑乘数从最小显著位置到最大显著位置的每一位。如果该位为1,那么我们将被乘数的值写在该行下方,否则我们将写0。对于每个乘数位,我们将被乘数向左移动一位。其原因是每个乘数位代表2的更高幂。我们将每个这样的值称为部分和(见图7.10(b))。如果乘法器有m位,那么我们需要将m个部分和相加以获得乘积。在这种情况下,乘积是十进制117,二进制1110101。读者可以验证它们实际上表示相同的数字。为了便于以后的表示,让我们定义另一个称为部分积的术语。它是部分和的连续序列的和。

(a)十进制乘法;(b)二进制乘法。

常规的乘法器是O(n2)O(n2),而改进版的Booth乘法器或Wallace树形乘法器(下图)可以做到O(log(n))O(log(n))的算法复杂度。

Wallace树形乘数。

19.2.7.3 除法

现在让我们看看整数除法。不幸的是,与加法、减法和乘法不同,除法是一个明显较慢的过程。任何除法运算都可以表示如下:

N=DQ+RN=DQ+R

N是被除数,D是除数,Q是商,R是余数。假定除数和被除数为正,除法过程需要满足以下属性:

- R<DR<D且R≥0R≥0。

- Q是满足上述等式的最大正整数。

如果我们想除掉负数,那么首先将它们转换成正数,进行除法,然后调整商和余数的符号,部分ISA试图确保余数始终为正。在这种情况下,需要将商减1,并将除数与余数相加,使其为正。

实现除法的方式有迭代除法、佘数恢复除法(Restoring Division)、非余数恢复除法(Non-Restoring Division)等。本文忽略这些算法的具体描述,有兴趣的童鞋可以自行查阅资料。

19.2.7.4 浮点数运算

浮点加法和减法的问题实际上是同一问题的不同方面。A-B可以用两种方式解释,可以说正在从A中减去B,也可以说在将-B加到A中。因此,与其单独看减法,不如将其视为加法的特例。浮点数的二进制表示、属性和特殊含义可以参见:17.2.2 浮点数。

下图显示了一个示例,说明了如何将有效位解压缩,并将其放入普通浮点数的寄存器中。在32位IEEE 754格式中,尾数有23位,小数点前有0或1。因此,有效位需要24位,如果我们希望添加前导符号位(0),那么我们需要25位存储。让我们把这个号码保存在一个寄存器中,并称之为W。

展开有效位并放入寄存器。

IEEE 754格式。

浮点数的运算涉及舍入等考量,下图显示了两个浮点数相加的算法,考虑了0值。

累加两个浮点值的流程图。

浮点数相乘算法与泛型加法算法的形式完全相同,只需几步。让我们尝试乘以A x B以获得乘积C,乘法的流程图如下图所示。在乘法的情况下,我们不必对齐指数,如下初始化算法,将B的符号和装入寄存器W,W的宽度等于操作数大小的两倍,就可以容纳乘积。E寄存器初始化为EA+EB−biasEA+EB−bias,因为在乘法的情况下,指数相加,减去bias以避免重复计数,计算结果的符号很简单。

两个浮点值相乘的流程图。

此外,还有Goldschmidt除法以及Newton-Raphson除法。

Newton-Raphson方法。

19.3 计算机架构和组织

19.3.1 计算机层级

计算机系统级层次结构是将计算机与用户连接起来并使用计算机的不同级别的组合,还描述了如何在计算机上执行计算活动,并显示了在不同级别的系统中使用的所有元素。通用的计算机系统级层次结构由7个级别组成:

| 层级 | 功能 | 举例 | 解析 |

|---|---|---|---|

| 层6 | 用户 | 可执行程序 | 包含用户和可执行程序。 |

| 层5 | 高级语言 | C++、Java | 高级语言包括 C++、Java、FORTRAN和许多其他语言,是用户发出命令的语言。 |

| 层4 | 汇编语言 | 汇编代码 | 汇编语言是计算机系统的下一个层次。机器只理解汇编语言,因此按照顺序,所有高级语言都在汇编语言中进行了更改,汇编代码是为它编写的。 |

| 层3 | 系统软件 | 操作系统 | 系统软件种类繁多,主要帮助操作进程,并建立硬件和用户界面之间的连接,可能包括操作系统、库代码等。 |

| 层2 | 机器 | 指令集架构(ISA) | 在计算机系统中使用不同类型的硬件来执行不同类型的活动,包含指令集架构。 |

| 层1 | 控制层 | 微码(microcode) | 控制是系统中使用微码的级别,控制单元包括在这一级别的计算机系统中。 |

| 层0 | 数字逻辑 | 电路、门 | 数字逻辑是数字计算的基础,提供了对计算机内电路和硬件如何通信的基本理解,由各种电路和门等组成。 |

当然,也存在另一种层级划分,从上到下分别是:游戏应用、游戏引擎、图形API、操作系统、设备驱动、硬件设备。

下图是更加详细的层级模块,其中操作系统(OS)处于图形API等第三方SDK和驱动之间,充当着承上启下的重要作用和通讯桥梁,是整个计算机层级架构极其重要的组成部分。

在底层,计算机硬件由处理器、内存和I/O组件组成,每种类型有一个或多个模块。这些组件以某种方式互连,以实现计算机的主要功能,即执行程序。有四个主要结构要素:

- 处理器:控制计算机的操作并执行其数据处理功能。当只有一个处理器时,它通常被称为中央处理单元(CPU)。

- 主存储器:存储数据和程序。易丢失,当计算机关闭时,内存中的内容会丢失。相反,即使计算机系统关闭,磁盘内存的内容也会保留。主存储器也称为实存储器或主存储器。

- I/O模块:在计算机及其外部环境之间移动数据外部环境由各种设备组成,包括辅助存储器设备(如磁盘)、通信设备和终端。

- 系统总线:提供处理器、主存储器和I/O模块之间的通信。

19.3.2 架构vs组织

计算机架构(Computer Architecture)是对计算机各个部分的需求和设计实现的功能描述,处理计算机系统的功能行为。在设计计算机时,它出现在计算机组织之前。

计算机组织(Computer Organization)出现在计算机体系架构之后,是操作属性如何链接在一起并有助于实现架构规范的方式,处理的是结构关系。

简单而言,架构是呈现给软件设计师的计算机视图,组织是计算机在硬件上的实际实现。

计算机的层级设计、硬件、软件和架构、组织的关系图。

数字计算机方框图。

计算机体系架构和计算机组织之间的详细区别如下表:

| 计算机架构 | 计算机组织 | |

|---|---|---|

| 1 | 描述计算机的功能。 | 描述计算机是如何做到的。 |

| 2 | 处理计算机的功能行为。 | 处理计算机的结构关系。 |

| 3 | 在上图,很明显它处理的是高层级的设计问题。 | 在上图,也很明显它处理的是低层级的设计问题。 |

| 4 | 表明硬件。 | 表明性能。 |

| 5 | 作为程序员,可以将架构视为一系列指令、寻址模式和寄存器。 | 架构的实现称为组织。 |

| 6 | 对于设计一台计算机,它的架构是固定的。 | 为了设计一台计算机,它的组织根据其架构而定。 |

| 7 | 也被称为指令集架构 (ISA)。 | 通常被称为微体系架构(microarchitecture)。 |

| 8 | 包括逻辑功能,例如指令集、寄存器、数据类型和寻址模式。 | 由电路设计、外围设备和加法器等物理单元组成。 |

| 9 | 架构类别:冯诺依曼、Harvard、ISA、系统设计。 | CPU组织根据地址字段的数量分为三类:单累加器组织、通用寄存器组织、堆栈组织。 |

| 10 | 使计算机的硬件可见。 | 提供了有关计算机性能的详细信息。 |

| 11 | 协调系统的硬件和软件。 | 处理系统中的网络段。 |

| 12 | 软件开发人员意识到它。 | 它逃脱了软件程序员的检测。 |

| 13 | 示例:Intel和AMD创建了x86处理器,Sun Microsystems和其他公司创建了SPARC处理器,Apple、IBM和摩托罗拉创建了PowerPC。 | 组织质量包括程序员看不到的硬件元素,例如计算机和外围设备的接口、内存技术和控制信号。 |

19.3.3 冯·诺伊曼架构

历史上有两种类型的计算机:

- 固定程序计算机:它们的功能非常具体,不能重新编程,例如计算器。

- 存储程序计算机:可以被编程以执行许多不同的任务,应用程序存储在它们上面,因此得名。

现代计算机基于John Von Neumann(约翰·冯·诺依曼)引入的存储程序概念。在这种存储程序的概念中,程序和数据存储在称为存储器的单独存储单元中,并被同等对待,意味着用这种架构构建的计算机将更容易重新编程。 其基本结构是这样的:

有着输入、处理、输出等概念和组成的计算机模型称为冯·诺伊曼架构,它是一种将程序指令存储器和数据存储器合并在一起的电脑设计概念结构,是一种实现通用图灵机的计算设备,以及一种相对于并行计算的序列式结构参考模型(referential model)。冯·诺伊曼隐式指导了将存储设备与中央处理器分开的概念,也被称为ISA(指令集架构)计算机。

冯·诺依曼1947年出版的《电子计算仪器问题的规划和编码》中的流程图。

冯·诺依曼结构的抽象组成如下:

更进一步地,它约定了用二进制进行计算和存储,还定义计算机基本结构为5个部分,分别是中央处理器(CPU)、内存、输入设备、输出设备、总线。

结合上图,各部分结构的具体描述如下:

-

存储器:代码跟数据在RAM跟ROM中是线性存储, 数据存储的单位是一个二进制位,最小的存储单位是字节。

-

总线:总线是用于 CPU 和内存以及其他设备之间的通信,总线主要有三种:

-

地址总线:用于指定 CPU 将要操作的内存地址。

-

数据总线:用于读写内存的数据。

-

控制总线:用于发送和接收信号,比如中断、设备复位等信号,CPU收到信号后响应,这时也需要控制总线。

-

-

输入/输出设备:输入设备向计算机输入数据,计算机经过计算后,把数据输出给输出设备。比如键盘按键时需要和CPU进行交互,这时就需要用到控制总线。

-

CPU:中央处理器,类比人脑,作为计算机系统的运算和控制核心,是信息处理、程序运行的最终执行单元。它的结构如下所示:

- 控制单元(CU):处理所有处理器控制信号,指导所有输入和输出流,获取指令代码,并控制数据在系统中的移动方式。

- 算术逻辑单元 (ALU) :处理CPU可能需要的所有计算(如加法、减法、比较),执行逻辑运算、位移运算和算术运算。

- 主存储器单元(寄存器):CPU用寄存器存储计算时所需数据,寄存器一般有以下几种:

- 累加器(Accumulator):存储ALU的计算结果。

- 程序计数器(PC):跟踪要处理的下一条指令的内存位置,然后PC将下一个地址传递给内存地址寄存器 (MAR)。

- 内存地址寄存器(MAR):存储需要从内存中取出或存储到内存中的指令的内存位置。

- 内存数据寄存器(MDR):存储从内存中获取的指令或任何要传输到内存并存储在内存中的数据。

- 指令寄存器(IR):可分为两种:

- 当前指令寄存器(CIR):在等待编码和执行时存储最近获取的指令。

- 指令缓冲寄存器(IBR):不立即执行的指令放在指令缓冲寄存器IBR中。

- 通用寄存器(GPR):存放需要进行运算的数据,比如需进行加法运算的两个数据。

在冯诺伊曼体系下计算机指令执行的简要过程如下:

- CPU读取程序计数器获得指令内存地址,CPU控制单元操作地址总线从内存地址拿到数据,数据通过数据总线到达CPU被存入指令寄存器。

- CPU分析指令寄存器中的指令,如果是计算类型的指令交给逻辑运算单元,如果是存储类型的指令交给控制单元执行。

- CPU 执行完指令后程序计数器的值通过自增指向下个指令,比如32位CPU会自增4。

- 自增后开始顺序执行下一条指令,不断循环执行直到程序结束。

冯诺依曼瓶颈(Von Neumann bottleneck)是无论做什么来提升性能,都无法摆脱这样一个事实,即一次只能执行一条指令,并且只能按顺序执行,这两个因素都阻碍了CPU的能力。我们可以为冯诺依曼处理器提供更多缓存、更多RAM或更快的组件,但如果要在CPU性能方面取得原始收益,则需要对CPU配置进行有影响力的检查。 这种架构非常重要,用于PC乃至超级计算机。

19.3.4 多核结构

下图是典型多核计算机主要部件的简化视图。大多数计算机,包括智能手机和平板电脑中的嵌入式计算机,以及个人计算机、笔记本电脑和工作站,都安装在主板上。印刷电路板(PCB)是一种刚性的平板,用于固定和互连芯片和其他电子部件,该电路板由通常为两到十层的层组成,这些层通过蚀刻到电路板中的铜路径将组件互连。计算机中的主要印刷电路板称为系统板或主板,而插入主板插槽的较小的印刷电路板则称为扩展板。主板上最突出的元素是芯片,芯片是一块半导体材料,通常是硅,在其上制造电子电路和逻辑门,所得产品称为集成电路。

多核计算机主要元件的简化视图。

下图左是IBM zEnterprise EC12大型计算机处理器芯片的照片,有27.5亿个晶体管,有六个内核(处理器),还有两个标记为L3缓存的大区域,由所有六个处理器共享,L3控制逻辑控制L3高速缓存和内核之间以及L3高速缓存与外部环境之间的流量。此外,在核心和L3缓存之间还有存储控制(SC)逻辑,内存控制器(MC)功能控制对芯片外部内存的访问,GX I/O总线控制访问I/O的通道适配器的接口。下图右则展示了单个核的内部结构,只是构成单个处理器芯片的硅表面区域的一部分。

晶片(Wafer)、芯片(Chip)和门(Gate)之间的关系如下:

QPI(QuickPath Interconnect)是Intel于2008年推出的点对点互连方法,QPI和其他点对点互连方案的重要特征是多个直接连接、分层协议架构和分组数据传输。

下图说明了QPI在多核计算机上的典型使用。QPI链路(由图中的绿色箭头对表示)形成了一个交换结构,使数据能够在整个网络中移动,可以在每对核心处理器之间建立直接QPI连接。如果图中的核心A需要访问核心D中的内存控制器,则它通过核心B或C发送请求,后者必须将该请求转发到核心D的内存控制器。同样,具有八个或更多处理器的大型系统可以使用具有三个链路的处理器构建,并通过中间处理器路由流量。

使用QPI的多核配置。

QPI层示意图。

不同的芯片组织。

多核组织备选方案。

19.3.5 嵌入式系统

术语嵌入式系统是指在产品中使用电子设备和软件,而不是通用计算机,如平板电脑或台式机系统。每年售出数百万台电脑,包括笔记本电脑、个人电脑、工作站、服务器、大型机和超级计算机,相比之下,每年生产数十亿个嵌入大型设备的计算机系统。如今,许多(也许是大多数)使用电力的设备都有嵌入式计算系统,在不久的将来,几乎所有这样的设备都将具有嵌入式计算系统。

具有嵌入式系统的设备类型几乎太多,无法列出,样例包括手机、数码相机、摄像机、计算器、微波炉、家庭安全系统、洗衣机、照明系统、恒温器、打印机、各种汽车系统(如变速器控制、巡航控制、燃油喷射、防抱死制动和悬挂系统)、网球拍、牙刷以及自动化系统中的多种类型的传感器和致动器。

通常,嵌入式系统与其环境紧密耦合,导致与环境交互的需要所施加的实时约束。约束条件(如所需的运动速度、所需的测量精度和所需的持续时间)决定了软件操作的时间,如果必须同时管理多个活动,会带来更复杂的实时约束。

下图概括地显示了嵌入式系统组织,除了处理器和内存之外,还有许多元素与典型的台式机或笔记本电脑不同:

嵌入式系统的可能组织。

- 可能存在多种接口,使系统能够测量、操作和以其他方式与外部环境交互。嵌入式系统通常通过传感器和致动器与外部世界交互(感知、操纵和通信),因此通常是反应系统,反应系统与环境持续交互,并以该环境确定的速度执行。

- 人机界面可以像闪光灯一样简单,也可以像实时机器人视觉一样复杂。在许多情况下,没有人机界面。

- 诊断端口可用于诊断所控制的系统,而不仅仅用于诊断计算机。

- 可使用专用现场可编程(FPGA)、专用(ASIC)或甚至非数字硬件来提高性能或可靠性。

- 软件通常具有固定的功能,并且特定于应用程序。

- 效率对于嵌入式系统至关重要。需针对能量、代码尺寸、执行时间、重量、体积以及成本进行了优化。

与通用计算机系统也有几个值得注意的相似之处:

- 即使使用名义上固定功能的软件,现场升级以修复错误、提高安全性和添加功能的能力对于嵌入式系统来说也变得非常重要,而不仅仅是在消费类设备中。

- 一个相对较新的发展是支持多种应用的嵌入式系统平台,良好例子是智能手机和音频/视频设备(如智能电视)。

19.3.5.1 微处理器与微控制器

早期的微处理器芯片包括寄存器、ALU和某种控制单元或指令处理逻辑。随着晶体管密度的增加,有可能增加指令集架构的复杂性,最终增加内存和多个处理器,现代微处理器芯片包括多个内核和大量的高速缓存。

微控制器芯片对可用的逻辑空间进行了实质上不同的使用,下图概括地显示了微控制器芯片上常见的元件。微控制器是包含处理器、用于程序的非易失性内存(ROM)、用于输入和输出的易失性内存(RAM)、时钟和I/O控制单元的单个芯片。微控制器的处理器部分具有比其他微处理器低得多的硅面积和高得多的能量效率。

也被称为“芯片上的计算机”,每年数十亿个微控制器单元被嵌入到从玩具到家电到汽车的各种产品中,比如单个车辆可以使用70个或更多个微控制器。通常,特别是对于更小、更便宜的微控制器,它们被用作特定任务的专用处理器,比如微控制器在自动化过程中被大量使用。通过提供对输入的简单反应,它们可以控制机器、打开和关闭风扇、打开和闭合阀门等,是现代工业技术的组成部分,是生产能够处理极其复杂功能的机械的最廉价的方法之一。

微控制器具有多种物理尺寸和处理能力,处理器的范围从4位到32位架构。微控制器往往比微处理器慢得多,通常工作在MHz范围,而不是微处理器的GHz速度。微控制器的另一个典型特征是它不提供人机交互,被编程用于特定任务,嵌入其设备中,并在需要时执行。

19.3.5.2 嵌入式与深度嵌入式系统

嵌入式系统的一个子集,以及相当多的子集,被称为深度嵌入式系统(Deeply embedded system)。尽管这个术语在技术和商业文献中被广泛使用,但你会在互联网上无法明确地寻找一个直截了当的定义。通常,我们可以说,一个深度嵌入式系统有一个处理器,其行为很难被程序员和用户观察到。深度嵌入式系统使用微控制器而不是微处理器,一旦设备的程序逻辑被烧录到ROM(只读存储器)中,就不可编程,并且与用户没有交互。

深度嵌入式系统是专用的、单用途的设备,可以检测环境中的某些东西,执行基本级别的处理,然后对结果进行处理。深度嵌入式系统通常具有无线能力,并以联网配置出现,例如部署在大面积(例如,工厂、农业领域)上的传感器网络,物联网在很大程度上依赖于深度嵌入式系统。典型地,深度嵌入式系统在内存、处理器大小、时间和功耗方面具有极端的资源限制。

19.3.6 ARM架构

ARM架构是指从RISC设计原则演变而来的处理器架构,用于嵌入式系统。本节将简述之。

ARM指令集是高度规则的,旨在高效实现处理器和高效执行。所有指令均为32位长,遵循常规格式,使得ARM ISA适合在广泛的产品上实现。

增强基本ARM ISA的是Thumb指令集,是ARM指令集的重新编码子集。Thumb旨在提高使用16位或更窄内存数据总线的ARM实现的性能,并允许比ARM指令集提供的代码密度更好的代码密度。Thumb指令集包含记录为16位指令的ARM 32位指令集的子集。前些年定义的版本是Thumb-2。

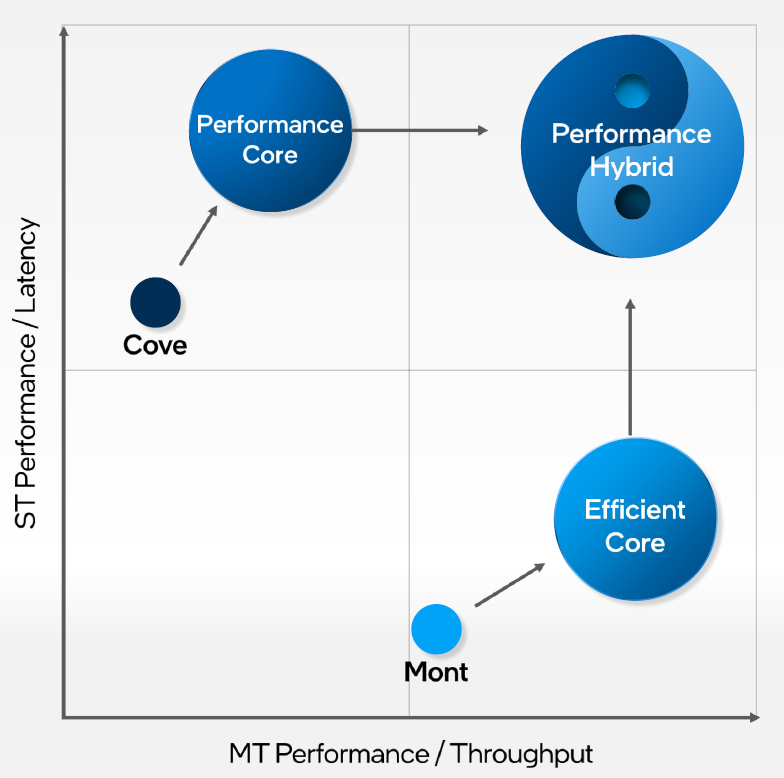

ARM Holdings许可了许多专用微处理器和相关技术,但其产品线的大部分是Cortex系列微处理器架构。有三种Cortex架构,方便地用缩写A、R和M标记。

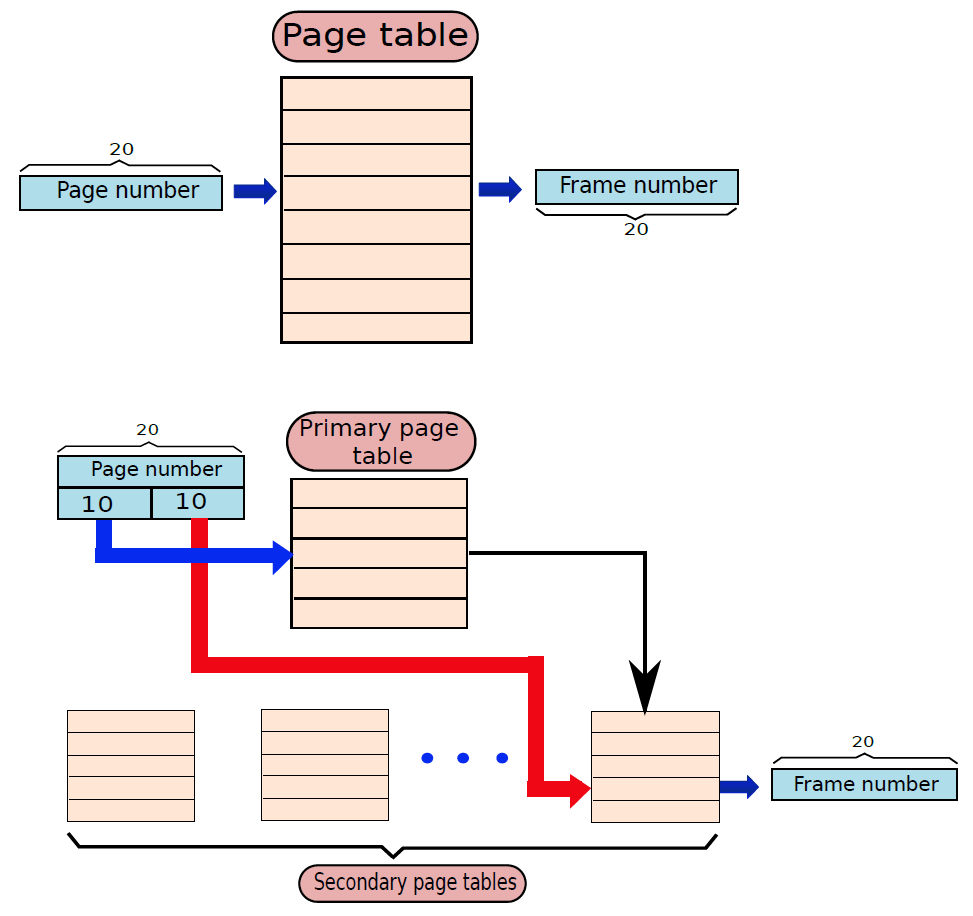

-

Cortex-A和Cortex-A50:是应用处理器,适用于智能手机和电子书阅读器等移动设备,以及数字电视和家庭网关(如DSL和有线互联网调制解调器)等消费设备。这些处理器以更高的时钟频率(超过1GHz)运行,并支持内存管理单元(MMU),是全功能操作系统(如Linux、Android、MS Windows和移动操作系统)所需的。MMU是通过将虚拟地址转换为物理地址来支持虚拟内存和分页的硬件模块。这两种架构同时使用ARM和Thumb-2指令集,主要区别在于Cortex-A是32位机器,而Cortex-A50是64位机器。

-

Cortex-R:设计用于支持实时应用程序,其中需要通过对事件的快速响应来控制事件的定时。它们可以在相当高的时钟频率(例如200MHz到800MHz)下运行,并且具有非常低的响应延迟。Cortex-R包括对指令集和处理器组织的增强,以支持深度嵌入式实时设备。这些处理器中的大多数没有MMU,有限的数据需求和有限数量的同时处理消除了对虚拟内存的复杂硬件和软件支持的需求。Cortex-R确实具有专为工业应用设计的内存保护单元(MPU)、缓存和其他内存功能。MPU是一种硬件模块,它禁止内存中的一个程序意外访问分配给另一个活动程序的内存。使用各种方法,在程序周围创建一个保护边界,并且禁止程序内的指令引用该边界之外的数据。使用Cortex-R的嵌入式系统包括汽车制动系统、大容量存储控制器、网络和打印设备。

-

Cortex-M:主要是为微控制器领域开发的,在微控制器领域,快速、高确定性中断管理的需求与极低门计数和最低可能功耗的需求相结合。与Cortex-R系列一样,Cortex-M架构有一个MPU,但没有MMU。Cortex-M仅使用Thumb-2指令集,其市场包括物联网设备、工厂和其他企业使用的无线传感器/致动器网络、汽车车身电子设备等。Cortex-M系列包含Cortex-M0、Cortex-M0+、Cortex-M3、Cortex-M4等版本。下图是基于Cortex-M3的典型单片机芯片:

19.3.7 云计算

尽管云计算的一般概念可以追溯到20世纪50年代,但云计算服务在2000年代初首次出现,尤其是针对大型企业。从那时起,云计算已经扩展到中小型企业,最近还扩展到了消费者。苹果的iCloud于2012年推出,在推出一周内就拥有2000万用户,2008年推出的基于云的笔记和归档服务Evernote在不到6年的时间内就接近了1亿用户。本节将简要概述。

在许多组织中,越来越突出的趋势是将大部分甚至所有信息技术(IT)运营转移到称为企业云计算的互联网连接基础设施。与此同时,个人电脑和移动设备的个人用户越来越依赖云计算服务来备份数据、同步设备和使用个人云计算进行共享。NIST在NIST SP-800-145(NIST云计算定义)中对云计算的定义如下:

云计算(Cloud computing):是一种模型,用于实现对可配置计算资源(例如,网络、服务器、存储、应用程序和服务)的共享池的无处不在、方便的按需网络访问,这些资源可以通过最小的管理工作量或服务提供商交互快速调配和发布。

基本上,通过云计算,可以获得规模经济、专业网络管理和专业安全管理,这些功能对大小公司、政府机构以及个人电脑和移动用户都有吸引力。个人或公司只需支付所需的存储容量和服务费用,无论是公司还是个人,用户都无需设置数据库系统、获取所需的硬件、进行维护和备份数据,所有这些都是云服务的一部分。

理论上,使用云计算存储数据并与其他人共享数据的另一大优势是云提供商负责安全。客户并不总是受到保护,云提供商之间出现了许多安全故障,例如Evernote在2013年初成为头条新闻,当时它告诉所有用户在发现入侵后重置密码。

云网络是指必须具备的网络和网络管理功能,以支持云计算。大多数云计算解决方案都依赖于互联网,但这只是网络基础设施的一部分。云网络的一个示例是在提供商和订户之间提供高性能和/或高可靠性网络,在这种情况下,企业和云之间的部分或全部流量绕过互联网,使用云服务提供商拥有或租用的专用专用网络设施。更一般地说,云联网是指访问云所需的网络能力的集合,包括利用互联网上的专门服务、将企业数据中心链接到云,以及在关键点使用防火墙和其他网络安全设备来强制执行访问安全政策。

我们可以将云存储视为云计算的一个子集,本质上,云存储由远程托管在云服务器上的数据库存储和数据库应用程序组成,使小型企业和个人用户能够利用可根据其需求扩展的数据存储,并利用各种数据库应用程序,而无需购买、维护和管理存储资产。

云计算的基本目的是提供方便的计算资源租赁,云服务提供商(CSP)维护通过互联网或专用网络可用的计算和数据存储资源,客户可以根据需要租用这些资源的一部分。实际上,所有云服务都是使用三种模型之一提供的(下图):SaaS、PaaS和IaaS。

替代信息技术架构。

云计算元素。

云服务模型。

19.4 ISA

19.4.1 ISA定义

就像任何语言都有有限的单词一样,处理器可以支持的基本指令/基本命令的数量也必须是有限的,这组指令通常称为指令集(instruction set),基本指令的一些示例是加法、减法、乘法、逻辑或和逻辑非。请注意,每条指令需要处理一组变量和常量,最后将结果保存在变量中,这些变量不是程序员定义的变量,是计算机内的内部位置。我们将指令集架构定义为:

指令集架构(instruction set architecture,ISA)是处理器支持的所有指令的语义,包括指令本身及其操作数的语义,以及与外围设备的接口。

指令集架构是软件感知硬件的方式,我们可以将其视为硬件输出到外部世界的基本功能列表。Intel和AMD CPU使用x86指令集,IBM处理器使用PowerPC R指令集,HP处理器使用PA-RISC指令集,ARM处理器使用ARMR指令集(或其变体,如Thumb-1和Thumb-2)。因此,不可能在基于ARM的系统上运行为Intel系统编译的二进制文件,因为指令集不兼容,但在大多数情况下,可以重用C/C++程序。要在特定架构上运行C/C++程序,我们需要为该特定架构购买一个编译器,然后适当地编译C/C++程序。

19.4.2 基础指令

基本计算机具有16位指令寄存器 (IR),可以表示内存引用或寄存器引用或输入输出指令。一种简单的指令格式可以是如下形式:

基础指令可分为以下几类:

- 内存引用

这些指令将内存地址称为操作数,另一个操作数总是累加器。下图为直接和间接寻址指定12位地址、3位操作码(111除外)和1位寻址模式。

示例:IR寄存器内容是0001XXXXXXXXXXXX,即ADD指令取指译码后发现是ADD操作的内存引用指令,因此:

DR ← M[AR]

AC ← AC + DR, SC ← 0

- 寄存器引用

这些指令对寄存器而不是内存地址执行操作。下图的IR(14 – 12) 为 111(将其与内存引用区分开),IR(15) 为 0(将其与输入/输出指令区分开),其余12位指定寄存器操作。

示例:IR寄存器内容是0111001000000000,即CMA在取指和解码周期后发现它是补码累加器的寄存器引用指令,因此:

AC ← ~AC

- 输入/输出

这些指令用于计算机和外部环境之间的通信。下图的IR(14 – 12) 为 111(将其与内存引用区分开来),IR(15) 为 1(将其与寄存器引用指令区分开),其余 12 位指定 I/O 操作。

示例:IR寄存器内容是1111100000000000,即INP经过取指和解码循环后发现它是用于输入字符的输入/输出指令。因此,来自外围设备的INPUT字符。

包含在16位IR寄存器中的指令集是:

- 算术、逻辑和移位指令(与、加、补、左循环、右循环等)。

- 将信息移入和移出内存(存储累加器,加载累加器)。

- 带有状态条件的程序控制指令(分支、跳过)。

- 输入输出指令(输入字符、输出字符)。

指令具体的描述如下表:

| 符号 | 16进制码 | 描述 |

|---|---|---|

| AND | 0xxx、8xxx | 与任意字到AC |

| ADD | 1xxx、9xxx | 累加任意字到AC |

| LDA | 2xxx、Axxx | 加载内存字到AC |

| STA | 3xxx、Bxxx | 存储AC字到内存 |

| BUN | 4xxx、Cxxx | 无条件分支 |

| BSA | 5xxx、Dxxx | 分支并保存返回地址 |

| ISZ | 6xxx、Exxx | 如果为0,则递增并跳过 |

| CLA | 7800 | 清理AC |

| CLE | 7400 | 清除E(溢出位) |

| CMA | 7200 | 补充AC |

| CME | 7100 | 补充E |

| CIR | 7080 | 右循环AC和E |

| CIL | 7040 | 左循环AC和E |

| INC | 7020 | 递增AC |

| SPA | 7010 | 如果AC>0,跳过下一条指令 |

| SNA | 7008 | 如果AC<0,跳过下一条指令 |

| SZA | 7004 | 如果AC=0,跳过下一条指令 |

| SZE | 7002 | 如果E=0,跳过下一条指令 |

| HLT | 7001 | 停止计算机 |

| INP | F800 | 输入字符到AC |

| OUT | F400 | 输出字符到AC |

| SKI | F200 | 跳过输入标志 |

| SKO | F100 | 跳过输出标志 |

| ION | F080 | 中断开启 |

| IOF | F040 | 中断关闭 |

19.4.3 指令集设计准则

现在让我们开始为处理器设计指令集的艰难过程,可以将指令集视为软件和硬件之间的法律合同,双方都需要履行各自的合同。软件部分需要确保用户编写的所有程序都能成功有效地转译成基本指令,同样,硬件需要确保指令集中的所有指令都是有效实现的。双方都需要做出合理的假设,ISA需要具有一些必要的特性和一些有效性所需的特性。

-

完整。ISA应能够实现所有用户程序,是绝对必要的要求,我们希望ISA能够代表用户为其编写的所有程序。例如,如果我们有一个ISA,只有一条ADD指令,那么我们将无法减去两个数字。为了实现循环,ISA应该有一些方法来一遍遍地重新执行同一段代码。如果没有这种对和while循环的支持,C程序中的循环将无法工作。

请注意,对于通用处理器,我们正在查看所有可能的程序。然而,许多用于嵌入式设备的处理器功能有限,例如执行字符串处理的简单处理器不需要支持模拟点数(带小数点的数字)。我们需要注意的是,不同的处理器被设计用于做不同的事情,因此它们的ISA可能不同。然而,底线是任何ISA都应该是完整的,因为它应该能够用机器代码表达用户打算为其编写的所有程序。

-

简明。指令集的有限大小,最好不要有太多的指示。实现一条指令需要相当多的硬件,执行大量指令将不必要地增加处理器中晶体管的数量并增加其复杂性。因此,大多数指令集都有64到1000条指令。例如,MIPS指令集包含64条指令,而截至2012年,Intel x86指令集大约有1000条指令。请注意,对于ISA中的指令数量,1000条被认为是相当大的数字。

-

通用。指令应捕获通用案例,程序中的大多数常见指令都是简单的算术指令,如加法、减法、乘法、除法。最常见的逻辑指令是逻辑和、或、异或、和非。因此,为这些常见操作中的每一个指定一条指令是有意义的。

很少使用的计算的指令不是一个好主意。例如,实现计算sin−1(x)sin−1(x)的指令可能没有意义,可以提供使用现有的数学技术(如泰勒级数展开)实现的专用库函数来计算sin−1(x)sin−1(x)。由于大多数程序很少使用此函数,因此如果此函数执行时间相对较长,它们不会受到不利影响。

-

简单。指令应该尽量简单。假设有很多添加数字序列的程序,为了设计专门针对此类程序定制的处理器,我们有几个关于add指令的选项。我们可以实现一条将两个数字相加的指令,也可以实现一个可以获取操作数列表并生成列表和的指令。这里的复杂性显然存在差异,不能说哪种实现更快。前一种方法要求编译器生成更多指令,但是,每个添加操作都执行得很快。后一种方法生成的指令数量更少,但是,每条指令执行的时间更长。前一种类型的ISA称为精简指令集(Reduced Instruction Set),后一种ISA称为复杂指令集(Complex Instruction Set)。

精简指令集计算机(reduced instruction set computer,RISC)实现具有简单规则结构的简单指令,指令的数量通常很小(64到128)。示例:ARM、IBM PowerPC、HP PA-RISC。

复杂指令集计算机(complex instruction set computer,CISC)实现高度不规则的复杂指令,采用多个操作数,并实现复杂功能。其次,指令的数量很大(通常为500+)。示例:Intel x86、VAX。

直到90年代末,RISC与CISC的争论一直是一个非常有争议的问题。然而,从那时起,设计师、程序员和处理器供应商一直倾向于RISC设计风格,共识似乎是采用少量相对简单的、具有规则结构和格式的指令。值得注意的是,这一点仍有争议,因为CISC指令有时更适合某些类型的应用。现代处理器通常使用混合方法,其中既有简单的指令,也有一些复杂的指令。然而,在底层,CISC指令被转译成RISC指令。因此,我们认为行业稍微偏向RISC指令,认为有简单的指示是一种可取的特性。

ISA需要完整、简洁、通用和简单,且必须完整,而其余属性是可取的(但附有争议)。

19.4.4 图灵机和指令完整性

如何验证ISA的完整性?这是一个非常有趣、困难且理论上深刻的问题。确定给定ISA对于给定程序集是否完整的问题是一个相当困难的问题,一般情况要有趣得多。我们需要回答这个问题:给定ISA,它能代表所有可能的程序吗?

假设有一个ISA,其中包含基本的加法和乘法指令,我们能用这个ISA运行所有可能的程序吗?答案是否定的,因为我们不能用现有的基本指令减去两个数字。如果我们将减法指令添加到指令库中,我们可以计算一个数的平方根吗?即使我们可以,是否可以保证我们可以进行所有类型的计算?要回答这些令人烦恼的问题,我们需要首先设计一台通用机器。

通用机器(universal machine)是可以执行任何程序的机器。

它是一台可以执行所有程序的机器,可以把这台机器的每一个基本动作都当作一条指令。通用机器的一组动作就是它的ISA,而这个ISA是完整的。当说ISA是完整的时,相当于说可以专门基于给定的ISA构建通用机器,可以通过解决通用机器的设计问题来解决ISA的完整性问题。它们是双重问题,就通用机器而言,推理更容易。

20世纪初,计算机科学家开始思考通用机器的设计,他们想知道什么是可计算的,什么不是,以及不同类别机器的能力。其次,能够计算所有可能程序结果的理论机器的形式是什么?计算机科学的这些基本结果构成了当今现代计算机体系结构的基础。

阿兰·图灵(Alan Turing)是第一个提出一种极其简单和强大的通用机器的人,这台机器恰如其分地以他的名字命名,被称为图灵机器(Turing machine)。这只是一个理论实体,通常用作数学推理工具,可以创建图灵机的硬件实现,然而极为困难,并且需要不成比例的资源。尽管如此,图灵机构成了当今计算机的基础,而现代ISA是从图灵机的基本动作中派生出来的。因此,非常有必要研究它的设计。

下图显示了图灵机的一般结构,它包含一个内部磁带,磁带是一个单元阵列,每个单元格可以包含有限字母表中的符号,有一个特殊符号$用作特殊标记,一个专用的磁带头指向磁带中的一个单元。在一组状态中,有一小块存储器可以保存当前状态,该存储元件称为状态寄存器。

图灵机的操作非常简单。在每一步中,磁带头从状态寄存器中读取当前单元中的符号及其当前状态,并查找一个表,该表包含每个符号和状态组合的操作集,这个专用表称为转换函数表或动作表。这个表中的每个条目都说明了三件事——是否将磁带头向左或向右移动一步、下一个状态及应写入当前单元格的符号。因此,在每一步中,磁带头都可以覆盖单元格的值,改变状态寄存器中的状态,并移动到新单元格。唯一的限制是新单元格必须位于当前单元格的最左边或最右边。形式上,它的格式为:

(state, symbol)→({L,R}, new_state, new_symbol)(state, symbol)→({L,R}, new_state, new_symbol)

其中LL代表左边,RR代表右边。

示例:设计一个图灵机来判断字符串的形式是否为aaa...abb...bb。答案:让我们定义两个状态(Sa,Sb)(Sa,Sb)和两个特殊状态——exit和error。如果状态等于退出或错误,则计算停止。图灵机可以开始从右向左扫描输入,开始于状态(Sb)(Sb)。动作表如下:

(Sb,b)→(L,Sb,b)(Sb,a)→(L,Sa,a)(Sb,$)→(L, error ,$)(Sa,b)→(L, error ,b)(Sa,a)→(L,Sa,a)(Sa,$)→(L, exit,$)(Sb,b)→(L,Sb,b)(Sb,a)→(L,Sa,a)(Sb,$)→(L, error ,$)(Sa,b)→(L, error ,b)(Sa,a)→(L,Sa,a)(Sa,$)→(L, exit,$)

以上只是图灵机的简单应用案例,但实际场景中,复杂程度远远不止于此。我们可以立即得出结论,为即使是简单的问题设计图灵机也是不可能的。因为动作表会包含很多状态,并且很快就会超出大小,但基线是可以用这个简单的设备解决复杂的问题。事实上,这台机器可以解决各种问题,如天气建模、金融计算和微分方程的求解!

Church-Turing论文捕捉到了这一观察结果,该论文说,任何物理计算设备都可以计算的所有函数都可以由图灵机计算。用外行的话说,任何可以在人类已知的任何计算机上用确定性算法计算的程序,也可以用图灵机计算。

这篇论文在过去的半个世纪里一直坚定不移。到目前为止,研究人员还无法找到比图灵机器更强大的机器,意味着没有程序可以由图灵机之外的另一种机器计算。有一些程序可能需要很长时间才能在图灵机上进行计算,但它们也会占用所有其他计算机上的无限时间。我们可以用所有可能的方式扩展图灵机,可以考虑多个磁带、多个磁带头或每个磁带中的多个磁道。可以看出,这些机器中的每一个都像一个简单的图灵机一样强大。

上面描述的图灵机不是通用机器,因为它包含一个动作表,该动作表特定于机器正在计算的函数。一个真正的通用机器将具有相同的动作表、符号以及每个功能的相同状态集。如果我们能设计一个能模拟另一个图灵机的图灵机,我们就能制造一个通用图灵机——通用且不会特定于正在计算的函数。

让被模拟的图灵机被称为M,通用图灵机则被称为U。让我们首先为M的动作表创建一个通用格式,并将其保存在U磁带上的指定位置,每个动作都需要5个参数——旧状态、旧符号、方向(左或右)、新状态、新符号。我们可以使用一组常见的基本符号,可以是10位十进制数字(0-9),如果一个函数需要更多的符号,那么我们可以考虑将一个符号包含在一组由特殊分隔符划分的连续单元中。让这样的符号称为模拟符号。同样,模拟动作表中的状态也可以编码为十进制数。对于方向,我们可以使用0表示左侧,1表示右侧。因此,单个动作表条目可能看起来像(@1334@34@0@1335@10@),其中“@”是分隔符,该条目表示,如果遇到符号34,我们将从状态1334移动到1335。我们向左移动(0),并写一个值10。因此,我们找到了一种对用于计算某个函数的图灵机的动作表、符号集和状态进行编码的方法。

类似地,我们可以指定磁带的一个区域来包含M的状态寄存器,称之为模拟状态寄存器。让M的磁带在U的磁带中有一个专用的空间,我们把这个空间称为工作区(work area)。这种组织如下图所示。

通用图灵机的布局。

磁带因此分为三部分,第一部分包含模拟动作表,第二部分包含模拟状态寄存器,最后一部分包含包含一组模拟符号的工作区。通用图灵机(U)有一个非常简单的动作表和一组状态,其思想是在模拟动作表中查找与模拟状态寄存器中的值和磁带头下的模拟符号相匹配的正确条目。然后,通用图灵机需要通过移动到新的模拟状态来执行相应的动作,并在需要时覆盖工作区中的模拟符号。为了做每一个基本动作,U需要做几十次磁带头运动。然而,结论是我们可以构造一个通用的图灵机。

可以构造一个通用的图灵机,它可以模拟任何其他的图灵机器。

自20世纪50年代以来,研究人员设计了更多类型的具有自己的状态和规则集的假想机器,这些机器中的每一台都已被证明至多与图灵机一样强大。所有机器和计算系统都有一个通用名称,它们都像图灵机一样具有表达力和功能。这种系统可以说是图灵完整的(Turing complete)。因此,任何通用机器和ISA都是图灵完整的。

任何等同于图灵机的计算系统都被称为图灵机。

因此,如果ISA是图灵完整的,我们需要证明ISA是完整的或通用的。

现在考虑一个更适合实际实现的通用图灵机的变体(下图),让它具有以下特性。请注意,这样的机器已经被证明是图灵完整的。

一种改进的通用图灵机

1、磁带为半无限(semi-infinite,仅在一个方向上延伸至无限)。

2、模拟状态是指向模拟动作表中的条目的指针。

3、每个状态的模拟动作表中有一个唯一的条目。在查找模拟动作表时,我们不关心磁带头下的符号。

4、一个动作指示磁带头访问工作区中的一组位置,并根据它们的值使用简单的算术函数计算一个新值。它将此新值写入工作区中的新位置。

5、默认的下一个状态是动作表中的后续状态。

6、如果磁带上某个位置的符号小于某个值,动作也可以任意改变状态,意味着模拟磁带头将开始从模拟动作表中的新区域提取动作。

这台图灵机建议采用以下形式的机器组织。有大量指令(动作表),这个指令数组通常被称为程序。有一个状态寄存器,用于维护指向数组中当前指令的指针,称为程序计数器,可以更改程序计数器以指向新指令。有一个大的工作区,可以存储、检索和修改符号,此工作区也称为数据区。指令表(程序)和工作区(数据)保存在我们改进的图灵机的磁带上。在实际的机器中,有限磁带可被看作内存。存储器是一个大的存储单元阵列,其中存储单元包含一个基本符号。内存的一部分包含程序,另一部分包含数据。

此外,每条指令都可以读取内存中的一组位置,计算它们上的一个小算术函数,并将结果写回内存,还可以根据内存中的值跳转到任何其他指令。有一个专用单元来计算这些算术函数,写入内存,并跳转到其他指令,被称为CPU(中央处理单元)。下图显示了该机器的概念组织。

基本指令处理器。

上面我们已经捕获了图灵机的所有方面:状态转换、磁带头的移动、重写符号以及基于磁带头下符号的决策。这种机器与冯·诺依曼机器非常相似,后者构成了当今计算机的基础。

现在,让我们尝试为改进的图灵机设计一个ISA,有可能有一个只包含一条指令的完整ISA,考虑一个与改进的图灵机兼容并且已经被证明是图灵完备的指令。

sbn a, b, c

sbn表示减法,如果为负数则分支,此指令从a中减去b(a和b是存储器位置),将结果保存在a中。如果a<0,则跳转到指令表中位置c处的指令,否则,控制转移到下一条指令。例如,我们可以使用此指令将保存在位置a和b中的两个数字相加。请注意,退出是程序末尾的一个特殊位置。

1: sbn temp, b, 2

2: sbn a, temp, exit

这里假设内存位置temp已经包含值0。第一条指令将−b−b保存在temp中,不管结果的值如何,它都跳到下一条指令。请注意,标识符(数字:)是指令的序列号。在第二条指令中,计算a=a+b=a−(−b)a=a+b=a−(−b)。因此,成功地相加了两个数字,现在可以使用这段基本代码将数字从1加到10。我们假设变量计数器初始化为9,索引初始化为10,一初始化为1,和初始化为0。

1: sbn temp, temp, 2 // temp = 0

2: sbn temp, index, 3 // temp = -1 * index

3: sbn sum, temp, 4 // sum += index

4: sbn index, one, 5 // index -= 1

5: sbn counter, one, exit // loop is finished, exit

6: sbn temp, temp, 7 // temp = 0

7: sbn temp, one, 1 // (0 - 1 < 0), hence goto 1

我们观察到,这个小的操作序列运行for循环。退出条件在第5行,循环返回发生在第7行。在每一次迭代中,它都计算−sum+=index−sum+=index。

有许多类似的单指令ISA已经被证明是完整的,例如,如果小于等于,则进行减法和分支,如果借用(borrow),则进行反向减法和跳过,以及具有通用内存移动操作的计算机。

用一条指令编写一个程序是非常困难的,而且程序往往很长。没有理由吝啬指令的数量,通过考虑大量的指令,可以使复杂程序的实现变得更加轻松。让我们尝试将基本的sbn指令分解为几个指令:

- 算术指令。可以有一组算术指令,如加法、减法、乘法和除法。

- 移动指令。可以有移动指令,在不同的内存位置移动值,允许将常量值加载到内存位置。

- 分支指令。需要根据计算结果或存储在内存中的值来改变程序计数器以指向新指令的分支指令。

记住这些基本原则,我们可以设计许多不同类型的完整ISA。需要注意的是,我们只需要三种类型的指令:算术(数据处理)、移动(数据传输)和分支(控制)。

在任何指令集中,至少需要三种类型的指令:

1、需要算术指令来执行加法、减法、乘法和除法等运算。大多数指令集也有这类专门的指令来执行逻辑运算,如逻辑OR和NOT。

2、需要数据传输指令,可以在内存位置之间传输值,并可以将常量加载到内存位置。

3、需要能够根据指令操作数的值在程序中的不同点开始执行指令的分支指令。

寄存器机(register machine)是指包含无限数量的命名存储位置,这些存储位置称为寄存器。寄存器可以随机访问,所有指令都使用寄存器名作为操作数。CPU访问寄存器,获取操作数,然后处理它们。还存在混合机器,它们可以增加存储空间带有寄存器的标准Von Neumann机器。寄存器是可以保存符号的存储位置。

存储器通常是非常大的结构,在现代处理器中,整个内存可以包含数十亿个存储位置,这种大小的内存的任何实际实现在实践中都相当缓慢。硬件中有一个一般的经验法则,大则慢,小则快。因此,为了实现快速操作,每个处理器都有一组可以快速访问的寄存器,寄存器的数量通常在8到64之间。算术和分支操作中的大多数操作数都存在于这些寄存器中,由于程序倾向于在任何时间点重复使用一小组变量,因此使用寄存器可以节省许多内存访问。然而,有时需要将内存位置引入寄存器或将寄存器中的值写回内存位置。在这些情况下,我们使用专用的加载和存储指令,在内存和寄存器之间传输值。大多数程序都有大多数纯寄存器指令,加载和存储指令的数量通常约为已执行指令总数的三分之一。

假设我们要将数字的3次方加到存储位置b和c中,并将结果保存在存储位置a中。带有寄存器的机器需要以下指令,假设r1、r2和r3是寄存器的名称,没有使用任何特定的(通用的、概念性的)ISA。

1: r1 = mem[b] // load b

2: r2 = mem[c] // load c

3: r3 = r1 * r1 // compute b^2

4: r4 = r1 * r3 // compute b^3

5: r5 = r2 * r2 // compute c^2

6: r6 = r2 * r5 // compute c^3

7: r7 = r4 + r6 // compute b^3 + c^3

4: mem[a] = r7 // save the result

mem是表示内存的数组,需要首先将值加载到寄存器中,然后执行算术计算,然后将结果保存回内存。上面的代码通过使用寄存器来节省内存访问,如果增加计算的复杂性,将节省更多的内存访问,因此,使用寄存器的执行速度会更快。最终的处理器组织如下图所示。

很明显,安排计算在堆栈上工作是不可取的,将有许多冗余负载和存储。尽管如此,对于打算计算长数学表达式的机器,以及程序大小是一个问题的机器,通常会选择堆栈。很少有基于堆栈的机器的实际实现,如Burroughs Large Systems、UCSD Pascal和HP 3000(经典)。Java语言在编译过程中假设一台基于堆栈的机器,由于基于堆栈的机器很简单,Java程序实际上可以在任何硬件平台上运行。当我们运行编译后的Java程序时,Java虚拟机(JVM)会动态地将Java程序转换为另一个可以在带有寄存器的机器上运行的程序。

基于累加器的机器使用一个寄存器,称为累加器(accumulator)。每条指令都将单个内存位置作为输入操作数,例如,加法运算将累加器中的值与存储器地址中的值相加,然后将结果存储回累加器。早期无法容纳寄存器的机器曾经有累加器,累加器能够减少内存访问的次数并加速程序。

累加器的某些方面已经渗透到英特尔x86处理器组中,这些处理器是2012年台式机和笔记本电脑最常用的处理器。对于大数的乘法和除法,这些处理器使用寄存器eax作为累加器。对于其他通用指令,任何寄存器都可以指定为累加器。

19.4.5 常见ISA

目前市面上流行的指令集包含ARM指令集和x86指令集。ARM是高级RISC机器(Advanced RISC Machines),是一家总部位于英国剑桥的标志性公司,截至2012年,包括苹果iPhone和iPad在内的大约90%的移动设备都运行在基于ARM的处理器上。同样,截至2012年超过90%的台式机和笔记本电脑运行在基于Intel或AMD的x86处理器上。ARM是RISC指令集,x86是CISC指令集。

还有许多其他为各种处理器量身定制的指令集,移动计算机的另一个流行指令集是MIPS指令集,基于MIPS的处理器也用于汽车和工业电子中的各种处理器。

对于大型服务器,通常使用IBM(PowerPC)、Sun(如今的Oracle,UltraSparc)或HP(PA-RISC)处理器。每个处理器系列都有自己的指令集,这些指令集通常是RISC指令集,大多数ISA共享简单的指令,如加法、减法、乘法、移位和加载/存储指令。除了这个简单的集合,他们使用了大量更专业的指令。在ISA中选择正确的指令集取决于处理器的目标市场、工作负载的性质以及许多设计时间限制,下表显示了流行的指令集列表。

| ISA | 类型 | 年份 | 厂商 | 位数 | 字节顺序 | 寄存器数 |

|---|---|---|---|---|---|---|

| VAX | CISC | 1977 | DEC | 32 | little | 16 |

| SPARC | RISC | 1986 | Sun | 32 | bi | 32 |

| SPARC | RISC | 1993 | Sun | 64 | bi | 32 |

| PowerPC | RISC | 1992 | Apple, IBM, Motorola | 32 | bi | 32 |

| PowerPC | RISC | 2002 | Apple, IBM | 64 | bi | 32 |

| PA-RISC | RISC | 1986 | HP | 32 | big | 32 |

| PA-RISC | RISC | 1996 | HP | 64 | big | 32 |

| m68000 | CISC | 1979 | Motorola | 16 | big | 16 |

| m68000 | CISC | 1979 | Motorola | 32 | big | 16 |

| MIPS | RISC | 1981 | MIPS | 32 | bi | 32 |

| MIPS | RISC | 1999 | MIPS | 64 | bi | 32 |

| Alpha | RISC | 1992 | DEC | 64 | bi | 32 |

| x86 | CISC | 1978 | Intel, AMD | 16 | little | 8 |

| x86 | CISC | 1985 | Intel, AMD | 32 | little | 8 |

| x86 | CISC | 2003 | Intel, AMD | 64 | 64 little | 16 |

| ARM | RISC | 1985 | ARM | 32 | bi (little default) | 16 |

| ARM | RISC | 2011 | ARM | 64 | bi (little default) | 31 |

19.4.6 指令实现机制

有一小组基本逻辑组件,可以以各种方式组合起来存储二进制数据,并对该数据执行算术和逻辑运算。如果要执行特定的计算,则可以构造专门为该计算设计的逻辑组件的配置。我们可以将以所需配置连接各种组件的过程视为编程的一种形式。生成的“程序”是硬件形式的,称为硬连线程序(hardwired program)。

现在考虑这个替代方案。假设我们构造了算术和逻辑函数的通用配置,这组硬件将根据施加到硬件的控制信号对数据执行各种功能。在定制硬件的原始情况下,系统接受数据并产生结果(下图a)。使用通用硬件,系统接受数据和控制信号并产生结果,因此程序员只需要提供一组新的控制信号,而不是为每个新程序重新布线硬件。

硬件和软件方法。

如何提供控制信号?答案很简单,但很微妙。整个程序实际上是一系列步骤,在每个步骤中,对一些数据执行一些算术或逻辑运算。对于每个步骤,都需要一组新的控制信号。让我们为每一组可能的控制信号提供一个唯一的代码,并在通用硬件中添加一个可以接受代码并生成控制信号的段(上图b)。

编程现在更容易了。我们需要做的是提供一个新的代码序列,而不是为每个新程序重新布线硬件。实际上,每个代码都是一条指令,部分硬件解释每个指令并生成控制信号。为了区分这种新的编程方法,一系列代码或指令被称为软件。

19.4.6.1 存储指令

让我们考虑加载指令:ld r1, 12[r2],此处将内存地址计算为r2和数字12的内容之和。ld指令访问此内存地址,获取存储的整数并将其存储在r1中。假设计算的内存地址指向整数的第一个存储字节(即小端表示),所以内存地址包含LSB。详情如下图(a)所示。存储操作则相反,将r1的值存储到存储器地址(r2+12)中,如下图(b)所示。

19.4.6.2 函数

回顾一下实现一个简单函数的基本要求。假设地址为A的指令调用函数foo,在执行函数foo之后,需要立即返回A处指令之后的指令,该指令的地址为A+4(如果我们假设A处的指令长度为4字节)。这个过程被称为从函数返回,地址(a+4)被称为返回地址。

返回地址(Return address)是进程在执行函数后需要分支到的指令的地址。

因此,实现函数有两个基本方面:1、调用或调用函数的过程;2、涉及从函数返回。

函数本质上是一块汇编代码,调用一个函数本质上是让PC指向这段代码的开头。我们可以将标签与每个函数相关联,标签应该与函数中的第一条指令相关联,调用函数就像分支到函数开头的标签一样简单。然而,这只是故事的一部分,我们还需要实现返回功能。因此,我们不能使用无条件分支指令来实现函数调用。

因此,让我们提出一个专用的函数调用指令,它分支到函数的开头,同时保存函数需要返回的地址(称为返回地址)。让我们考虑下面的C代码,并假设每个C语句对应于一行汇编代码。

a = foo(); /* Line 1 */

c = a + b; /* Line 2 */

在这个小代码片段中,我们使用函数调用指令来调用foo函数,返回地址是第2行中指令的地址。调用指令必须将返回地址保存在专用存储位置,以便以后可以检索。大多数RISC指令集都有一个专用寄存器,称为返回地址寄存器(不妨称为ra),用于保存返回地址,返回地址寄存器由函数调用指令自动填充。当我们需要从函数返回时,我们需要分支返回地址寄存器中包含的地址。

如果foo调用另一个函数会发生什么?在这种情况下,ra中的值将被覆盖。我们稍后将讨论这个问题。现在让我们考虑将参数传递给函数并返回返回值的问题。

假设函数foo调用函数foobar。foo被称为调用者(caller),foobar被称为被调用者(callee)。请注意,调用方与被调用方的关系是不固定的。foo可以调用foobar,foobar也可以在同一个程序中调用foo。根据哪个函数调用另一个函数来决定单个函数调用的调用者和被调用者。

调用者和被调用者都看到相同的寄存器视图。因此,我们可以通过寄存器传递参数,同样也可以通过寄存器来传递返回值。然而,正如我们在下面列举的,在这个简单的想法中有几个问题(假设我们有16个寄存器)。

1、一个函数可以接受16个以上的参数,比我们现有的通用寄存器数量还要多,因此需要添加额外的空间来保存参数。

2、函数可以返回大量数据,例如C中的大型结构。这段数据可能不可能在寄存器中存储。

3、被调用者可能会覆盖调用者将来可能需要的寄存器。

因此,我们观察到,通过寄存器传递参数和返回值只适用于简单的情况,不是一个非常灵活和通用的解决方案。尽管如此,我们的讨论提出了两个要求:

- 空间问题。我们需要额外的空间来发送和返回更多的参数。

- 覆盖问题。我们需要确保被调用方不会覆盖调用方的寄存器。

为了解决这两个问题,需要更深入地了解函数是如何工作的。可以将函数foo想象成一个黑匣子,它接受一系列参数并返回一组值。要执行它的工作,foo可以花费一纳秒、一周甚至一年的时间。foo可以调用其他函数来完成它的工作、将数据发送到I/O设备以及访问内存位置。下图是函数foo的可视化。

总而言之,通用函数处理参数,根据需要从内存和I/O设备读取和写入值,然后返回结果。关于内存和I/O设备,目前我们并不特别关心,有大量可用内存,空间不是主要限制,读写I/O设备通常也与空间限制无关。主要问题是寄存器,因为它们供不应求。

让我们先解决空间问题,可以通过寄存器和内存传输值。为了简单起见,如果我们需要传输少量数据,我们可以使用寄存器,否则我们可以通过内存传输它们。类似地,对于返回值,我们可以通过内存传输值。如果我们使用内存传输数据,那么我们不受空间限制。然而,这种方法缺乏灵活性,因为调用者和被调用者之间必须就要使用的内存位置达成严格的协议。请注意,我们不能使用一组固定的内存位置,因为被调用方可以递归调用自己。

void foobar()

{

...

foobar();

...

}

精明的读者可能会认为,被调用方可以从内存中读取参数并将其转移到内存中的其他临时区域,然后调用其他函数。然而,这种方法既不优雅,也不十分有效。稍后将研究更优雅的解决方案。

因此可以得出结论,我们已经部分解决了空间问题。如果需要在调用者和被调用者之间传输一些值,或者反之亦然,可以使用寄存器。但是,如果参数/返回值不在可用寄存器集中,那么需要通过内存传输它们。对于通过内存传输数据,我们需要一个优雅的解决方案,它不需要调用者和被调用者之间就用于传输数据的内存位置达成严格的协议。

将寄存器保存在内存中并随后恢复的概念称为寄存器溢出(register spilling)。

要解决覆盖问题,有两种解决方案:1、调用者可以将所需的寄存器集保存在内存中的专用位置,可以在被调用方完成后检索其寄存器集,并将控制权返回给调用方。2、让被调用方保存和恢复它需要的寄存器。这两种方法都如下图所示。这种将寄存器值保存在内存中,然后再检索的方法称为溢出。

调用方保存和被调用方保存的寄存器。

我们又遇到了同样的问题,即调用者和被调用者都需要就需要使用的内存位置达成严格的协议。现在让我们一起努力解决这两个问题。

我们简化了向函数传递参数和从函数传递参数,以及使用内存中的专用位置保存/恢复寄存器的过程。然而,该解决方案被发现是灵活的,对于大型现实世界程序来说,实现起来可能相当复杂。为了简化这个想法,让我们在函数调用中定义一个模式。

典型的C或Java程序从主函数开始。然后,该函数调用其他函数,这些函数可能反过来调用其他函数。最后,当主函数退出时,执行终止。每个函数定义一组局部变量,并对这些变量和函数参数执行计算,它还可以调用其他函数。最后,函数返回一个值,很少返回一组值(C中的结构)。请注意,函数终止后,不再需要局部变量和参数。因此,如果其中一些变量或参数保存在内存中,我们需要回收空间。其次,如果函数溢出了寄存器,那么这些内存位置也需要在它退出后释放。最后,如果被调用方调用另一个函数,则需要将返回地址寄存器的值保存在内存中,还需要在函数退出后释放此位置。

最好将所有这些信息连续保存在一个内存区域中,被称为函数的激活块(activation block),下图显示了激活块的内存映射。

激活块包含参数、返回地址、寄存器溢出区(对于调用方保存和被调用方保存的方案)和局部变量。一旦函数终止,就可以完全摆脱激活块。一个函数如果想要返回一些值,那么可以使用寄存器这样做,但是它如果想要返回一个大的结构,那么就可以将其写入调用方的激活块中,调用方可以在其激活块中提供一个可以写入该数据的位置。后面有可能更优雅地做到这一点,在解释如何做到这一点之前,需要了解如何在内存中安排激活块。

我们可以有一个存储区域,其中所有的激活块都存储在相邻的区域中。考虑一个例子,假设函数foo调用函数foobar,foobar又调用foobarbar。下图显示了4个内存状态:(a)在调用foobar之前,(b)在调用foobarbar之前,(c)在调用foobarbar之后,(d)在foobarar返回之后。

在这个内存区域中有一个后进先出的行为,最后调用的函数是要完成的第一个函数,这种后进先出的结构传统上被称为计算机科学中的堆栈(stack),因此专用于保存激活块的存储区域称为堆栈。传统上,堆栈被认为是向下增长的(向更小的内存地址增长),意味着主功能的激活块从非常高的位置开始,新的激活块被添加到现有激活块的正下方(朝向较低的地址)。堆栈的顶部实际上是堆栈中最小的地址,而堆栈的底部是最大的地址。堆栈的顶部表示当前正在执行的函数的激活块,堆栈的底部表示初始主函数。

堆栈(stack)是保存程序中所有激活块的内存区域,一般情况是向下增长的。在调用函数之前,我们需要将其激活块推送到堆栈中,当函数完成执行时,需要将其激活块弹出到堆栈中。

堆栈指针寄存器(stack pointer register)保存指向堆栈顶部的指针。

大多数架构将指向堆栈顶部的指针保存在一个称为堆栈指针的专用寄存器中,常被称为sp。请注意,对于许多架构,堆栈是纯软件结构。对于他们来说,硬件不知道堆栈。但对于某些架构(如x86),硬件知道堆栈并使用它来推送返回地址或其他寄存器的值。即使在这种情况下,硬件也不知道每个激活块的内容,结构由程序集程序员或编译器决定。在所有情况下,编译器都需要显式添加汇编指令来管理堆栈。

为被调用方创建新的激活块涉及以下步骤。

1、将堆栈指针减小激活块的大小。

2、复制参数的值。

3、如果需要,通过写入相应的内存位置来初始化任何局部变量。

4、如果需要,溢出任何寄存器(存储到激活块)。

从函数返回时,必须销毁激活块,可以通过将激活块的大小添加到堆栈指针来完成。

通过使用堆栈,我们解决了所有问题。调用方和被调用方不能覆盖彼此的局部变量,局部变量保存在激活块中,两个激活块不重叠。除了变量之外,还可以通过在激活块中显式插入保存寄存器的指令来阻止被调用方重写调用方的寄存器。实现这一点有两种方法:调用者保存的方案和被调用方保存的方案。其次,无需就将用于传递参数的内存区域达成明确协议,堆栈可以用于此目的,调用者可以简单地将参数推送到堆栈上,这些参数将被推送到被调用方的激活块中,被调用方可以轻松使用它们。同样,当从函数,被调用方可以通过堆栈传递返回值,需要先通过减少堆栈指针来销毁其激活块,然后才能将返回值推送到堆栈上。调用方将知道被调用方的语义,因此在被调用方返回后,可以假定其激活块已被被调用方有效地放大,返回值占用了额外的空间。

ARM使用B/BL/BX/BLX等语句调用函数和返回函数,而x86使用call等指令调用函数,此外,x86和ARM都可使用ret指令返回地址。下面是ARM的函数调用示例代码:

.globl main

.extern abs

.extern printf

.text

output_str:

.ascii "The answer is %d\n\0"

@ returns abs(z)+x+y

@ r0 = x, r1 = y, r2 = z

.align 4

do_something:

push {r4, lr}

add r4, r0, r1

mov r0, r2

bl abs ; 调用abs

add r0, r4, r0

pop {r4, pc}

main:

push {ip, lr}

mov r0, #1

mov r1, #3

mov r2, #-4

bl do_something ; 调用do_something

mov r1, r0

ldr r0, =output_str

bl printf

mov r0, #0

pop {ip, pc}

有趣的指令是pushpop和bl,只需获取提供的寄存器列表并将其推到堆栈上,或者将其弹出并放入提供的寄存器中。bl只不过是带链接的分支,分支后的下一条指令的地址被加载到链接寄存器lr中。

一旦我们正在调用的例程被执行,lr就可以被复制回pc,将使CPU能够在bl指令之后从代码中继续。在do_someting中,我们将链接寄存器推送到堆栈,这样就可以再次将其弹出返回,即使对abs的调用将覆盖链接寄存器的原始内容。程序存储r4,因为Arm过程调用标准规定在函数调用之间必须保留r4-r11(下图),并且被调用的函数负责该保留,意味着do_someting需要将r0+r1的结果保存在一个不会被abs破坏的寄存器中,并且我们还必须保存用于保存该结果的任何寄存器的内容。当然,在这种特殊情况下,我们可以只使用r3,但是需要考虑的。我们推送并弹出寄存器,尽管我们不必保留它,因为过程调用标准要求堆栈64位对齐。这在使用堆栈操作时提供了性能优势,因为它们可以利用CPU内的64位数据路径。

我们可以直接压入高地址的值,毕竟如果abs需要注册,那么这就是它保存值的方式。推送r4而不是我们知道需要的值有一个小的性能问题,但最有力的论点可能是,在函数的开始和结束时只推送/弹出所需的任何寄存器,就可以减少错误发生的可能性,提高代码的可读性。此外,“main”函数还压入和弹出lr的内容,因为虽然主代码可能是我的代码中要执行的第一件事,但它不是加载程序时要执行的第二件事。编译器将在调用main之前插入对一些基本设置函数的调用,并在退出时进行一些最终清理调用。

现在让我们尝试将每条指令编码为32位值。假设有0、1、2和3地址格式的指令,其次,有些指令采用即时值,因此需要将32位划分为多个字段。假设有21条指令,则需要5位来编码指令类型,常规指令中的每个指令的代码如下表所示。我们可以使用32位字段中最重要的位来指定指令类型,指令的代码也称为操作码(opcode)。

| 指令 | 二进制码 |

|---|---|

| add | 00000 |

| sub | 00001 |

| mul | 00010 |

| div | 00011 |

| mod | 00100 |

| cmp | 00101 |

| and | 00110 |

| or | 00111 |

| not | 01000 |

| mov | 01001 |

| lsl | 01010 |

| lsr | 01011 |

| asr | 01100 |

| nop | 01101 |

| ld | 01110 |

| st | 01111 |

| beq | 10000 |

| bgt | 10001 |

| b | 10010 |

| call | 10011 |

| ret | 10100 |

现在,让我们尝试从0地址指令开始对每种类型的指令进行编码。

我们拥有的两条0地址指令是ret和nop。操作码由五个最重要的位指定,在这种情况下,ret等于10100,b等于10010(参见上表)。它们的编码如下图所示,我们只需要在MSB位置指定5位操作码,其余27位不需要。

编码ret指令。

我们拥有的1地址指令是call、b、beq和bgt,它们将标签作为参数。在编码指令时,我们需要指定标签的地址作为参数,标签的地址与它所指向的指令的地址相同。如果标签后的行为空,那么我们需要考虑下一条包含指令的汇编语句。

这四条指令的操作码需要5位,剩余的27位可用于地址。请注意,内存地址是32位长,不能用27位覆盖地址空间,但可以进行两个关键的优化。首先,可以假设PC相对寻址,可以假设27位指定了相对于当前PC的偏移量(正负)。现代程序中的分支语句是因为for/while循环或if语句而生成的,对于这些构造,分支目标通常在几百条指令的范围内。如果有27位来指定偏移量,并且假设它是2的补码,那么任何方向(正或负)的最大偏移量都是226,对于几乎所有的程序来说已足够。

还有另一个重要的观察。一条指令需要4个字节。如果假设所有指令都与4字节边界对齐,那么指令的所有起始内存地址都将是4的倍数,因此地址的至少两个有符号二进制数字将是00,没有理由在试图指定它们时浪费比特,可以假设27位指定包含指令的内存字(以4字节内存字为单位)地址的偏移量。通过这种优化,从PC的字节偏移量变为29位,即使是最大的程序,这个数字也应该足够。以防万一有极端的例子,其中分支目标距离超过228个字节,那么汇编程序需要将分支链接起来,这样一个分支将调用另一个分支,以此类推。这些指令的编码如下图所示。

1地址指令的编码(分支格式)。

请注意,1地址指令格式禁止使用0地址格式中未使用的位,可以将ret指令的0地址格式视为1地址格式的特例,1地址格式称为分支格式。以这种格式命名字段,将格式的操作码部分称为op,将偏移量称为offset。操作字段包含位置28-32的位,偏移字段包含位置1-27的位。

接下来考虑3地址指令:add、sub、mul、div、mod和或、lsl、lsr和asr。

考虑一个通用的3地址指令,它有一个目标寄存器、一个输入源寄存器和一个可以是寄存器或立即数的第二个源操作数。如果第二个源操作数是寄存器或立即数,需要将一位输入和输出。将其称为I位,并在指令中的操作码之后指定它。如果I=1,则第二个源操作数是立即数,如果I=0,则第二个源操作数是寄存器。

现在考虑将第二个源操作数作为寄存器(I=0)的3地址寄存器的情况。因为有16个寄存器,所以需要4位来唯一地指定每个寄存器。寄存器ri可以编码为i的无符号4位二进制等价物。因此,要指定目标寄存器和两个输入源寄存器,需要12位。结构如下图所示,此指令格式称为寄存器格式。像分支格式一样,不妨命名不同的字段:op(操作码,位:28-32)、I(立即数,位:27)、rd(目的寄存器,位:23-26)、rs1(源寄存器1,位:19-22)和rs2(源寄存器2,位:15-18)。

假设第二个源操作数是立即数,那么需要将I设置为1,接下来计算指定立即数所剩的位数。现在已经为操作码投入了5位,为I位投入了1位,为目标寄存器投入了4位,为第一个源寄存器投入了四位,总共花费了14位。因此,在32位中,剩下18位,可以使用它们来指定立即数。

建议将18位分为两部分:2位(修改器)+16位(立即数的常数部分),两个修改位可以取三个值:00(默认值)、01(“u”)和10(“h”)。当使用默认修改器时,剩余的16位用于指定16位2的补码数。对于u和h修改器,假设立即字段中的16位常量是无符号数。假设立即字段为18位长,具有修改部分和常量部分,处理器根据修改器将立即数内部扩展为32位值。

此编码如下图所示,可将此指令格式称为立即数格式。像分支格式一样,不妨命名不同的字段:op(操作码,位:28-32)、I(立即数,位:27)、rd(目标寄存器,位:23-26)、rs1(源寄存器1,位:19-22)和imm(立即数:1-18)。

用类似的方式,可以用下图所示的方式编码cmp、not和mov指令:

而加载指令的实现如下图:

19.4.7 ARM指令编码

ARM有四种类型的指令:数据处理(加/减/乘/比较)、加载/存储、分支和其他,需要2位来表示这些信息,这些位决定了指令的类型。下图显示了ARM中指令的通用格式。

对于数据处理指令,类型字段等于00,其余26位需要包含指令类型、特殊条件和寄存器。下图显示了数据处理指令的格式。

第26位称为I(立即数)位,类似于前面所述的I位。如果将其设置为1,则第二个操作数是立即数,否则是寄存器。由于ARM有16条数据处理指令,需要4位来表示它们,该信息保存在第22-25位。第21位保存S位,如果打开,则指令将设置CPSR。

其余20位保存输入和输出操作数。由于ARM有16个寄存器,需要4位来编码一个寄存器。第17-20位保存第一个输入操作数(rs)的标识符,要求是一个寄存器。第13-16位保存目标寄存器(rd)的标识符。

位1-12用于保存立即数或移位器操作数,下面看看如何最好地利用这12位。

ARM支持32位立即数,然而实际上只有12位来编码它们。不可能对所有232232个可能的值进行编码,需要从中选择一个有意义的子集,想法是使用12位对32位值的子集进行编码,硬件预计将解码这12位,并在处理指令时将其扩展到32位。

现在,12位是一个相当不灵活的值,既不是1字节,也不是2字节。有必要想出一个非常巧妙的解决方案,想法是将12位分为两部分:4位常量(rot)和8位有效载荷(payload),参见下图。

假设12位中编码的实际数字为n,有:

n=payload ror (2⋅rot)n=payload ror (2⋅rot)

其中ror是右旋操作。通过将有效载荷右旋2倍于rot字段中的值,获得实际数字n。现在试着理解这样做的逻辑。

数字n是32位值。一个天真的解决方案是使用12位来指定n的最小符号位,高阶位可以是0。然而,程序员倾向于以字节为单位访问数据和内存,因此1.5个字节对我们毫无用处。更好的解决方案是使用1字节的有效载荷,并将其放置在32位字段中的任何位置,其余4位用于此目的,它们可以对0到15之间的数字进行编码。ARM处理器将该值加倍,以考虑0到30之间的所有偶数,将有效载荷向右旋转该量。这样做的好处是可以对更广泛的数字集进行编码,对于所有这些数字,有8位对应于有效载荷,其余24位均为零。rot位仅确定32位字段中的哪8位被有效载荷占用。

同样地,通过合理地思考,可以得到以下的位移指令格式图:

此外,加载、存储指令格式如下:

而分支指令如下:

ARM Endian支持使用E-Bit加载/存储字:

19.4.8 x86指令编码

x86是真正的CISC指令集,其编码过程更为规律,几乎所有的指令都遵循标准格式。其次,x86中的操作码通常有多种模式和前缀。先看看编码机器指令的广泛结构,下图显示了二进制编码指令的结构。

x86二进制指令格式。

x86指令格式细节。

第一组1-4字节用于编码指令的前缀,rep前缀就是其中一个例子,还有许多其他类型的前缀可以在第一组1-4字节中编码。

接下来的1-3个字节用于对操作码进行编码,整个x86 ISA有数百条指令,操作码还编码操作数的格式。例如,加法指令可以将其第一个操作数作为内存操作数,也可以将其第二个操作数用作内存操作数。此信息也是操作码的一部分。

接下来的两个字节是可选的。第一个字节被称为ModR/M字节,用于指定源寄存器和目标寄存器的地址,第二个字节被称作SIB(标度索引基)字节,该字节记录基本缩放索引和基本缩放索引偏移寻址模式的参数,存储器地址可以可选地具有32位的位移(在本书中也称为偏移量)。因此,我们可以选择在一条指令中多4个字节来记录位移值。最后,一些x86指令接受立即数作为操作数,立即数也可以大到32位,因此,最后一个字段(也是可选的)用于指定立即数操作数。

ModR/M字节有三个字段,如下图所示:

SIB字节的结构如下图所示:

x86数字数据格式如下:

x86 EFLAGS寄存器:

x86控制寄存器:

MMX寄存器到浮点寄存器的映射:

19.5 处理器

19.5.1 指令处理概览

我们可以将处理器的操作大致分为五个阶段,如下图所示。

指令处理的五个阶段:指令获取、操作数获取、执行、内存访问、寄存器写入。

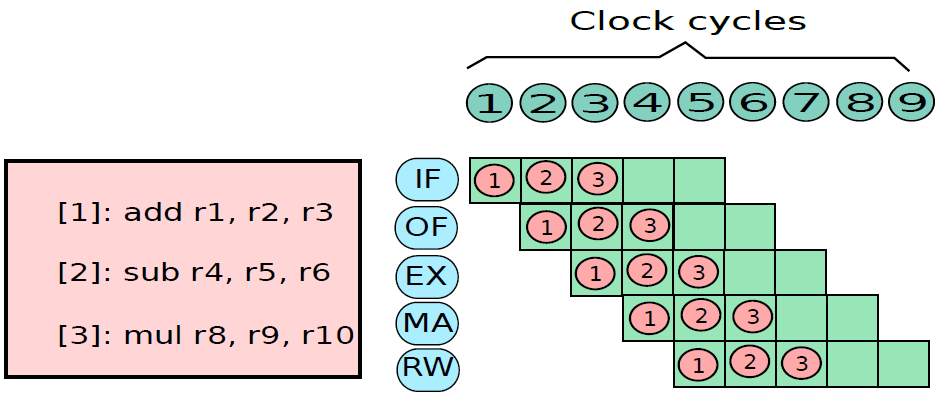

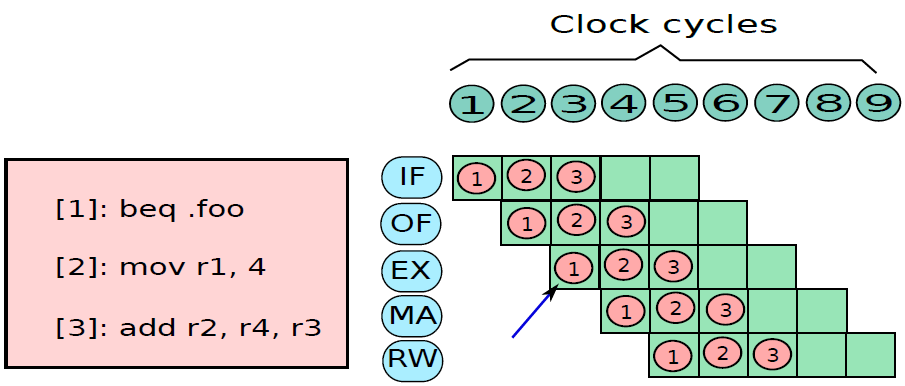

指令的多时钟周期管线图。图中时间从左到右在页面上前进,指令从页面的顶部到底部前进。管线阶段的表示沿指令轴放置在每个部分,占据适当的时钟周期。图中显示了每个阶段之间的管线寄存器,数据路径以图形方式表示管线的五个阶段,但命名每个管线阶段的矩形也同样有效。

第1步是从内存中获取指令。机器的底层组织并不重要,该机器可以是冯·诺依曼机器(共享指令和数据存储器),也可以是哈佛机器(专用指令存储器)。提取阶段有逻辑元件来计算下一条指令的地址,如果当前指令不是分支,那么需要将当前指令的大小(4字节)添加到存储在PC中的地址。但如果当前指令是分支,那么下一条指令的地址取决于分支的结果和目标。此信息从处理器中的其他单元获得。

第2步是解码“指令并从寄存器中取出操作数。不同指令类型所需的处理非常不同,例如加载存储指令使用专用的存储单元,而算术指令则不使用。为了解码指令,处理器有专用的逻辑电路,根据指令中的字段生成信号,这些信号随后被其他模块用来正确处理指令。像Intel处理器这样的商用处理器有非常复杂的解码单元,解码x86指令集非常复杂。不管解码的复杂程度如何,解码过程通常包括以下步骤:

- 提取操作数的值,计算嵌入的立即数并将其扩展到32或64位,以及生成关于指令处理的附加信息。

- 生成关于指令的更多信息的过程包括生成处理器专用信号。例如,可以为加载/存储指令生成“启用内存单元”形式的信号,对于存储指令,可以生成一个禁用寄存器写入功能的信号。

第3步是执行算术和逻辑运算。它包含一个能够执行所有算术和逻辑运算的算术和逻辑单元(ALU),ALU还需要计算加载存储操作的有效地址,通常情况下处理器的这一部分也计算分支的结果。

ALU(算术逻辑单元)包含用于对数据值执行算术和逻辑计算的元素,通常包含加法器、乘法器、除法器,并具有计算逻辑位运算的单元。

第4步包含用于处理加载存储指令的存储单元。该单元与存储器系统接口,并协调从存储器加载和存储值的过程。典型处理器中的内存系统相当复杂,其中一些复杂性是在处理器的这一部分中实现的。

第5步是将ALU计算的值或从存储器单元获得的加载值写入寄存器文件。

单个指令所需的处理称为指令周期。使用前面给出的简化的两步描述,指令周期如下图所示,这两个步骤被称为获取周期和执行周期。只有在机器关闭、发生某种不可恢复的错误或遇到使计算机停止的程序指令时,程序执行才会停止。

基本指令周期。

考虑一个使用假设机器的简单示例,该机器包括下图中列出的特性。处理器包含一个称为累加器(AC)的数据寄存器,指令和数据都是16位长,因此使用16位字组织内存是方便的。指令格式为操作码提供4位,因此可以有多达24=1624=16个不同的操作码,并且可以直接寻址多达212=4096212=4096(4K)个字的内存。

假想机器的特性。

下图说明了部分程序执行,显示了内存和处理器寄存器的相关部分。所示的程序片段将地址940处的存储字的内容添加到地址941处的内存字的内容,并将结果存储在后一位置。需要三条指令,可以描述为三个获取和三个执行周期:

1、PC包含300,即第一条指令的地址。该指令(十六进制值1940)被加载到指令寄存器IR中,PC递增。注意,此过程涉及使用内存地址寄存器和内存缓冲寄存器。为了简单起见,这些中间寄存器被忽略。

2、IR中的前4位(第一个十六进制数字)表示要加载AC,剩余的12位(三个十六进制数字)指定要加载数据的地址(940)。

3、从位置301获取下一条指令(5941),并且PC递增。

4、添加AC的旧内容和位置941的内容,并将结果存储在AC中。

5、从位置302取出下一条指令(2941),并且PC递增。

6、AC的内容存储在位置941中。

程序执行示例(内存和寄存器的内容为十六进制)。

特定指令的执行周期可能涉及对内存的不止一次引用。此外,指令可以指定I/O操作,而不是内存引用。考虑到这些额外的考虑因素,图下图提供了基本指令周期的更详细的视图,该图采用状态图的形式。对于任何给定的指令周期,某些状态可能为空,而其他状态可能被访问多次。

指令周期状态图。

状态描述如下:

- 指令地址计算(iac):确定要执行的下一条指令的地址,通常需要在前一条指令的地址上添加一个固定的数字,例如如果每条指令的长度为16位,并且内存被组织为16位字,则在前一个地址上加1。相反,如果内存被组织为可单独寻址的8位字节,则在前一个地址上加2。

- 指令获取(if):将指令从其内存位置读入处理器。

- 指令操作解码(iod):分析指令以确定要执行的操作类型和要使用的操作数。

- 操作数地址计算(oac):如果操作涉及对内存中的操作数的引用或通过I/O可用的操作数,则确定操作数的地址。

- 操作数获取(of):从内存中获取操作数或从I/O中读取操作数。

- 数据操作(do):执行指令中指示的操作。

- 操作数存储(os):将结果写入内存或输出到I/O。

下图显示了包括中断周期处理的修订指令周期状态图:

下图左是非直接时钟周期,右是中断时钟周期:

下图通过指出每种模块类型的主要输入和输出形式,说明了所需的交换类型:

微处理器寄存器组织示例:

19.5.2 处理器结构

19.5.2.1 处理器单元

处理器内部包含了诸多单元,诸如获取单元、数据路径和控制单元、操作数获取单元、执行单元(分支单元、ALU)、内存访问单元、寄存器回写单元等等。

下图显示了获取单元电路的实现。在一个周期中需要执行两个基本操作:1、下一个PC(程序计数器)的计算;2、获取指令。

电路中有两种元件:

- 第一类元件是寄存器、存储器、算术和逻辑电路,用于处理数据值。

- 第二类元素是决定数据流方向的控制单元。处理器中的控制单元通常生成信号以控制所有多路复用器(multiplexer),被称为控制信号(control signal),因为其作用是控制信息流。

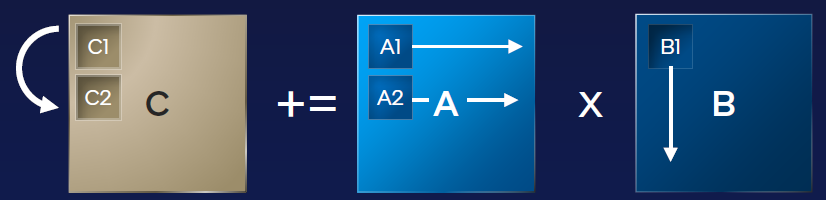

因此,我们可以从概念上认为处理器由两个不同的子系统组成:

- 数据路径(data path)。它包含存储和处理信息的所有元素。例如,数据存储器、指令存储器、寄存器文件和ALU(算术逻辑单元)是数据路径的一部分。内存和寄存器存储信息,而ALU处理信息,例如,它将两个数字相加,并产生和作为结果,或者它可以计算两个数字的逻辑函数。

- 控制路径(control path)。它通过生成信号来引导信息的正确流动,生成一个信号,指示多路复用器在分支目标和默认下一个PC之间进行选择。在这种情况下,多路复用器由信号

isBranchTaken控制。

我们可以将控制路径和数据路径视为电路的两个不同元件,就像城市的交通网络一样。道路和红绿灯类似于数据路径,控制交通灯的电路构成了控制路径,控制路径决定灯光转换的时间。在现代智慧城市中,控制城市中所有交通灯的过程通常是集成的。如果有可能智能控制交通,使汽车绕过交通堵塞和事故现场。类似地,处理器的控制单元相当智能,它的工作是尽可能快地执行指令。现代处理器的控制单元已经非常复杂。

数据路径(data path):数据路径由处理器中专用于存储、检索和处理数据的所有元素组成,如寄存器、内存和ALU。

控制路径(control path):控制路径主要包含控制单元,其作用是生成适当的信号来控制数据路径中指令和数据的移动。

数据路径和控制路径之间的关系。

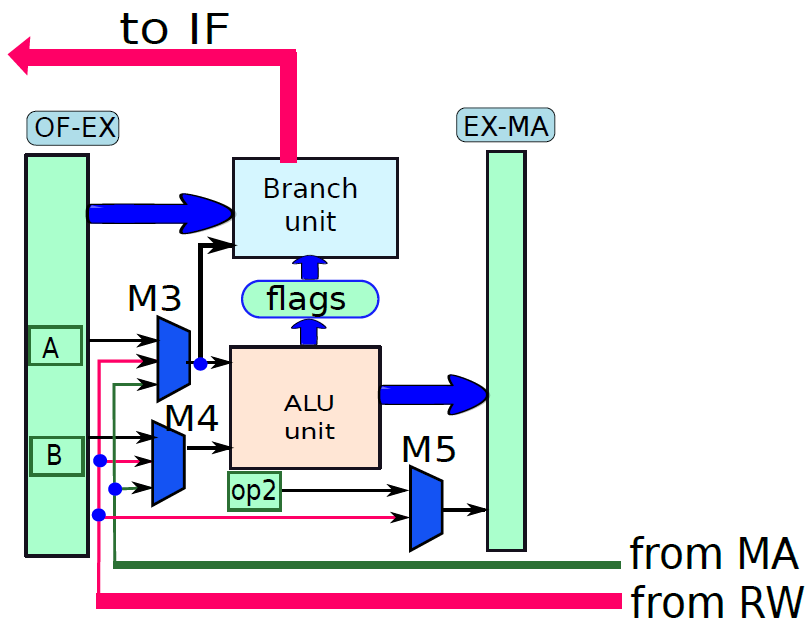

现在看看执行指令。首先将指令分为两种类型:分支和非分支。分支指令由计算分支结果和最终目标的专用分支单元处理,非分支指令由ALU(算术逻辑单元)处理。分支单元的电路如下图所示:

使用多路复用器在返回地址(op1)的值和指令中嵌入的branchT目标之间进行选择。isRet信号控制多路复用器,如果它等于1就选择op1,否则选择分支目标。多路复用器branchPC的输出被发送到提取单元。

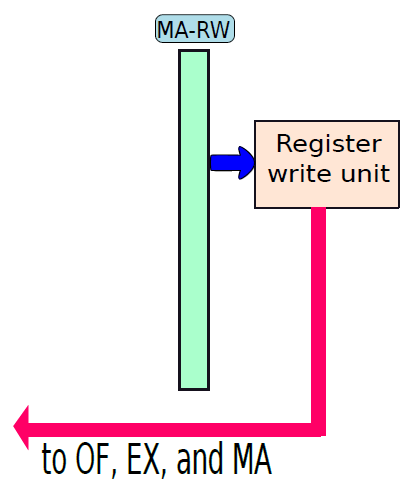

下图显示了包含ALU的执行单元部分。ALU的第一个操作数(A)始终为op1(从操作数获取单元获得),但第二个操作数(B)可以是寄存器或符号扩展立即数,由控制单元生成的isImmediate信号决定,isImmediate信号等于指令中立即数位的值,如果是1,则图中的多路复用器选择immx作为操作数,如果为0,则选择op2作为操作数。ALU将一组信号作为输入,统称为aluSignals,aluSignals由控制单元生成,并指定ALU操作的类型。ALU的结果称为aluResult。

下图显示了ALU的一种设计。ALU包含一组模块,每个模块计算单独的算术或逻辑函数,如加法或除法。其次,每个模块都有一个启用或禁用它的专用信号,例如,当我们想执行简单的加法时,没有理由启用除法器。有几种方法可以启用或禁用单元,最简单的方法是为每个输入位使用一个传输门(transmission gate,见下下图),如果信号(S)打开,则输出反映输入值。否则,它将保持其以前的值。因此,如果启用信号关闭,则模块不会看到新的输入。因此,它不会耗散功率,并被有效禁用。

ALU。

传输门。

总之,下图展示了执行单元(分支单元和ALU)的完整设计。要设置输出(aluResult),需要一个多路复用器,可以从ALU中的所有模块中选择正确的输出,没有在图中显示此多路复用器。

执行单元(分支和ALU单元)。

下图显示了内存访问单元。它有两个输入{数据和地址,地址由ALU计算,它等于ALU的结果(aluResult),加载和存储指令都使用这个地址,地址保存在传统上称为MAR(内存地址寄存器)的寄存器中。

内存单元。

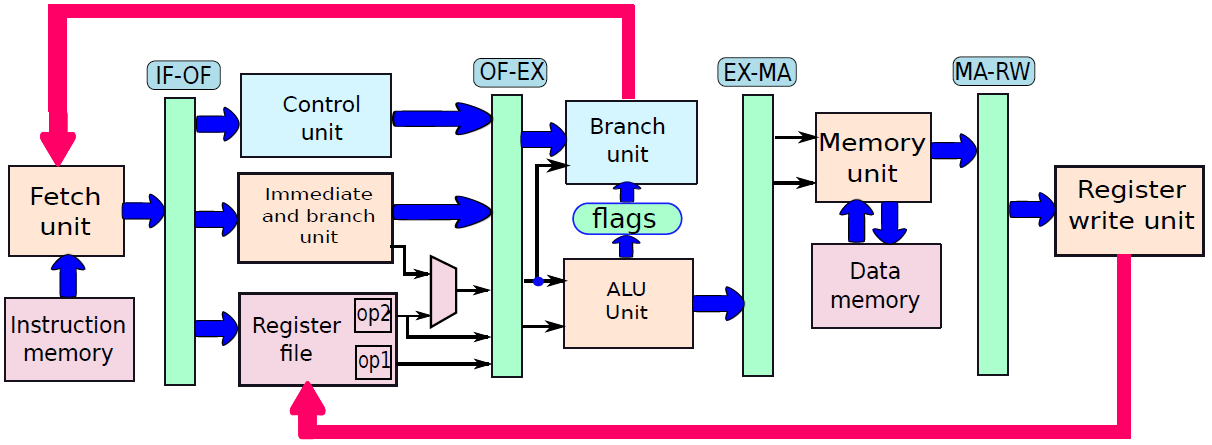

通过连接所有部分来形成整体。到目前为止,已经将处理器分为五个基本单元:指令获取单元(IF)、操作数获取单元(OF)、执行单元(EX)、内存访问单元(MA)和寄存器写回单元(RW)。是时候把所有的部分结合起来,看看统一的图片了(下图,省略了详细的电路,只关注数据和控制信号的流动)。

一个基础处理器。

19.5.2.2 控制单元

一个简单处理器的硬接线控制单元可以被认为是一个黑盒子,它以6位作为输入(5个操作码位和1个立即数位),并产生22个控制信号作为输出。如下图所示。

硬接线控制单元的抽象。

控制单元的结构图。

硬接线控制单元快速高效,这就是今天大多数商用处理器使用硬接线控制单元的原因,但硬接线控制单元并不十分灵活,例如在处理器出厂后,不可能更改指令的行为,甚至不可能引入新指令。有时如果功能单元中存在错误,需要更改指令的执行方式,例如如果乘法器存在设计缺陷,那么理论上可以使用加法器和移位单元运行布斯乘法算法。然而,我们需要一个非常复杂的控制单元来动态地重新配置指令的执行方式。

支持灵活的控制单元还有其他更实际的原因。某些指令集(如x86)具有重复指令给定次数的rep指令,它们还具有复杂的字符串指令,可以处理大量数据,支持此类指令需要非常复杂的数据路径。原则上,我们可以通过精心设计的控制单元来执行这些指令,而这些控制单元又有简单的处理器来处理这些指令,这些子处理器可以生成用于实现复杂CISC指令的控制信号。

数据路径和控制信号。

带内部总线的CPU。

19.5.2.3 基于微程序的处理器

前面已经研究了带有硬接线控制单元的处理器,设计了一个包含处理和执行指令所需的所有元素的数据路径。在输入操作数之间有选择的地方,添加了一个多路复用器,它由来自控制单元的信号控制。控制单元将指令的内容作为输入,并生成所有控制信号。现代高性能处理器通常采用这种设计风格。请注意,效率是有代价的,成本是灵活性。我们可能需要添加更多的多路复用器,并为每个新指令生成更多的控制信号。其次,在处理器交付给客户后,不可能向处理器添加新指令。有时候,我们渴望这样的灵活性。

通过引入将ISA中的指令转换为一组简单微指令的转换表,可以引入这种额外的灵活性。每个微指令都可以访问处理器的所有锁存器和内部状态元素。通过执行一组与指令关联的微指令,我们可以实现该指令的功能,这些微指令或微代码保存在微代码表中。通常可以通过软件修改该表的内容,从而改变硬件执行指令的方式。有几个原因需要这种灵活性,允许我们添加新指令或修改现有指令的行为。其中一些原因如下:

- 处理器在执行某些指令时有时会出现错误。因为设计师在设计过程中犯下的错误,或者是由于制造缺陷,其中一个著名的例子是英特尔奔腾处理器中的除法错误,英特尔不得不召回它卖给客户的所有奔腾处理器。如果可以动态地更改除法指令的实现,那么就不必调用所有处理器。因此可以得出结论,处理器的某种程度的可重构性有助于解决在设计和制造过程的各个阶段可能引入的缺陷。

- 英特尔奔腾4等处理器,以及英特尔酷睿i3和英特尔酷睿i7等更高版本的处理器,通过执行存储在内存中的一组微指令来实现一些复杂的指令。通常使用微码来实现数据串或指令的复杂操作,这些操作会导致一系列重复计算,意味着英特尔处理器在内部将复杂指令替换为包含简单指令的代码段,使得处理器更容易实现复杂的指令。我们不需要对数据路径进行不必要的更改,添加额外的状态、多路复用器和控制信号来实现复杂的指令。

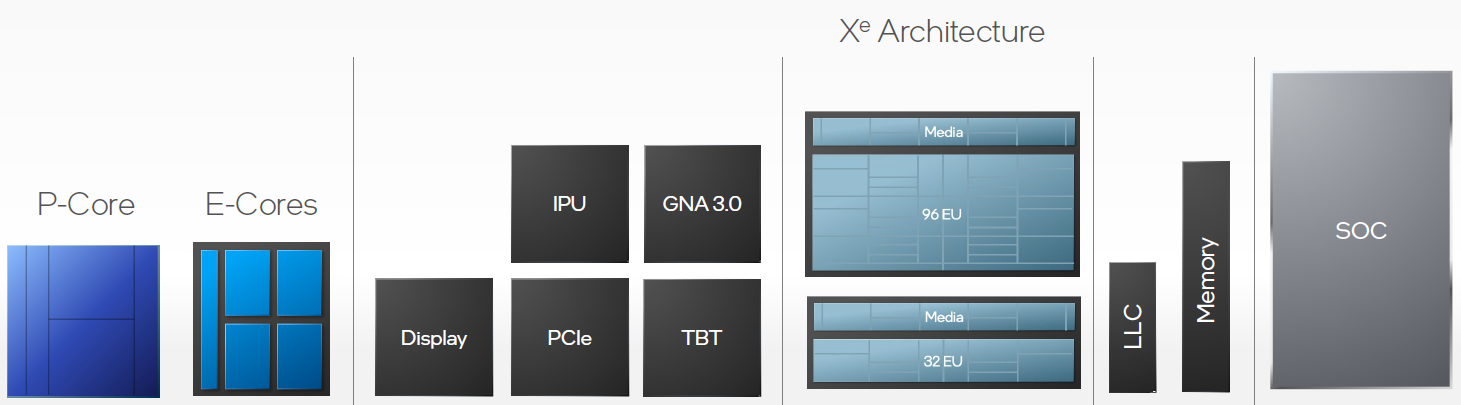

- 当今的处理器只是芯片的一部分,有许多其他元件,被称为片上系统(system-on-chip,SOC)。例如,手机中的芯片可能包含处理器、视频控制器、相机接口、声音和网络控制器。处理器供应商通常会硬连线一组简单的指令,而与视频和音频控制器等外围设备接口的许多其他指令都是用微码编写的。根据应用程序域和外围组件集,可以定制微码。

- 有时使用一组专用微指令编写自定义诊断例程。这些例行程序在芯片运行期间测试芯片的不同部分,报告故障并采取纠正措施。这些内置自检(BIST)例程通常是可定制的,并以微码编写。例如,如果我们希望高可靠性,那么我们可以修改在CPU上执行可靠性检查的指令的行为,以检查所有组件。但是,为了节省时间,可以压缩这些例程以检查更少的组件。

因此,我们观察到,有一些令人信服的理由能够以编程方式改变处理器中指令的行为,以实现可靠性、实现附加功能并提高可移植性。因此,现代计算系统,尤其是手机和平板电脑等小型设备使用的芯片依赖于微码。这种微码序列通常被称为固件。

现代计算系统,尤其是手机、调制解调器、打印机和平板电脑等小型设备,使用的芯片依赖于微码。这种微码序列通常被称为固件(firmware)。

因此,让我们设计一个基于微程序的处理器,即使在处理器被制造并发送给客户之后,它也能为我们提供更大的灵活性来定制指令集。需要注意,常规硬接线处理器和微编程处理器之间存在着基本的权衡。权衡是效率与灵活性,不能指望有一个非常灵活的处理器,它既快速又省电。

19.5.2.4 微编程数据路径

让我们为微程序处理器设计数据路径,修改处理器的数据路径。处理器有一些主要单元,如提取单元、寄存器文件、ALU、分支单元和内存单元。这些单元是用导线连接的,只要有可能有多个源操作数,我们就在数据路径中添加一个多路复用器。控制单元的作用是为多路复用器生成所有控制信号。

问题是多路复用器的连接是硬接线的,不能建立任意连接,例如,不能将存储单元的输出发送到执行单元的输入。因此我们希望有一个组件之间没有固定互连的设计,理论上任何单位都可以向任何其他单位发送数据。

最灵活的互连是基于总线的结构。总线是一组连接所有单元的普通铜线,支持一个写入,在任何时间点支持多个读者。例如,单元A可以在某个时间点写入总线,所有其他单元都可以获得单元A写入的值。如果需要,可以将数据从一个单元发送到另一个单元,或从一个装置发送到一组其他单元。控制单元需要确保在任何时间点,只有一个单元写入总线,需要处理正在写入的值的单元从总线读取值。

现在让我们继续设计我们为硬连线处理器引入的所有单元的简化版本,这些简化版本可以适当地用于我们的微程序处理器的数据路径。

让我们从解释微程序处理器的设计原理开始。我们为每个单元添加寄存器,这些寄存器存储特定单元的输入数据,专用输出寄存器存储单元生成的结果,这两组寄存器都连接到公共总线。与硬连线处理器不同的是,在不同的单元之间存在大量的耦合,微程序处理器中的单元是相互独立的。他们的工作是执行一组操作,并将结果返回总线。每个单元就像编程语言中的一个函数,它有一个由一组寄存器组成的接口,用于读取数据,通常需要1个周期来计算其输出,然后该单元将输出值写入输出寄存器。

根据上述原理,下图中展示了提取单元的设计,它有两个寄存器:pc(程序计数器)和ir(指令寄存器)。pc寄存器可以从总线读取其值,也可以将其值写入总线,没有将ir连接到总线,因为没有其他单位对指令的确切内容感兴趣,其他单位只对指令的不同字段感兴趣。因此,有必要解码指令并将其分解为一组不同的字段,由解码单元完成。

微程序处理器中的提取单元。

解码单元在功能上类似于操作数获取单元,但我们不在该单元中包含寄存器文件,而将其视为微程序处理器中的一个独立单元。下图显示了操作数获取单元的设计。

微程序处理器中的解码单元。

我们将解码单元和寄存器文件组合成一个单元,称为硬连线处理器的操作数获取单元,但更期望在微程序处理器中保持寄存器文件独立,因为在硬连线处理器中,它在解码指令后立即被访问。然而,微程序处理器可能不是这样——在指令执行期间,可能需要多次访问它。

微程序处理器中的寄存器文件。

ALU的结构如下图所示,有两个输入寄存器,A和B。ALU对寄存器A和B中包含的值执行操作,操作的性质由args值指定。例如,如果指定了加法运算,则ALU将寄存器A和B中包含的值相加。如果指定了减法运算,那么将从A中包含的数值减去B中的值,对于cmp指令,ALU更新标志。使用两个标志来指定相等和大于条件,分别保存在寄存器标志flags.E和标志flags.GT中,然后ALU运算的结果保存在寄存器aluResult中。此处还假设ALU在总线上指定args值后需要1个周期才能执行。

微程序处理器中的ALU。

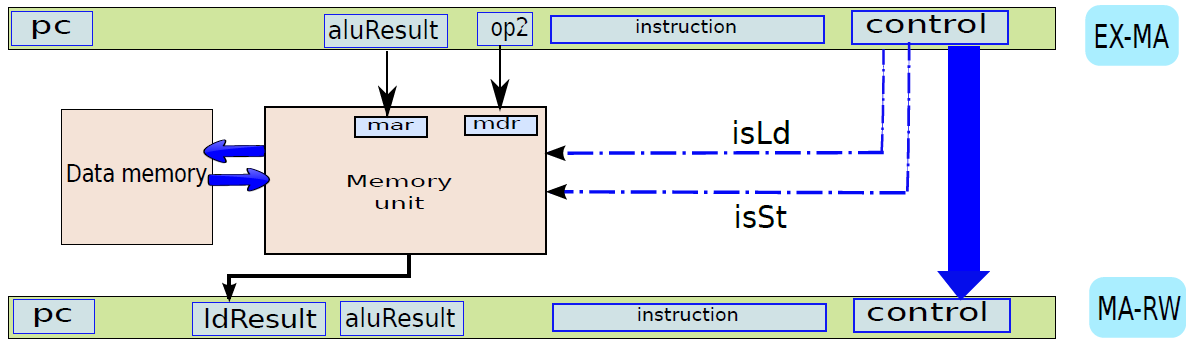

内存单元如下图所示。与硬连线处理器一样,它有两个源寄存器:mar(内存地址寄存器)和mdr(内存数据寄存器),mar缓冲内存地址,mdr缓冲需要存储的值。还需要一组参数来指定内存操作的性质:加载或存储,加载操作完成后,ldResult寄存器中的数据可用。

微程序处理器中的存储单元。

综上,微程序处理器中的数据路径总览如下:

19.5.3 管线处理器

19.5.3.1 管线概述

假设前面介绍的硬连线处理器需要一个周期来获取、执行和将指令的结果写入寄存器文件或内存。在电气层面上,是通过从提取单元经由其他单元流到寄存器写回单元的信号来实现的,而电信号从一个单元传播到另一个单元需要时间。

例如,从指令存储器中获取指令需要一些时间。然后需要时间从寄存器文件读取值,并用ALU计算结果。内存访问和将结果写回寄存器文件也是相当耗时的操作。需要等待所有这些单独的子操作完成,然后才能开始处理下一条指令,意味着电路中有大量的空闲,当操作数获取单元执行其工作时,所有其他单元都处于空闲状态。同样,当ALU处于活动状态时,所有其他单元都处于非活动状态。如果我们假设五个阶段(IF、OF、EX、MA、RW)中的每一个都需要相同的时间,那么在任何时刻,大约80%的电路都是空闲的!这代表了计算能力的浪费,空闲资源绝对不是一个好主意。

如果能找到一种方法让芯片的所有单元保持忙碌,那么就能提高执行指令的速度。

管线流程

不妨类比一下前面讨论的简单单周期处理器中的空闲问题。当一条指令在EX阶段时,下一条指令可以在OF阶段,而后续指令可以在IF阶段。事实上,如果在处理器中有5个阶段,简单地假设每个阶段花费的时间大致相同,可以假设同时处理5条指令,每条指令在处理器的不同单元中进行处理。类似于流水线中的汽车,指令在处理器中从一个阶段移动到另一个阶段。此策略确保处理器中没有任何空闲单元,因为处理器中的所有不同单元在任何时间点都很忙。

在此方案中,指令的生命周期如下。它在周期n中进入IF阶段,在周期n+1中进入OF阶段,周期n+2中进入EX阶段,循环n+3中进入MA阶段,最后在周期n+4中完成RW阶段的执行。这种策略被称为流水线(pipelining,又名管线、管道),实现流水线的处理器被称为流水处理器(pipelined processor)。五个阶段(IF、OF、EX、MA、RW)的顺序在概念上一个接一个地布置,称为流水线(pipeline,类似于汽车装配线)。下图显示了流水线数据路径的组织。

流水线数据路径。

上图中,数据路径分为五个阶段,每个阶段处理一条单独的指令。在下一个周期中,每条指令都会传递到下一个阶段,如图所示。

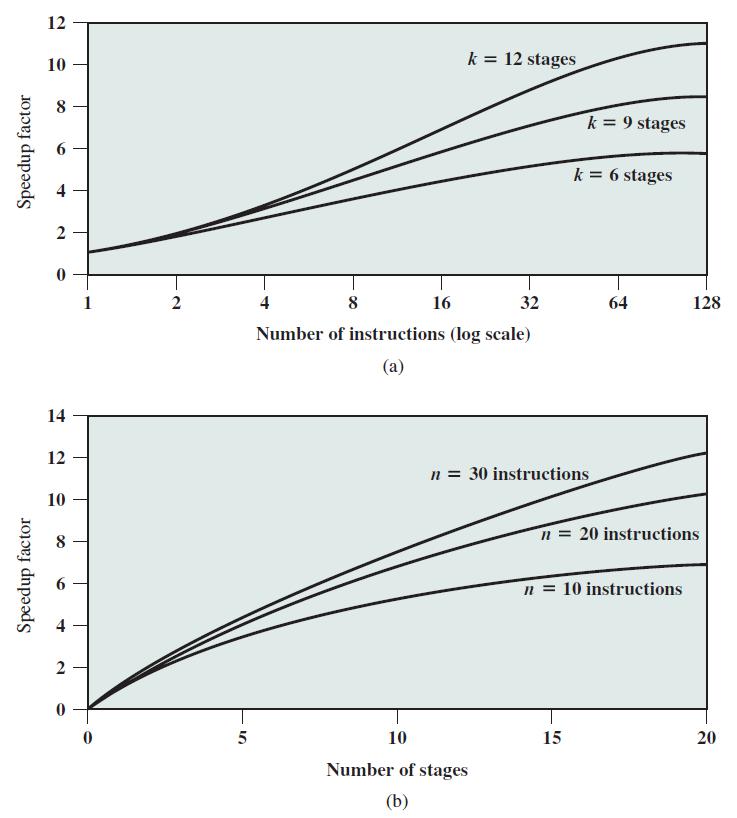

性能优势