一种优化局部搜索能力的灰狼算法

摘要: 灰狼算法是一种经典的群智能算法。针对灰狼算法局部搜索收敛较慢,易陷入局部最优且搜索精度不高的缺陷,提出一种新的灰狼算法。新算法通过增加α狼视野,赋予α狼主动搜索能力,在全局搜索的同时进一步提高了局部寻优精度,实现搜索结果的进一步优化。反向学习策略以避免算法陷入局部最优 .

1.灰狼优化算法

基础灰狼优化算法的具体原理参考,我的博客:https://blog.csdn.net/u011835903/article/details/107716390

2.改进的狼群算法

仔细观察狼群围捕过程可以发现,在围捕的最后阶段狼群围绕猎物不断移动,但代价函数的输出却不再缩小,究其原因是狼群多样性缺失,α狼陷入局部最优,为此,本文提出为α狼增加主动搜索视野,使α狼不再被动局限于狼群更新带来的优化,同时也具备局部搜索的能力。

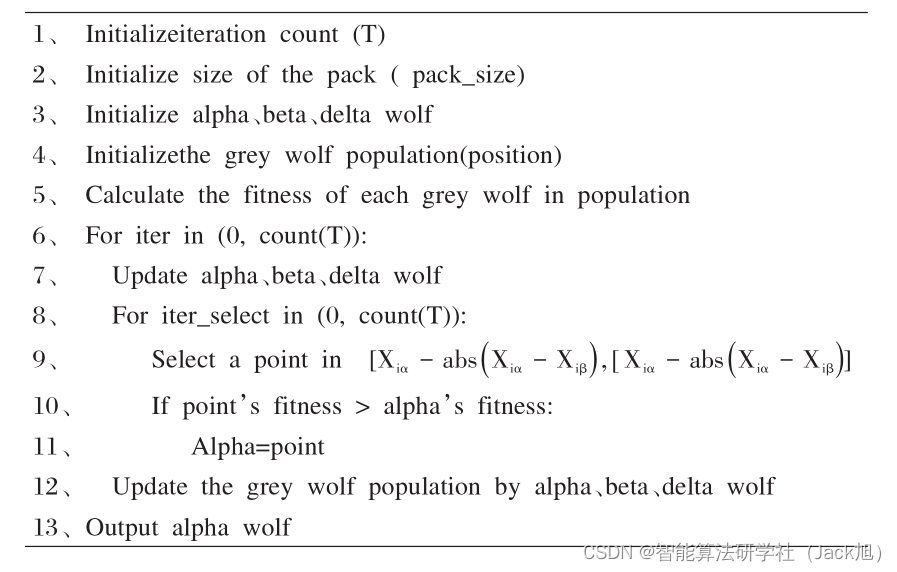

假设α狼具备看到β狼的视野,这样每次α狼、β狼、δ狼更新位置后α狼会在视野范围内寻找比当前更优的位置并移动到更优位置,为了减少参数数量,假设α狼每次视野内局部寻优进行次数与狼群迭代次数相同,即程序会在α狼视野范围内重复生成备选位置,与α狼比较并选取最优解。

X

i备选

=

X

i

α

+

random

(

−

a

b

s

(

X

i

α

−

X

i

β

)

,

a

b

s

(

X

i

α

−

X

i

β

)

)

(12)

X_{\text {i备选 }}=X_{i \alpha}+\operatorname{random}\left(-a b s\left(X_{i \alpha}-X_{i \beta}\right), a b s\left(X_{i \alpha}-X_{i \beta}\right)\right) \tag{12}

Xi备选 =Xiα+random(−abs(Xiα−Xiβ),abs(Xiα−Xiβ))(12)

为了进一步降低算法实现难度,提高程序运行效率,采用式 (12)生成备选位置的第i维数据,因此,α狼在第 i 维空间的视野范围为

[

X

i

α

−

a

b

s

(

X

i

α

−

X

i

β

)

,

X

i

α

+

a

b

s

(

X

i

α

−

X

i

β

)

]

,

i

=

0

,

1

,

.

.

.

,

n

[X_{i\alpha}-abs(X_{i\alpha}-X_{i\beta}),X_{i\alpha}+abs(X_{i\alpha}-X_{i\beta})],i=0,1,...,n

[Xiα−abs(Xiα−Xiβ),Xiα+abs(Xiα−Xiβ)],i=0,1,...,nn为解空间维度。

本文GWO算法伪代码:

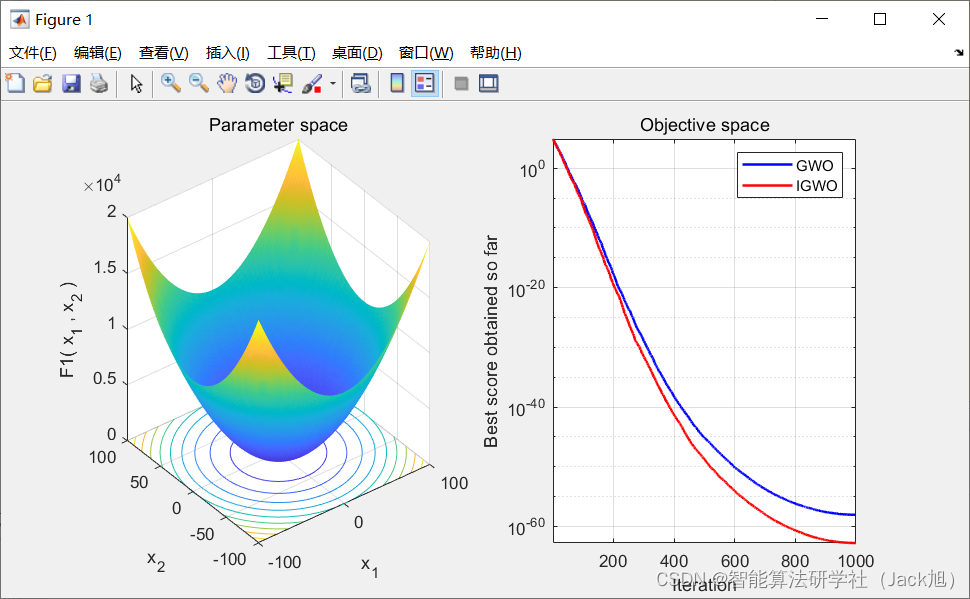

3.实验结果

4.参考文献

[1]王习涛.一种优化局部搜索能力的灰狼算法[J].计算机时代,2020(12):53-55.

1102

1102

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?