爬取的目标网页:http://www.qianlima.com/zb/area_305/

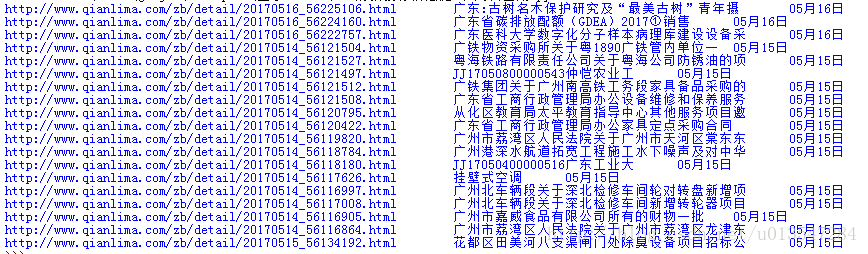

这是一个招投标网站,我们使用python脚本爬取红框中的信息,包括链接网址、链接名称、时间等三项内容。

使用到的Python库:urlib、urlib2、re(正则表达式库)

代码如下:

# -*- coding:utf-8 -*-

import urllib

import urllib2

import re

url = 'http://www.qianlima.com/zb/area_305/'

user_agent = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/45.0.2454.101 Safari/537.36'

headers = { 'User-Agent' : user_agent}

try:

request = urllib2.Request(url,headers = headers)

response = urllib2.urlopen(request)

content = response.read().decode('gbk')

pattern = re.compile(u'<span class="shixian_biao">招标公告</span>(.*?)<span class="shixian_biao">招标预告</span>',re.S)

items = re.findall(pattern,content)

item = items[0]

pattern = re.compile('<dt><a href="(.*?)" target="_blank">(.*?)</a></dt><dd>(.*?)</dd>',re.S)

items = re.findall(pattern,item)

for m in items:

print '%s\t%s\t%s' % (m[0],m[1],m[2])

except urllib2.URLError, e:

if hasattr(e,"code"):

print e.code

if hasattr(e,"reason"):

print e.reason运行结果如下

4243

4243

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?