论文:Squeeze-and-Excitation Networks

论文链接:https://arxiv.org/abs/1709.01507

代码地址:https://github.com/hujie-frank/SENet

PyTorch代码地址:https://github.com/miraclewkf/SENet-PyTorch

Sequeeze-and-Excitation(SE) block并不是一个完整的网络结构,而是一个子结构,可以嵌到其他分类或检测模型中,作者采用SENet block和ResNeXt结合在ILSVRC 2017的分类项目中拿到第一,在ImageNet数据集上将top-5 error降低到2.251%,原先的最好成绩是2.991%。

作者在文中将SENet block插入到现有的多种分类网络中,都取得了不错的效果。SENet的核心思想在于通过网络根据loss去学习特征权重,使得有效的feature map权重大,无效或效果小的feature map权重小的方式训练模型达到更好的结果。当然,SE block嵌在原有的一些分类网络中不可避免地增加了一些参数和计算量,但是在效果面前还是可以接受的。

也许通过给某一层特征配备权重的想法很多人都有,那为什么只有SENet成功了?个人认为主要原因在于权重具体怎么训练得到。就像有些是直接根据feature map的数值分布来判断;有些可能也利用了loss来指导权重的训练,不过全局信息该怎么获取和利用也是因人而异。

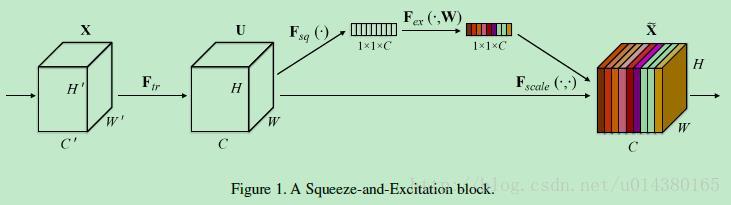

Figure1表示一个SE block。主要包含Squeeze和Excitation两部分,接下来结合公式来讲解Figure1。

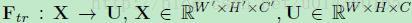

首先Ftr这一步是转换操作(严格讲并不属于SENet,而是属于原网络,可以看后面SENet和Inception及ResNet网络的结合),在文中就是一个标准的卷积操作而已,输入输出的定义如下表示。

那么这个Ftr的公式就是下面的公式1(卷积操作,vc表示第c个卷积核,xs表示第

SENet是一种用于深度学习的卷积神经网络结构,通过引入Squeeze-and-Excitation模块来学习特征的权重,提高模型对特征的选择性。在ImageNet数据集上,SENet显著降低了top-5错误率,且可以灵活地嵌入到其他网络结构中。SE模块由全局平均池化和两个全连接层组成,用于捕捉通道间信息并调整特征图的权重,实现端到端训练。

SENet是一种用于深度学习的卷积神经网络结构,通过引入Squeeze-and-Excitation模块来学习特征的权重,提高模型对特征的选择性。在ImageNet数据集上,SENet显著降低了top-5错误率,且可以灵活地嵌入到其他网络结构中。SE模块由全局平均池化和两个全连接层组成,用于捕捉通道间信息并调整特征图的权重,实现端到端训练。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

10万+

10万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?