文章目录

- 深度学习中的优化算法(Optimization)

- 1. 深度学习中的优化问题

- 2. 基于梯度的优化算法

- 3. 常用的梯度下降算法

- 4. 其他优化算法

-

-

- ⚪ [Averaging Weights Leads to Wider Optima and Better Generalization](https://0809zheng.github.io/2020/11/29/swa.html):随机权重平均 SWA

- ⚪ [Gradientless Descent: High-Dimensional Zeroth-Order Optimization](https://0809zheng.github.io/2022/03/09/gradientless.html):不计算梯度的零阶优化方法

- ⚪ [Gradients without Backpropagation](https://0809zheng.github.io/2022/02/19/fgradient.html):使用前向梯度代替反向传播梯度

- ⚪ [Lookahead](https://0809zheng.github.io/2020/12/14/lookahead.html): 快权重更新k次,慢权重更新1次

- ⚪ [Amos](https://0809zheng.github.io/2022/12/02/amos.html)

-

- ⚪ 参考文献

深度学习中的优化算法(Optimization)

Optimization in Deep Learning.

本文目录:

- 深度学习中的优化问题

- 基于梯度的优化算法

- 常用的梯度下降算法

- 其他优化算法

1. 深度学习中的优化问题

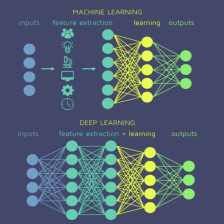

深度学习中的优化(optimization)问题通常是指在已有的数据集上实现最小的训练误差(training error)。记深度网络的待优化参数为 θ \theta θ

本文深入探讨深度学习中的优化问题,重点分析基于梯度的优化算法,包括超参数选择如学习率和批量大小的影响,以及不同的理解角度,如动力系统、逼近理论和概率视角。此外,介绍了常用梯度下降算法的优缺点,并提到了一些新兴的优化技术,如随机权重平均(SWA)、零阶优化和前向梯度下降等,旨在帮助读者更好地理解和应对深度学习的优化挑战。

本文深入探讨深度学习中的优化问题,重点分析基于梯度的优化算法,包括超参数选择如学习率和批量大小的影响,以及不同的理解角度,如动力系统、逼近理论和概率视角。此外,介绍了常用梯度下降算法的优缺点,并提到了一些新兴的优化技术,如随机权重平均(SWA)、零阶优化和前向梯度下降等,旨在帮助读者更好地理解和应对深度学习的优化挑战。

订阅专栏 解锁全文

订阅专栏 解锁全文

853

853

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?