作者:禅与计算机程序设计艺术

1.简介

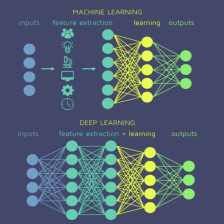

: 机器学习领域涌现了一大批关于深度学习、自然语言处理、计算语言学等方面的研究成果。其中比较知名的一个技术就是BERT(Bidirectional Encoder Representations from Transformers)模型,它的出现极大的促进了自然语言处理的发展。BERT模型是一个预训练好的文本表示模型,通过对海量的数据进行训练得到各种不同长度的文本的embedding表示,并应用在自然语言处理任务中,取得了不错的效果。

本文将介绍BERT模型的整体结构,以及模型的输入输出,目标函数,以及一些其他的关键点。文章将从以下三个方面展开介绍:

- 模型结构:由Encoder和Decoder组成,其中Encoder可以看作是深度双向循环神经网络(RNN),用来提取上下文信息;而Decoder则是一个简单的LSTM网络,用于输出最后的分类结果或序列标注。

- 模型输入输出:BERT模型的输入可以分为两个部分:第一个是token embedding,即词嵌入层,也就是把词转换为一个固定维度的向量;第二个是位置嵌入层,即位置编码层,它根据单词在句子中的位置信息编码成一个向量。

- 模型目标函数:BERT模型的目标函数是一个条件概率分布,即给定输入序列,模型要输出正确的标签序列的概率。这个概率通常可以通过最大似然估计或最小化交叉熵的方式求解。

2.基本概念和术语说明

2.1 BERT模型相关基本概念

2.1.1 模型概述

BERT(Bi

订阅专栏 解锁全文

订阅专栏 解锁全文

2844

2844

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?