如果pip安装很慢,可以试试这个方法

https://github.com/Dao-AILab/flash-attention

pip install ninja

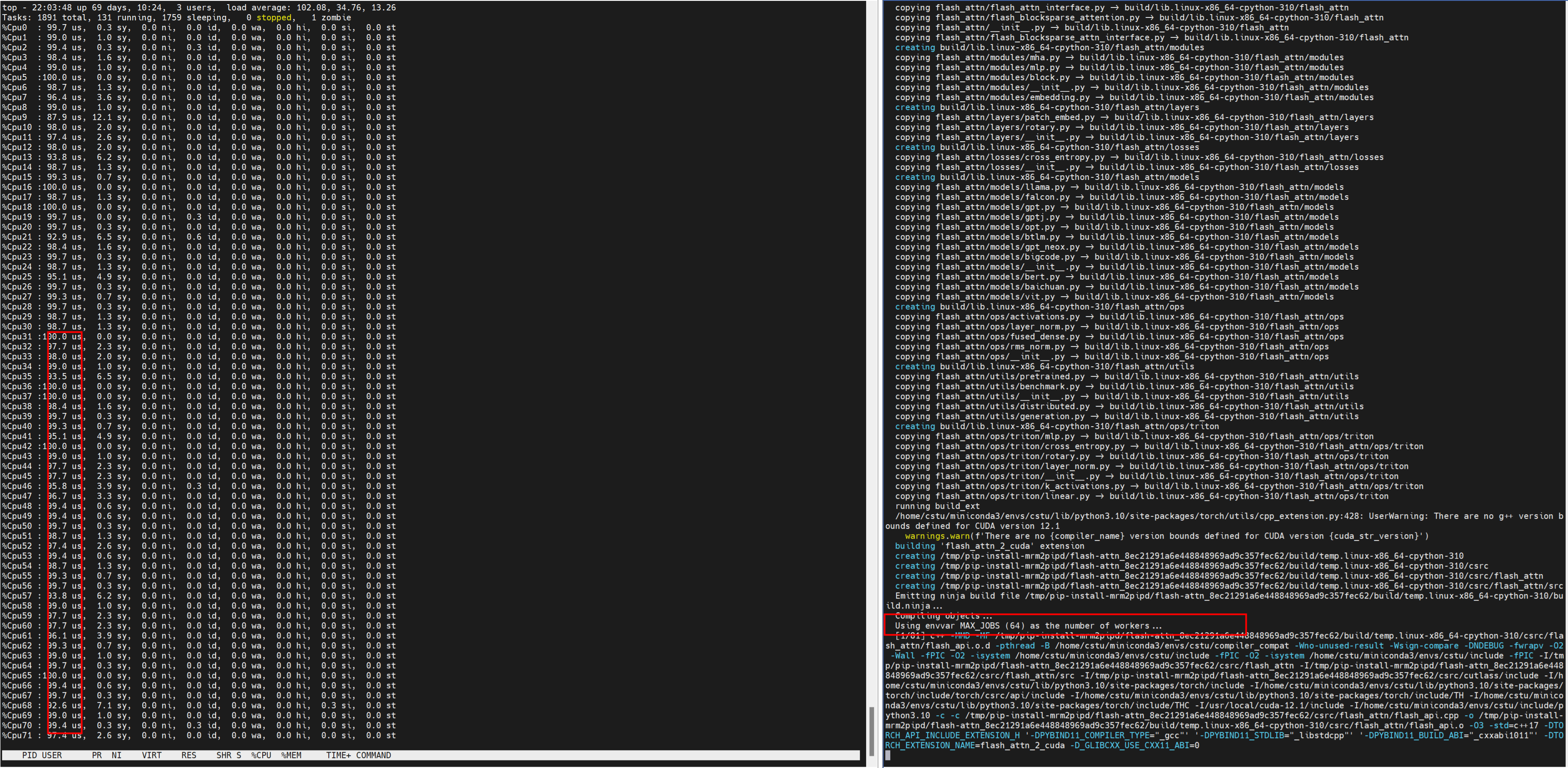

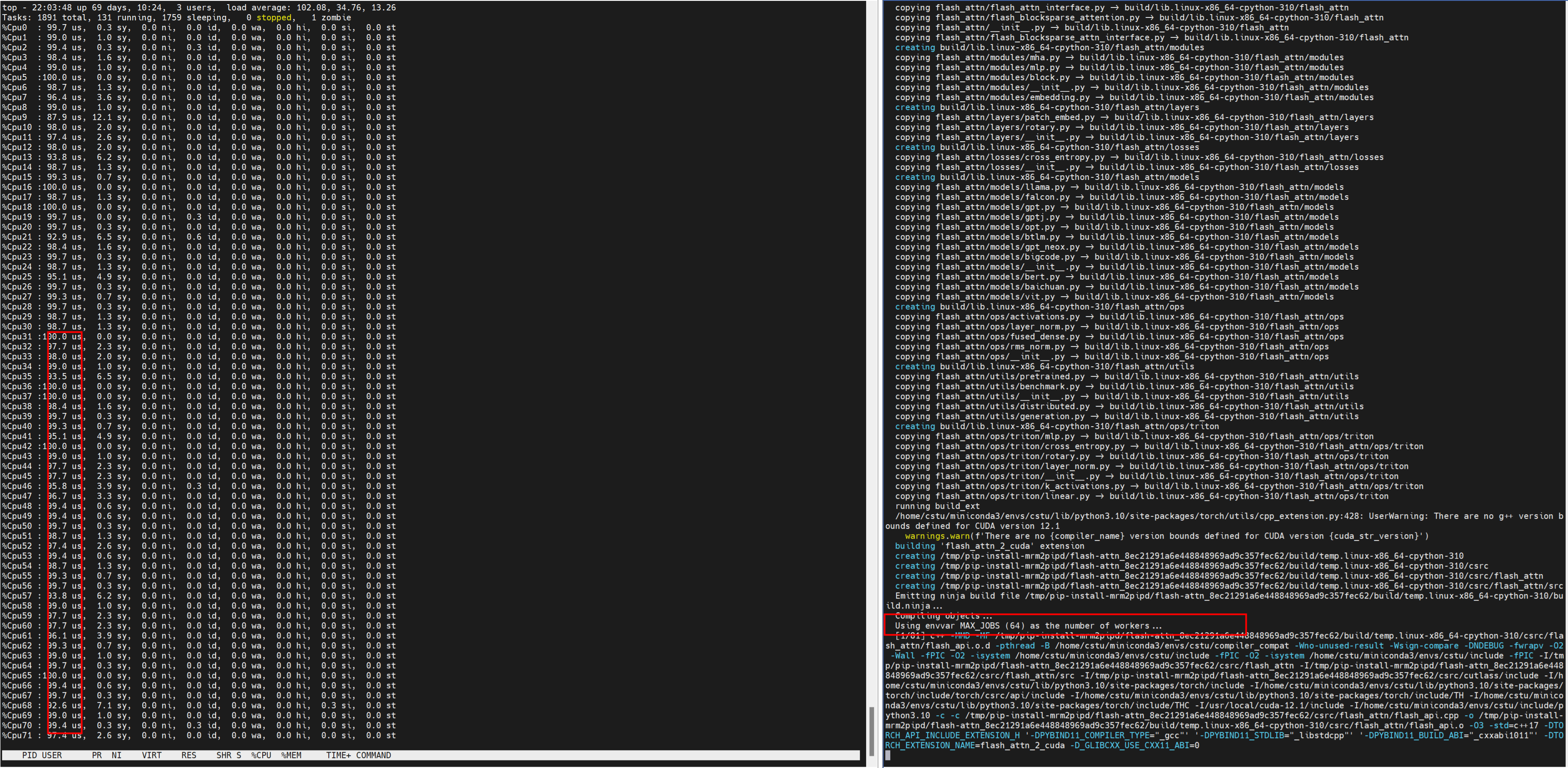

MAX_JOBS=64 pip install -v flash-attn --no-build-isolation

不安装ninja,MAX_JOBS不起作用

MAX_JOBS根据自己硬件配置来设置

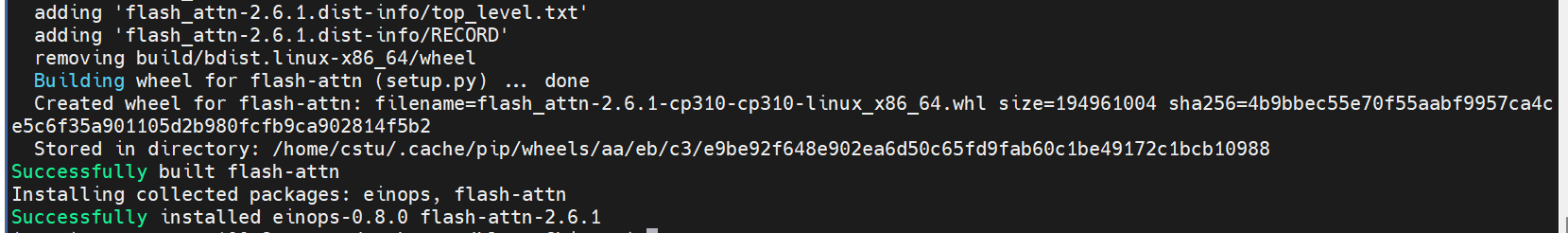

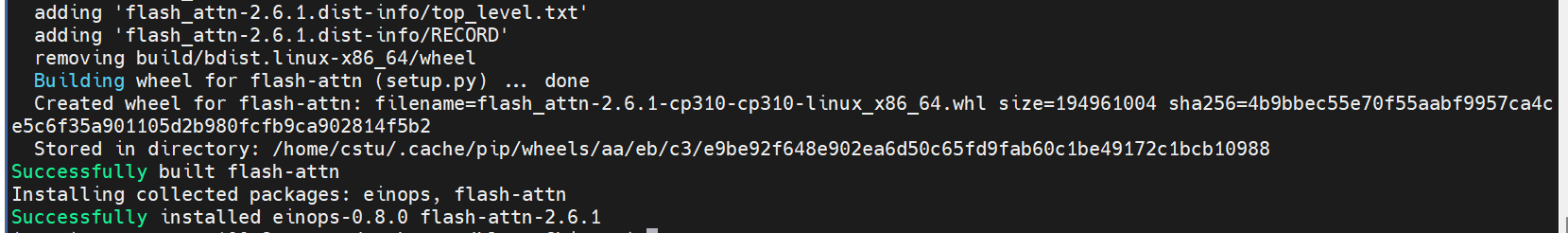

经过10分钟不到,编译成功

如果pip安装很慢,可以试试这个方法

https://github.com/Dao-AILab/flash-attention

pip install ninja

MAX_JOBS=64 pip install -v flash-attn --no-build-isolation

不安装ninja,MAX_JOBS不起作用

MAX_JOBS根据自己硬件配置来设置

经过10分钟不到,编译成功

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?